2016 年に AlphaGo が囲碁で人間を破って以来、DeepMind の科学者は強力な汎用人工知能アルゴリズムの探索に取り組んできました。Oriol Vinyals もその 1 つです。

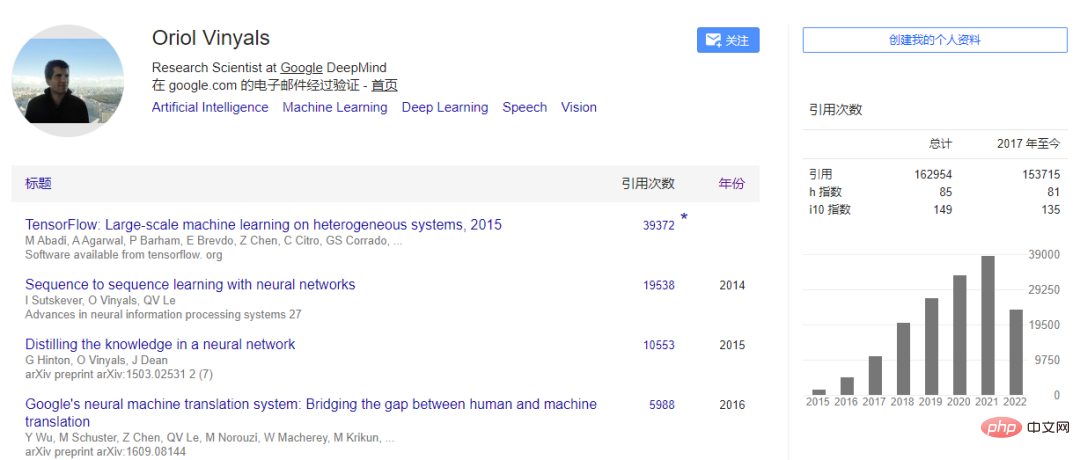

Vinyals は 2016 年に DeepMind に入社し、現在はチーフサイエンティストとして深層学習グループを率いています。以前は Google Brain で働いていました。彼の博士号はカリフォルニア大学バークレー校で取得し、2016 年の MIT TR35 Innovator Award を受賞しました。 seq2seq、知識蒸留、TensorFlow に関する彼の研究結果は、Google 翻訳、音声合成、音声認識などの製品に適用されています。彼の記事は 160,000 回以上引用されています。

最近、Oriol Vinyals が Lex Fridman のポッドキャストにゲストとして出演し、深層学習、ジェネラリスト エージェント ガトー、メタ学習、ニューラル ネットワーク、AI 意識についての彼の考えについて話しました。 、などのビュー。 Vinyals は次のように考えています:

#次の AI テクノロジー レビューは、元の意味を変えることなくインタビューの内容を編集および整理しています:

1. 一般的なアルゴリズムフリッドマン: この会話において、私たちをインタビュアーまたはインタビュイーとして置き換えることができる AI システムを私たちが生きているうちに構築することは可能でしょうか?

Vinyals: 私が聞きたいのは、その願いを私たちは実現したいですか?ということです。私たちが非常に強力なモデルを使用しているのを見て、それらが私たちに近づいているように感じられてうれしいのですが、問題は、会話の人間的な側面がなければ、それでも興味深い人工物でしょうか?おそらくそうではありません。たとえば、StarCraft では、ゲームをプレイして自分たちと競争するエージェントを作成できますが、最終的に人々が気にするのは、競争相手が人間の場合にエージェントがどのように行動するかということです。

つまり、AI によって私たちはより強くなるのは間違いありません。たとえば、AI システムから非常に興味深い問題をいくつか除外することができますが、言語の分野ではこれを「テリーピッキング」と呼ぶことがあります。同様に、今このようなツールがあったとして、あなたが興味深い質問をすると、特定のシステムがいくつかの単語を選択して答えを形成してくれるでしょうが、それは私にとってあまり興奮しません。フリッドマン: 人々の興奮を呼び起こすこと自体がシステムの目的機能の一部であるとしたらどうしますか?

Vinyals: ゲームでは、アルゴリズムを設計するときに、勝利を目標として報酬関数を作成できます。しかし、それを測定して最適化できるとしたら、何が楽しいのでしょうか?おそらくこれが、私たちがビデオゲームをしたり、オンラインで交流したり、猫の動画を見たりする理由でしょう。実際、強化学習で使用される明白な報酬関数を超えて報酬をモデル化することは非常に興味深いものです。

また、AI は特定の側面でいくつかの重要な進歩を遂げています。たとえば、会話や情報がインターネット上で受け入れられるかどうかに基づいて、その会話や情報が信頼できるかどうかを評価できます。機能を自動的に学習できれば、より簡単に最適化して、興奮などのあまり明らかではない情報を最適化するために会話を行うことができます。少なくとも 1 つの側面が完全に興奮性報酬関数によって駆動されるシステムを構築することは興味深いでしょう。 しかし、明らかに、システムにはシステム構築者による人間的要素がまだ多く含まれており、興奮のラベルは私たちからのものであるため、興奮を計算するのは困難です。私の知る限り、まだ誰もこのようなことをした人はいません。フリッドマン: おそらく、システムには強いアイデンティティーの意識も必要です。それは記憶を持ち、過去についての物語を語ることができるでしょう。インターネット上には、人々がどのような意見を持っているか、そして特定の意見に関連する興奮についてのデータが大量にあるため、物議を醸す意見から学ぶことができます。システムはそこから、文法や真実性を最適化するのではなく、人間による文の一貫性を最適化する何かを作り出すことができます。

Vinyals: ニューラル ネットワークや人工知能の構築者の観点から見ると、通常、話している多くの興味深いトピックをベンチマークにマッピングし、さらにそれらのシステムについてもマッピングしようとします。現在の実際のアーキテクチャ、どのように構築され、どのように学習し、どのようなデータから学習し、何を学習するのかについて説明します。ここで説明するのは数学関数の重みです。

ゲームの現状において、恐怖のような人生経験を得るには何が必要でしょうか?言語面では、現時点ではほとんど進歩が見られません。なぜなら、私たちが現在行っていることは、オンラインでの人間のやり取りを大量に取り込み、単語、文字、画像、音声、モダリティの文字列であるシーケンスを抽出しているからです。これらのシーケンスが表示される可能性を最大化するために、ニューラル ネットワークを通じて関数を学習しようとしています。

私たちが現在これらのモデルをトレーニングしている方法のいくつかは、あなたが話しているような機能を開発することを期待しています。そのうちの 1 つはエージェントまたはモデルのライフ サイクルであり、モデルはオフライン データから学習するため、受動的に観察して最大化するだけです。山岳地帯のように、あらゆる場所に人間のインタラクション データがある場合は重みを増やし、データがない場合は重みを下げます。通常、モデルは自分自身を経験することはなく、単にデータを受動的に観察するだけです。次に、ユーザーと対話しながらデータを生成してもらいますが、これにより、重みを最適化またはさらに最適化するときにユーザーが実際に経験する可能性のあるエクスペリエンスが大幅に制限されます。しかし、私たちはまだその段階にさえ到達していません。

AlphaGo と SlphaStar では、モデルをデプロイし、人間と競合したり、人間と対話したり (言語モデルなど) させてモデルをトレーニングします。彼らは継続的にトレーニングを受けず、データから学習した重みに基づいて学習せず、継続的に自己改善しません。

しかし、ニューラル ネットワークについて考えてみると、言葉の厳密な意味での重みの変化から学習しない可能性があることは理解できます。これは、ニューロンの相互接続方法と、私たちが生涯を通じてどのように学習するかに関係しています。しかし、これらのシステムと会話すると、会話のコンテキストが記憶の中に確かに存在します。それは、コンピューターを起動し、そのハード ドライブに多くの情報が保存されている場合、すべての情報を含むインターネットにもアクセスできるようなものです。エージェントの希望であると考えられる記憶もあります。

現時点では、ストレージは非常に限られており、私たちが今話しているのは約 2,000 語ですが、それを超えると、見たものを忘れ始めます。そのため、短期的な継続性はあります。エージェントに一貫性がある場合、「あなたの名前は何ですか?」と尋ねると、エージェントはその文を覚えていますが、2,000 語を超えると文脈を忘れてしまう可能性があります。

つまり、技術的に言えば、人々がディープラーニングに期待できることには非常に限界があります。しかし、私たちはベンチマークとテクノロジーによって記憶体験を継続的に蓄積できることを期待しており、オフライン学習が非常に強力であることは明らかです。私たちは長い道のりを歩んできました。世界についての基本的な事柄に重きを置くための模倣やインターネットの規模の力を再び目にしましたが、経験が不足しています。

実際、システムと対話するとき、その記憶が影響を受けない限り、システムをトレーニングすることさえありません。それがダイナミックな部分ですが、彼らはあなたや私が生まれたときから学ぶのと同じ方法では学びません。あなたの質問に対して、私がここで言いたいのは、記憶と経験は単に世界を観察し学ぶこととは異なるということです。

私が認識している 2 番目の問題は、これらすべてのモデルを最初からトレーニングしていることです。モデルをゼロからトレーニングし、最初からインスピレーションを見つけないと、何かが欠けてしまうようです。宇宙の他の多くの要素が以前の反復から構築されている間に、数か月ごとにモデルを種のようにトレーニングする何らかの方法が必要です。純粋なニューラル ネットワークの観点からは、以前の重みを破棄しないことは困難です。データから学習してこれらの重みを更新します。つまり、何かが欠けているように感じられ、最終的には見つかるかもしれませんが、それがどのようになるかはまだ完全には明らかではありません。

Fridman: ゼロからトレーニングするのは無駄のようです。囲碁やチェス、StarCraft、タンパク質の折りたたみ問題を解くたびに、巨大な新しいニューラル ネットワーク データベースを拡張する際に重みを再利用する何らかの方法が必要です。 。では、重みを再利用するにはどうすればよいでしょうか?一般化可能なものを抽出し、残りを破棄する方法をどのように学ぶのでしょうか?重みをより適切に初期化するにはどうすればよいでしょうか?

Vinyals: ディープ ラーニングの中心となるのは、単一のアルゴリズムですべてのタスクを解決するという素晴らしいアイデアです。ベンチマークがどんどん登場するにつれて、この基本原則は不可能であることが証明されています。つまり、空の計算脳のようなニューラル ネットワークの初期化が行われ、その後、教師あり学習でさらに多くのものを供給されます。

理想的な状況は、入力が期待されるとおりであり、出力もそのままである必要があります。たとえば、画像の分類では 1000 のカテゴリから 1 つを選択することができ、これが画像ネットワークです。多くの問題はこの方法でマッピングできます。また、多くの変更を加えたり考えたりすることなく、特定のタスクに使用できる一般的なアプローチも必要です。これがディープラーニング研究の核心だと思います。

私たちはまだそれを解明していませんが、重要な問題を解決するためのより少ないトリック (一般的なアルゴリズム) を人々が発見できれば、とても興味深いでしょう。アルゴリズム レベルでは、大量のデータに対して非常に強力なニューラル ネットワーク モデルをトレーニングするための一般的な公式がすでにあります。

多くの場合、いくつかの実際的な問題の特殊性を考慮する必要があります。タンパク質の折り畳み問題は重要であり、Transformer モデル、グラフ ニューラル ネットワーク、NLP からの洞察 (BERT など)、知識の蒸留などの基本的なアプローチがすでにいくつかあります。この定式化では、タンパク質の折り畳み問題を解決する必要があるほど重要な、タンパク質の折り畳み問題に特有の何かを見つける必要もあります。この問題で学んだことは、深層学習研究者の次の反復に適用される可能性があります。

おそらく過去 23 年間で、メタ学習の分野では、主に言語分野で作成された GPT-3 を中心に、一般的なアルゴリズムがある程度の進歩を遂げました。このモデルのトレーニングは 1 回だけで、言語の翻訳や文の根底にある感情を知ることだけに限定されるわけではなく、本質的により多くの例を示すヒントを通じて実際にモデルに教えることができます。私たちは言語を通じて刺激を受けており、言語自体は私たちがお互いから学ぶための自然な方法です。おそらく、最初にいくつかの質問をしてから、この新しいタスクを実行するように指示します。最初から再トレーニングする必要はありません。私たちは、言語のみのモダリティで言語を促す、数回の学習で魔法の瞬間をいくつか見てきました。

過去 2 年間、私たちはこれが言語を超えた他のモダリティに拡張され、ビジュアル、アクション、ゲームが追加され、大きな進歩を遂げるのを目にしてきました。これは、単一のモデルを実装する方法である可能性があります。このモデルは重量や容量を増やすのが難しいのが問題ですが、強力であることは確かです。

現在の進歩はテキストベースのタスクまたはビジュアルスタイル分類タスクで発生していますが、さらに画期的な進歩があるはずです。私たちは優れたベースラインを持っており、そのベースラインが一般的な人工知能に向けて移行することを望んでおり、コミュニティがその方向に進んでいることは素晴らしいことです。私が興奮しているのは、これらのモデルをより強力にするための深層学習の次のステップは何でしょうか?彼らをどのように訓練すればよいでしょうか?進化しなければならないとしたら、どのようにして「繁殖」できるのでしょうか?タスクを教えるときに重みを変更する必要がありますか?答えなければならない疑問はまだたくさんあります。

フリッドマン: あなたのツイートにある「ニャー」と猫の表現について説明していただけますか?で、ガトーって何?どのように機能するのでしょうか?どのような種類のニューラルネットワークが関与しているのでしょうか?トレーニング方法は?

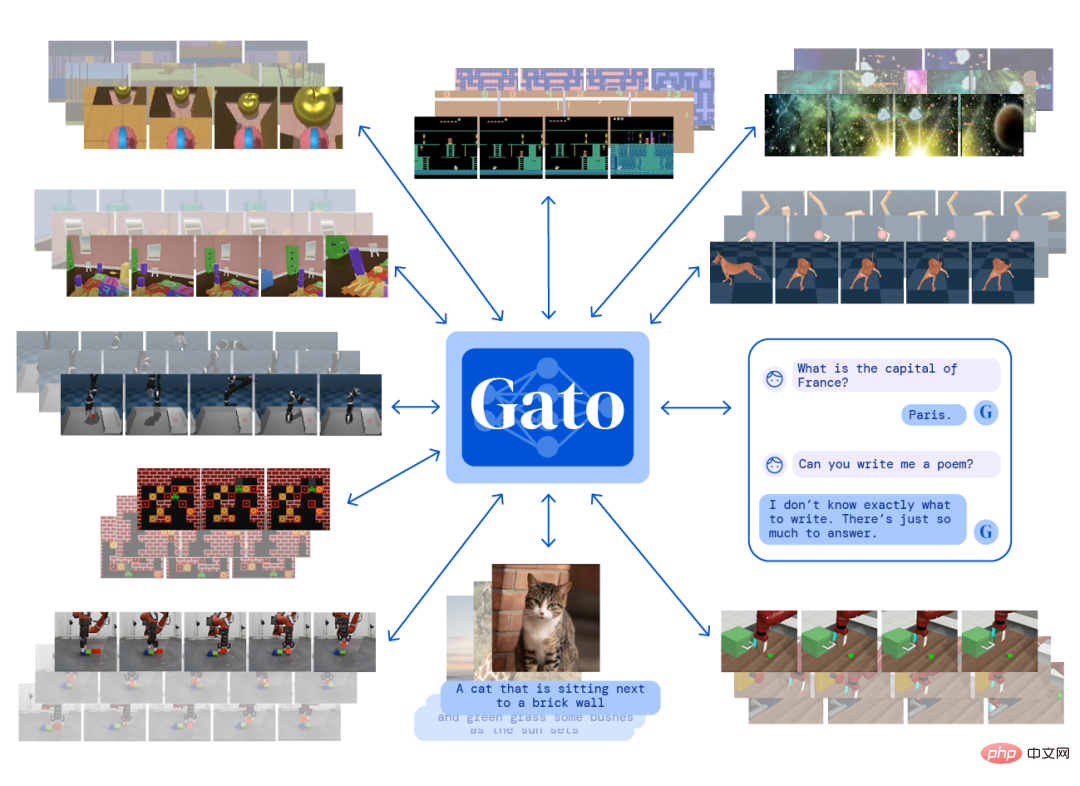

Vinyals: まず第一に、Gato という名前は、DeepMind がリリースした他の一連のモデルと同様に、動物にちなんで名付けられています。大規模シーケンス モデルは言語のみから始まりますが、他のモダリティにも拡張しています。 Gopher、Chinchilla、これらは純粋な言語モデルであり、最近では視覚をカバーする Flamingo をリリースしました。 Gato は視覚的モダリティとアクション モダリティを追加し、上下左右などの個別のアクションを単語から強力な言語シーケンス モデルに自然にマッピングできます。

ガトーをリリースする前に、どの動物に名前を付けるかを議論しました。主に考慮すべきことは、ガトーの固有の属性であるジェネラルエージェントだと思います。「ガトー」はスペイン語で「」を意味します。中国語で「猫」。

Gato の基本は他の多くのジョブと変わりません。これは、視覚、言語、行動などの複数のモダリティをカバーするリカレント ニューラル ネットワークである Transformer モデルです。トレーニング中の目標は、シーケンスの次に何が行われるかを予測できるようになることです。トレーニングがアクション シーケンスの場合は、次のアクションが何であるかを予測することです。文字列や画像列も同様です。私たちはそれらをすべてバイトとして考え、モデルのタスクは次のバイトが何であるかを予測することです。そして、このバイトをアクションとして理解してゲーム内でこのアクションを使用することができます。また、それを単語として理解して、システムとの会話中に一言もしゃべりません。

ロボットもトレーニング コンテンツの一部であるため、Gato の入力には画像、テキスト、ビデオ、アクション、およびロボットからのいくつかの知覚センサーが含まれます。テキストとアクションを出力しますが、画像は出力しません。現在、そのような出力フォームを設計中です。まだやるべきことはたくさんあるので、Gato がスタートだと言います。基本的に、Gato は一連の観察とモダリティを与えると、そのシーケンスの次のステップを出力する脳です。次に、次のものへの移動を開始し、次のものを予測し続けます。

これは単なる言語モデルではありません。チンチラやフラミンゴのようなガトーとチャットできますが、エージェントでもあります。汎用性があるようにさまざまなデータセットでトレーニングされています。StarCraft が得意なだけではなく、アタリゲームとか囲碁とか。

フリッドマン: 行動様式の観点から言えば、どのようなモデルを「知的エージェント」と呼ぶことができますか?

ビニール: 私の意見では、エージェントとは実際には環境内でアクションを実行する能力です。環境にアクションを与えることで反応し、新しい観察結果が返され、次のアクションが生成されます。

Gato をトレーニングする方法は、観測データ セットを抽出することです。これは、データ セット内の次の単語が何になるかを予測するようにトレーニングするなど、大規模な模倣学習アルゴリズムです。 Web ページ上でテキストメッセージを送信したりチャットしたりする人々のデータセットがあります。

DeepMind は、強化学習と、さまざまな環境で動作する学習エージェントに興味を持っています。私たちは、エージェントの経験の軌跡を記録するデータセットを開発しました。私たちがトレーニングする他のエージェントは、3 次元のゲーム環境を制御したり、迷路をナビゲートしたりするなど、単一の目標に向けて訓練されており、エージェントと環境とのインタラクションから得られた経験をデータセットに追加します。

Gato をトレーニングするとき、単語などのデータと、エージェントと環境の間のインタラクションを組み合わせてトレーニングします。これが Gato の「普遍性」です。さまざまなモダリティやタスクに対して、Gato は単一の「頭脳」しか持ちません。 」とあり、近年のほとんどのニューラル ネットワークと比較すると、パラメータの数は 10 億個とそれほど大きくありません。

サイズが小さいにもかかわらず、そのトレーニング データ セットは非常に挑戦的で多様であり、インターネット データだけでなく、さまざまな環境とのエージェントの対話経験も含まれています。

原則として、Gato はあらゆる環境、特に訓練されたビデオ ゲーム、さまざまなロボット タスク、その他の環境を制御できます。しかし、それを教えた教師よりもうまくいくわけではありません。規模は依然として重要です。Gato はまだ比較的小さいため、まだ始まりです。規模を拡大すると、さまざまなモダリティ間の相乗効果が高まる可能性があります。そして、データを研究したり準備したりする新しい方法がいくつかあると思います。たとえば、Atari ゲームをプレイするときに上下の動きだけを考慮しているのではなく、エージェントがその動きを確認できる必要があることをモデルに明確にする必要があります。特定の背景を使用すると、テキストを使用して「シーケンス全体を表示します。これからこのゲームのプレイを開始します」と伝えることができます。したがって、テキストはデータを強化する方法である可能性があります。

Fridman: テキスト、画像、ゲームアクション、ロボットタスクをトークン化するにはどうすればよいですか?

ビニール: 良い質問です。トークン化は、すべてのデータをシーケンスにするための開始点です。すべてをこれらのパズルのピースに分解し、パズルがどのように見えるかをシミュレーションできるようなものです。並べるとシーケンスになります。 Gato は、現在の標準テキスト トークン化テクノロジを使用します。一般的に使用される部分文字列を通じてテキストをトークン化します。たとえば、「ing」は英語で一般的に使用される部分文字列であるため、トークンとして使用できます。

フリッドマン: 単語にはいくつのトークンが必要ですか?

Vinyals: 英語の単語の場合、現在のトークン化の粒度は通常 2 ~ 5 個の記号であり、文字より大きく、単語より小さくなります。

フリッドマン: 絵文字をトークン化してみたことがありますか?

ビニール: 絵文字は実際には単なる文字の連続です。

フリッドマン: 絵文字は画像ですか、それともテキストですか?

Vinyals: 実際に絵文字を文字シーケンスにマッピングできるため、モデルに入力絵文字を与えると絵文字が出力されます。 Gato では、画像をさまざまな強度のピクセルに圧縮することで画像を処理し、その結果、非常に長いピクセルのシーケンスが生成されます。

フリッドマン: 意味論は関与していないということですか?画像について何も理解する必要はありませんか?

ビニール: はい、ここでは圧縮の概念のみが使用されています。トークン化レベルでは、画像を圧縮するための共通パターンを見つけます。

フリッドマン: 色のような視覚情報は、単なる統計ではなく、画像の意味を捉えます。

Vinyals: 機械学習における画像の処理方法は、よりデータ駆動型です。画像の統計を使用して数値化するだけです。共通の部分文字列はトークンとして位置付けられ、画像は似ていますが、それらの間には関連性がありません。トークンを整数と考えると、テキストに 1 から 10,000 までの 10,000 個のトークンがあり、それらが私たちが目にするすべての言語と単語を表すとします。

画像は、10001 から 20000 までの別の整数のセットであり、この 2 つは完全に独立しています。それらを結び付けるのはデータであり、データセットでは、画像のタイトルがその画像が何についてのものであるかを示します。モデルはテキストからピクセルまでを予測する必要があり、アルゴリズムが学習するにつれて 2 つの間の相関関係が生じます。単語や画像に加えて、アクションに整数を割り当て、それらを離散化し、同様のアイデアを使用してアクションをトークンに圧縮することもできます。

これは、すべての空間タイプを整数シーケンスにマッピングする方法です。これらはそれぞれ異なる空間を占有し、それらを接続するのが学習アルゴリズムです。

フリッドマン: スケールするのは難しいと前に言いましたが、それはどういう意味ですか? Gato のようなネットワークを拡張するのはなぜそれほど難しいのでしょうか?

Vinyals: Gato ネットワークを再トレーニングすれば、スケールアップするのは難しくありません。重要なのは、現在 10 億のパラメータがあるということですが、同じ重みを使用してこれをより大きな脳に拡張できるでしょうか?これはとても難しいことです。ソフトウェア工学にはモジュール性という概念があり、モジュール性を利用した研究がいくつか行われています。 Flamingo はアクションを処理しませんが、画像の処理には強力であり、これらのプロジェクト間のタスクは異なり、モジュール化されています。

私たちは、純粋言語モデル Chinchilla から重みを取得し、それらの重みを凍結し、モデル内の正しい場所にいくつかの新しいニューラル ネットワークを接続することで、Flamingo モデルのモジュール性を完全に実現しました。他の機能を壊さずに他の機能を追加する方法を見つける必要があります。

ランダムに初期化されず、自己監視を通じて学習する小さなサブネットワークを作成します。次に、データセットを使用して、視覚と言語の 2 つのモダリティを接続しました。ネットワークの大部分をフリーズし、トレーニングにいくつかのパラメータを最初から追加しました。その後、Flamingo が登場しました。入力はテキストと画像、出力はテキストでした。新しい視覚タスクを教えることができ、チンチラはデータセット自体が提供する以上のことを行いますが、チンチラから得た言語知識の多くを活用します。

このモジュール性の重要なアイデアは、凍結した脳を取り出し、それに新しい機能を追加するということです。ある程度、DeepMind にも Flamingo の折衷主義があり、システムを最初から再トレーニングすることなく、スケールをより合理的に利用できることがわかります。

Gato も同じデータセットを使用しますが、最初からトレーニングされます。したがって、コミュニティにとっての大きな問題は、ゼロからトレーニングするべきなのか、それともモジュール性を採用すべきなのか、ということだと思います。モジュール性は拡張する方法として非常に効果的です。

フリッドマン: Gato の出現後、「メタ学習」という用語を再定義できますか?メタ学習とは何だと思いますか?メタラーニングは5年後、10年後にはガトーを拡張したようなものになるでしょうか?

ビニール: 前方ではなく後方に目を向けると、良い視点が得られるかもしれません。 2019 年にメタ学習について話すとき、その意味は GPT-3 革命によってほぼ変わりました。当時のベンチマークはオブジェクトのアイデンティティを学習する能力に関するものであったため、視覚とオブジェクトの分類に非常に適していました。 ImageNet が学習するように指示する 1000 のカテゴリを学習しているだけではなく、モデルと対話するときに定義できるオブジェクト カテゴリも学習しています。

モデルの進化は興味深いものです。まず、小さなデータセットである特別な言語を用意し、モデルに新しい分類タスクを要求します。機械学習データセットの形式のヒントを使用すると、オブジェクトを定義するときにオブジェクトを予測または分類できるシステムが得られます。最後に、言語モデルは学習者になります。 GPT-3 は、オブジェクトの分類と、オブジェクト クラスの学習のコンテキストにおけるメタ学習の意味に焦点を当てることができることを示しています。

これで、ベンチマークに拘束されなくなり、自然言語を通じていくつかの論理タスクをモデルに直接伝えることができるようになりました。これらのモデルは完璧ではありませんが、メタ学習を通じて新しいタスクを実行し、新しい機能を獲得しています。 Flamingo モデルは、視覚および言語のマルチモダリティに拡張されていますが、同じ機能を備えています。あなたはそれを教えることができます。たとえば、新しい機能の 1 つは、数字の写真を撮って、算術を教えることができることです。いくつかの例を示すと学習するため、以前の画像分類をはるかに超えています。

これは、メタ学習が過去に何を意味していたのかを拡張したものです。メタ学習は常に変化する用語です。現在の進捗状況を考えると、次に何が起こるか楽しみです。おそらく 5 年後には別の話になるでしょう。一連の重みを備えたシステムがあり、インタラクティブなプロンプトを通じて StarCraft をプレイするようにシステムに教えることができます。システムに話しかけ、新しいゲームを教え、ゲームの例を見せると想像してください。おそらくシステムは、「このゲームをプレイしたばかりですが、上手にプレイできましたか? もっと教えてもらえますか?」といった質問をすることもあります。そのため、5 年後、10 年後、専門分野では、これらの要素がよりインタラクティブになるでしょう。そしてより豊かに。たとえば、StarCraft 用に特別に開発された AlphaStar は、非常に異なります。アルゴリズムは一般的ですが、重みは固有です。

メタ学習はプロンプトを超えて、より多くのインタラクションを含みます。システムは、ミスをしたりゲームに負けたりした後、フィードバックを与えるように指示する場合があります。実際、ベンチマークはすでに存在しており、私たちはその目標を変更しただけです。つまり、ある意味、私は一般的な人工知能について次のように考えるのが好きです。チェスや StarCraft などの特定のタスクではすでに 101% のパフォーマンスがあり、次の反復ではすべてのタスクで 20% に到達できるでしょう。次世代モデルの進歩は間違いなくこの方向にあります。もちろん、ツールがなかったり、Transformer が足りなかったりするなど、いくつかの点で間違ってしまう可能性があります。今後 5 ~ 10 年以内に、モデルの重みはトレーニングされる可能性が高く、モデルにメタ学習を教えるか許可するかが重視されるようになるでしょう。

これは対話型の教育です。機械学習の分野では、この方法は分類タスクの処理に長い間使用されていませんでした。私のアイデアは最近傍アルゴリズムに少し似ていますが、これはほぼ最も単純なアルゴリズムであり、学習や勾配の計算を必要としません。最近傍法はデータ セット内のポイント間の距離を測定し、新しいポイントを分類するには、この大量のデータ内で最も近いポイントが何かを計算するだけで済みます。したがって、このヒントは、アップロード時に単純なポイントを処理しているだけではなく、事前トレーニングされたシステムに知識を追加していると考えることができます。

このヒントは、機械学習における非常に古典的な概念、つまり最近接点による学習を発展させたものです。 2016 年の研究の 1 つは、最近傍法を使用しました。これは、コンピュータ ビジョンの分野でも非常に一般的です。2 つの画像間の距離を計算する方法は、非常に活発な研究分野です。適切な距離行列を取得できれば、次のことができます。良い分類器も得られます。

これらの距離と点は画像に限定されず、テキスト、テキスト、画像、アクション シーケンス、およびモデルに教えられるその他の新しい情報でも構いません。おそらくウェイトトレーニングはもうしないでしょう。メタ学習のテクニックの中には微調整を行うものもあります。新しいタスクを取得すると、重みを少しトレーニングします。

フリッドマン: 私たちはフラミンゴ、チンチラ、ゴーファーなどの一般的で大規模なモデルやエージェントを作成しましたが、これらは技術的には特別なものです。それ?

ビニール: 成功の鍵はエンジニアリングだと思います。 1 つ目はデータ エンジニアリングです。最終的に収集するのはデータ セットだからです。次に展開プロジェクトが始まり、モデルをいくつかのコンピューティング クラスターに大規模に展開します。この成功要因はあらゆることに当てはまり、まさに悪魔は細部に宿ります。

もう 1 つは、ベンチマークの現在の進歩です。チームは調査に数か月を費やしていますが、成功するかどうかはわかりませんが、リスクを冒して不可能と思われることを実行しないと、成功しないでしょう。」 t. 成功する可能性はあります。ただし、進捗状況を測定する方法が必要なので、ベンチマークを確立することが重要です。

私たちは広範なベンチマークを使用して AlphaFold を開発しました。このプロジェクトのデータと指標はすべてすぐに入手できます。優れたチームとは、漸進的な改善を見つけて論文を発表することではなく、より高い目標を持ち、それに何年も取り組むことであるべきです。

機械学習の分野では、私たちはニューラル ネットワークのようなアーキテクチャが好きですが、Transformer が登場する前は、この分野は非常に急速に成長していました。 「Attentionis All You Need」は確かに素晴らしいエッセイのテーマです。このアーキテクチャは、任意のバイト シーケンスをモデル化するという私たちの夢を実現します。これらのアーキテクチャの進歩は、ある程度ニューラル ネットワークの動作方法にあると思います。5 年前に発明され、まだ安定していてほとんど変更されていないアーキテクチャを見つけるのは困難です。そのため、Transformer は多くのプロジェクトに登場し続けることができます。 . 驚きです。

フリッドマン: テクノロジーの哲学的なレベルでは、注意を引く魔法はどこにあるのでしょうか?人間の心の中で注意力はどのように機能するのでしょうか?

Vinyals: Transformer と長期短期記憶人工ニューラル ネットワーク LSTM の間には違いがあります。Transformer の初期の頃、LSTM はまだ非常に強力なシーケンス モデルでした。 AlphaStar として、両方です。 Transformer のパワーは、誘導性の注意バイアスが組み込まれていることです。段落全体を翻訳したり、前の 10 段落に基づいて次の段落を予測したりするなど、単語の文字列に対する複雑なタスクを解決したいとします。

直観的には、Transformer がこれらのタスクを実行する方法は、人間を模倣してコピーすることです。Transformer では、何かを探しています。テキストの段落を読んだ後、次に何が起こるかを考えるでしょう。テキストをもう一度見てください。これは仮説に基づいたプロセスです。次の単語は「猫」か「犬」のどちらになるだろうかと考えている場合、トランスフォーマーの仕組みとしては、次の 2 つの仮定があります。「それは猫でしょうか?」それとも犬?それが猫の場合は、いくつかの単語 (必ずしも「猫」という単語自体である必要はありません) を見つけて、「猫」と「犬」のどちらが意味があるかを確認します。

次に、単語に対して非常に詳細な計算を実行し、単語を結合し、クエリも実行します。本文について真剣に考える場合は、上記のすべての本文を振り返る必要がありますが、注意を向けているものは何でしょうか?私が今書いたことは確かに重要ですが、10 ページ前に書いたことも重要である可能性があるため、考えなければならないのは配置ではなく内容です。 Transformer は、特定のコンテンツをクエリして、それを抽出してより適切な意思決定を行うことができます。これは Transformer を説明する 1 つの方法であり、この誘導バイアスは非常に強力だと思います。 Transformer には時間の経過とともに細かい変更が加えられる可能性がありますが、誘導バイアスにより、Transformer はリーセンシー バイアスに基づくリカレント ネットワークよりも強力になります。これは一部のタスクでは効果的ですが、非常に大きな欠陥があります。

トランス自体にも欠陥があります。主な課題の 1 つは、今議論したプロンプトだと思います。プロンプトの長さは最大 1000 ワードにすることができ、ゲームに関するビデオや Wikipedia の記事をシステムに表示する必要さえあります。また、ゲームをプレイしたり質問したりするときに、システムと対話する必要もありました。モデルの現在の能力を超えたものを達成できるように教えるには、優れた教師になる必要があります。そこで問題は、これらのタスクをどのようにベンチマークするかということです。アーキテクチャの構造をどのように変更するのでしょうか?これは物議を醸しています。

フリッドマン: この研究の進展において、個々の人々はどれくらい重要ですか?彼らは分野をどの程度変えましたか?あなたは現在、DeepMind で深層学習の研究を率いています。多くのプロジェクトや優秀な研究者がいますが、これらすべての人間がどれだけの変化をもたらすことができるでしょうか?

ビニール: 私は人々が大きな役割を果たすと信じています。うまくいくアイデアを手に入れてそれを貫きたいと思う人もいれば、より実践的で、タンパク質のフォールディングを解くことができればどんなアイデアがうまくいくかは気にしない人もいるでしょう。一見相反するように見えるこの両方のアイデアが必要です。歴史的には、どちらも遅かれ早かれ何かを生み出しました。 2 つの間の区別は、強化学習の分野でいわゆる探索と活用のトレードオフに似ている可能性もあります。チームや会議で人々とやりとりすると、何かが探索可能または悪用可能であることがすぐにわかります。

どんな種類の研究スタイルも否定するのは間違いです。私は産業界の出身なので、大規模なコンピューティング能力を使用でき、それに対応する特定の種類の研究も存在します。科学の進歩のためには、今答えるべき質問に答える必要があります。

同時に、多くの進歩も感じています。アテンション メカニズムはもともとカナダのモントリオールで、Google Brain の友人たちとシーケンスツーシーケンス モデルに取り組んでいたときに、コンピューティング能力の不足により発見されました。私たちは 8 つの GPU (実際には当時としてはかなりの数でした) を使用しましたが、モントリオールはコンピューティングの規模という点でまだ比較的限られていたと思います。しかしその後、彼らはコンテンツベースのアテンションの概念を発見し、それがさらに Transformer につながりました。

フリッドマン: 多くの人は天才は壮大なアイデアに宿ると考えがちですが、エンジニアリングにおける天才は細部に宿ることが多いのではないかと思います。場合によっては 1 人のエンジニア、または数人のエンジニアが私たちの行動を変えることもあります。特に大規模コンピューターで作成されたものでは、エンジニアリング上の 1 つの決定が連鎖反応を引き起こす可能性があります。

Vinyals: ディープ ラーニングとニューラル ネットワークの開発の歴史を振り返ると、偶然の要素があることがわかります。なぜなら、GPU はビデオ ゲーム用ではありますが、たまたま適切なタイミングで登場したからです。したがって、ハードウェア エンジニアリングでさえ時間要因の影響を受けます。データセンターが設立されたのも、このハードウェア革命によるものでした。たとえば、Google のデータセンター。このようなデータセンターを使用すると、モデルをトレーニングできます。ソフトウェアも重要な要素であり、この分野に参入する人が増えています。システムがすべてのベンチマークを備えていることも期待されるかもしれません。

フリッドマン: Jeff Dean、Percy Liang らと共著した「大規模言語モデルの創発能力」というタイトルの論文がありますね。 ”。ニューラルネットワークにおける創発はどのように直観的に説明されるのでしょうか?魔法の転換点はあるのでしょうか?これはタスクごとに異なりますか?

ビニール: ベンチマーク テストを例に挙げます。システムをトレーニングするときに、データセットのサイズがパフォーマンスにどの程度影響するか、モデルのサイズがパフォーマンスにどのような影響を与えるか、パフォーマンスに影響を与えるシステムのトレーニングにかかる時間などを分析すると、曲線は非常に滑らかになります。 ImageNet を非常に滑らかで予測可能なトレーニング カーブとして見ると、ある意味非常に滑らかで予測可能であるように見えます。

言語側では、入力が数学的問題を説明する文であっても、ベンチマークにはより多くの思考が必要となり、より多くの処理とより多くの内省が必要になります。モデルのパフォーマンスはランダムになる可能性があります。Transformer のクエリ システムまたは Transformer のような言語モデルによって正しい質問がされるまで、パフォーマンスはランダムから非ランダムに変化し始めます。これは非常に経験的なものであり、その背後に形式化されたものはありません。理論。

フリッドマン: 最近、ある Google エンジニアは、Lambda 言語モデルには意識があると主張しました。この事件は、人間の側面、機械学習の技術的側面、そして人間の世界での AI システムの役割の哲学的側面に触れています。機械学習エンジニアとして、また人間としてどのような視点を持っていますか?

Vinyals: 現在のモデルはどれも、まだ意識には程遠いと思います。私は自分が少し失敗した科学者であると感じています。機械学習は他の科学にも役立つかもしれない科学として常に考えています。私は天文学と生物学が好きですが、それらの分野の専門家ではないので、機械学習を勉強することにしました。

しかし、Alphafold についてさらに学び、タンパク質、生物学、生命科学について少し学ぶにつれて、原子レベルで何が起こっているのかを調べ始めました。私たちはニューラル ネットワークを脳として考える傾向があり、専門家でない私には複雑で魔法のように思えますが、生物学的システムは計算脳よりもはるかに複雑で、既存のモデルはまだ生物学的脳のレベルに達していません。

この Google エンジニアに何が起こったのか、私はそれほど驚きません。おそらく、時間曲線が滑らかになっていることを私が見ているからかもしれませんが、50 年代のシャノンの研究以来、言語モデルはそれほど急速に進歩しておらず、100 年前に私たちが持っていたアイデアは、私たちが今持っているアイデアとそれほど違いはありません。しかし、誰も自分が考えるべきことを他人に伝えるべきではありません。

人類の創造の始まりからの複雑さ、そして宇宙全体の進化の複雑さは、私にとって桁違いに魅力的です。自分のやっていることに夢中になるのは良いことだが、それはそれほど魔法ではない、と生物学の専門家に言ってもらいたいものだ。コミュニティでの交流を通じて、何が正常ではないのか、何が危険なのかなどを理解するのに役立つレベルの教育も得られます。これがなければテクノロジーは正しく使用できません。

フリッドマン: 知能の問題を解決するには、システムが意識を獲得する必要がありますか? AI システムを作成する際に、人間の心のどの部分が有益になるでしょうか?

Vinyals: システムが、あなたに挑戦し、あなたを導くことができる非常に有用な頭脳を備えているほど賢いとは思えません。代わりに、何かをするように教える必要があります。個人的には、意識が必要かどうかはわかりませんが、おそらく意識やその他の生物学的または進化的観点が次世代のアルゴリズムに影響を与えるでしょう。

人間の脳とニューラルネットワークでは計算内容が異なり、もちろん似ている部分もありますが、脳の詳細については十分にわかっていません。しかし、私たちの思考プロセス、記憶の仕組み、さらにはどのように進化して現在の姿になったのか、探索と開発とは何かなど、範囲を少し狭めると、アルゴリズム レベルでの研究に刺激を与えることができます。

フリッドマン: 70 年間の人工知能研究からの最大の教訓は、コンピューティング能力を活用する一般的な方法であるという、The Bitter Lesson でのリチャード サットンの見解に同意しますか? それは最終的な効果的な方法ですか?

ビニール: 私はこの観点に強く同意します。信頼できる複雑なシステムを構築するには、スケールが必要です。これでは十分ではない可能性があり、いくつかのブレークスルーが必要です。サットン氏は、検索はスケーリングの手法であると述べましたが、Go のような分野では、明確な報酬関数があるため、検索は役立ちます。しかし、他のいくつかのミッションでは、何をすればよいのかよくわかりませんでした。

フリッドマン: 人間の知能に達するか、それを超える一般的な人工知能システムを私たちが生きているうちに構築できると思いますか?

ビニール: 私は、それが人間レベルの知性を持っていると絶対に信じています。特に模倣学習の観点から現在の標準を見ると、「超える」という言葉を定義するのは困難ですが、AI に言語において人間を模倣し、超えることは確実に可能です。したがって、模倣によって人間のレベルに到達するには、強化学習などが必要になります。一部の地域ではすでにその成果が現れている。

人間の能力を超えるという点では、AlphaGo が私の一番好きな例です。そして、一般的な意味で、人間の知性を模倣した方法で報酬関数を定義できるかどうかはわかりません。超越性に関してはまだ分かりませんが、間違いなく人間のレベルに達するでしょう。明らかに、私たちは超越を試みるつもりはなく、もし超越できたとしたら、世界を進歩させるための超人的な科学者と発見が得られるでしょうが、少なくとも人間レベルのシステムは非常に強力になるでしょう。

フリッドマン: 人間レベルまたはそれを超えた数十億の諜報員が人間社会に深く統合される特異点の瞬間が来ると思いますか?世界について怖がりますか?それとも興奮しますか?

Vinyals: もしかしたら、この目標を実際に達成できるかどうかを検討する必要があるかもしれません。限られたリソースであまりにも多くの人が共存すると、問題が発生する可能性があります。おそらくデジタルエンティティにも数量制限が存在するはずです。これは、エネルギーも消費するため、エネルギーの利用可能性を理由にしています。

現実には、エネルギー要件に関しては、ほとんどのシステムは私たちのシステムよりも効率が低くなります。しかし、私は社会として、成長するための合理的な方法と共存する方法を見つけるために協力する必要があると思います。そうでなければ明らかにアクセスできない人々に特定のリソースや知識へのアクセスを提供する自動化の側面が実現したら、私は興奮します。それが私が最も楽しみにしているアプリケーションです。

フリッドマン: 最後の質問ですが、人類が太陽系から出ていく中、将来の世界には人間が増えるのでしょうか、それともロボットが増えるのでしょうか?

ビニール: 人間と AI が共存する可能性があるというのは単なる憶測ですが、このようにして私たちをより良くしようとしている企業はすでに存在します。比率は最大でも 1:1 にしたいです。1:1 も可能かもしれませんが、バランスが崩れるのは良くありません。

元のビデオリンク: https://youtu.be/aGBLRlLe7X8

以上がDeepMind 首席科学者 Oriol Vinyals 氏への最新インタビュー: 一般 AI の未来は強力なインタラクティブなメタ学習ですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。