この共有のトピックは、ChatGPT テクノロジ、ローカリゼーションの試み、およびオープン ソース モデルです。この共有は 3 つの部分で構成されており、最初の部分では、ChatGPT テクノロジーの進化、現在の問題、ChatGPT テクノロジー学習の 3 つの段階、データの編成と効果の評価など、ChatGPT 関連テクノロジーの全体的な紹介を行い、2 番目の部分では ChatGPT に関する経験を共有しています。テクノロジーのローカライゼーションに関する私たちの試みには、実験中に遭遇した問題、私たちの考え、モデルの効果と応用が含まれており、第 3 部では、私たちがリリースした中国のオープンソース大規模モデルと、私たちが独自のデータを使用して学習する方法を紹介します。ローカルモデル 運用中に遭遇する可能性のある問題、オープンソースの先進モデルとのギャップ、モデルの効果をさらに高める方法。

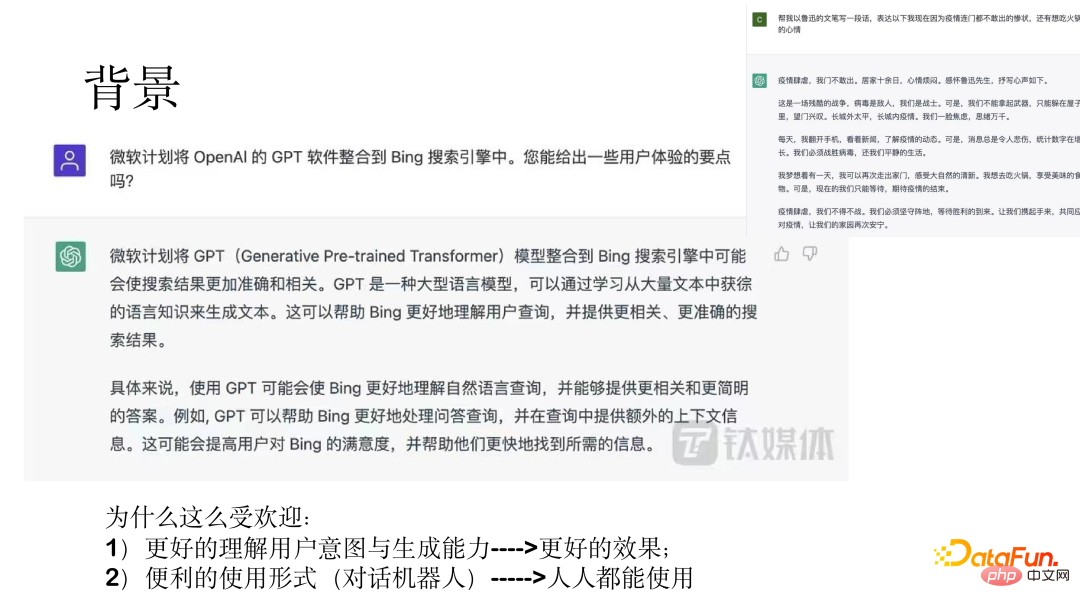

ChatGPT は、一般的な機能アシスタントです。 2022 年 12 月 5 日、OpenAI CEO のサム アルトマン氏は、ChatGPT のユーザー数が開始から 5 日後に 100 万人を超えたとソーシャル メディアに投稿しました。 AI チャットボット ChatGPT は爆発的に人気を博し、画期的なイベントになりました。 Microsoftは株式を100億ドル増額し、近くMicrosoft Cloudに統合する方向で交渉を進めている。

#上の図は 2 つの例を示しており、驚くべき結果が示されています。

ChatGPT が非常に人気がある理由は、一方ではユーザーの意図を理解し、より良い効果を生み出す能力にありますが、他方では、対話型ロボットの活用により、誰もが利用できるようになりました。

以下では、モデルの進化、初期モデルの問題点、ChatGPT モデル学習の 3 段階、データ構成とトレーニングの効果について説明します。 ChatGPTモデルを紹介します。

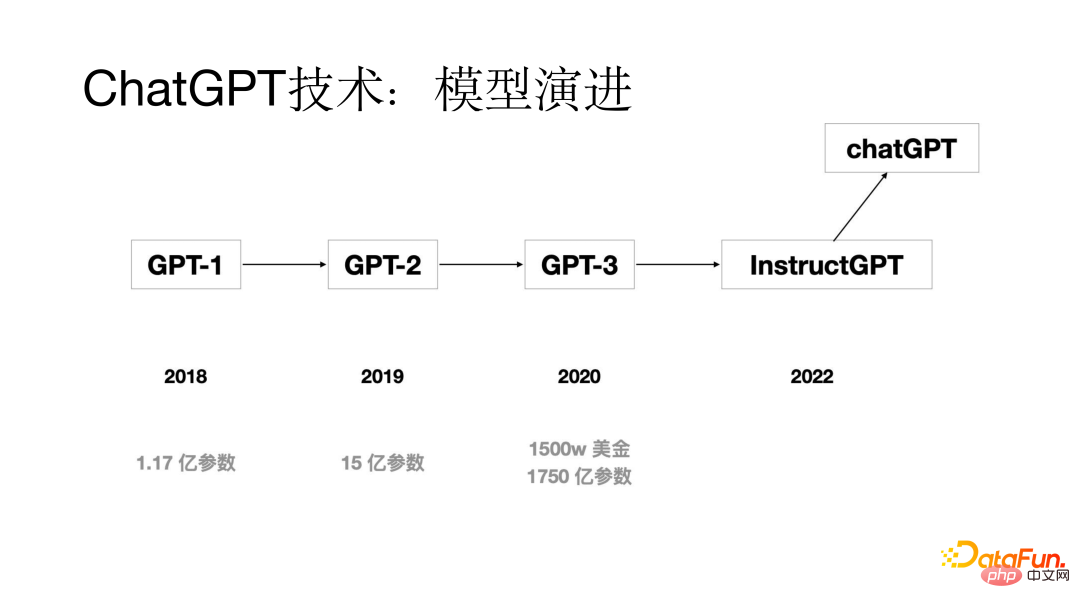

ChatGPT テクノロジーも、数世代のモデルを通じて進化してきました。初期の GPT モデルは次のとおりです。 2018 年に提案されたモデル パラメーターはわずか 1 億 1,700 万個でしたが、2019 年には GPT-2 モデル パラメーターは 15 億個でした。2020 年までに GPT-3 モデル パラメーターは 1,750 億個に達しました。数世代のモデル更新反復を経て、 ChatGPT 2022モデル。

In ChatGPT モデルが登場する前のモデルにはどのような問題がありましたか?分析の結果、より明らかな問題の 1 つは位置合わせの問題であり、大規模なモデルの生成能力は比較的高いものの、生成された答えがユーザーの意図を満たさない場合があることがわかりました。研究を通じて、アライメントの問題の主な理由は、言語モデル トレーニングのトレーニング目標が、ユーザーの意図に従って次の単語を生成するのではなく、次の単語を予測することであることが判明しました。アライメントの問題を解決するために、ChatGPT モデルのトレーニング プロセスにヒューマン フィードバックからの強化学習 (RLHF) プロセスが追加されます。

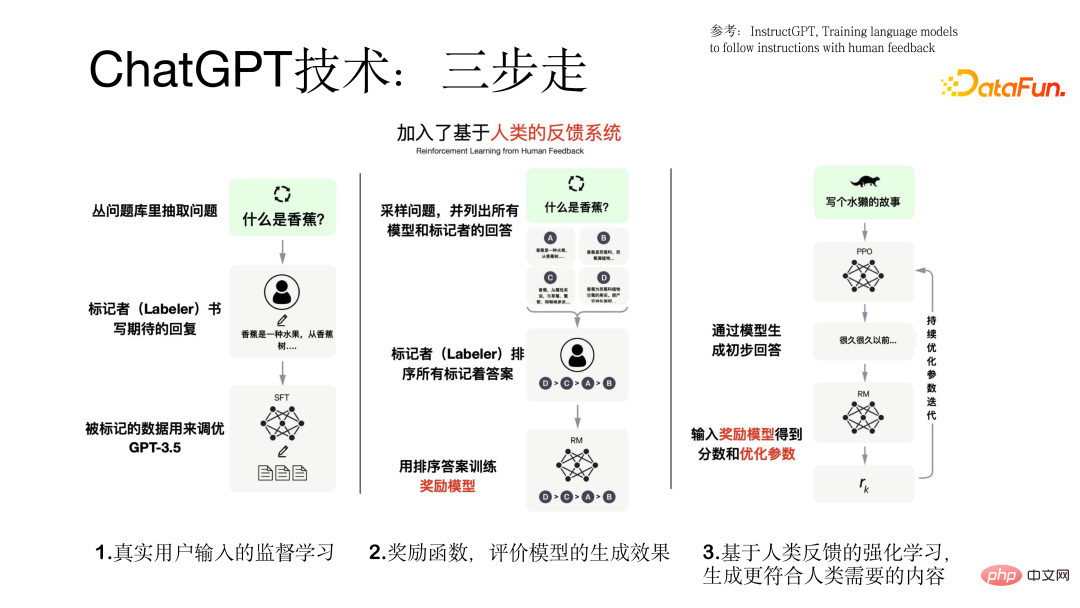

ChatGPT モデルのトレーニング プロセスは 3 つの段階で実行されます。ステッププロセス。

最初のステップは、 GPT モデルに基づく教師あり学習に実際のユーザー入力を使用することです。プロセス内のデータは実際のユーザーからのものであり、データの品質は比較的高く、価値があります。

2 番目のステップは、報酬モデルをトレーニングすることです。モデルが異なれば、クエリに対して異なる出力が生成されます。その結果、タガーはすべてのモデルの出力結果を並べ替え、これらの並べ替えられたデータを使用して報酬モデルをトレーニングします。

3 番目のステップは、モデルによって生成された暫定的な回答を報酬モデルに入力します。報酬モデルは回答を評価します。生成された場合、答えがユーザーの意図に沿ったものであればポジティブなフィードバックが与えられ、そうでなければネガティブなフィードバックが与えられることでモデルがどんどん良くなっていき、生成される結果をより人間のニーズに沿ったものにすることが強化学習を導入する目的です。 。 ChatGPT モデルをトレーニングする 3 段階のプロセスを次の図に示します。

モデルをトレーニングする前に、使用するデータ セットを準備する必要があります。このプロセスでは、データ コールド スタートの問題が発生します。次の 3 つの側面によって解決できます:

#(1) 旧システムのユーザーが使用していたデータセットを収集する

#(2) いくつかのプロンプトを考える前に、アノテーターがいくつかの同様のプロンプトに注釈を付け、実際のユーザーが入力した質問に基づいて

を出力します。 ChatGPT モデルをトレーニングするためのデータには、データ セット (77,000 の実データ) の 3 つの部分が含まれています。

(1) 教師あり学習ベース実際のユーザー プロンプト データ、ユーザー プロンプト、モデル応答のデータ量は 13k です。

(2) 報酬モデルのトレーニングに使用されるデータセット。データのこの部分は、1 つのプロンプトに対応する複数の応答を並べ替えるためのものです。データ量は33kです。

# (3) モデルのトレーニングに強化学習テクノロジーを使用した報酬モデルに基づくデータセット。ユーザーのプロンプトのみが必要です。データ量は 31k、高い品質要件があります。 ChatGPT モデルのトレーニングを完了すると、主に次の側面からモデルの評価が比較的十分になります。

(1) かどうかモデルによって生成された結果はユーザーの意図を満たしているか

(2) 生成された結果はユーザーが指定した制約を満たせるかどうか

(3) 顧客サービス分野で良い結果が得られるかどうか

#従来モデルとの比較詳細GPT基本モデル 実験結果を下図に示します。

2. ChatGPT テクノロジーのローカライゼーション#以下では、その背景と問題点、解決策のアイデア、効果について説明します。この側面では、ChatGPT テクノロジーのローカリゼーションを紹介します。

1. 背景と課題ローカライゼーションを行う必要がある理由として、主に次の点を考慮します。

## (1) ChatGPT テクノロジー自体は比較的先進的で、多くのタスクにうまく機能しますが、中国本土にはサービスを提供しません。# (2) 国内のエンタープライズレベルの顧客のニーズを満たすことができない可能性があり、現地に合わせた技術サポートやサービスを提供できない場合があります。

# (3) 価格は主な市場であるヨーロッパとアメリカでは米ドルで設定されており、価格は比較的高価であり、国内ユーザーのほとんどは余裕がありません。テストの結果、データあたりのコストは約 0.5 元であり、大量のデータを持つ顧客には商用化が不可能であることが判明しました。

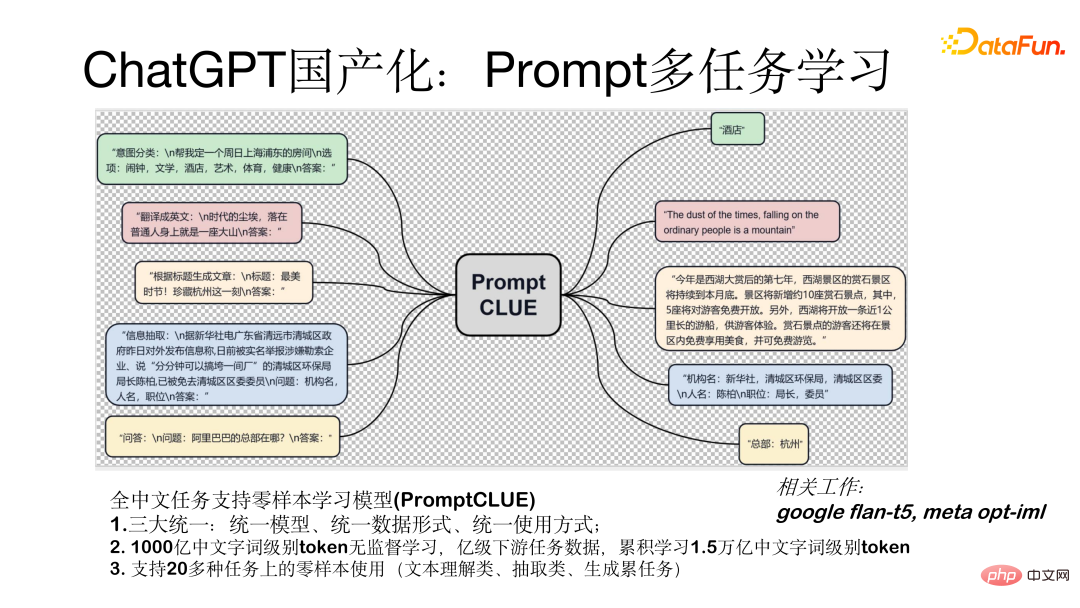

上記の 3 つの問題のため、私たちは ChatGPT テクノロジーのローカライズを試みました。 #現在、ChatGPT テクノロジーのローカライズを進めています。 , 分散戦略が採用されました。 最初に、数百億のパラメータを持つ中国語の事前トレーニング モデルがトレーニングされました。次に、10 億レベルのタスク データに対して Prompt を使用してタスク教師あり学習が実行され、その後モデルが会話化、つまり対話または人間とコンピューターの相互作用の形で人々と対話する; 最後に、報酬モデルとユーザー フィードバックの強化学習 RLHF テクノロジーを紹介します。 プロンプト マルチタスク学習モデル (PromptCLUE) は、すべての中国語タスクのゼロサンプル学習をサポートするモデルです。このモデルは、統一モデル、統一データ形式(すべてのタスクをプロンプト形式に変換)、統一使用方法(ゼロサンプル形式で使用)の 3 つの主要な統一を実現します。このモデルは、1,000 億の中国語単語レベルのトークンの教師なし学習に基づいており、10 億レベルの下流タスク データでトレーニングされ、1 兆 5,000 億の中国語単語レベルのトークンが蓄積されています。 20 を超えるタスク (テキスト理解、抽出、生成タスク) でのゼロサンプルの使用をサポートします。 2. ソリューションのアイデア

モデルを会話型にする方法、つまり人間とコンピューターの対話形式のモデルに変換する方法、私たちは主に次の側面を行いました 作業:

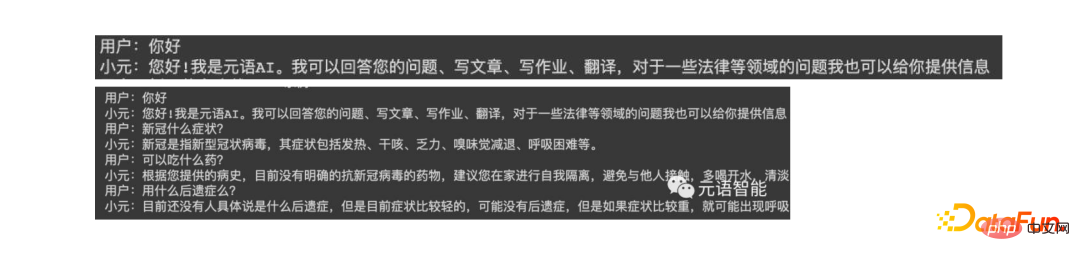

まず、モデルの生成効果を高めるために、テキストの理解と抽出のタスクを削除し、質問を強化しました。応答、対話、生成タスク、学習、第二に、対話モデルに変換した後、生成された結果はコンテキストによって干渉されます。この問題に対処するために、モデルが必要に応じて無関係なコンテキストを無視できるように、干渉防止データを追加しました。 ; 最後に、実際のユーザーのフィードバック データに基づいて、モデルがユーザーの意図をよりよく理解できるようにするための学習プロセスが追加されました。以下の図は、モデルを使用した単一ラウンドおよび複数ラウンドのテストの形式を示しています。

#以下は、次のテストです。 ChatGPT モデルと現在の効果を比較すると、まだ 1 ~ 2 年のギャップがありますが、このギャップは徐々に埋めることができます。現時点では、いくつかの有用な試みが行われ、一定の成果が得られています。現在、対話、Q&A、執筆、その他のやり取りが行われています。下の画像はテスト結果を示しています。

##3. 国内オープンソース大規模モデル

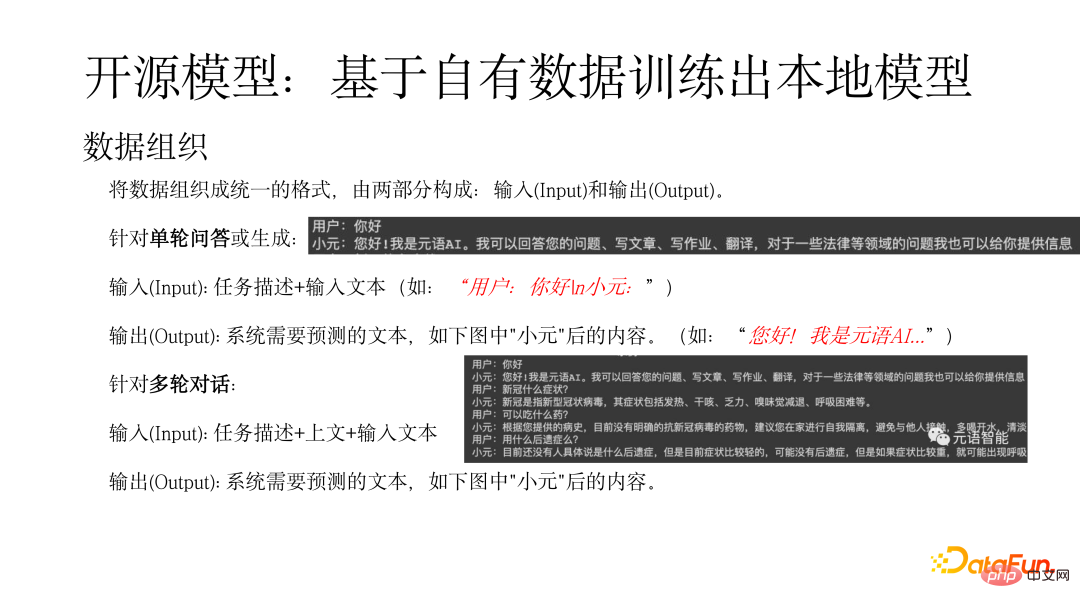

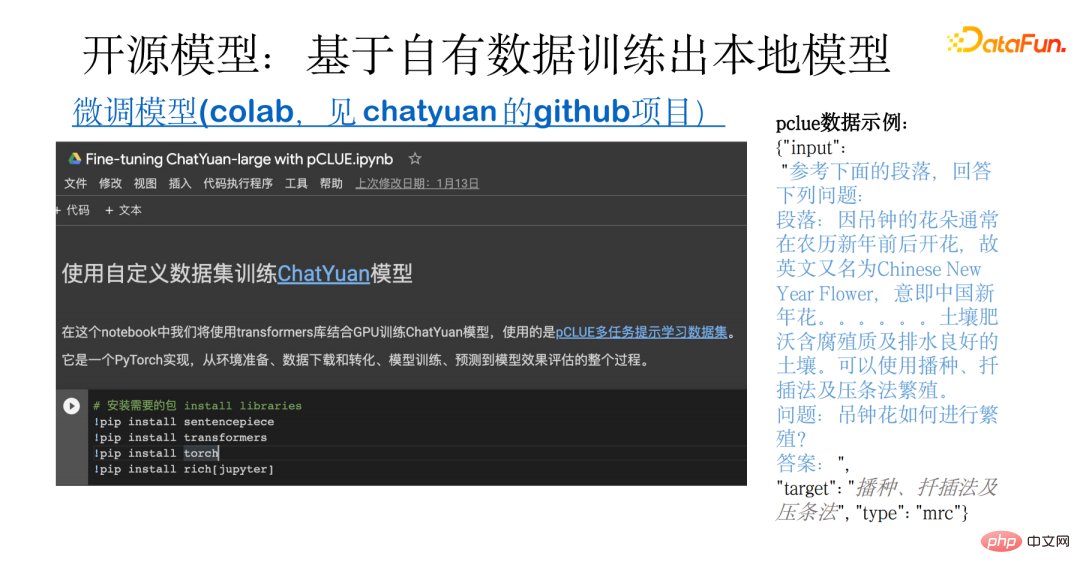

#まず、データを次の 2 つの部分で構成される統一された形式に編成する必要があります。入出力。 1 ラウンドの質問と回答または生成された入力 (入力) の場合: タスク説明の入力テキスト (「ユーザー: Hello n Xiaoyuan:」など)、出力 (出力) は、システムが予測する必要があるテキスト (次のような) を指します。 : 「こんにちは! 私はメタ言語 AI です...」)。マルチラウンド ダイアログ入力 (入力) の場合: 入力テキストの上のタスクの説明。出力は、以下の図の「Xiaoyuan」の後に示すように、システムが予測する必要があるテキストを指します。 #次の図は、独自のデータに基づいてローカル モデルをトレーニングする例を示しています。この例では、データの準備からオープンソース データのダウンロードと変換、モデルのトレーニング、予測、評価までのプロセス全体を取り上げます。基礎となるのは pCLUE マルチタスク データセットです。ユーザーは独自のデータをトレーニングに使用することも、pCLUE を使用して事前トレーニングを行って効果をテストすることもできます。 ChatYuan と ChatGPT はどちらも一般的な機能会話モデルであり、チャットや法律や医学などの専門分野での質問と回答、対話、生成が可能です。 ChatGPT モデルと比較すると、依然として一定のギャップがあり、主に次の側面に反映されています: #モデルの効果をさらに向上させるには、次の点から始めることができます: # # (1) 教師なし事前トレーニングを含むさらなるトレーニングのために業界データを結合し、教師あり学習に大量の高品質データを使用します。 ## (2) 実際のユーザーのフィードバック データを使用した学習により、分布の違いを補うことができます。 #(3) 強化学習を導入してユーザーの意図を一致させる。 # (4) より大きなモデルを選択する 一般的に、モデルが大きいほど、モデルの機能が強化されます。 ChatGPT によってもたらされた新しいテクノロジーと使用シナリオにより、人々は AI の大きな可能性を理解できるようになります。より多くのアプリケーションがアップグレードされ、いくつかの新しいアプリケーションの可能性が生まれます。 Yuanyu Intelligence は、大規模モデルの Model-as-a-Service サービス プロバイダーとして、この分野でも常に調査を行っています。ご興味のあるパートナー様は、当社ウェブサイトおよび公式アカウントをぜひご注目ください。 2. 独自のデータに基づいてローカル モデルをトレーニングする

以上がChatGPT テクノロジーをローカライズする試みの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。