中国の医師と Google の科学者は最近、ビデオ内の複数のイベントを区別して説明できる事前トレーニング済み視覚言語モデル Vid2Seq を提案しました。この論文は CVPR 2023 に受理されました。

最近、Google の研究者は、マルチイベント ビデオを記述するための事前トレーニング済み視覚言語モデル Vid2Seq を提案し、CVPR23 に受け入れられました。

以前は、ビデオには異なる時間スケールで発生する複数のイベントが含まれることが多かったため、ビデオ コンテンツを理解するのは困難な作業でした。

たとえば、マッシャーが犬をそりに繋ぎ、犬が走り始めるビデオには、長いイベント (犬ぞり) と短いイベント (犬がそりに繋がれている) が含まれます。

ビデオ理解研究を進める 1 つの方法は、高密度のビデオ アノテーション タスクを使用することです。これには、1 分間のビデオ内のすべてのイベントを時間的に位置特定して説明することが含まれます。

論文アドレス: https://arxiv.org/abs/2302.14115

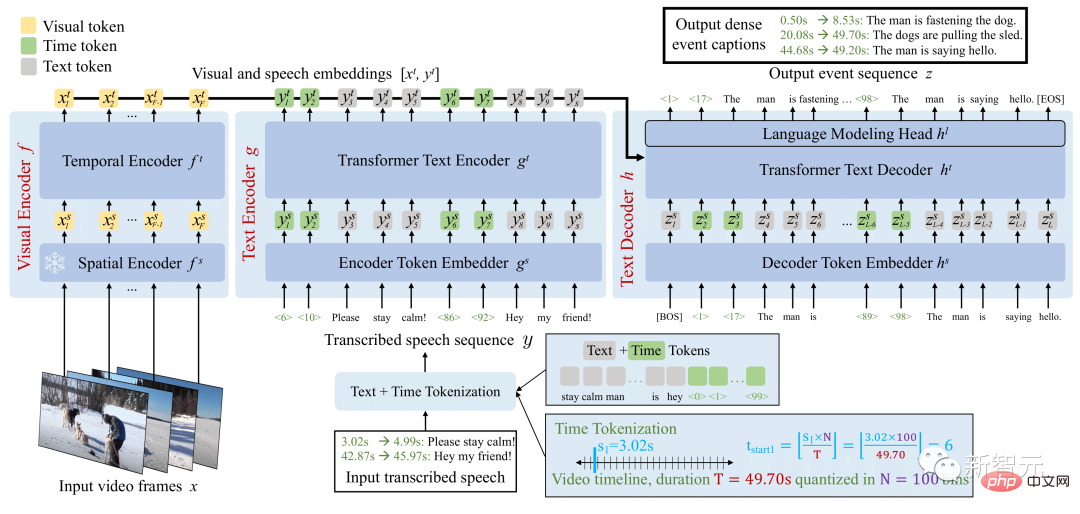

Vid2Seq アーキテクチャは、特別なタイムスタンプを使用して言語モデルを強化し、同じ出力シーケンス内のイベントの境界とテキストの説明をシームレスに予測します。

この統合モデルを事前トレーニングするために、研究者たちはラベルのないナレーション付きビデオを利用しました。

Vid2Seq モデルの概要

結果として得られた Vid2Seq モデルは、数百万のナレーション付きビデオで事前トレーニングされ、ビデオ アノテーション ベンチマークのさまざまな高密度の技術レベルが向上しました。 YouCook2、ViTT、ActivityNet のキャプション。

Vid2Seq は、数ショットの高密度ビデオ アノテーション設定、ビデオ セグメント アノテーション タスク、および標準ビデオ アノテーション タスクにも適しています。

マルチモーダル Transformer アーキテクチャにより、アクション認識などのさまざまなビデオ タスクの SOTA が更新されました。ただし、このようなアーキテクチャを、数分間のビデオ内のイベントを共同で見つけて注釈を付けるという複雑なタスクに適応させるのは簡単ではありません。

この目標を達成するために、研究者は、空間ドメインの Pix2Seq と同様に、ビデオ内の離散タイムスタンプを表す特別なタイム マーカー (テキスト マーカーなど) を使用して視覚言語モデルを強化しました。

特定のビジュアル入力に対して、結果として得られる Vid2Seq モデルは、入力を受け入れ、テキストおよび時間タグ付きシーケンスを生成することができます。

まず、これにより、Vid2Seq モデルは、単一のトークン シーケンスとして投影される、文字起こしされた音声入力の時間情報を理解できるようになります。第 2 に、これにより、Vid2Seq は単一のマーカー シーケンスを生成しながら、ビデオ内の高密度イベント アノテーションを時間的に統合して予測できるようになります。

Vid2Seq アーキテクチャには、ビデオ フレームと文字起こしされた音声入力をそれぞれエンコードするビジュアル エンコーダとテキスト エンコーダが含まれています。結果のエンコードはテキスト デコーダに転送され、高密度イベント アノテーションの出力シーケンスとビデオ内での時間的位置が自動的に予測されます。このアーキテクチャは、強力なビジュアル バックボーンと強力な言語モデルで初期化されています。

高密度ビデオ アノテーションのアノテーションを手動で収集することは、タスクの集中的な性質のため、特にコストがかかります。

したがって、研究者らは、大規模に簡単に利用できる、ラベルのないナレーション ビデオを使用して Vid2Seq モデルを事前トレーニングしました。また、YT-Temporal-1B データセットも使用しました。これには、幅広い領域をカバーする 1,800 万本のナレーション付きビデオが含まれています。

研究者らは、書き起こされた音声文とそれに対応するタイムスタンプを監視として使用し、これらの文は単一のトークン シーケンスとして投影されました。

Vid2Seq は、視覚入力が与えられた文字起こしされた音声シーケンスのみを予測するようにデコーダーに教える生成目標と、マルチモーダル学習を促進するノイズ除去目標を使用して事前トレーニングされ、モデルにノイズの多い文字起こしされた音声のコンテキストでの予測マスクを要求します。シーケンスと視覚的な入力。特に、スパントークンをランダムにマスクすることによって、音声シーケンスにノイズが追加されます。

結果として得られる事前トレーニング済み Vid2Seq モデルは、教師強制を使用する単純な最尤目標 (つまり、次のトークンに基づいて次のトークンを予測すると仮定した場合) を介して、下流タスクで微調整できます。以前の基本的な実際のトークン)。

微調整後、Vid2Seq は 3 つの標準的なダウンストリーム高密度ビデオ アノテーション ベンチマーク (ActivityNet Captions、YouCook2、および ViTT) と 2 つのビデオ クリップ アノテーション ベンチマーク (MSR-VTT、MSVD) で SOTA を上回りました。

この論文には、追加のアブレーション研究、定性的結果、数ショット設定およびビデオ段落注釈タスクの結果が含まれています。

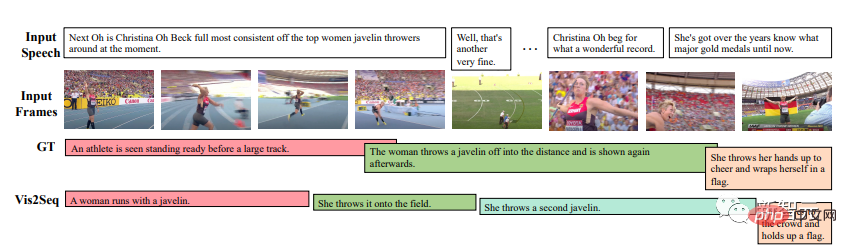

結果は、Vid2Seq が意味のあるイベントの境界と注釈を予測できること、および予測された注釈と境界が書き起こされた音声入力とは大きく異なることを示しています (これは、入力の重要性が重要であることも示しています)視覚マーカーの)。

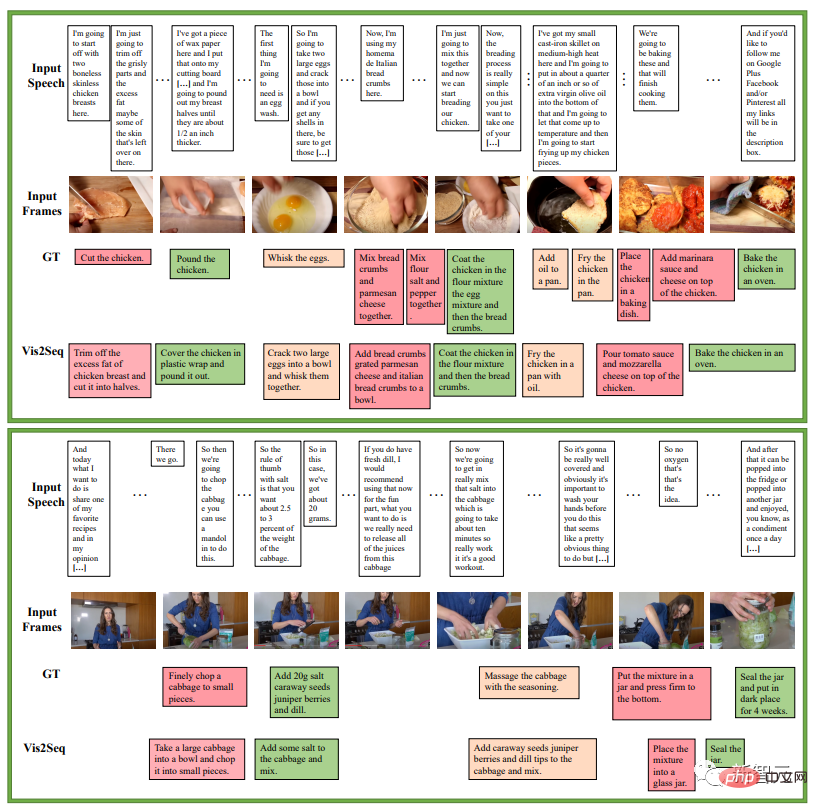

次の例は、料理レシピの一連の指示に関するもので、YouCook2 検証セットに対する Vid2Seq による集中的なイベント アノテーション予測の例です。

以下は、ActivityNet Captions 検証セットでの Vid2Seq の高密度イベント アノテーション予測の例です。これらのビデオにはすべて、文字起こしされた音声がありません。

しかし、それでも失敗するケースはあるでしょう。たとえば、Vid2Seq 氏によると、下の赤でマークされた写真は、カメラの前で帽子を脱ぐ人物です。

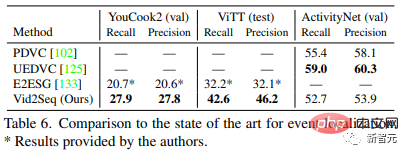

表 5 は、Vid2Seq と最先端の高密度ビデオ アノテーション メソッドを比較しています。Vid2Seq は、YouCook2、ViTT、ActivityNet Captions の 3 つのデータ セットで SOTA を更新します。

YouCook2 と ActivityNet Captions における Vid2Seq の SODA インジケーターは、PDVC と UEDVC よりそれぞれ 3.5 ポイントと 0.3 ポイント高くなっています。また、E2ESG は Wikihow でドメイン内のプレーン テキストの事前トレーニングを使用しており、Vid2Seq はこの方法よりも優れています。これらの結果は、事前トレーニングされた Vid2Seq モデルが高密度イベントをラベル付けする強力な能力を備えていることを示しています。

表 6 は、高密度ビデオ アノテーション モデルのイベント位置特定パフォーマンスを評価します。 YouCook2 や ViTT と比較して、Vid2Seq は高密度ビデオ アノテーションを単一のシーケンス生成タスクとして処理する点で優れています。

ただし、PDVC や UEDVC と比較すると、Vid2Seq は、ActivityNet キャプションでのパフォーマンスが低くなります。これら 2 つの方法と比較して、Vid2Seq は時間的位置特定に関する事前知識をあまり統合しませんが、他の 2 つの方法にはイベント カウンターなどのタスク固有のコンポーネントが含まれているか、位置特定サブタスク用にモデルを個別にトレーニングします。

ビジュアル テンポラル トランスフォーマー エンコーダー、テキスト エンコーダー、およびテキスト デコーダーはすべて、12 レイヤー、12 ヘッド、埋め込み次元 768、 MLP 隠された次元 2048。

テキスト エンコーダーとデコーダーのシーケンスは、事前トレーニング中は L=S=1000 トークンに切り詰められるか、微調整中は S=1000 および L=256 トークンにパディングされます。推論中に、ビーム検索デコードが使用され、最初の 4 つのシーケンスが追跡され、0.6 の長さ正規化が適用されます。

著者は、重み減衰なしで Adam オプティマイザー β=(0.9, 0.999) を使用しています。

事前トレーニング中、1e^-4 の学習率が使用され、最初の 1000 回の反復では線形にウォームアップ (0 から開始) され、残りの反復では一定に保たれます。

微調整中は、3e^-4 の学習率を使用し、反復の最初の 10% では線形にウォームアップ (0 から開始) し、残りの 90 % ではコサイン減衰 (0 まで) を維持します。反復の%。このプロセスでは、32 個のビデオのバッチ サイズが使用され、16 個の TPU v4 チップに分割されます。

著者は、YouCook2 に対して 40 エポック調整、ActivityNet Captions と ViTT に対して 20 エポック調整、MSR-VTT に対して 5 エポック調整、MSVD に対して 10 エポック調整を行いました。

Googleが提案したVid2Seqは、高密度ビデオアノテーションのための新しいビジュアル言語モデルであり、ラベルのないナレーションビデオに対して大規模な事前トレーニングを効果的に実行でき、さまざまなダウンストリームでSOTA結果を達成しています高密度ビデオ注釈ベンチマーク。

著者紹介

論文の筆頭著者: Antoine Yang

Antoine Yang は、パリの Inria および高等師範学校の WILLOW チームの博士課程 3 年生で、指導教員は Antoine Mitoch、Josef Sivic、Ivan Laptev、Cordelia Schmid です。

現在の研究は、ビデオを理解するための視覚言語モデルの学習に焦点を当てています。彼は2019年にファーウェイのノアの方舟研究所でインターンし、2020年にパリのエコール・ポリテクニックで工学の学位を取得し、パリ国立大学サクレー校で数学、ビジョン、学習の修士号を取得し、2022年にGoogle Researchでインターンを務めた。

以上がGoogle がマルチモーダル Vid2Seq を発表、オンラインでビデオ IQ を理解、字幕はオフラインにならない | CVPR 2023の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。