現代の大規模言語モデルの背後にある設計、制約、進化について学ぶには、この記事の参考文献リストを参照してください。

大規模言語モデルは世間の注目を集め、わずか 5 年で Transforme などのモデルは自然言語処理の分野をほぼ完全に変えました。さらに、コンピューター ビジョンや計算生物学などの分野にも革命を起こし始めています。

Transformers がすべての研究プロセスに非常に大きな影響を与えていることを考慮して、この記事では、機械学習の研究者や実践者が始めるための短い参考文献リストを紹介します。

次のリストは、主にいくつかの学術研究論文を時系列順に展開したものです。もちろん、他にも役立つリソースがたくさんあります。例:

Transformers と大規模な言語モデルを初めて使用する場合は、これらの記事があなたに最適です。

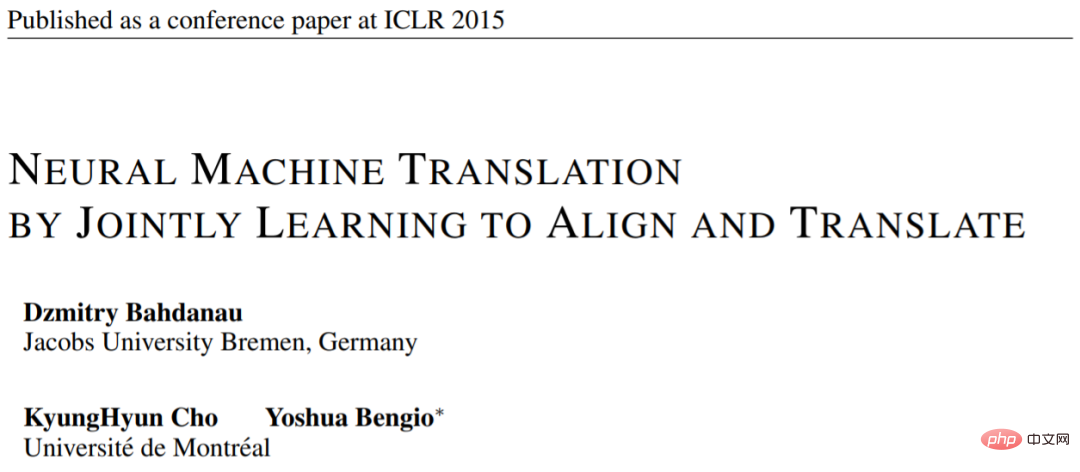

論文 1: 「位置合わせと翻訳を共同学習することによるニューラル機械翻訳」

論文アドレス: https:// arxiv.org/pdf/1409.0473.pdf

この記事では、モデルの長距離シーケンス モデリング機能を向上させるリカレント ニューラル ネットワーク (RNN) アテンション メカニズムを紹介します。これにより、RNN は長い文をより正確に翻訳できるようになります。これが、元の Transformer アーキテクチャの開発の背後にある動機です。

画像ソース: https://arxiv.org/abs/1409.0473

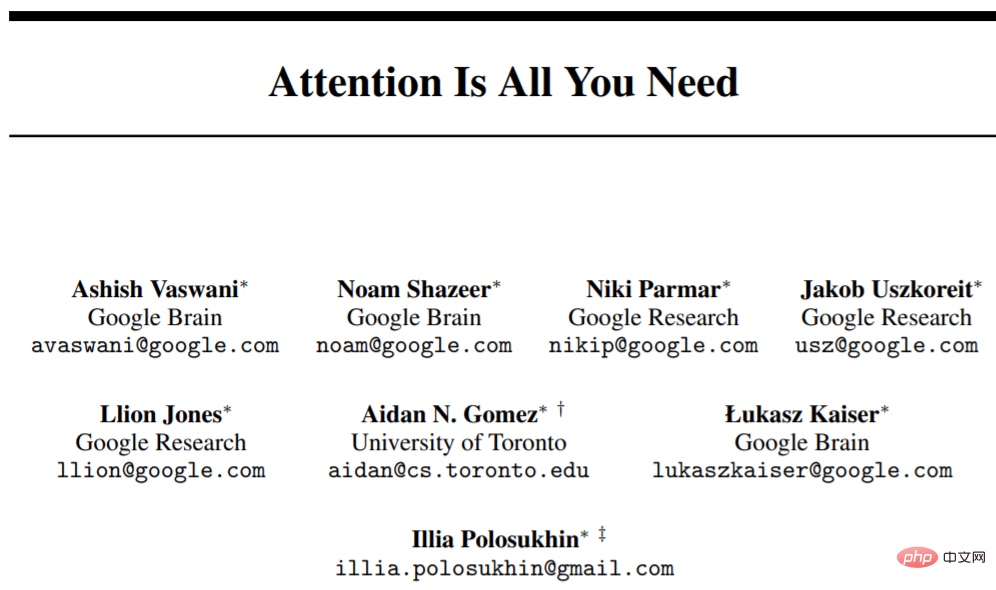

論文 2: 「必要なのは注意だけです」 》

論文アドレス: https://arxiv.org/abs/1706.03762

この記事では、エンコーダとデコーダの構成について紹介します。オリジナルの Transformer アーキテクチャでは、これらの部分は後で別個のモジュールとして導入されます。さらに、この記事では、スケーリング ドット積アテンション メカニズム、マルチヘッド アテンション ブロック、位置入力エンコーディングなどの概念も紹介します。これらは依然として現代の Transformers の基礎となっています。

出典: https://arxiv.org/abs/1706.03762

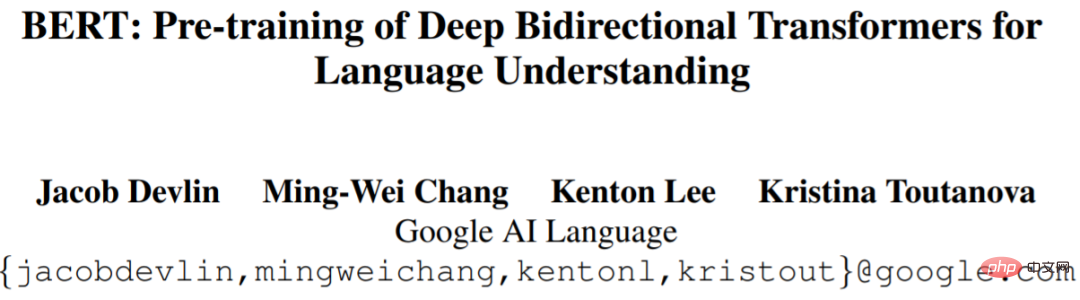

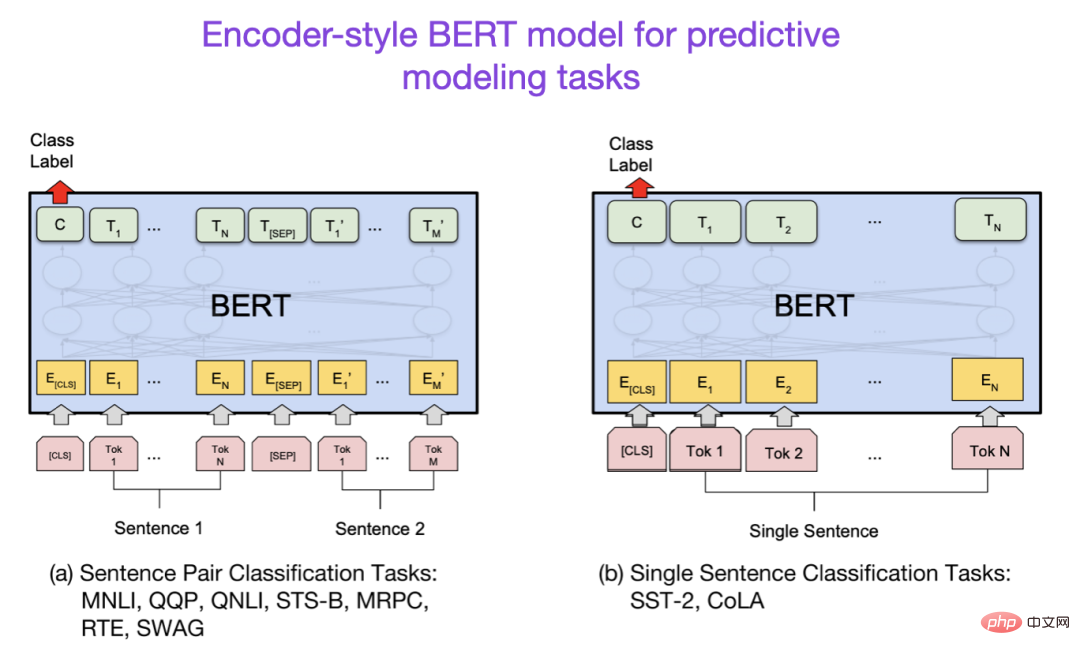

論文 3: 「BERT: Pre -言語理解のための深い双方向トランスフォーマーのトレーニング》

論文アドレス: https://arxiv.org/abs/1810.04805

Large - スケール言語モデルの研究は、初期の Transformer アーキテクチャに従い、その後、予測モデリング タスク (テキスト分類など) 用の Transformer と生成モデリング タスク (翻訳、要約、その他の形式のテキスト作成) 用の Transformer の 2 つの方向に拡張し始めました。変成器。

BERT 論文では、マスクされた言語モデリングの独自の概念が紹介されています。この研究分野に興味がある場合は、事前トレーニングの目標を簡素化する RoBERTa をフォローしてください。

画像ソース: https://arxiv.org/abs/1810.04805

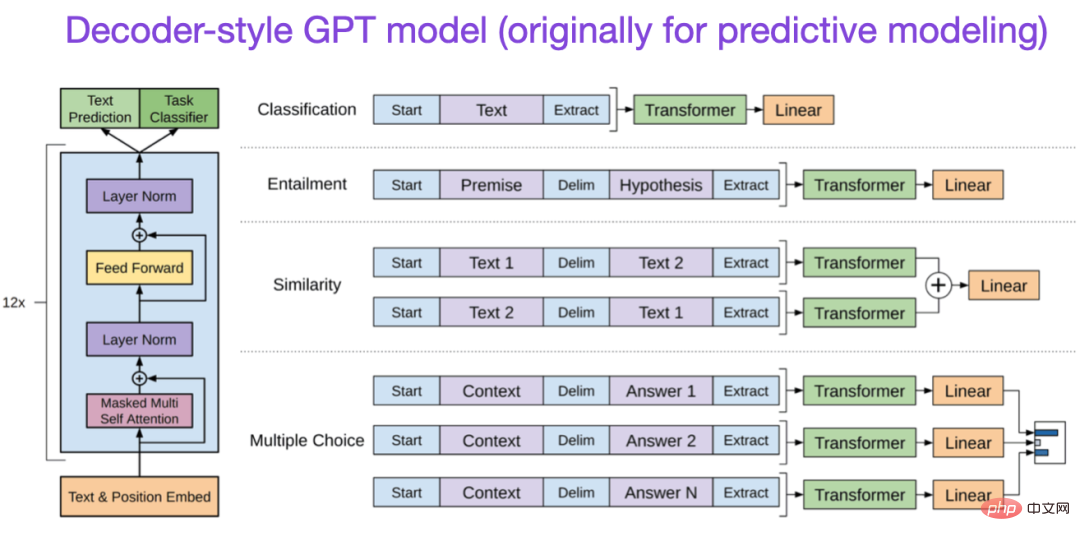

論文 4: 「言語の改善」生成的事前トレーニングによる理解》

論文アドレス: https://www.semanticscholar.org/paper/Improving-Language-Understanding-by-Generative- Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035

元の GPT 論文では、人気のあるデコーダー スタイルのアーキテクチャと次の単語予測による事前トレーニングが紹介されています。 BERT は、マスクされた言語モデルの事前トレーニング目標により双方向の Transformer であると考えることができますが、GPT は一方向の自己回帰モデルです。 GPT 埋め込みも分類に使用できますが、GPT メソッドは ChatGPT など、今日最も影響力のある LLM の中核となっています。

この研究分野に興味がある場合は、GPT-2 および GPT-3 の論文をフォローしてください。なお、この記事ではInstructGPTメソッドについては後ほど別途紹介します。

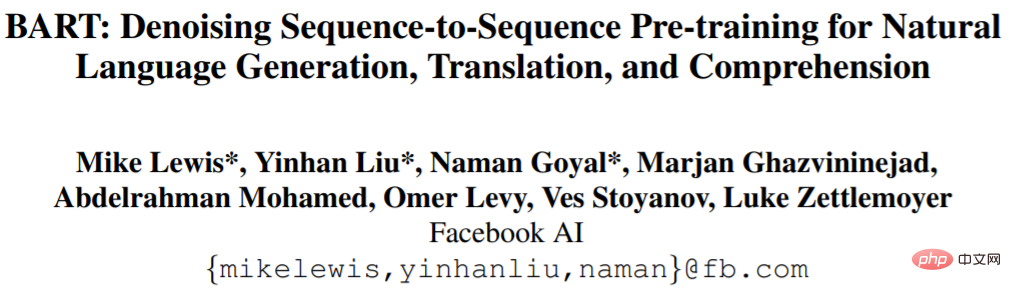

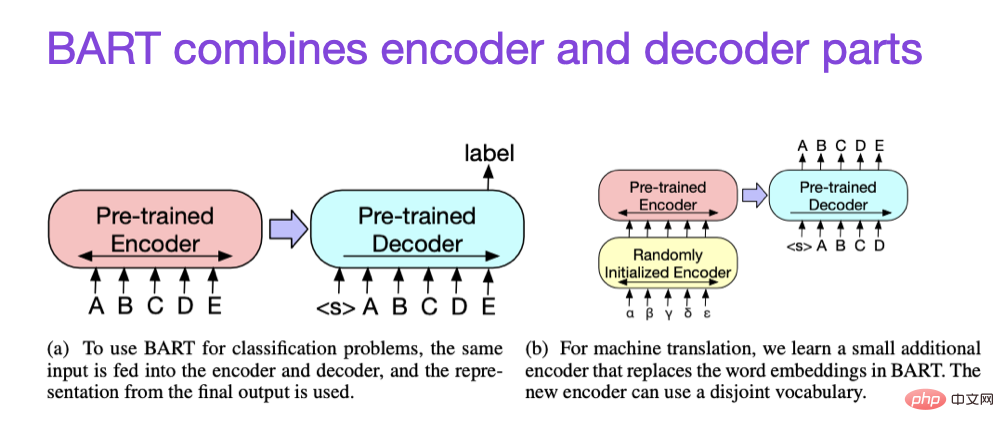

#論文 5: 「BART: 自然言語の生成、翻訳、理解のためのシーケンス間の事前トレーニングのノイズ除去」

#拡張則と効率改善

#拡張則と効率改善

##論文 2:「FlashAttendant: IO 認識による高速かつメモリ効率の高い Exact Attendance」

論文 3: 「詰め込み: 1 日で 1 つの GPU で言語モデルをトレーニングする」

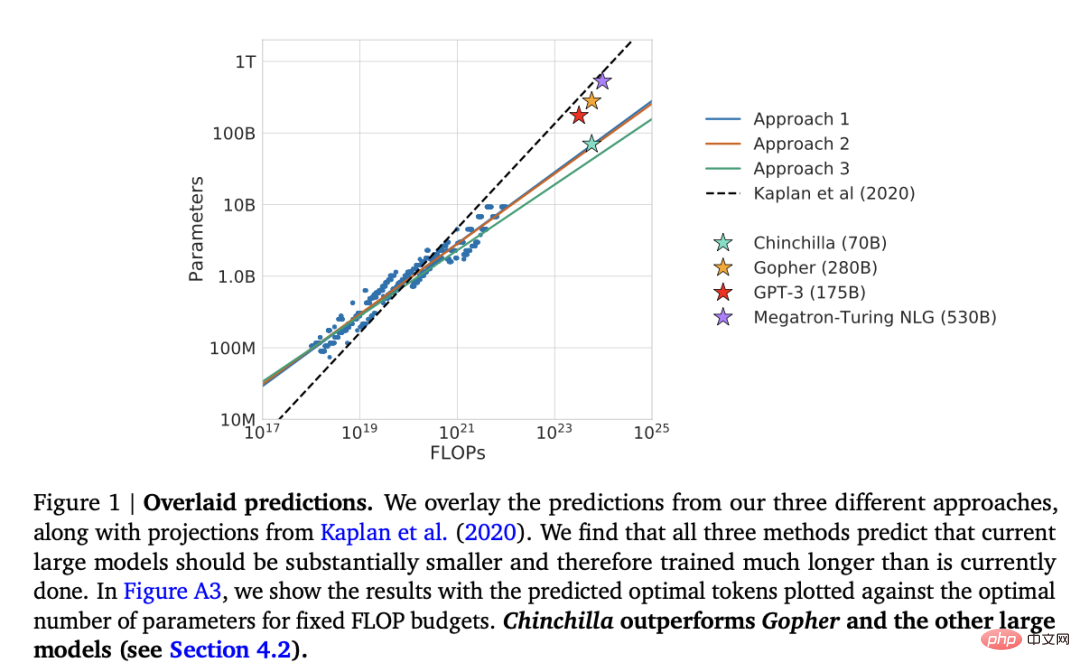

論文 4:「コンピューティングに最適な大規模言語モデルのトレーニング」

この記事では、生成モデリング タスクにおいて一般的な 1,750 億パラメータの GPT-3 モデルを上回る 700 億パラメータのチンチラ モデルを紹介します。ただし、その主なハイライトは、現代の大規模言語モデルが大幅にトレーニングされていないことです。

この記事では、大規模言語モデルのトレーニングのための線形スケーリング則を定義します。たとえば、Chinchilla は GPT-3 の半分のサイズですが、(3,000 億ではなく) 1 兆 4,000 億のトークンでトレーニングされているため、GPT-3 よりも優れたパフォーマンスを発揮します。言い換えれば、トレーニング トークンの数はモデルのサイズと同じくらい重要です。

調整 - 大規模な言語モデルを望ましい目標と関心に向けて導く

近年、比較的強力な手法が数多く登場しています。実際のテキストを生成できるモデル (GPT-3 や Chinchilla など)。一般的に使用されている事前トレーニング パラダイムに関しては、上限に達しているようです。 言語モデルを人間にとってより役立つものにし、誤った情報や悪い言葉を減らすために、研究者は、次の論文を含む、事前トレーニングされた基本モデルを微調整するための追加のトレーニング パラダイムを設計しました。

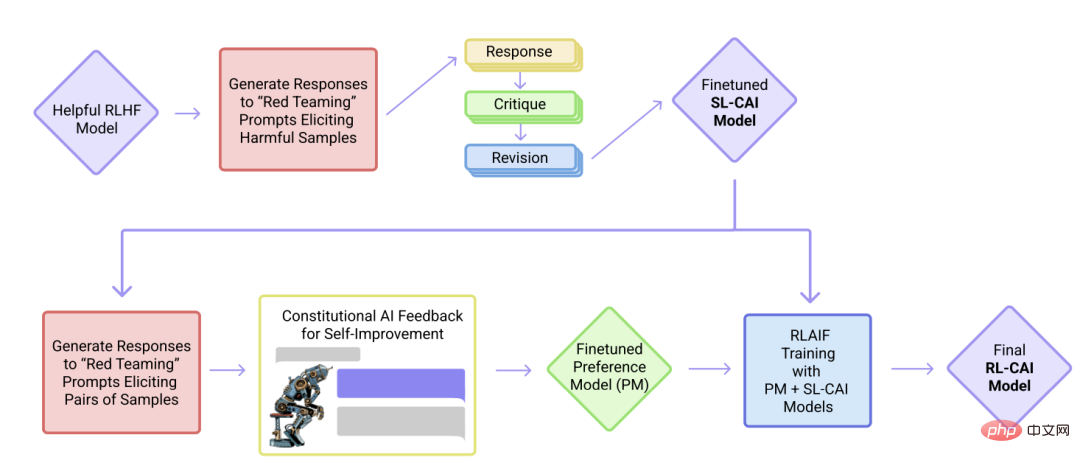

論文 1:「人間のフィードバックによる指示に従う言語モデルのトレーニング」論文のアドレス: https://arxiv.org/abs/2203.02155この記事の内容論文の中で、研究者らはアライメントの考え方をさらに進め、「無害な」AI システムを作成するためのトレーニング メカニズムを提案しています。研究者らは、人間が直接監督するのではなく、(人間が提供する)ルールのリストに基づいた自己訓練メカニズムを提案した。前述の InstructGPT の論文と同様に、提案された手法は強化学習手法を使用します。

この記事では、上記のフォームの配置をできるだけシンプルかつ美しく保つよう努めています。最初の 10 個に焦点を当てることをお勧めします。現代の大規模言語モデルの背後にある考え方、設計、制限、進化を理解するための論文。

さらに詳しく読みたい場合は、上記の論文の参考文献を参照することをお勧めします。あるいは、読者がさらに詳しく調べるための追加リソースがいくつかあります:

GPT の代替オープンソース

ChatGPT 代替案

計算生物学における大規模言語モデル

以上が大規模な言語モデルを包括的に理解するための参考文献リストは次のとおりです。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。