Aujourd'hui, Google a annoncé le lancement de Gemini 1.5.

Gemini 1.5 est développé sur la base des innovations de recherche et d'ingénierie de Google en matière de modèles fondamentaux et d'infrastructure. Cette version introduit une nouvelle architecture Mix of Experts (MoE) pour améliorer l'efficacité de la formation et du service Gemini 1.5.

Ce que Google a lancé, c'est la première version de Gemini 1.5 pour les premiers tests, à savoir Gemini 1.5 Pro. Il s’agit d’un modèle multimodal de taille moyenne, mis à l’échelle et optimisé pour une variété de tâches. Comparé au plus grand modèle de Google, 1.0 Ultra, Gemini 1.5 Pro offre des niveaux de performances similaires et introduit des fonctionnalités expérimentales révolutionnaires pour mieux comprendre le contexte long.

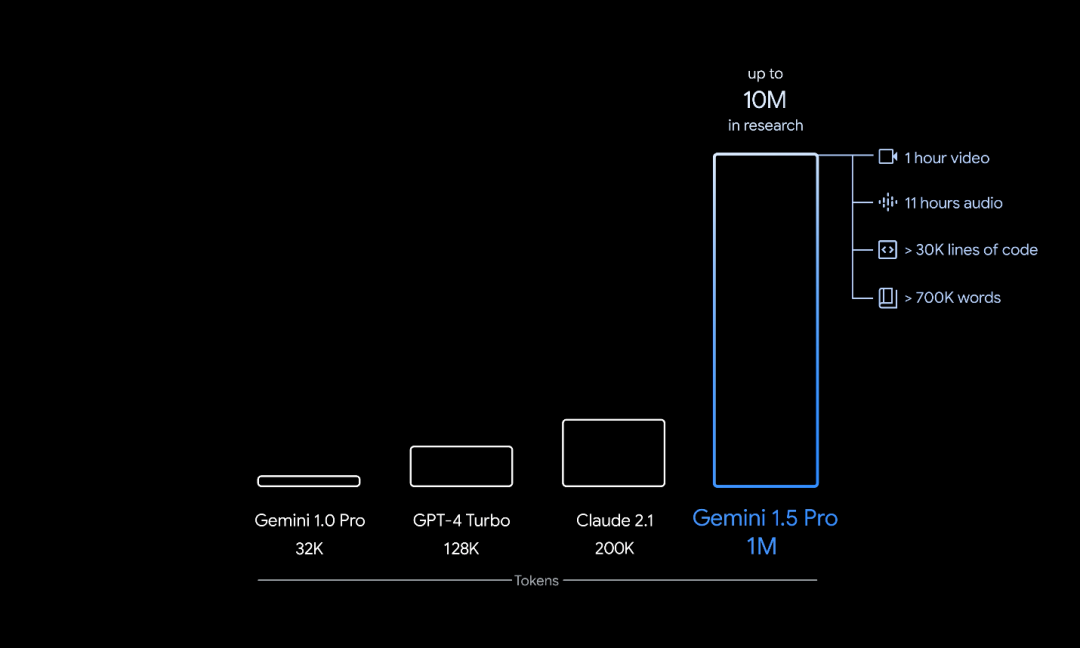

Le nombre de fenêtres contextuelles de jetons pour Gemini 1.5 Pro est de 128 000. Cependant, à partir d'aujourd'hui, Google propose un aperçu privé d'AI Studio et de Vertex AI à un nombre limité de développeurs et d'entreprises clientes, leur permettant de l'essayer dans une fenêtre contextuelle pouvant atteindre 1 000 000 de jetons. De plus, Google a procédé à plusieurs optimisations visant à améliorer la latence, à réduire les exigences informatiques et à améliorer l'expérience utilisateur.

Le PDG de Google, Sundar Pichai, et le PDG de Google DeepMind, Demis Hassabis, ont donné une introduction spéciale au nouveau modèle.

的 La longueur du contexte du modèle de base leader

Architecture à haute efficacité Gemini 1.5 est basé sur les recherches de pointe de Google sur l'architecture Transformer et MOE. Le Transformer traditionnel agit comme un grand réseau neuronal, tandis que le modèle MoE est divisé en réseaux neuronaux « experts » plus petits. En fonction du type d'entrée fourni, le modèle MoE apprend à activer sélectivement uniquement les chemins experts les plus pertinents dans son réseau neuronal. Cette spécialisation augmente considérablement l'efficacité du modèle. Google a été l'un des premiers à adopter et pionnier de la technologie MoE d'apprentissage profond grâce à des recherches sur MoE à grille clairsemée, GShard-Transformer, Switch-Transformer, M4, etc.

Les dernières innovations de Google en matière d'architecture de modèle permettent à Gemini 1.5 d'apprendre des tâches complexes plus rapidement et de maintenir la qualité, tout en formant et en servant plus efficacement. Ces gains d'efficacité aident les équipes de Google à itérer, former et fournir des versions plus avancées de Gemini plus rapidement que jamais, et travaillent sur de nouvelles optimisations.

Contexte plus long, fonctionnalités plus utilesLa « fenêtre contextuelle » du modèle d'intelligence artificielle est composée de jetons, qui sont les éléments constitutifs du traitement des informations. Un jeton peut être une partie entière ou une sous-partie d’un texte, d’une image, d’une vidéo, d’un audio ou d’un code. Plus la fenêtre contextuelle d'un modèle est grande, plus il peut recevoir et traiter d'informations dans une invite donnée, ce qui rend sa sortie plus cohérente, pertinente et utile. Grâce à une série d'innovations en matière d'apprentissage automatique, Google a augmenté la capacité de la fenêtre contextuelle de 1.5 Pro bien au-delà des 32 000 jetons initiaux de Gemini 1.0. Le grand modèle peut désormais fonctionner en production avec jusqu'à 1 million de jetons.

Cela signifie que le 1.5 Pro peut gérer d'énormes quantités d'informations à la fois, dont 1 heure de vidéo, 11 heures d'audio, plus de 30 000 lignes de code ou une base de code de plus de 700 000 mots. Dans le cadre d'une recherche Google, jusqu'à 10 millions de jetons ont également été testés avec succès.

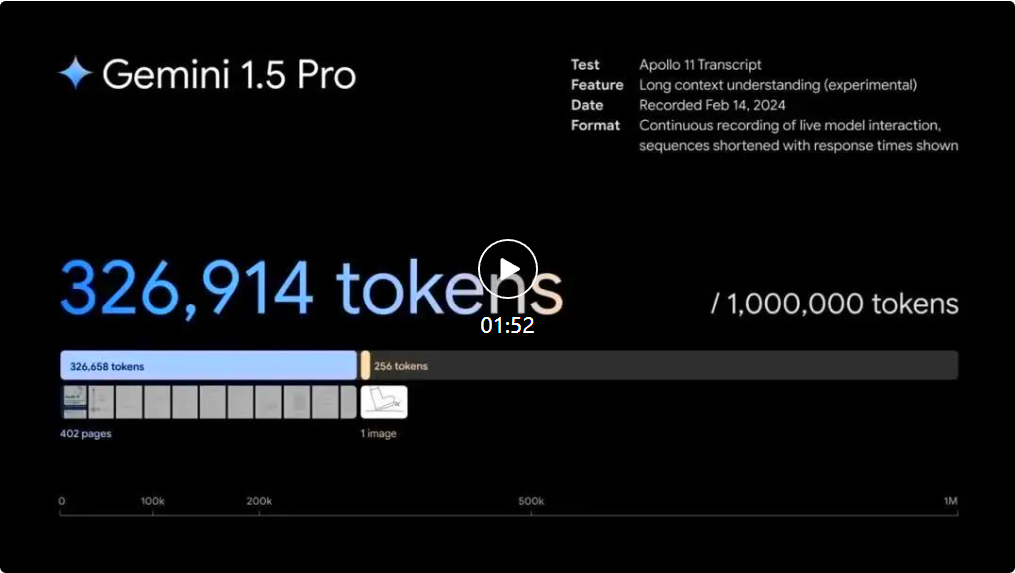

Raisonnement complexe sur de grandes quantités d'informations1.5 Pro peut analyser, classer et résumer de manière transparente de grandes quantités de contenu dans une invite donnée. Par exemple, lorsqu'on lui donne une transcription de 402 pages de la mission d'alunissage d'Apollo 11, il pourrait raisonner sur les dialogues, les événements et les détails tout au long du document. # Gemini 1.5 Pro pour comprendre, raisonner et identifier les détails curieux des 402 pages d'enregistrements de la mission d'alunissage d'Apollo 11. Meilleure compréhension et raisonnement selon les modalités

1.5 Pro peut effectuer des tâches de compréhension et de raisonnement très complexes pour différentes modalités, y compris la vidéo. Par exemple, lorsqu'on lui donnait un film muet de 44 minutes de Buster Keaton, le modèle pouvait analyser avec précision divers points et événements de l'intrigue, et même raisonner sur de petits détails du film qui étaient facilement négligés.

Gemini 1.5 Pro peut comprendre, raisonner et identifier des détails curieux dans le dossier de 402 pages de la mission d'alunissage d'Apollo 11.

Meilleure compréhension et raisonnement selon les modalités

1.5 Pro peut effectuer des tâches de compréhension et de raisonnement très complexes pour différentes modalités, y compris la vidéo. Par exemple, lorsqu'on lui présente un film muet de 44 minutes de Buster Keaton, le modèle peut analyser avec précision divers points et événements de l'intrigue, et même raisonner sur de petits détails du film qui sont facilement négligés.

Gemini 1.5 Pro peut comprendre, raisonner et identifier des détails curieux dans le dossier de 402 pages de la mission d'alunissage d'Apollo 11.

Meilleure compréhension et raisonnement selon les modalités

1.5 Pro peut effectuer des tâches de compréhension et de raisonnement très complexes pour différentes modalités, y compris la vidéo. Par exemple, lorsqu'on lui donnait un film muet de 44 minutes de Buster Keaton, le modèle pouvait analyser avec précision divers points et événements de l'intrigue, et même raisonner sur de petits détails du film qui étaient facilement négligés.

Lorsqu'on lui donnait de simples dessins au trait comme matériel de référence pour des objets réels, Gemini 1.5 Pro pouvait identifier 44 minutes de scènes d'un film muet de Buster Keaton.

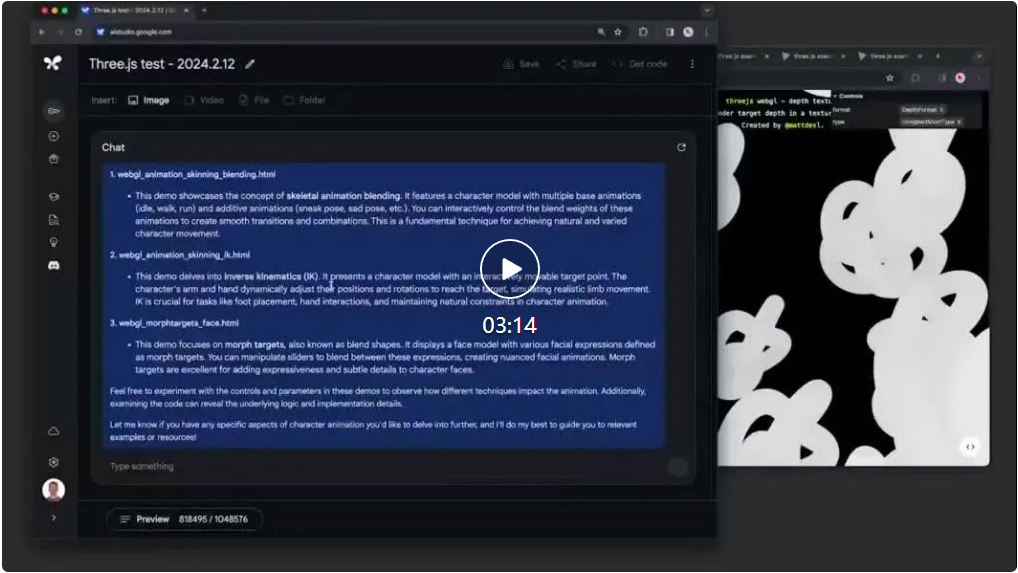

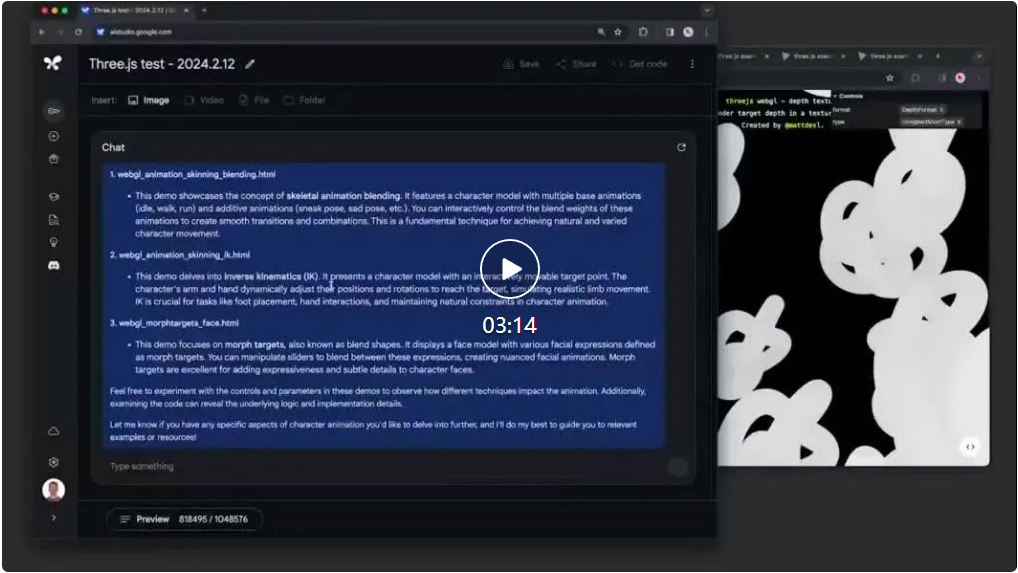

Utilisez des blocs de code plus longs pour résoudre les problèmes associés 1.5 Pro peut effectuer des tâches de résolution de problèmes plus pertinentes sur des blocs de code plus longs. Lorsqu'on lui donne des indices sur plus de 100 000 lignes de code, il peut mieux raisonner à l'aide d'exemples, suggérer des modifications utiles et expliquer le fonctionnement des différentes parties du code.

Panneau complet d'évaluation du texte, du code, de l'image, de l'audio et de la vidéo Une fois testé. sur Windows Phone, 1.5 Pro a surpassé 1.0 Pro sur 87 % des tests utilisés pour développer des modèles de langage étendus (LLM). Comparé au 1.0 Ultra dans les mêmes benchmarks, ses performances sont à peu près similaires.

Même si la fenêtre contextuelle augmente, Gemini 1.5 Pro maintient un haut niveau de performances.

Dans l'évaluation NIAH, un petit morceau de texte contenant un fait ou une déclaration spécifique a été intentionnellement placé dans un bloc de texte très long, 1.5 Pro a trouvé le texte intégré 99 % du temps, dans le bloc de données comme suit pour juste 100 Dix mille jetons.

Gemini 1.5 Pro démontre également d'impressionnantes compétences « d'apprentissage en contexte », ce qui signifie qu'il peut acquérir de nouvelles compétences à partir des informations fournies dans de longues invites sans avoir besoin de réglages supplémentaires. Google a testé cette compétence sur le benchmark MTOB (Translation from One Book), qui montre la capacité du modèle à apprendre à partir d'informations qu'il n'a jamais vues auparavant. Lorsqu'on lui donne un manuel de grammaire pour le Kalamang, une langue qui compte moins de 200 locuteurs dans le monde, le modèle peut apprendre à traduire l'anglais vers le Kalamang à un niveau similaire à celui d'un humain apprenant le même contenu.

Étant donné que la longue fenêtre contextuelle de 1.5 Pro est une première pour les grands modèles, Google développe constamment de nouvelles évaluations et benchmarks pour tester ses nouvelles fonctionnalités.

Pour plus de détails, consultez le rapport technique Gemini 1.5 Pro.

Adresse du rapport technique : https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

Construire et expérimenter des modèles Gemini

Google s'engage à Proposer de manière responsable chaque nouvelle génération de modèles Gemini à des milliards de personnes, de développeurs et d'utilisateurs d'entreprise à travers le monde.

À partir d'aujourd'hui, Google met la version préliminaire 1.5 Pro à la disposition des développeurs et des entreprises clientes via AI Studio et Vertex AI.

À l'avenir, lorsque le modèle sera diffusé à plus grande échelle, Google lancera 1.5 Pro avec une fenêtre contextuelle standard de 128 000 jetons. Bientôt, Google prévoit d'introduire des niveaux de tarification en commençant par les 128 000 fenêtres contextuelles standard et en augmentant jusqu'à 1 million de jetons à mesure qu'il améliore le modèle.

Les premiers testeurs peuvent essayer gratuitement 1 million de fenêtres contextuelles de jetons pendant les tests, et des améliorations significatives de la vitesse sont à venir.

Les développeurs intéressés par tester la version 1.5 Pro peuvent s'inscrire dès maintenant dans AI Studio, tandis que les entreprises clientes peuvent contacter l'équipe de leur compte Vertex AI.

Lien de référence : https://blog.google/technology/ai/google-gemini-next-Generation-model-february-2024/#sundar-noteCe qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!