Les modèles d'apprentissage automatique sont de plus en plus sophistiqués et précis, mais leur opacité reste un défi de taille. Comprendre pourquoi un modèle fait une prédiction spécifique est essentiel pour instaurer la confiance et garantir qu'il se comporte comme prévu. Dans cet article, nous présenterons LIME et l'utiliserons pour expliquer divers modèles courants.

Une puissante bibliothèque Python LIME (Local Interpretable Model-agnostic Explanations) peut aider à expliquer le comportement des classificateurs (ou modèles) d'apprentissage automatique. L’objectif principal de LIME est de fournir des explications interprétables et lisibles par l’homme pour les prédictions individuelles, en particulier pour les modèles complexes d’apprentissage automatique. En fournissant une compréhension détaillée du fonctionnement de ces modèles, LIME encourage la confiance dans les systèmes d'apprentissage automatique

À mesure que les modèles d'apprentissage automatique deviennent plus complexes, comprendre leur fonctionnement interne peut devenir un défi précieux. LIME résout ce problème en créant des explications locales pour des instances spécifiques, permettant ainsi aux utilisateurs de comprendre plus facilement et de faire confiance aux modèles d'apprentissage automatique.

Principales caractéristiques de LIME :

LIME fonctionne en rapprochant des modèles ML complexes avec un modèle plus simple et interprétable localement construit autour d'une instance spécifique. Les principales étapes du workflow LIME peuvent être divisées en étapes suivantes :

Avant de commencer à utiliser LIME, vous devez l'installer. LIME peut être installé en utilisant la commande pip :

pip install lime

Pour utiliser LIME avec un modèle de classification, vous devez créer un objet interpréteur puis générer une explication pour une instance spécifique. Ce qui suit est un exemple simple utilisant la bibliothèque LIME et le modèle de classification :

# Classification- Lime import lime import lime.lime_tabular from sklearn import datasets from sklearn.ensemble import RandomForestClassifier # Load the dataset and train a classifier data = datasets.load_iris() classifier = RandomForestClassifier() classifier.fit(data.data, data.target) # Create a LIME explainer object explainer = lime.lime_tabular.LimeTabularExplainer(data.data, mode="classification", training_labels=data.target, feature_names=data.feature_names, class_names=data.target_names, discretize_cnotallow=True) # Select an instance to be explained (you can choose any index) instance = data.data[0] # Generate an explanation for the instance explanation = explainer.explain_instance(instance, classifier.predict_proba, num_features=5) # Display the explanation explanation.show_in_notebook()

Lorsque vous utilisez LIME pour expliquer le modèle de régression, cela revient à utiliser LIME pour expliquer le modèle de classification. . Un objet interpréteur doit être créé et une interprétation générée pour une instance spécifique. Voici un exemple utilisant la bibliothèque LIME et un modèle de régression :

#Regression - Lime import numpy as np from sklearn.model_selection import train_test_split from sklearn.linear_model import LinearRegression from lime.lime_tabular import LimeTabularExplainer # Generate a custom regression dataset np.random.seed(42) X = np.random.rand(100, 5) # 100 samples, 5 features y = 2 * X[:, 0] + 3 * X[:, 1] + 1 * X[:, 2] + np.random.randn(100) # Linear regression with noise # Split the data into training and testing sets X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42) # Train a simple linear regression model model = LinearRegression() model.fit(X_train, y_train) # Initialize a LimeTabularExplainer explainer = LimeTabularExplainer(training_data=X_train, mode="regression") # Select a sample instance for explanation sample_instance = X_test[0] # Explain the prediction for the sample instance explanation = explainer.explain_instance(sample_instance, model.predict) # Print the explanation explanation.show_in_notebook()

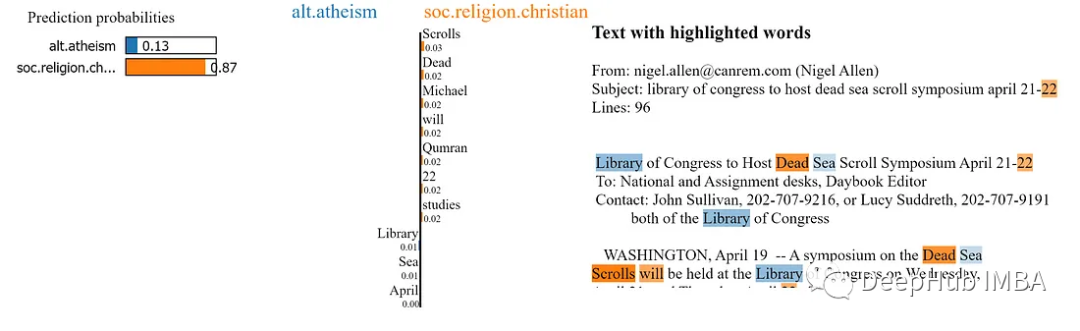

LIME peut également être utilisé pour expliquer les prédictions faites par des modèles de texte. Pour utiliser LIME avec un modèle de texte, vous devez créer un objet interpréteur de texte LIME, puis générer une interprétation pour une instance spécifique. Voici un exemple d'utilisation de la bibliothèque LIME et du modèle de texte :

# Text Model - Lime import lime import lime.lime_text from sklearn.feature_extraction.text import TfidfVectorizer from sklearn.naive_bayes import MultinomialNB from sklearn.datasets import fetch_20newsgroups # Load a sample dataset (20 Newsgroups) for text classification categories = ['alt.atheism', 'soc.religion.christian'] newsgroups_train = fetch_20newsgroups(subset='train', categories=categories) # Create a simple text classification model (Multinomial Naive Bayes) tfidf_vectorizer = TfidfVectorizer() X_train = tfidf_vectorizer.fit_transform(newsgroups_train.data) y_train = newsgroups_train.target classifier = MultinomialNB() classifier.fit(X_train, y_train) # Define a custom Lime explainer for text data explainer = lime.lime_text.LimeTextExplainer(class_names=newsgroups_train.target_names) # Choose a text instance to explain text_instance = newsgroups_train.data[0] # Create a predict function for the classifier predict_fn = lambda x: classifier.predict_proba(tfidf_vectorizer.transform(x)) # Explain the model's prediction for the chosen text instance explanation = explainer.explain_instance(text_instance, predict_fn) # Print the explanation explanation.show_in_notebook()

LIME peut être utilisé pour expliquer les résultats de prédiction du modèle d'image. Besoin de créer un objet interpréteur d'image LIME et de générer une explication pour une instance spécifique

import lime import lime.lime_image import sklearn # Load the dataset and train an image classifier data = sklearn.datasets.load_digits() classifier = sklearn.ensemble.RandomForestClassifier() classifier.fit(data.images.reshape((len(data.images), -1)), data.target) # Create a LIME image explainer object explainer = lime.lime_image.LimeImageExplainer() # Select an instance to be explained instance = data.images[0] # Generate an explanation for the instance explanation = explainer.explain_instance(instance, classifier.predict_proba, top_labels=5)

Après avoir utilisé LIME pour générer l'explication, vous pouvez visualiser l'explication pour comprendre la contribution de chacun caractéristique à la prédiction. Pour les données tabulaires, vous pouvez utiliser les méthodes show_in_notebook ou as_pyplot_figure pour afficher des explications. Pour les données texte et image, vous pouvez utiliser la méthode show_in_notebook pour afficher les notes.

En comprenant la contribution de chaque fonctionnalité, nous pouvons acquérir une compréhension plus approfondie du processus de prise de décision du modèle et identifier les biais potentiels ou les zones problématiques

LIME fournit des techniques avancées pour améliorer la qualité des explications, ces techniques inclure :

Ajustement du nombre d'échantillons perturbés : augmenter le nombre d'échantillons perturbés peut améliorer la stabilité et la précision de l'interprétation.

Choisissez un modèle interprétable : le choix d'un modèle interprétable approprié (par exemple, régression linéaire, arbre de décision) affecte la qualité de l'explication.

Sélection des fonctionnalités : la personnalisation du nombre de fonctionnalités utilisées dans l'explication peut aider à se concentrer sur les contributions les plus importantes aux prédictions.

Bien que LIME soit un outil puissant pour interpréter les modèles d'apprentissage automatique, il présente également certaines limites :

Interprétation locale : LIME se concentre sur l'interprétation locale, qui peut ne pas capturer le comportement global du modèle.

Coûteux : générer des explications à l'aide de LIME peut prendre beaucoup de temps, en particulier pour les grands ensembles de données et les modèles complexes

Si LIME ne répond pas à vos besoins, il existe d'autres moyens d'expliquer les modèles d'apprentissage automatique, tels que SHAP ( SHapley Additive ExPlanations) et ancre.

LIME est un outil précieux pour expliquer ce que fait un classificateur (ou modèle) d'apprentissage automatique. En fournissant un moyen pratique de comprendre des modèles d'apprentissage automatique complexes, LIME permet aux utilisateurs de faire confiance et d'améliorer leurs systèmes

En fournissant des explications interprétables pour les prédictions individuelles, LIME peut aider à renforcer la confiance dans les modèles d'apprentissage automatique. Ce type de confiance est crucial dans de nombreux secteurs, en particulier lorsqu'on utilise des modèles ML pour prendre des décisions importantes. En comprenant mieux le fonctionnement de leurs modèles, les utilisateurs peuvent s'appuyer en toute confiance sur les systèmes d'apprentissage automatique et prendre des décisions basées sur les données.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Introduction à la classification des systèmes Linux

Introduction à la classification des systèmes Linux Solutions aux exceptions logicielles inconnues dans les applications informatiques

Solutions aux exceptions logicielles inconnues dans les applications informatiques Comment restaurer des vidéos qui ont été officiellement supprimées de Douyin

Comment restaurer des vidéos qui ont été officiellement supprimées de Douyin Comment changer la disposition CAO du blanc au noir

Comment changer la disposition CAO du blanc au noir Quelles sont les performances de thinkphp ?

Quelles sont les performances de thinkphp ? Format de courrier électronique professionnel

Format de courrier électronique professionnel Comment télécharger le fichier FLV

Comment télécharger le fichier FLV Quels sont les types d'outils lasso dans PS ?

Quels sont les types d'outils lasso dans PS ?