Aujourd'hui, je vais vous parler de l'application des grands modèles dans la prévision de séries chronologiques. Avec le développement de grands modèles dans le domaine de la PNL, de plus en plus de travaux tentent d'appliquer de grands modèles au domaine de la prédiction de séries chronologiques. Cet article présente les principales méthodes d'application des grands modèles à la prévision des séries chronologiques et résume certains travaux récents connexes pour aider chacun à comprendre les méthodes de recherche sur la prévision des séries chronologiques à l'ère des grands modèles.

Au cours des trois derniers mois, de nombreux travaux de prévision de séries chronologiques sur de grands modèles ont vu le jour, qui peuvent essentiellement être divisés en deux types.

Contenu réécrit : une approche consiste à utiliser directement des modèles de PNL à grande échelle pour la prévision de séries chronologiques. Dans cette méthode, de grands modèles NLP tels que GPT et Llama sont utilisés pour la prédiction de séries chronologiques. La clé réside dans la façon de convertir les données de séries chronologiques en données adaptées à l'entrée de grands modèles. La seconde consiste à former de grands modèles dans le domaine des séries chronologiques. Dans ce type de méthode, un grand nombre d'ensembles de données de séries chronologiques sont utilisés pour former conjointement un grand modèle tel que GPT ou Llama dans le domaine des séries chronologiques, et utilisés pour les tâches de séries chronologiques en aval.

Pour les deux types de méthodes ci-dessus, voici quelques travaux classiques de représentation de séries chronologiques sur grands modèles.

2. Appliquer les grands modèles NLP aux séries chronologiques

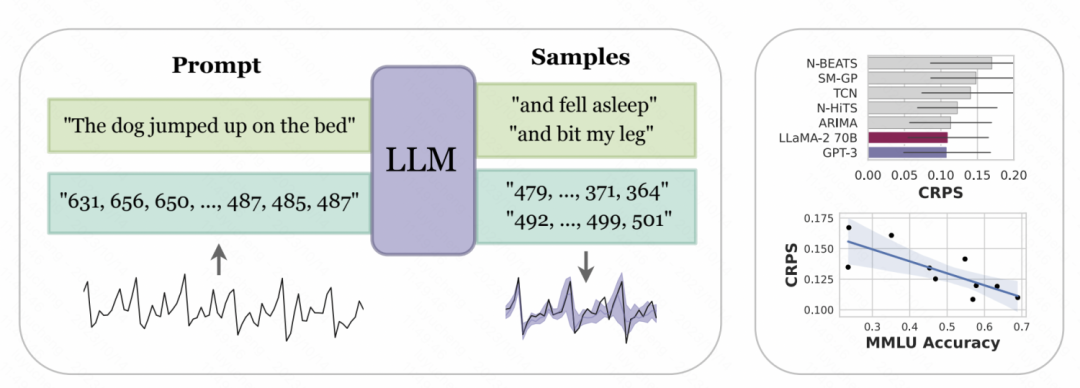

L'article "Large Language Models as Zero Samples" publié conjointement par l'Université de New York et l'Université Carnegie Mellon. Dans « Time Series Predictor », la représentation numérique de la série chronologique est conçue pour être tokenisée afin de la convertir en une entrée pouvant être reconnue par les grands modèles tels que GPT et LLaMa. Étant donné que différents modèles à grande échelle symbolisent les nombres différemment, une personnalisation est requise lors de l'utilisation de différents modèles. Par exemple, GPT divisera une chaîne de nombres en différentes sous-séquences, ce qui affectera l'apprentissage du modèle. Par conséquent, cet article impose un espace entre les nombres pour s'adapter au format d'entrée de GPT. Pour les grands modèles récemment sortis tels que LLaMa, les numéros individuels sont généralement divisés, il n'est donc pas nécessaire d'ajouter des espaces. Dans le même temps, afin d'éviter que la séquence d'entrée ne soit trop longue en raison de valeurs de séries chronologiques trop grandes, certaines opérations de mise à l'échelle sont effectuées dans l'article pour limiter les valeurs de la série chronologique d'origine à une plage plus raisonnable

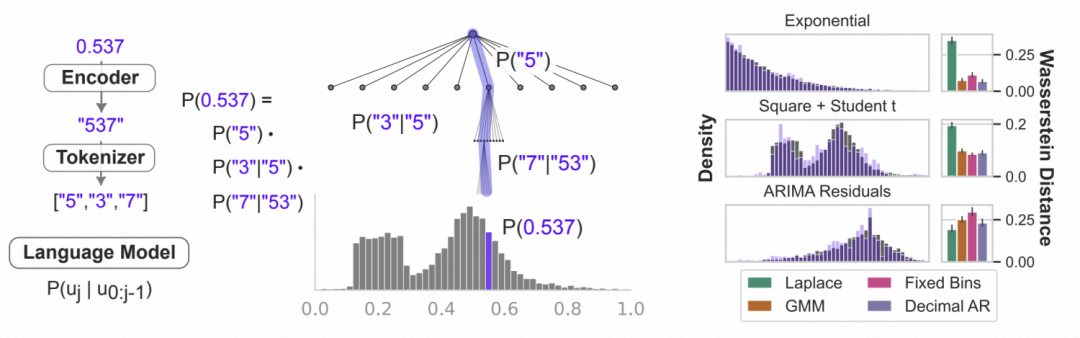

Images Caractères numériques après le traitement ci-dessus La chaîne est entrée dans le grand modèle, et le grand modèle prédit de manière autorégressive le nombre suivant, et convertit finalement le nombre prédit en valeur de série chronologique correspondante. La figure ci-dessous donne un diagramme schématique. Utiliser la probabilité conditionnelle du modèle de langage pour modéliser des nombres consiste à prédire la probabilité que le chiffre suivant soit chaque nombre en fonction des nombres précédents. Il s'agit d'une structure softmax hiérarchique itérative, couplée à la représentation. La capacité du grand modèle peut s'adapter à une variété de types de distribution, c'est pourquoi les grands modèles peuvent être utilisés de cette manière pour la prévision de séries chronologiques. Dans le même temps, la probabilité du prochain nombre prédit par le modèle peut également être convertie en une prédiction d'incertitude pour obtenir une estimation de l'incertitude des séries chronologiques.

Caractères numériques après le traitement ci-dessus La chaîne est entrée dans le grand modèle, et le grand modèle prédit de manière autorégressive le nombre suivant, et convertit finalement le nombre prédit en valeur de série chronologique correspondante. La figure ci-dessous donne un diagramme schématique. Utiliser la probabilité conditionnelle du modèle de langage pour modéliser des nombres consiste à prédire la probabilité que le chiffre suivant soit chaque nombre en fonction des nombres précédents. Il s'agit d'une structure softmax hiérarchique itérative, couplée à la représentation. La capacité du grand modèle peut s'adapter à une variété de types de distribution, c'est pourquoi les grands modèles peuvent être utilisés de cette manière pour la prévision de séries chronologiques. Dans le même temps, la probabilité du prochain nombre prédit par le modèle peut également être convertie en une prédiction d'incertitude pour obtenir une estimation de l'incertitude des séries chronologiques.

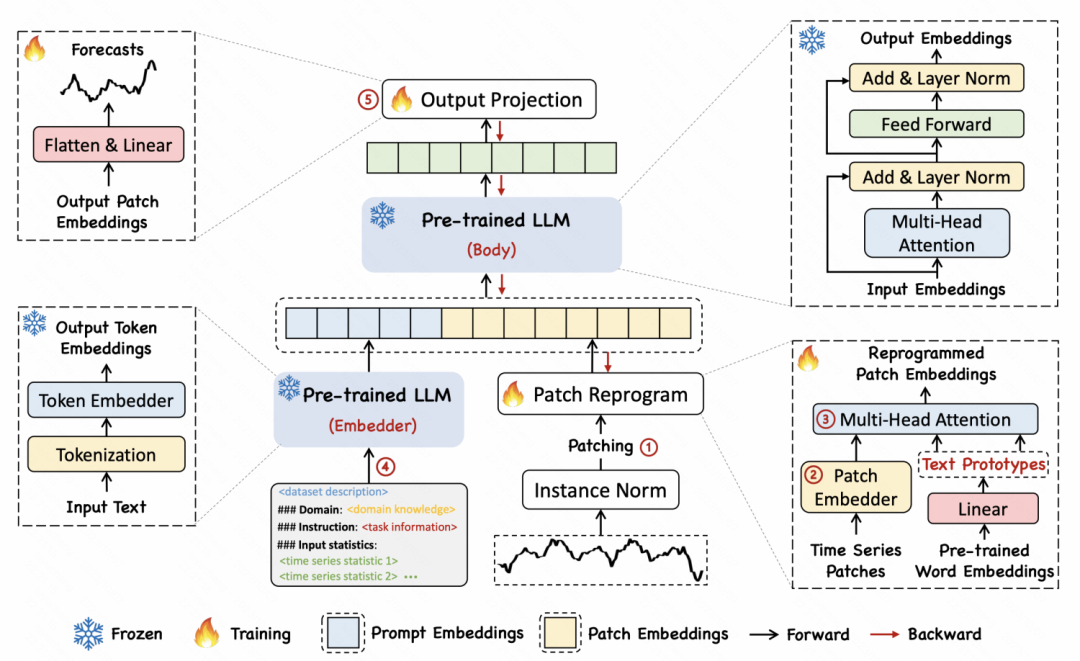

Photos Dans un autre article intitulé "TIME-LLM: TIME SERIES FORECASTING BY REPROGRAMMING LARGE LANGUAGE MODELS", l'auteur a proposé une méthode de reprogrammation pour convertir les séries temporelles en texte afin d'obtenir un alignement entre les deux formes de séries temporelles. et texte

Dans un autre article intitulé "TIME-LLM: TIME SERIES FORECASTING BY REPROGRAMMING LARGE LANGUAGE MODELS", l'auteur a proposé une méthode de reprogrammation pour convertir les séries temporelles en texte afin d'obtenir un alignement entre les deux formes de séries temporelles. et texte

La méthode de mise en œuvre spécifique consiste à d'abord diviser la série chronologique en plusieurs correctifs, et chaque correctif obtient une intégration via MLP. Ensuite, l'intégration du correctif est mappée sur le vecteur de mots dans le modèle de langage pour obtenir un mappage et un alignement intermodal des segments de séries chronologiques et du texte. L'article propose une idée de prototype de texte, qui mappe plusieurs mots sur un prototype pour représenter la sémantique d'une séquence de correctifs sur une période de temps. Par exemple, dans l'exemple ci-dessous, les mots shot et up sont mappés sur des triangles rouges, qui correspondent à des parcelles de sous-séquences ascendantes à court terme dans la série chronologique.

Images 3. Grand modèle de séries chronologiques

3. Grand modèle de séries chronologiques

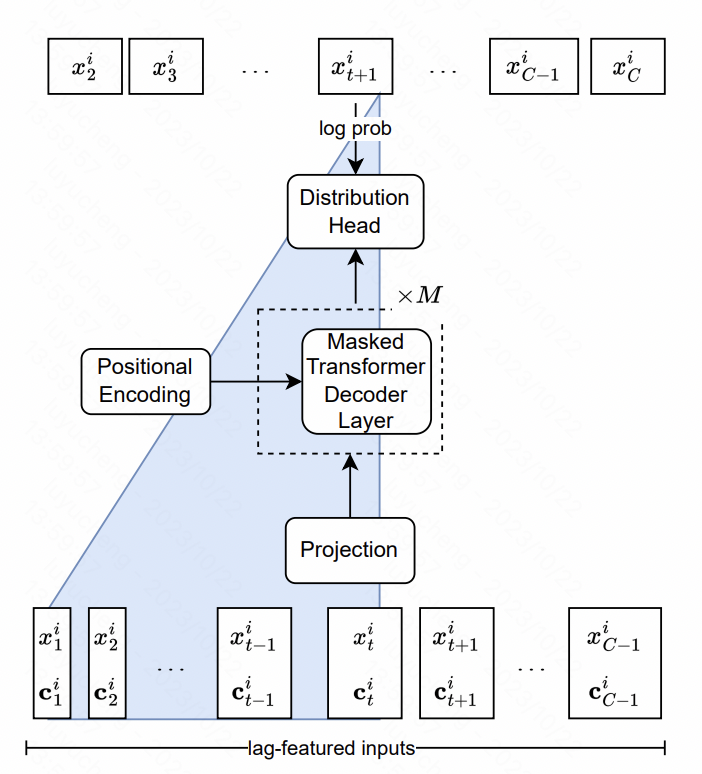

Lag-Llama : Vers des modèles de base pour la prévision des séries chronologiques Cet article construit le modèle Llama en séries chronologiques. Le noyau comprend la conception au niveau des fonctionnalités et au niveau de la structure du modèle.

En termes de fonctionnalités, l'article extrait des fonctionnalités de décalage multi-échelles et multi-types, qui sont principalement des valeurs statistiques de séquence historique dans différentes fenêtres temporelles de la série chronologique d'origine. Ces séquences sont entrées dans le modèle en tant que fonctionnalités supplémentaires. En termes de structure de modèle, le cœur de la structure LlaMA en PNL est Transformer, dans lequel la méthode de normalisation et la partie de codage de position ont été optimisées. La couche de sortie finale utilise plusieurs têtes pour ajuster les paramètres de la distribution de probabilité. Par exemple, la distribution gaussienne correspond à la variance moyenne. La distribution Student-t est utilisée dans cet article, ainsi que les trois paramètres correspondants : liberté, moyenne et échelle. sont sortis, et finalement à chaque fois est obtenu le résultat de la distribution de probabilité prédite du point.

Pictures

Pictures

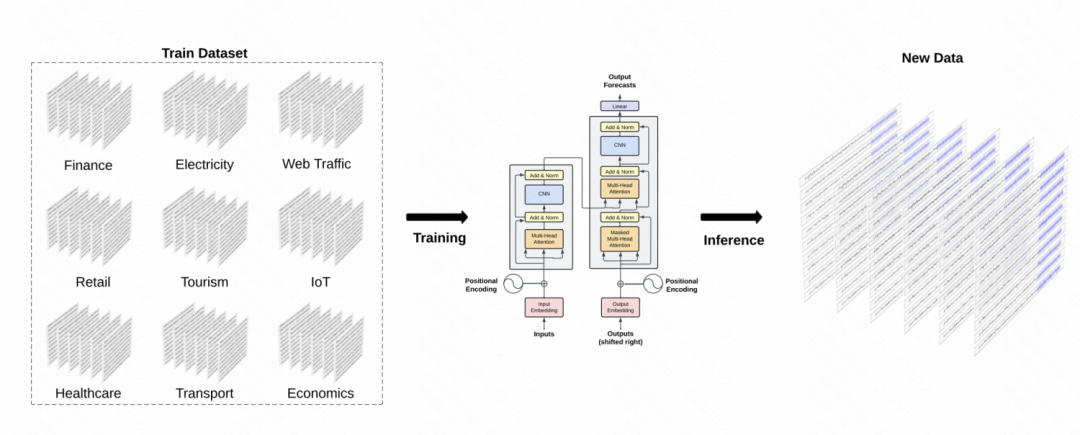

Un autre travail similaire est TimeGPT-1, qui construit un modèle GPT dans le domaine des séries chronologiques. En termes de formation des données, TimeGPT utilise une grande quantité de données de séries chronologiques, atteignant un total de 10 milliards de points d'échantillonnage de données, impliquant divers types de données de domaine. Pendant la formation, des lots plus grands et des taux d'apprentissage plus faibles sont utilisés pour améliorer la robustesse de la formation. La structure principale du modèle est le modèle GPT classique

image

image

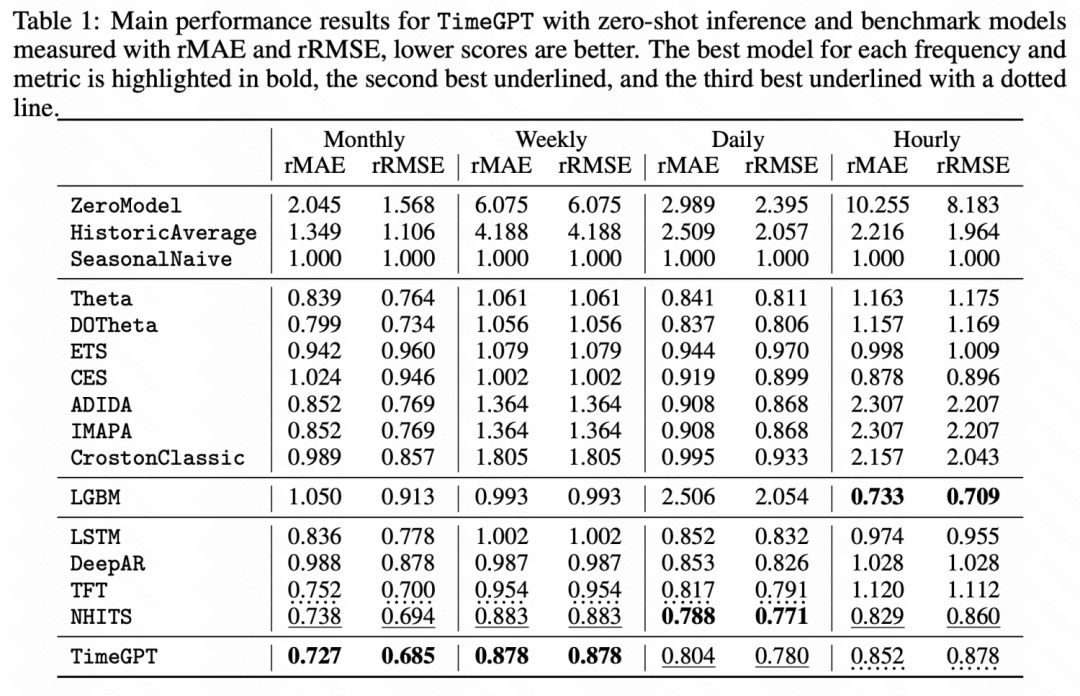

Les résultats expérimentaux ci-dessous montrent également que dans certaines tâches d'apprentissage à échantillon nul, ce grand modèle pré-entraîné en série chronologique a obtenu de meilleurs résultats que le modèle de base Amélioration significative des performances.

Photos

Photos

Cet article présente les idées de recherche sur la prévision de séries chronologiques sous la vague de grands modèles. Le processus global comprend l'utilisation directe de grands modèles PNL pour la prévision de séries chronologiques et la formation de grands modèles dans le temps. champ de série. Quelle que soit la méthode utilisée, elle nous montre le potentiel des grands modèles + séries chronologiques, et c'est une direction qui mérite une étude approfondie.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!