Dans la prévision de séries chronologiques, Transformer a démontré sa puissante capacité à décrire les dépendances et à extraire des représentations à plusieurs niveaux. Cependant, certains chercheurs ont remis en question l’efficacité des prédicteurs basés sur Transformer. De tels prédicteurs intègrent généralement plusieurs variables du même horodatage dans des canaux indiscernables et se concentrent sur ces horodatages pour capturer les dépendances temporelles. Les chercheurs ont découvert que les couches linéaires simples qui prennent en compte les relations numériques plutôt que les relations sémantiques surpassaient les transformateurs complexes en termes de performances et d'efficacité. Dans le même temps, l’importance de garantir l’indépendance des variables et d’exploiter les informations mutuelles fait l’objet d’une attention croissante dans les recherches récentes. Ces études modélisent explicitement des corrélations multivariées pour obtenir des prédictions précises. Cependant, il est encore difficile d'atteindre cet objectif sans renverser l'architecture commune de Transformer

Compte tenu de la controverse provoquée par les prédicteurs basés sur Transformer, les chercheurs réfléchissent à la raison pour laquelle Transformer est utilisé dans la prédiction de séries chronologiques. Les performances ne sont même pas aussi bonnes. comme modèles linéaires dans de nombreux autres domaines, mais il domine dans de nombreux autres domaines

Récemment, un nouvel article de l'Université Tsinghua propose une perspective différente - les performances de Transformer ne sont pas inhérentes, mais dues à la mauvaise application du schéma. aux données de séries chronologiques.

Le lien vers l'article est : https://arxiv.org/pdf/2310.06625.pdf

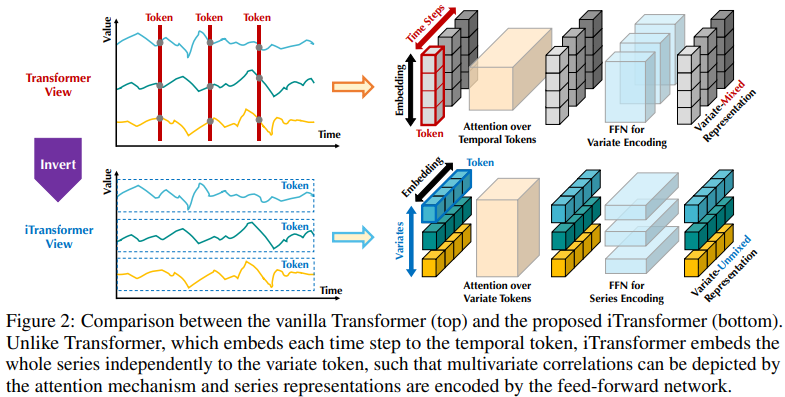

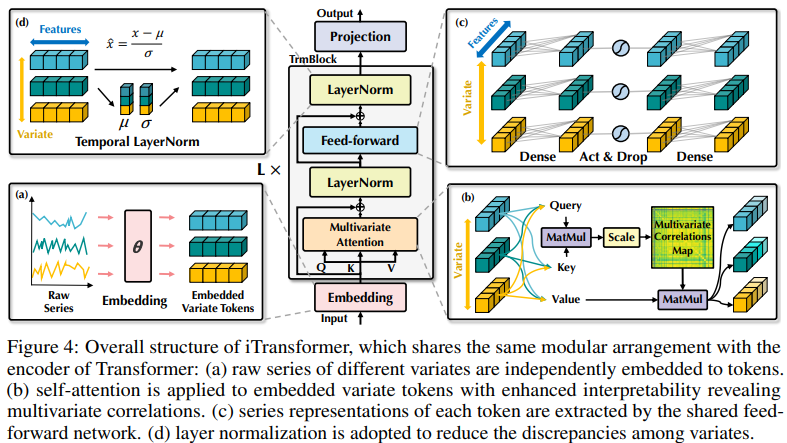

La structure existante des prédicteurs basés sur Transformer peut ne pas être adaptée à la prévision de séries chronologiques multivariées. Le côté gauche de la figure 2 montre que les points au même pas de temps représentent des significations physiques différentes, mais les résultats de mesure sont incohérents. Ces points sont intégrés dans un jeton et les corrélations multivariées sont ignorées. De plus, dans le monde réel, les pas de temps individuels sont rarement étiquetés avec des informations utiles en raison du désalignement des champs récepteurs locaux et des horodatages à des moments multivariés. De plus, bien que la variation de séquence soit significativement affectée par l’ordre des séquences, le mécanisme d’attention variable dans la dimension temporelle n’a pas été entièrement adopté. Par conséquent, la capacité du Transformer à capturer des représentations de séquences de base et à décrire des corrélations multivariées est affaiblie, limitant sa capacité et sa capacité de généralisation sur différentes données de séries chronologiques

Concernant la conversion de plusieurs variables à chaque pas de temps Pour souligner l'irrationalité de l'intégration un jeton (temporel), les chercheurs partent de la perspective inverse des séries chronologiques et intègrent indépendamment la série chronologique entière de chaque variable dans un jeton (variable). Il s'agit d'un cas extrême de patch pour étendre le champ de réception local. Grâce à l'inversion, le jeton intégré agrège la représentation globale de la séquence, qui peut être plus centrée sur les variables et mieux utiliser le mécanisme d'attention pour l'association multi-variable. Dans le même temps, les réseaux feedforward peuvent habilement apprendre des représentations généralisées de différentes variables codées par n’importe quelle séquence d’analyse et les décoder pour prédire les séquences futures.

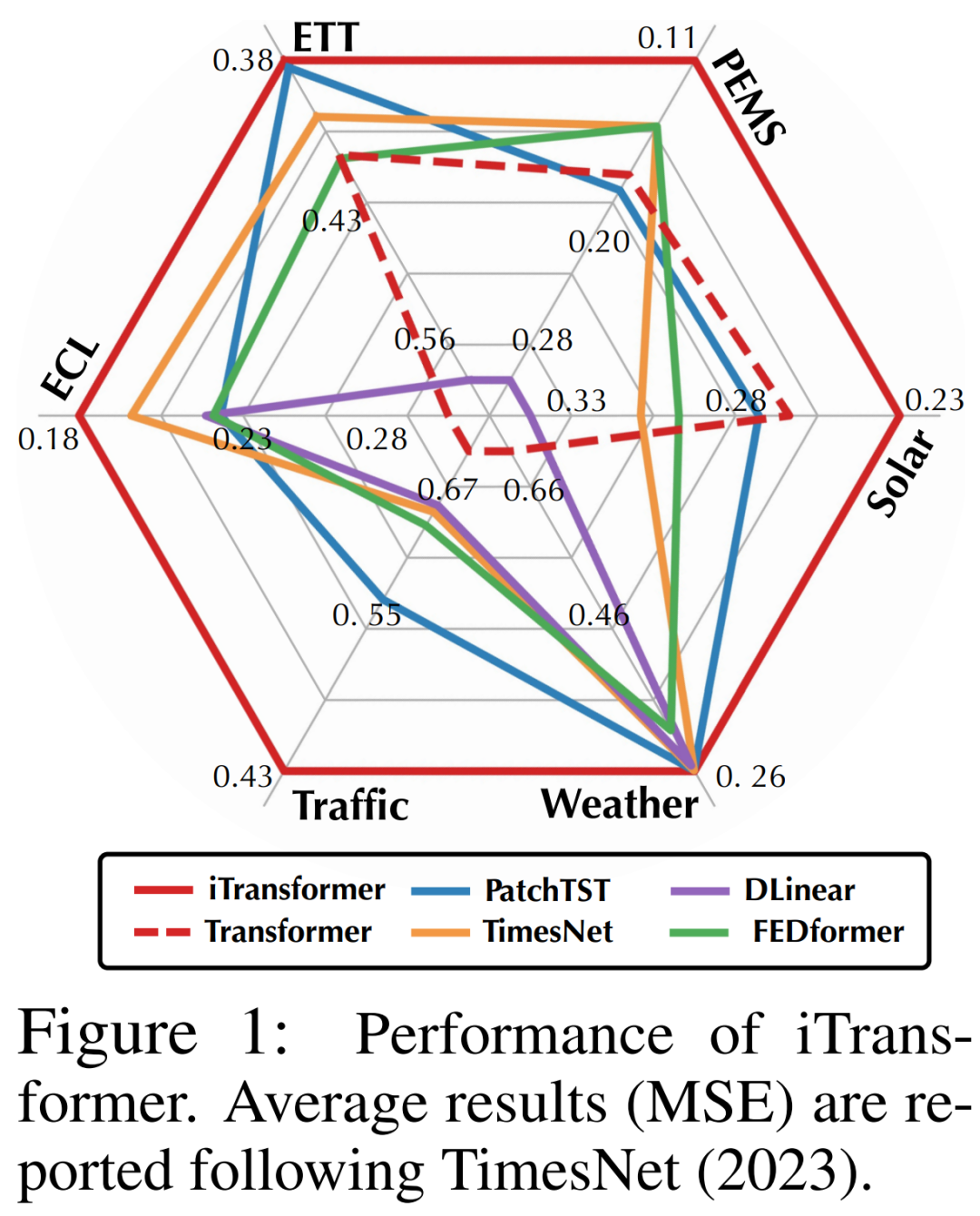

Les chercheurs ont souligné que pour la prédiction de séries chronologiques, Transformer n'est pas invalide, mais son utilisation est inappropriée. Dans cet article, les chercheurs ont réexaminé la structure de Transformer et ont recommandé iTransformer comme pilier de base de la prédiction des séries chronologiques. Ils intègrent chaque série temporelle sous forme de jeton variable, adoptent un mécanisme d'attention de corrélation multivariable et utilisent un réseau de rétroaction pour coder la séquence. Les résultats expérimentaux montrent que l'iTransformer proposé atteint le niveau de pointe dans le benchmark de prédiction réel (Figure 1) et résout de manière inattendue les problèmes rencontrés par les prédicteurs basés sur Transformer

En résumé, cet article Les contributions sont les suivantes :

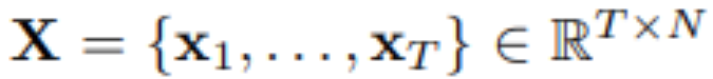

Dans la prévision de séries chronologiques multivariées, compte tenu des observations historiques :

En utilisant T pas de temps et N variables, le chercheur prédit S pas de temps dans le futur :  . Pour plus de commodité, notons que

. Pour plus de commodité, notons que  représente les variables multivariées enregistrées simultanément au pas de temps t, et

représente les variables multivariées enregistrées simultanément au pas de temps t, et  représente la série chronologique entière avec chaque variable indexée par n. Il convient de noter que dans le monde réel, en raison de la latence du système des moniteurs et des ensembles de données mal organisés,

représente la série chronologique entière avec chaque variable indexée par n. Il convient de noter que dans le monde réel, en raison de la latence du système des moniteurs et des ensembles de données mal organisés,  peut ne pas contenir de points temporels avec essentiellement le même horodatage. Les éléments de

peut ne pas contenir de points temporels avec essentiellement le même horodatage. Les éléments de

peuvent différer les uns des autres dans les mesures physiques et les distributions statistiques, et les variables

peuvent différer les uns des autres dans les mesures physiques et les distributions statistiques, et les variables  partagent souvent ces données.

partagent souvent ces données.

La variante Transformer équipée de l'architecture proposée dans cet article, appelée iTransformer, ne propose fondamentalement pas d'exigences plus spécifiques pour la variante Transformer, sauf que le mécanisme d'attention doit être adapté à la modélisation de corrélation multivariée. Par conséquent, un ensemble efficace de mécanismes d’attention peut servir de plug-in pour réduire la complexité des associations lorsque le nombre de variables augmente.

iTransformer est présenté dans la quatrième image, utilisant une architecture d'encodeur Transformer plus simple, qui comprend l'intégration, la projection et les blocs Transformer

Les chercheurs ont utilisé iTransformer dans diverses évaluations complètes a été menée dans diverses applications de prévision de séries chronologiques, confirmant la polyvalence du cadre et étudiant plus en détail l'effet de l'inversion des responsabilités du composant Transformer pour des dimensions spécifiques de séries chronologiques

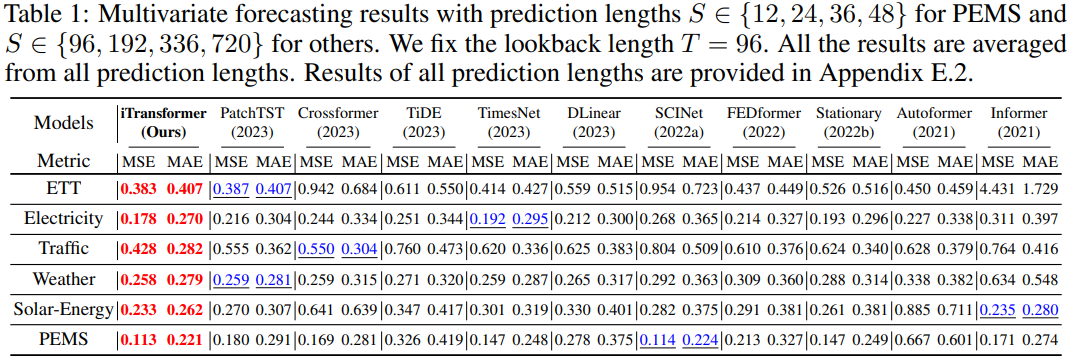

Les chercheurs ont largement inclus 6 données réelles dans l'expérience Ensembles de données mondiaux, y compris ETT, météo, électricité, ensembles de données de trafic, ensembles de données sur l'énergie solaire et ensembles de données PEMS. Pour des informations détaillées sur l'ensemble de données, veuillez vous référer au texte original

Le contenu réécrit est le suivant : Les résultats de la prédiction

sont présentés dans le tableau 1, le rouge indiquant l'optimal et le souligné indiquant l'optimal. Plus le MSE/MAE est bas, plus le contenu réécrit est : plus les résultats de prédiction sont précis. L'iTransformer proposé dans cet article atteint les performances SOTA. Le composant natif Transformer est capable de modélisation temporelle et de corrélation multivariée, et l'architecture inversée proposée peut résoudre efficacement des scénarios de prédiction de séries chronologiques du monde réel.

Ce qui doit être réécrit est : L'universalité d'iTransformer

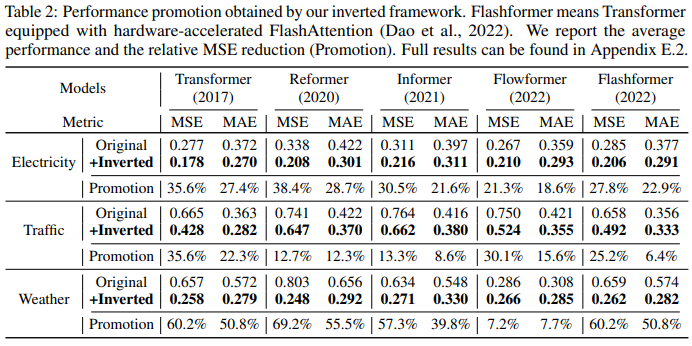

Les chercheurs qui ont appliqué ce cadre à Transformer et à ses variantes pour évaluer les iTransformers ont découvert que ces variantes résolvaient souvent le problème de complexité secondaire du soi -mécanisme d'attention, notamment Reformer, Informer, Flowformer et FlashAttention. Les chercheurs ont également découvert que le simple fait d'inverser la perspective peut améliorer les performances des prédicteurs basés sur Transformer, améliorer l'efficacité, généraliser à des variables invisibles et mieux utiliser les données d'observation historiques.

Le tableau 2 montre les transformateurs et les iTransformers correspondants évalués. Il convient de noter que le framework continue d’améliorer divers Transformers. Dans l'ensemble, les Transformers se sont améliorés en moyenne de 38,9 %, les Reformers de 36,1 % en moyenne, les Informers de 28,5 % en moyenne, les Flowformers de 16,8 % en moyenne et les Flashformers de 32,2 % en moyenne.

Un autre facteur est qu'iTransformer peut être largement utilisé dans les prédicteurs basés sur Transformer, car il adopte la structure inversée du mécanisme d'attention dans la dimension variable, introduit une attention efficace avec une complexité linéaire et résout fondamentalement les problèmes d'efficacité dus à 6 variables. Ce problème est courant dans les applications du monde réel, mais peut être consommateur de ressources pour Channel Independent

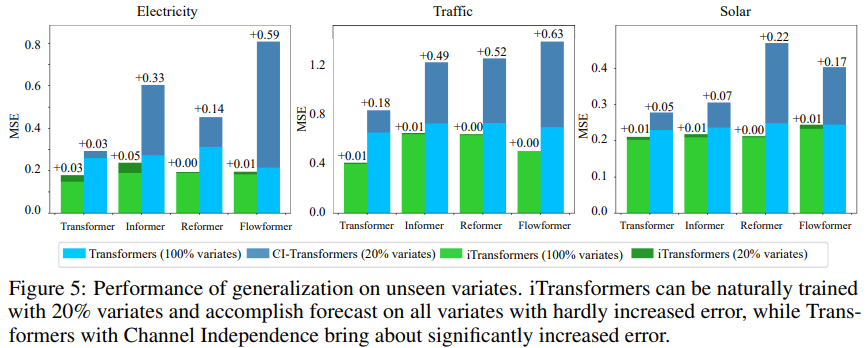

Pour tester l'hypothèse, les chercheurs ont comparé iTransformer avec une autre stratégie de généralisation : modèle pour toutes les variantes. Comme le montre la figure 5, l'erreur de généralisation de Channel Independent (CI-Transformers) peut augmenter de manière significative, tandis que l'augmentation de l'erreur de prédiction d'iTransformer est beaucoup plus faible.

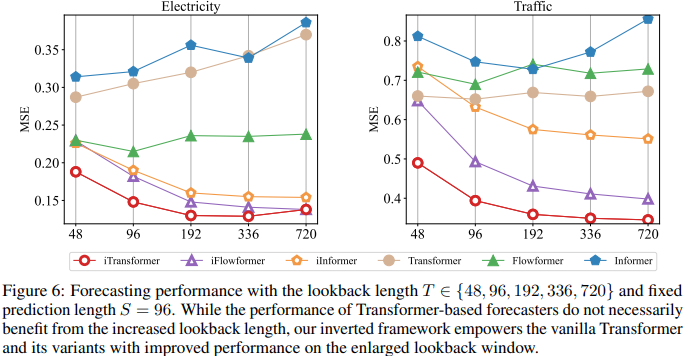

Étant donné que les responsabilités des réseaux d'attention et de rétroaction sont inversées, les performances de Transformers et d'iTransformer à mesure que la longueur de recherche augmente sont évaluées dans la figure 6. Il valide la justification de l'exploitation du MLP dans la dimension temporelle, c'est-à-dire que les transformateurs peuvent bénéficier de fenêtres d'analyse étendues, ce qui permet d'obtenir des prédictions plus précises.

Analyse du modèle

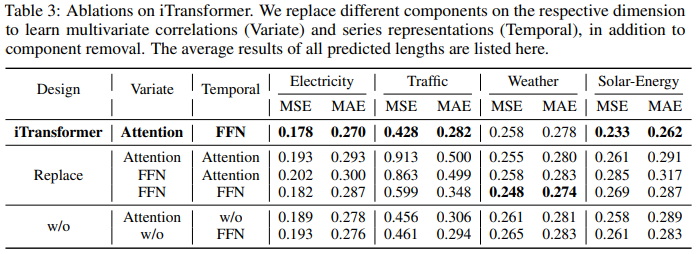

Afin de vérifier la rationalité du composant du transformateur, les chercheurs ont mené des expériences d'ablation détaillées, y compris des expériences de remplacement de composants (Remplacer) et de retrait de composants (sans). Le tableau 3 répertorie les résultats expérimentaux.

Pour plus de détails, veuillez vous référer à l'article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment gérer les caractères chinois tronqués sous Linux

Comment gérer les caractères chinois tronqués sous Linux

Ordre recommandé pour apprendre le langage C++ et C

Ordre recommandé pour apprendre le langage C++ et C

Comment résoudre les caractères tronqués en PHP

Comment résoudre les caractères tronqués en PHP

Méthode de réparation des doutes sur la base de données

Méthode de réparation des doutes sur la base de données

Solution de délai d'expiration des requêtes du serveur

Solution de délai d'expiration des requêtes du serveur

Solution d'erreur inattendue IIS 0x8ffe2740

Solution d'erreur inattendue IIS 0x8ffe2740

navigateur.useragent

navigateur.useragent

Comment obtenir un jeton

Comment obtenir un jeton