Titre original : Étude expérimentale multi-ensembles de données sur la fusion radar-caméra en vue à vol d'oiseau

Lien papier : https://arxiv.org/pdf/2309.15465.pdf

Affiliation de l'auteur : Opel Automobile GmbH Rheinland-Pfalzische Technische Universitat Kaiserslautern- Centre de recherche allemand Landau pour l'intelligence artificielle

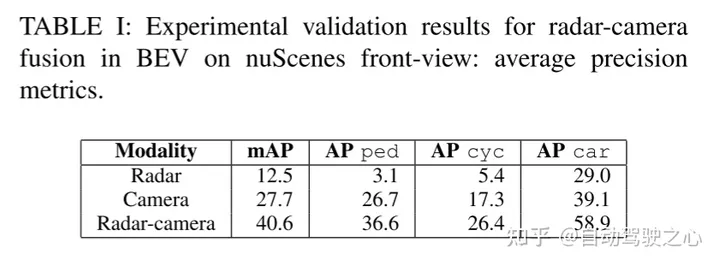

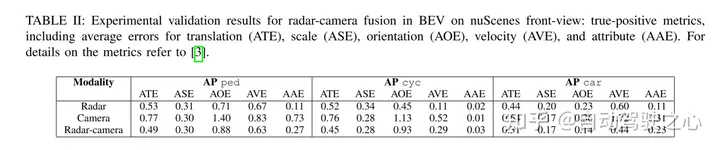

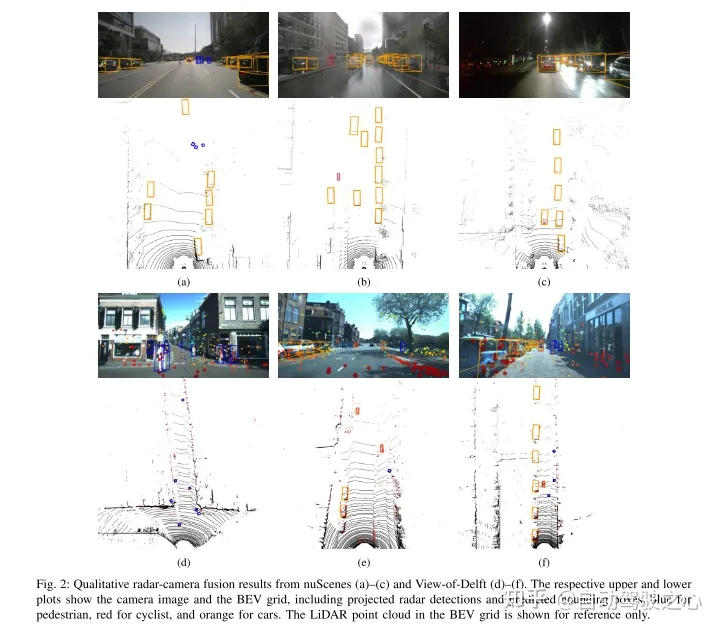

En exploitant les informations complémentaires des capteurs, les systèmes de fusion de radars à ondes millimétriques et de caméras ont le potentiel de fournir des capacités de conduite très robustes et autonomes pour les systèmes avancés d'aide à la conduite et Fonctions de conduite autonome. Système de détection fiable. Les progrès récents dans la détection d'objets par caméra offrent de nouvelles possibilités de fusion de radars à ondes millimétriques et de caméras, qui peuvent exploiter des cartes de caractéristiques à vol d'oiseau pour la fusion. Cette étude propose un réseau de fusion nouveau et flexible et évalue ses performances sur deux ensembles de données (nuScenes et View-of-Delft). Les résultats expérimentaux montrent que bien que la branche caméra nécessite des données de formation volumineuses et diversifiées, la branche radar à ondes millimétriques bénéficie davantage du radar à ondes millimétriques hautes performances. Grâce à l'apprentissage par transfert, cette étude améliore les performances de la caméra sur des ensembles de données plus petits. Les résultats de la recherche montrent en outre que la méthode de fusion du radar à ondes millimétriques et de la caméra est nettement meilleure que la méthode de base utilisant uniquement une caméra ou un radar à ondes millimétriques.

Récemment, une tendance dans la détection de cibles 3D consiste à intégrer les caractéristiques des images Convertir en une représentation commune Bird's Eye View (BEV). Cette représentation fournit une architecture de fusion flexible qui peut être fusionnée entre plusieurs caméras ou à l'aide de capteurs télémétriques. Dans ce travail, nous étendons la méthode BEVFusion initialement utilisée pour la fusion de caméras laser à la fusion de caméras radar à ondes millimétriques. Nous avons formé et évalué notre méthode de fusion proposée à l'aide d'un ensemble de données radar à ondes millimétriques sélectionné. Dans plusieurs expériences, nous discutons des avantages et des inconvénients de chaque ensemble de données. Enfin, nous appliquons l'apprentissage par transfert pour obtenir de nouvelles améliorations.

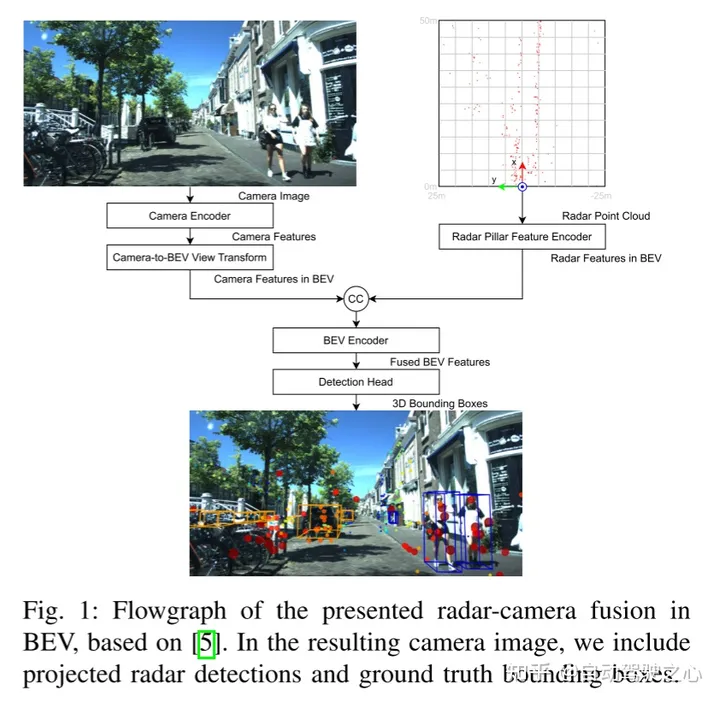

Voici ce qui doit être réécrit : La figure 1 montre l'organigramme de fusion radar-caméra à ondes millimétriques BEV basé sur BEVFusion. Dans l'image de caméra générée, nous incluons les résultats de détection du radar à ondes millimétriques projetées et de la véritable boîte englobante

Cet article suit l'architecture de fusion de BEVFusion. La figure 1 montre l'aperçu du réseau de fusion radar-caméra à ondes millimétriques dans BEV dans cet article. Notez que la fusion se produit lorsque les signatures de la caméra et du radar à ondes millimétriques sont connectées au BEV. Ci-dessous, cet article fournit plus de détails pour chaque bloc.

Le contenu qui doit être réécrit est : A. Encodeur de caméra et transformation de caméra en vue BEV

L'encodeur de caméra et la transformation de vue adoptent l'idée de [15], qui est un cadre flexible qui peut extraire une caméra externe arbitraire et les fonctionnalités Image BEV des paramètres internes. Tout d’abord, les caractéristiques sont extraites de chaque image à l’aide d’un réseau Tiny-Swin Transformer. Ensuite, cet article utilise les étapes Lift et Splat de [14] pour convertir les caractéristiques de l'image dans le plan BEV. À cette fin, la prédiction de profondeur dense est suivie d'un bloc basé sur des règles dans lequel les entités sont converties en pseudo-nuages de points, rastérisées et accumulées dans une grille BEV.

Encodeur de caractéristiques de colonne radar

Le but de ce bloc est d'encoder le nuage de points radar à ondes millimétriques en caractéristiques BEV sur la même grille que les caractéristiques d'image BEV. À cette fin, cet article utilise la technologie de codage de caractéristiques de pilier de [16] pour pixelliser le nuage de points en voxels infiniment élevés, ce qu'on appelle le pilier.

Le contenu qui doit être réécrit est : C. Encodeur BEV

Semblable à [5], les fonctionnalités BEV des radars et des caméras à ondes millimétriques sont obtenues grâce à la fusion en cascade. Les caractéristiques fusionnées sont traitées par un codeur convolutionnel BEV commun afin que le réseau puisse prendre en compte le désalignement spatial et exploiter la synergie entre les différentes modalités

Tête de détection D

Cet article utilise la tête de détection CenterPoint pour prédire le centre de l'objet de chaque classe de chaleur. carte. D'autres têtes de régression prédisent la taille, la rotation et la hauteur des objets, ainsi que les propriétés de vitesse et de classe des nuScenes. La carte thermique est entraînée à l'aide de la perte de focalisation gaussienne et le reste des têtes de détection sont entraînés à l'aide de la perte L1

Stäcker, L., Heidenreich, P., Rambach, J. et Stricker, D. (2023). "Une étude expérimentale multi-ensembles de données de la fusion radar-caméra vue à vol d'oiseau" .ArXiv./abs/2309.15465

Le contenu qui doit être réécrit est : Lien original ;

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment lier des données dans une liste déroulante

Comment lier des données dans une liste déroulante

La fonction du relais intermédiaire

La fonction du relais intermédiaire

Comment trouver la médiane d'un tableau en php

Comment trouver la médiane d'un tableau en php

Comment acheter et vendre du Bitcoin en Chine

Comment acheter et vendre du Bitcoin en Chine

Qu'est-ce que le métaverse

Qu'est-ce que le métaverse

Ordre de priorité des opérateurs en langage C

Ordre de priorité des opérateurs en langage C

Plateforme nationale d'achat et de vente de Bitcoin

Plateforme nationale d'achat et de vente de Bitcoin

Quel est le format du document ?

Quel est le format du document ?