Cet article est reproduit à partir de Lei Feng.com Si vous avez besoin de réimprimer, veuillez vous rendre sur le site officiel de Lei Feng.com pour demander une autorisation.

Cerebras, une société célèbre pour avoir créé le plus grand moteur à puce accélératrice CS-2 Wafer Scale Engine au monde, a annoncé hier avoir franchi une étape importante dans l'utilisation de « cœurs géants » pour la formation à l'intelligence artificielle. La société a formé le plus grand modèle d’IA PNL (traitement du langage naturel) au monde sur une seule puce.

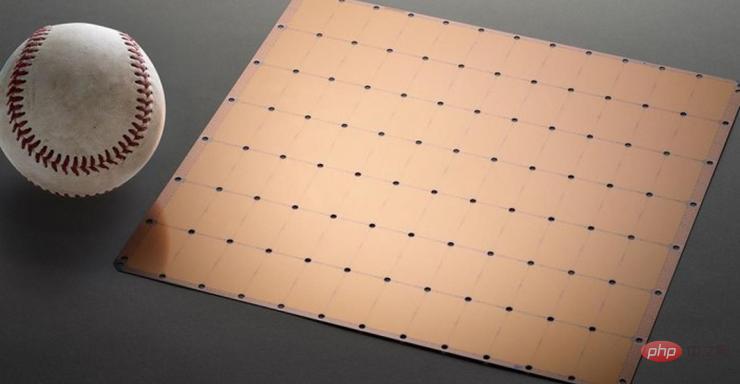

Le modèle possède 2 milliards de paramètres et est entraîné sur la puce CS-2. La plus grande puce accélératrice au monde utilise un processus de 7 nm et est gravée à partir d'une plaquette carrée. Il est des centaines de fois plus gros que les puces traditionnelles et a une puissance de 15 kW. Il intègre 2,6 billions de transistors 7 nm, contient 850 000 cœurs et 40 Go de mémoire.

Figure 1 Puce CS-2 Wafer Scale Engine

Le développement de modèles NLP est un domaine important de l'intelligence artificielle. Grâce aux modèles NLP, l’intelligence artificielle peut « comprendre » le sens du texte et prendre les mesures correspondantes. Le modèle DALL.E d'OpenAI est un modèle PNL typique. Ce modèle peut convertir les informations textuelles saisies par les utilisateurs en sortie d'image.

Par exemple, lorsque l'utilisateur saisit « fauteuil en forme d'avocat », l'IA générera automatiquement plusieurs images correspondant à cette phrase.

Image : L'image du "fauteuil en forme d'avocat" générée par l'IA après avoir reçu des informations

De plus, ce modèle peut également permettre à l'IA de comprendre des connaissances complexes telles que les espèces, la géométrie, les époques historiques, etc.

Mais il n'est pas facile de réaliser tout cela. Le développement traditionnel de modèles NLP présente des coûts de puissance de calcul et des seuils techniques extrêmement élevés.

En fait, si l'on ne parle que de chiffres, les 2 milliards de paramètres du modèle développé par Cerebras semblent un peu médiocres par rapport à ses pairs.

Le modèle DALL.E mentionné précédemment comporte 12 milliards de paramètres, et le plus grand modèle actuellement est Gopher, lancé par DeepMind à la fin de l'année dernière, avec 280 milliards de paramètres.

Mais au-delà des chiffres ahurissants, la PNL développée par Cerebras présente une énorme avancée : elle réduit la difficulté de développer des modèles de PNL.

Selon le processus traditionnel, le développement de modèles NLP nécessite que les développeurs divisent d'énormes modèles NLP en plusieurs parties fonctionnelles et répartissent leur charge de travail sur des centaines ou des milliers d'unités de traitement graphique.

Des milliers d'unités de traitement graphique représentent des coûts énormes pour les fabricants.

Les difficultés techniques rendent également les constructeurs malheureux.

Le découpage des modèles est un problème personnalisé, les spécifications de chaque réseau neuronal, de chaque GPU et du réseau qui les connecte (ou les interconnecte) ensemble sont uniques et ne sont pas portables entre les systèmes.

Les fabricants doivent clairement prendre en compte tous ces facteurs avant la première formation.

Ce travail est extrêmement complexe et prend parfois plusieurs mois.

Cerebras a déclaré qu'il s'agissait de « l'un des aspects les plus douloureux » de la formation des modèles PNL. Seule une poignée d’entreprises disposent des ressources et de l’expertise nécessaires pour développer la PNL. Pour les autres entreprises du secteur de l'IA, la formation PNL est trop coûteuse, prend beaucoup de temps et n'est pas disponible.

Mais si une seule puce peut prendre en charge un modèle avec 2 milliards de paramètres, cela signifie qu'il n'est pas nécessaire d'utiliser des GPU massifs pour répartir la charge de travail de formation du modèle. Cela peut permettre aux fabricants d'économiser des milliers de coûts de formation GPU et d'exigences matérielles et de mise à l'échelle associées. Cela évite également aux fournisseurs d’avoir à découper les modèles et à répartir leurs charges de travail sur des milliers de GPU.

Cerebras n'est pas seulement obsédé par les chiffres. Pour évaluer la qualité d'un modèle, le nombre de paramètres n'est pas le seul critère.

Plutôt que d'espérer "l'effort" du modèle né sur le "noyau géant", Cerebras espère que le modèle sera "intelligent".

La raison pour laquelle Cerebras peut atteindre une croissance explosive du nombre de paramètres est qu'il utilise la technologie du flux pondéré. Cette technologie dissocie les empreintes informatiques et mémoire et permet d'étendre la mémoire pour qu'elle soit suffisamment grande pour stocker un nombre quelconque de paramètres qui augmentent les charges de travail de l'IA.

Grâce à cette avancée, le temps de mise en place d'un modèle a été réduit de quelques mois à quelques minutes. Et les développeurs peuvent basculer entre des modèles tels que GPT-J et GPT-Neo en « quelques touches seulement ». Cela facilite le développement du PNL.

Cela a entraîné de nouveaux changements dans le domaine de la PNL.

Comme Dan Olds, directeur de recherche d'Intersect360 Research, a commenté les réalisations de Cerebras : « La capacité de Cerebras à proposer de grands modèles de langage au grand public de manière rentable et accessible ouvre une nouvelle ère passionnante de l'intelligence artificielle. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

ébrécher

ébrécher

Méthode de cryptage des données

Méthode de cryptage des données

Comment ouvrir un fichier csv

Comment ouvrir un fichier csv

Solution d'écran noir de démarrage Ubuntu

Solution d'écran noir de démarrage Ubuntu

Sinon, utilisation dans la structure de boucle Python

Sinon, utilisation dans la structure de boucle Python

introduction à la commande route add

introduction à la commande route add

Que dois-je faire si je ne peux envoyer qu'un seul message privé sur TikTok ?

Que dois-je faire si je ne peux envoyer qu'un seul message privé sur TikTok ?

l'espacement des lettres

l'espacement des lettres