Laissez un singe appuyer au hasard sur les touches d'une machine à écrire. Tant que vous lui donnez suffisamment de temps, il peut taper les œuvres complètes de Shakespeare.

Et si c'était un singe qui comprend la grammaire et la sémantique ? La réponse est que même la recherche scientifique peut être réalisée pour vous !

La dynamique de développement des modèles de langage est très rapide. Il y a quelques années, ils ne pouvaient compléter automatiquement que le mot suivant à saisir sur la méthode de saisie. Aujourd'hui, ils peuvent déjà aider les chercheurs à analyser et à rédiger des articles scientifiques et à générer du code. .

La formation de grands modèles de langage (LLM) nécessite généralement des données textuelles massives pour la prise en charge.

En 2020, OpenAI a publié le modèle GPT-3 avec 175 milliards de paramètres. Il peut écrire de la poésie, résoudre des problèmes mathématiques et presque tout ce que le modèle de génération GPT-3 peut faire. Même aujourd'hui, GPT. -3 est toujours C'est la référence pour que de nombreux modèles linguistiques soient comparés et dépassés.

Après la sortie de GPT-3, cela a rapidement suscité des discussions animées sur Twitter et d'autres médias sociaux. Un grand nombre de chercheurs ont été surpris par cette étrange méthode d'« écriture de type humain ».

Après la sortie du service en ligne de GPT-3, les utilisateurs peuvent saisir du texte à volonté et laisser le modèle renvoyer ce qui suit. Les frais les plus bas sont de seulement 0,0004 $ US pour 750 mots traités, ce qui est très abordable.

Récemment, un article a été publié dans la rubrique Nature sur la science et la technologie. Je ne m'attendais pas à ce qu'en plus de vous aider à rédiger des essais, ces modèles de langage puissent aussi vous aider à « faire de la recherche scientifique » !

Hafsteinn Einarsson, informaticien à l'Université d'Islande à Reykjavik, a déclaré : J'utilise GPT-3 presque tous les jours, par exemple pour réviser le résumé d'un article.

Lorsque Einarsson préparait la copie lors d'une réunion en juin, bien que GPT-3 ait fait de nombreuses suggestions de modifications inutiles, il y en avait aussi quelques-unes utiles, comme "rendre la question de recherche plus claire au début du résumé", et cela Vous ne réaliserez pas ce genre de problème lorsque vous lirez le manuscrit vous-même, à moins que vous ne demandiez à quelqu'un d'autre de le lire pour vous. Et pourquoi cette autre personne ne peut-elle pas être « GPT-3 » ?

Les modèles linguistiques peuvent même vous aider à améliorer votre conception expérimentale !

Dans un autre projet, Einarsson souhaitait collecter des données linguistiques parmi les participants utilisant le jeu Pictionary.

Après avoir donné une description du jeu, GPT-3 a donné quelques suggestions de modifications du jeu. En théorie, les chercheurs pourraient également demander de nouvelles tentatives de protocoles expérimentaux.

Certains chercheurs utilisent également des modèles linguistiques pour générer des titres papier ou rendre le texte plus lisible.

La méthode utilisée par Mina Lee, doctorante et professeur d'informatique à l'Université de Stanford, consiste à saisir "Utiliser ces mots-clés pour générer un titre d'article" dans GPT-3 comme invite, et le modèle vous aider à formuler plusieurs titres.

Si certains chapitres doivent être réécrits, elle utilisera également Wordtune, un assistant d'écriture d'intelligence artificielle développé par le laboratoire AI21 de Tel Aviv, en Israël. Il lui suffit de cliquer sur "Réécrire" pour convertir plusieurs versions des paragraphes réécrits. . Ensuite, sélectionnez-le avec soin.

Lee demandera également à GPT-3 de lui faire des suggestions sur certaines choses de la vie. Par exemple, lorsqu'on lui a demandé « comment présenter son petit ami à ses parents », GPT-3 a suggéré d'aller dans un restaurant sur la plage.

Domenic Rosati, informaticien chez Scite, une startup technologique située à Brooklyn, New York, a utilisé le modèle de langage Generate pour réorganiser ses idées.

Lien : https://cohere.ai/generate

Generate a été développé par Cohere, une société PNL au Canada. Le flux de travail du modèle est très similaire à GPT-3.

Entrez simplement des notes, ou parlez simplement de quelques idées, et enfin ajoutez « résumer » ou « transformez-le en un concept abstrait », et le modèle vous aidera automatiquement à organiser vos pensées.

Les chercheurs d'OpenAI ont formé GPT-3 sur une grande quantité de texte, notamment des livres, des actualités, des entrées Wikipédia et du code logiciel.

Plus tard, l'équipe a remarqué que GPT-3 pouvait compléter le code tout comme le texte normal.

Les chercheurs ont créé une version affinée de l'algorithme appelée Codex, entraînée sur plus de 150 Go de texte provenant de la plateforme de partage de code GitHub ; actuellement, GitHub a intégré Codex dans le service Copilot pour aider les utilisateurs à écrire du code.

Luca Soldaini, informaticien chez AI2 à l'Allen Institute for Artificial Intelligence à Seattle, Washington, affirme qu'au moins la moitié des personnes dans leur bureau utilisent Copilot

Soldaini a déclaré que Copilot est le mieux adapté à la programmation répétitive. scénarios. Par exemple, l'un de ses projets impliquait l'écriture de code de modèle pour le traitement des PDF, et Copilot l'a directement réalisé.

Cependant, le contenu de complétion de Copilot comporte souvent des erreurs, il est donc préférable de l'utiliser dans des langues que vous connaissez bien.

Le scénario d'application le plus abouti des modèles linguistiques est probablement la recherche et la synthèse de documents.

Le moteur de recherche Semantic Scholar développé par AI2 utilise le modèle de langage TLDR pour donner une description de type Twitter de chaque article.

Le moteur de recherche couvre environ 200 millions d'articles, principalement issus de la biomédecine et de l'informatique.

TLDR a été développé sur la base du modèle BART publié précédemment par Meta, puis les chercheurs d'AI2 ont affiné le modèle sur la base de résumés écrits par des humains.

Selon les normes actuelles, TLDR n'est pas un grand modèle de langage, car il ne contient qu'environ 400 millions de paramètres, tandis que la plus grande version de GPT-3 en contient 175 milliards.

TLDR est également utilisé dans Semantic Reader, une application étendue d'articles scientifiques développée par AI2.

Lorsque les utilisateurs utilisent des citations dans le texte dans Semantic Reader, une boîte d'informations contenant un résumé TLDR apparaîtra.

Dan Weld, scientifique en chef de Semantic Scholar, a déclaré que notre idée est d'utiliser des modèles de langage pour améliorer l'expérience de lecture.

Lorsqu'un modèle de langage génère un résumé de texte, le modèle peut générer des faits qui n'existent pas dans l'article. Les chercheurs appellent ce problème « illusion », mais en fait le modèle de langage est simplement une invention ou un mensonge.

TLDR a obtenu de meilleurs résultats au test d'authenticité. L'auteur de l'article a évalué la précision de TLDR à 2,5 points (sur 3 points).

Weld a déclaré que le TLDR est plus réaliste car le résumé ne compte qu'environ 20 mots, et peut-être parce que l'algorithme ne met pas dans le résumé des mots qui n'apparaissent pas dans le texte principal.

En termes d'outils de recherche, Should, une organisation à but non lucratif d'apprentissage automatique basée à San Francisco, en Californie, a lancé Elicit en 2021. Si un utilisateur lui demande « Quel est l'impact de la pleine conscience sur la prise de décision ? » afficher un tableau contenant dix articles.

Les utilisateurs peuvent demander au logiciel de remplir des colonnes avec des éléments tels que des résumés et des métadonnées, ainsi que des informations sur les participants à l'étude, les méthodes et les résultats, puis utiliser des outils, notamment GPT-3, pour extraire des données de le document. Extrayez ou générez ces informations.

Le domaine de recherche de Joel Chan est l'interaction homme-machine à l'Université du Maryland, College Park Chaque fois qu'il démarre un nouveau projet, il utilise Elicit pour rechercher des articles pertinents.

Gustav Nilsonne, neuroscientifique à l'Institut Karolinska de Stockholm, a également utilisé Elicit pour trouver des articles contenant des données qui pourraient être ajoutées à l'analyse groupée, en utilisant l'outil pour trouver des documents introuvables dans d'autres recherches.

Le prototype d'AI2 donne à LLM une sensation futuriste.

Parfois, les chercheurs ont des questions après avoir lu le résumé d’un article scientifique, mais n’ont pas encore le temps de lire le texte intégral.

Une équipe d'AI2 a également développé un outil capable de répondre à ces questions dans le domaine de la PNL.

Le modèle a d'abord demandé aux chercheurs de lire le résumé de l'article PNL, puis a posé des questions pertinentes (telles que « Quels cinq attributs de dialogue ont été analysés ? »)

L'équipe de recherche a ensuite demandé à d'autres chercheurs de répondre après lire l'intégralité du document.

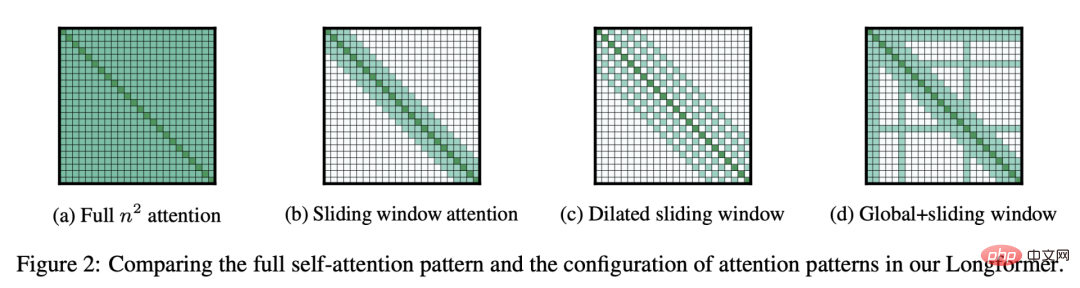

AI2 a formé une autre version du modèle linguistique Longformer, en prenant en entrée un article complet, puis a utilisé l'ensemble de données collectées pour générer des réponses à différentes questions sur d'autres articles. Le modèle

ACCoRD peut générer des définitions et des analogies pour 150 concepts scientifiques liés à la PNL.

MS2 est un ensemble de données contenant 470 000 documents médicaux et 20 000 résumés multidocuments. Après avoir affiné BART avec MS2, les chercheurs ont pu poser une question et un ensemble de documents et générer un court résumé de méta-analyse.

En 2019, AI2 a affiné BERT, le modèle de langage créé par Google en 2018, et a créé SciBERT avec 110 millions de paramètres basés sur l'article de Semantic Scholar

Scite a utilisé l'intelligence artificielle pour créer un moteur de recherche scientifique, en outre SciBERT a affiné de sorte que lorsque son moteur de recherche répertorie les articles qui citent un article cible, il classe ces articles comme soutenant, contrastant ou mentionnant l'article.

Rosati a déclaré que cette nuance aide les gens à identifier les limites ou les lacunes de la littérature scientifique.

Le modèle SPECTRE d'AI2 est également basé sur SciBERT, qui simplifie les articles en représentations mathématiques compactes.

Weld a déclaré que les organisateurs de la conférence utilisent SPECTRE pour faire correspondre les articles soumis aux pairs évaluateurs, et Semantic Scholar l'utilise pour recommander des articles en fonction des bibliothèques des utilisateurs.

Tom Hope, informaticien à l'Université hébraïque et à AI2, a déclaré qu'ils avaient des projets de recherche affinant les modèles de langage pour identifier les combinaisons de médicaments efficaces, les liens entre les gènes et les maladies, ainsi que les défis et orientations scientifiques de la recherche sur le COVID-19.

Mais les modèles linguistiques peuvent-ils fournir des informations plus approfondies ou même des capacités de découverte ?

En mai, Hope et Weld ont co-écrit un commentaire avec Eric Horvitz, directeur scientifique de Microsoft, décrivant les défis liés à la réalisation de cet objectif, y compris des modèles d'enseignement pour "(déduire) les conséquences de la recombinaison de deux concepts".

Hope a dit que c'est fondamentalement la même chose que le modèle de génération d'images DALL · E 2 d'OpenAI "générant l'image d'un chat volant dans l'espace", mais comment pouvons-nous progresser vers une combinaison de concepts scientifiques abstraits et très complexes ?

?C'est une question ouverte.

Aujourd'hui, les grands modèles linguistiques ont eu un réel impact sur la recherche, et si les gens n'ont pas commencé à utiliser ces grands modèles linguistiques pour les aider dans leur travail, ils rateront ces opportunités.

Référence :

https://www.nature.com/articles/d41586-022-03479-w

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment supprimer le verrou de sécurité de Firefox

Comment supprimer le verrou de sécurité de Firefox

Comment annuler le renouvellement automatique de la carte Taobao Money Saving

Comment annuler le renouvellement automatique de la carte Taobao Money Saving

Que signifie le réseau Apple LTE ?

Que signifie le réseau Apple LTE ?

vscode crée une méthode de fichier HTML

vscode crée une méthode de fichier HTML

Annuler le mot de passe de mise sous tension sous XP

Annuler le mot de passe de mise sous tension sous XP

cadre réseau

cadre réseau

Introduction au document en JS

Introduction au document en JS

Quelles sont les commandes d'arrêt de Linux ?

Quelles sont les commandes d'arrêt de Linux ?