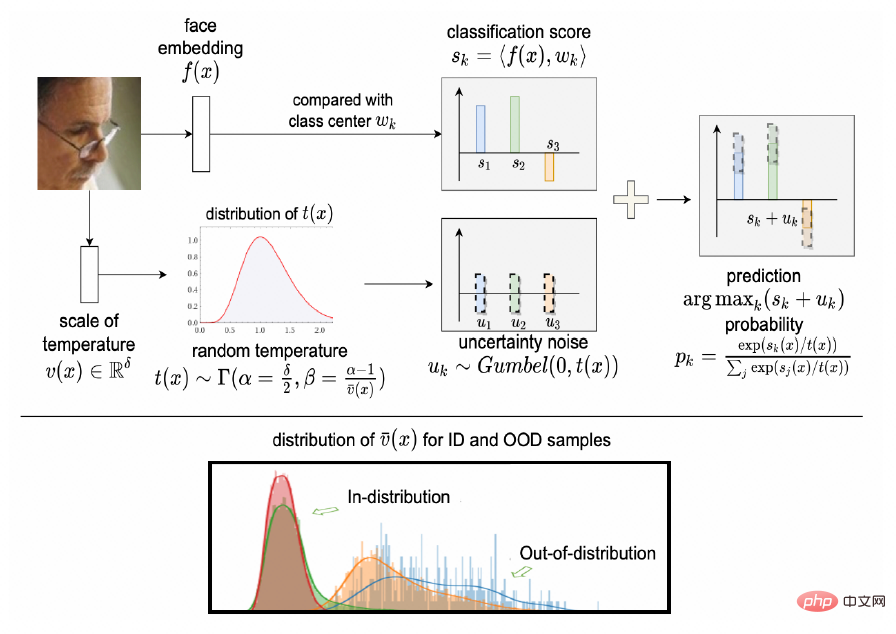

Cet article présente l'article « Améliorer la formation et l'inférence des modèles de reconnaissance faciale via Random Temperature Scaling » qui a été accepté par l'AAAI 2023, la plus grande conférence internationale sur l'apprentissage automatique. Cet article analyse de manière innovante la relation intrinsèque entre le paramètre d'ajustement de la température et l'incertitude de classification dans la fonction de perte de classification d'un point de vue probabiliste, révélant que le facteur d'ajustement de la température de la fonction de perte de classification est le coefficient d'échelle de la variable d'incertitude obéissant à la distribution de Gumbel. Par conséquent, un nouveau cadre de formation appelé RTS est proposé pour modéliser la fiabilité de l’extraction de fonctionnalités. Sur la base du cadre de formation RTS, un modèle de reconnaissance plus fiable est formé pour rendre le processus de formation plus stable et fournir un score de mesure de l'incertitude des échantillons pendant le déploiement afin de rejeter les échantillons très incertains et d'aider à construire un système d'identification de vision plus robuste. Des expériences approfondies montrent que RTS peut s'entraîner de manière stable et produire des mesures d'incertitude pour construire un système de reconnaissance visuelle robuste.

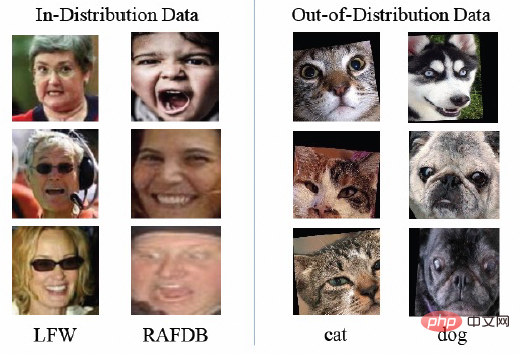

Problème d'incertitude : Les systèmes de reconnaissance visuelle rencontrent généralement diverses interférences dans des scènes réelles. Par exemple : occlusion (décoration ou premier plan complexe), flou d'imagerie (flou de mise au point ou flou de mouvement), éclairage extrême (surexposition ou sous-exposition, etc.). Ces interférences peuvent être résumées par l'impact du bruit. De plus, il existe des images mal détectées, généralement des visages de chat ou de chien. Ces données mal détectées sont appelées données hors distribution (OOD). Pour la reconnaissance visuelle, les données de bruit et OOD mentionnées ci-dessus constituent une source d'incertitude. Les échantillons concernés superposeront l'incertitude aux caractéristiques extraites sur la base du modèle de profondeur, provoquant des interférences avec le système de reconnaissance visuelle. Par exemple, si l'image de base est contaminée par des échantillons avec des interférences incertaines, un « trou noir caractéristique » se formera, ce qui entraînera des dangers cachés pour le système de reconnaissance visuelle. Il existe donc un besoin de modéliser la fiabilité des représentations.

Solution multi-modèle traditionnelle

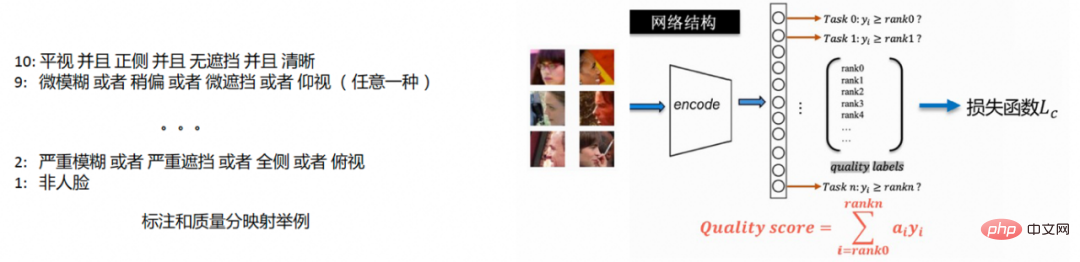

La méthode traditionnelle de contrôle de la fiabilité dans le lien de reconnaissance visuelle se fait à travers un modèle de qualité indépendant. La méthode typique de modélisation de la qualité d'image est la suivante :

1. Collectez des données d'annotation et annotez les facteurs spécifiques qui affectent la qualité, tels que la clarté, la présence ou l'absence d'occlusion et la posture.

2. Cartographiez le score de qualité de 1 à 10 selon l'étiquette des facteurs d'influence. Plus le score est élevé, meilleure est la qualité. Pour des exemples spécifiques, veuillez vous référer à l'exemple à gauche de la figure ci-dessous. .

3. Après avoir obtenu l'annotation du score de qualité des deux premières étapes, effectuez un entraînement de régression ordonnée pour prédire le score de qualité pendant la phase de déploiement, comme le montre l'exemple à droite de la figure ci-dessous.

La solution de modèle de qualité indépendant nécessite l'introduction d'un nouveau modèle dans le lien de reconnaissance visuelle, et la formation s'appuie sur des informations d'annotation.

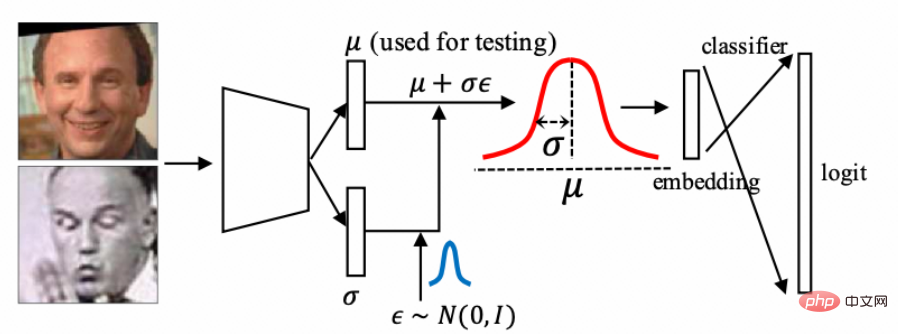

DUL

La méthode de modélisation de l'incertitude comprend « l'apprentissage de l'incertitude des données dans la reconnaissance faciale », qui modélise la caractéristique comme la somme de la moyenne et de la variance de la distribution gaussienne, et transforme les caractéristiques contenant de l'incertitude en Après l'avoir envoyé au classificateur pour formation. Ainsi, le score d'incertitude lié à la qualité de l'image peut être obtenu lors de la phase de déploiement.

DUL utilise une méthode de sommation pour décrire l'incertitude, et l'échelle de l'estimation du bruit est également étroitement liée à la distribution caractéristique d'un certain type de données. Si la distribution des données est relativement étroite, alors l’ampleur du bruit estimé par DUL est également relativement petite. Les travaux dans le domaine de l'OOD soulignent que la densité de distribution des données n'est pas une bonne mesure pour l'identification de l'OOD.

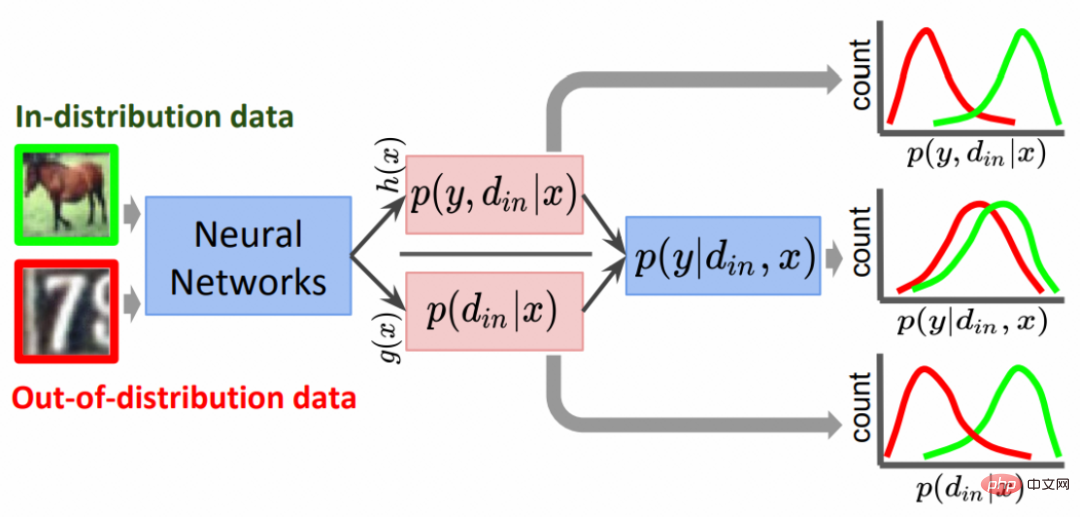

GODIN

Le travail dans le domaine de l'OOD "Odin généralisé : Détection d'images hors distribution sans apprendre à partir de données hors distribution" utilise la forme de distribution de probabilité conjointe pour traiter les données OOD, en utilisant deux branches indépendantes h(x) et g respectivement (x) Estimer les valeurs de probabilité de classification et les valeurs d'ajustement de la température.

La valeur de température étant modélisée comme une valeur de probabilité, la plage est limitée entre 0-1, ce qui ne permet pas une meilleure modélisation de la température.

En réponse aux problèmes ci-dessus et aux travaux connexes, cet article analyse la relation entre le facteur d'ajustement de la température et l'incertitude dans la fonction de perte de classification d'un point de vue probabiliste et propose un cadre de formation RTS.

Analyse des facteurs d'ajustement de la température basée sur une perspective de probabilité

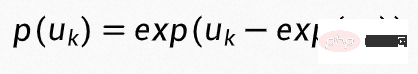

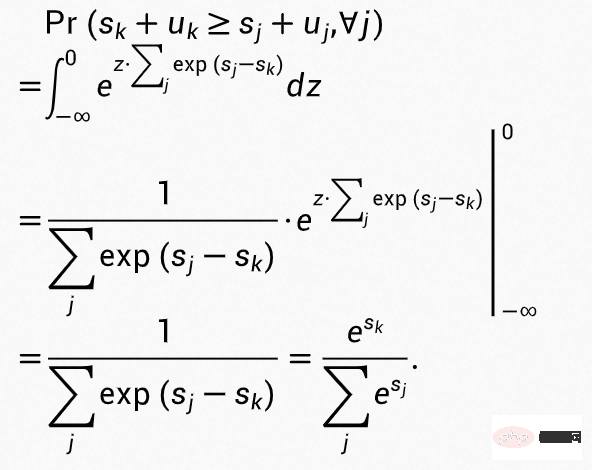

Tout d'abord, analysez la relation entre les facteurs d'ajustement de la température et l'incertitude. Supposons que l'incertitude  soit une variable aléatoire conforme à la distribution standard de Gumbel, alors la fonction de densité de probabilité peut être écrite sous la forme

soit une variable aléatoire conforme à la distribution standard de Gumbel, alors la fonction de densité de probabilité peut être écrite sous la forme

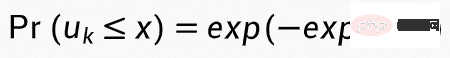

, la fonction de distribution cumulative de est

, la fonction de distribution cumulative de est  , et la probabilité La valeur de est classée en k classes est :

, et la probabilité La valeur de est classée en k classes est :

Mettre  dans la formule ci-dessus peut obtenir :

dans la formule ci-dessus peut obtenir :

On peut voir que la valeur de probabilité classé en La classe k est le score conforme à la fonction softmax, En même temps, nous pouvons utiliser a t pour ajuster l'échelle d'incertitude, c'est-à-dire qu'il est conforme à la distribution standard de Gumbel :

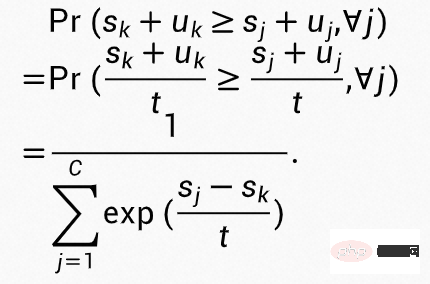

Il peut On voit que la valeur de probabilité classée dans la classe k à ce moment est cohérente avec la valeur d'ajustement de la température qui est le score de la fonction softmax de t.

Température de modélisation

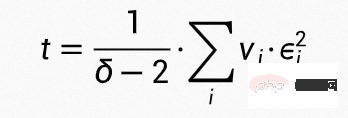

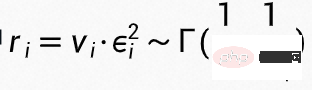

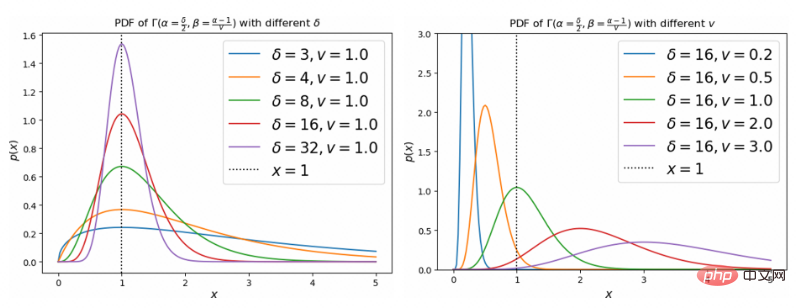

Afin de réduire l'impact de l'estimation de l'incertitude sur la classification, la température t doit être proche de 1, nous modélisons donc la température t comme la somme de  variables de distribution gamma indépendantes :

variables de distribution gamma indépendantes :  où

où  , donc qui n'obéit pas

, donc qui n'obéit pas

, beta = frac {alpha - 1}{v})$ distribution. L'influence de v et  sur la distribution est indiquée ci-dessous.

sur la distribution est indiquée ci-dessous.

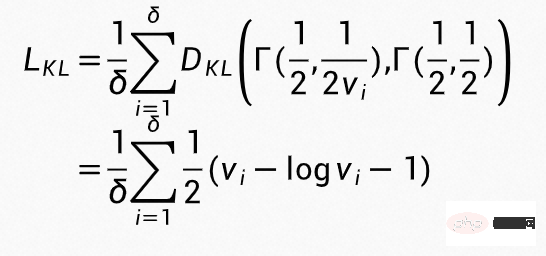

Les contraintes sur la modélisation de la température sont implémentées en utilisant les termes réguliers suivants lors de la formation

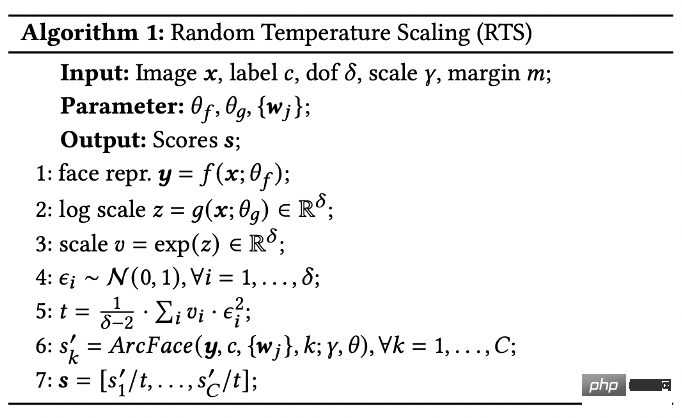

L'algorithme global est organisé comme :

Veuillez vous référer à l'article pour une analyse plus détaillée et une preuve théorique.

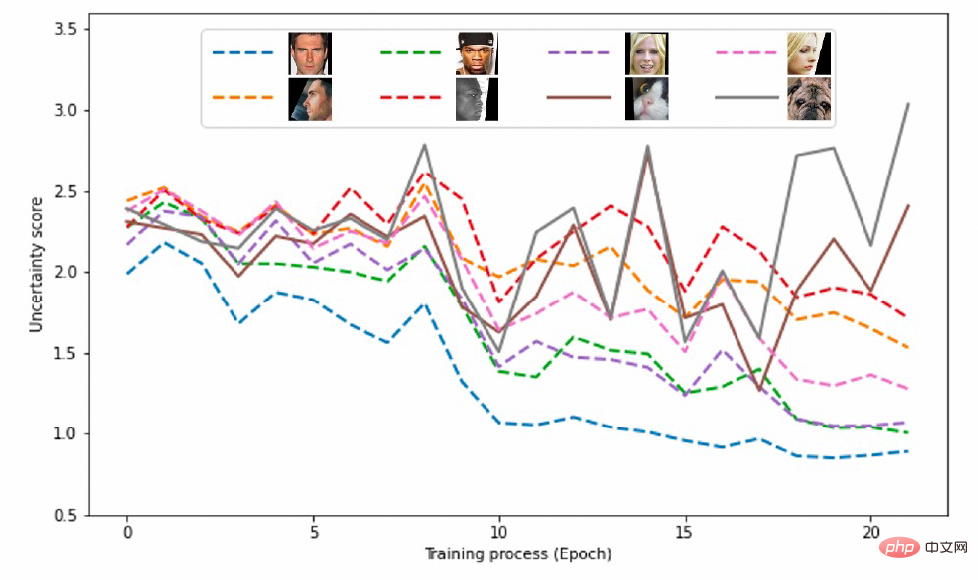

Dans la phase d'entraînement, les données d'entraînement ne contiennent que des données d'entraînement du visage. Les données OOD des visages de chat et de chien faussement détectés sont utilisées pour vérifier l'effet de reconnaissance des données OOD pendant les tests et le test illustre le processus dynamique d'incertitude des échantillons OOD à différentes étapes du processus de formation.

Phase d'entraînement

Nous dessinons l'incertitude des données en distribution (visage) et des données hors distribution (visages de chat et visages de chien détectés par erreur comme visages) à différents numéros d'époque Score de degré. Dans la figure ci-dessous, vous pouvez voir que les scores d'incertitude de tous les échantillons de la phase initiale sont distribués à proximité des valeurs les plus élevées. Au fur et à mesure que la formation progresse, l'incertitude des échantillons OOD augmente progressivement et l'incertitude des données faciales augmente progressivement. diminue, et plus la qualité du visage est bonne, plus l'incertitude est faible. Les données ID et les données OOD peuvent être distinguées en définissant un seuil, et la qualité de l'image est reflétée par le score d'incertitude.

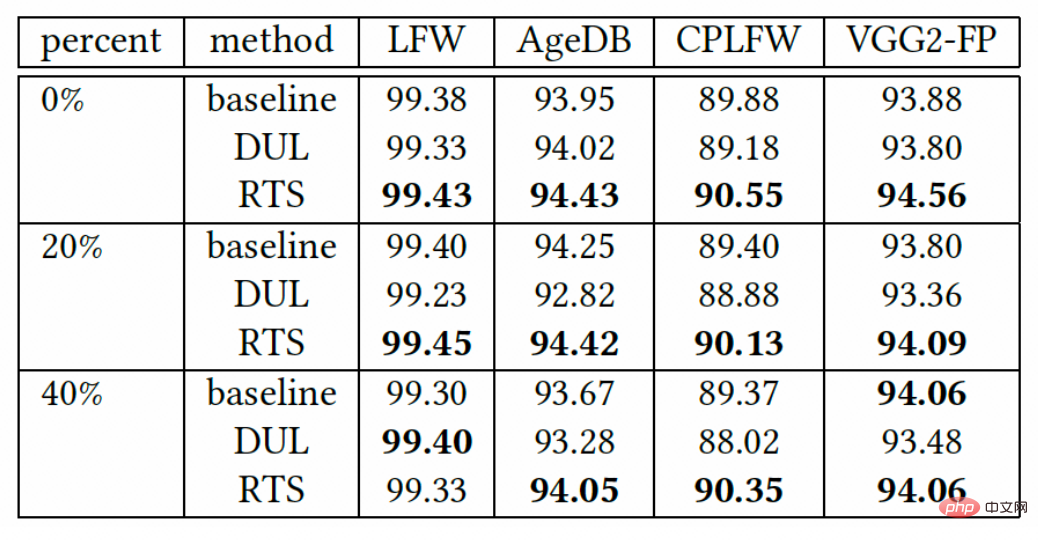

Pour illustrer la robustesse aux données d'entraînement bruyantes pendant la phase d'entraînement. Cet article applique différentes proportions de bruit à l'ensemble d'entraînement. Les effets de reconnaissance du modèle basés sur différentes proportions de données d'entraînement au bruit sont les suivants. On peut voir que RTS peut également obtenir de meilleurs résultats de reconnaissance pour l'entraînement basé sur les données de bruit.

Phase de déploiement

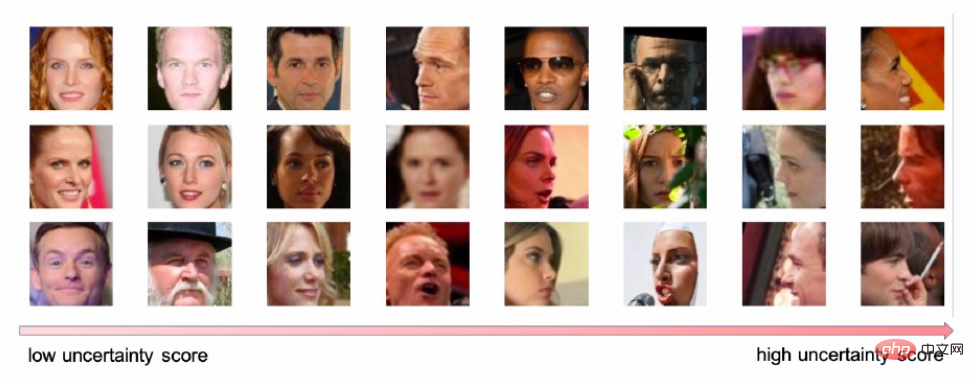

La figure suivante montre que le score d'incertitude obtenu par le framework RTS et la qualité du visage pendant la phase de déploiement montrent une forte corrélation

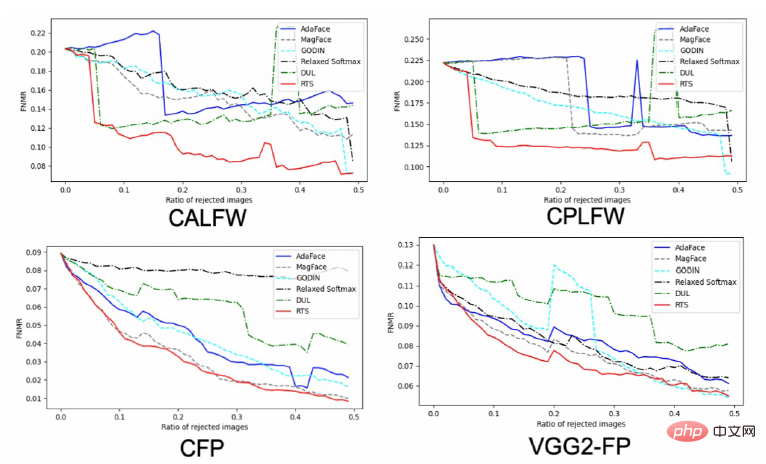

Dans le même temps, la courbe de correspondance des erreurs après suppression des échantillons de mauvaise qualité est tracée sur le benchmark. Sur la base des scores d'incertitude obtenus, les échantillons présentant une incertitude plus élevée dans le benchmark sont supprimés par ordre d'incertitude de haut en bas, puis les courbes d'appariement d'erreur des échantillons restants sont tracées. Comme le montre la figure ci-dessous, à mesure que davantage d'échantillons avec une incertitude plus élevée sont filtrés, il y a moins de fausses correspondances, et lorsque le même nombre d'échantillons d'incertitude est supprimé, RTS a moins de fausses correspondances.

Afin de vérifier l'effet d'identification du score d'incertitude sur les échantillons OOD, un ensemble de données en distribution (visage) et un ensemble de données hors distribution (chats détectés par erreur comme visages) ont été construit lors des tests face et face de chien). L'échantillon de données est le suivant.

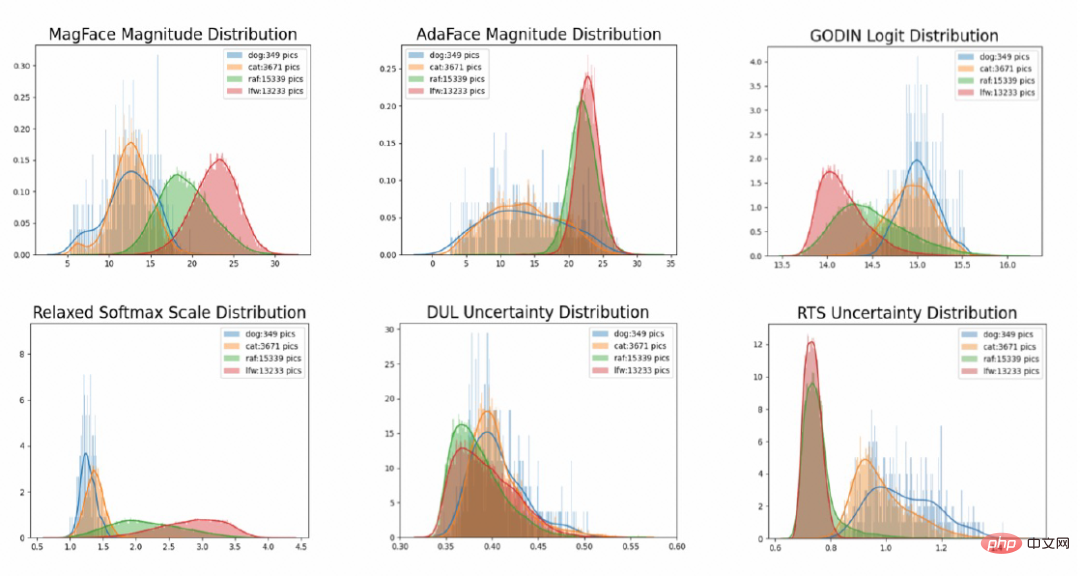

Nous expliquons l'effet du RTS sous deux aspects. Tout d'abord, dessinez le diagramme de distribution de l'incertitude. Comme vous pouvez le voir sur la figure ci-dessous, la méthode RTS a une forte capacité de discrimination pour les données OOD.

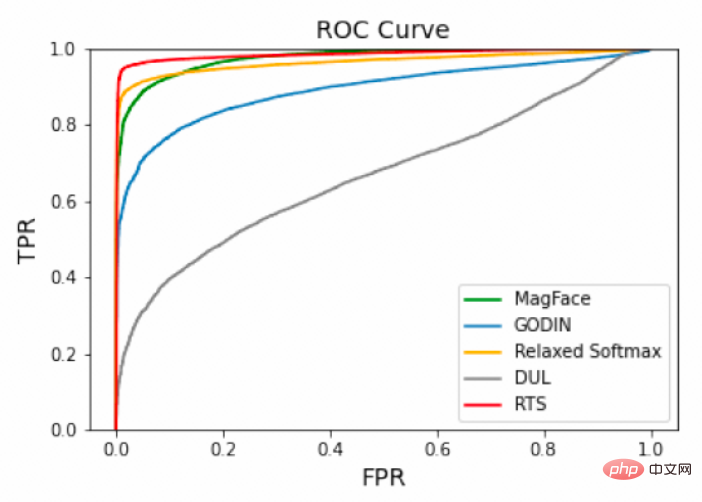

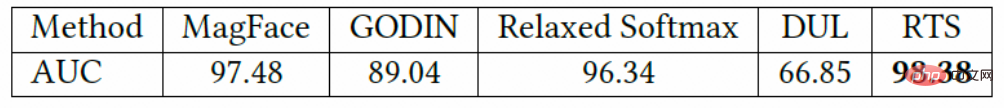

Dans le même temps, la courbe ROC sur l'ensemble de tests OOD a également été tracée et la valeur AUC de l'autorité ROC a été calculée. On peut voir que le score d'incertitude du RTS peut mieux identifier. Données OOD.

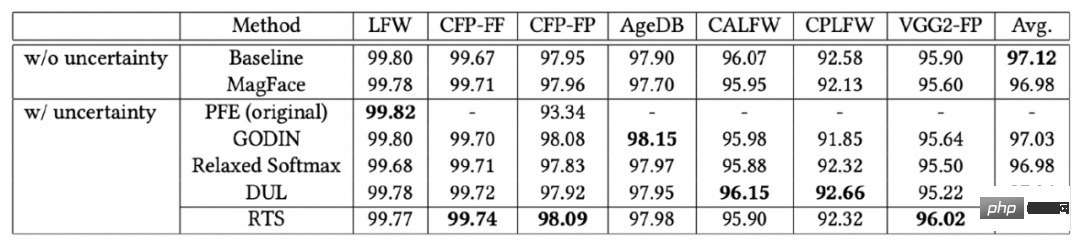

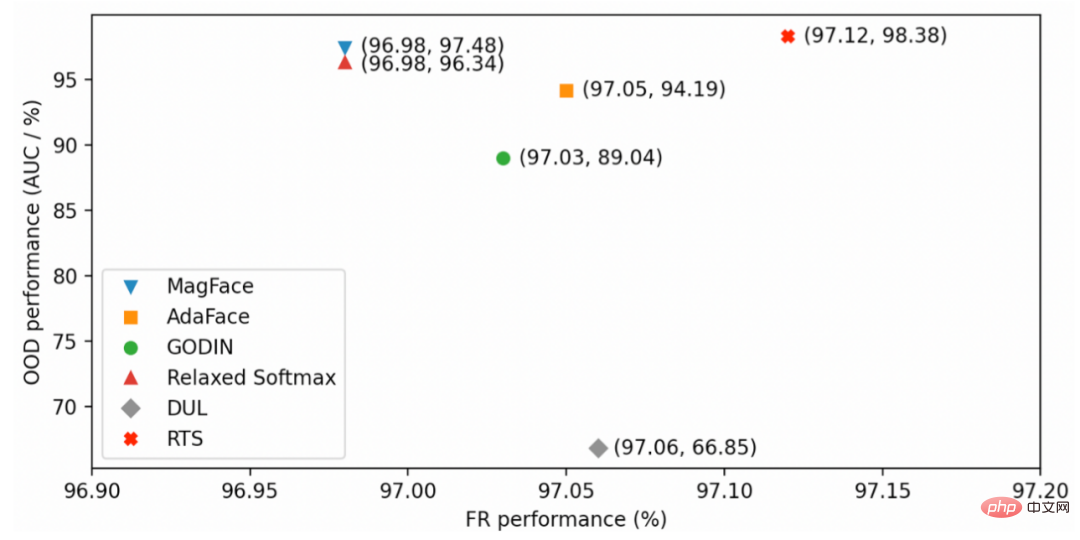

Capacité de reconnaissance universelle

Testez la capacité de reconnaissance universelle sur le benchmark. L'utilisation de l'algorithme RTS peut obtenir un résultat équilibré en matière d'identification et d'identification des données OOD.

Le modèle dans cet article a été open source dans modelscope. De plus, j'aimerais vous présenter le modèle gratuit open source sur le domaine CV. Tout le monde est invité à l'expérimenter et à le télécharger (vous pouvez l'expérimenter sur la plupart des téléphones mobiles) :

1. cn/models/damo/cv_resnet50_face-detection_retinaface/summary

2.https://modelscope.cn/models/damo/cv_resnet101_face-detection_cvpr22papermogface/summary

3.https://modelscope.cn/models/ damo/cv_manual_face-detection_tinymog/summary

4.https://modelscope.cn/models/damo/cv_manual_face-detection_ulfd/summary

5.https://modelscope.cn/models/damo/cv_manual_face- détection_mtcnn/summary

6.https://modelscope.cn/models/damo/cv_resnet_face-recognition_facemask/summary

7.https://modelscope.cn/models/damo/cv_ir50_face-recognition_arcface/summary

8. https://modelscope.cn/models/damo/cv_manual_face-liveness_flir/summary

9.https://modelscope.cn/models/damo/cv_manual_face-liveness_flrgb/summary

10 .https://modelscope.cn/models /damo/cv_manual_facial-landmark-confidence_flcm/summary

11.https://modelscope.cn/models/damo/cv_vgg19_facial-expression-recognition_fer/summary

12 .https://modelscope.cn/models/damo/cv_resnet34_face-attribute-recognition_fairface/summary

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quel est le système Honor ?

Quel est le système Honor ?

Quelle est la différence entre passer par valeur et passer par référence en Java

Quelle est la différence entre passer par valeur et passer par référence en Java

Que faire si le post-scriptum ne peut pas être analysé

Que faire si le post-scriptum ne peut pas être analysé

Que faire en cas de conflit IP

Que faire en cas de conflit IP

Le rôle du pilote de la carte graphique

Le rôle du pilote de la carte graphique

Comment supprimer un fichier sous Linux

Comment supprimer un fichier sous Linux

Comment optimiser les performances de Tomcat

Comment optimiser les performances de Tomcat

Comment utiliser le sommeil php

Comment utiliser le sommeil php