Alors que tout le monde attend avec impatience la sortie de GPT-4, aucune nouvelle d'OpenAI, qui est toujours en train de réparer son prédécesseur. La société basée à San Francisco a publié hier un nouveau modèle appelé ChatGPT, un dérivé de GPT-3 qui interagit de manière conversationnelle.

Ce dialogue permet à ChatGPT de répondre aux questions de suivi, d'admettre des erreurs, de contester des prémisses incorrectes et de rejeter les demandes inappropriées. Il est différent des autres modèles de langage inventés et fabriqués. Par exemple, le modèle de langage Galactica de Meta a été retiré des étagères quelques jours après son lancement en raison d’une fabrication irresponsable. Ce qui est différent avec ChatGPT, c'est que lorsqu'il ne sait pas de quoi il parle, il admet qu'il ne le sait pas. De plus, ChatGPT refuse de répondre aux questions pour lesquelles il n'est pas formé - par exemple, il ne tentera pas de répondre aux questions sur les événements survenus après 2022. Il ne répond pas non plus aux questions sur les individus.

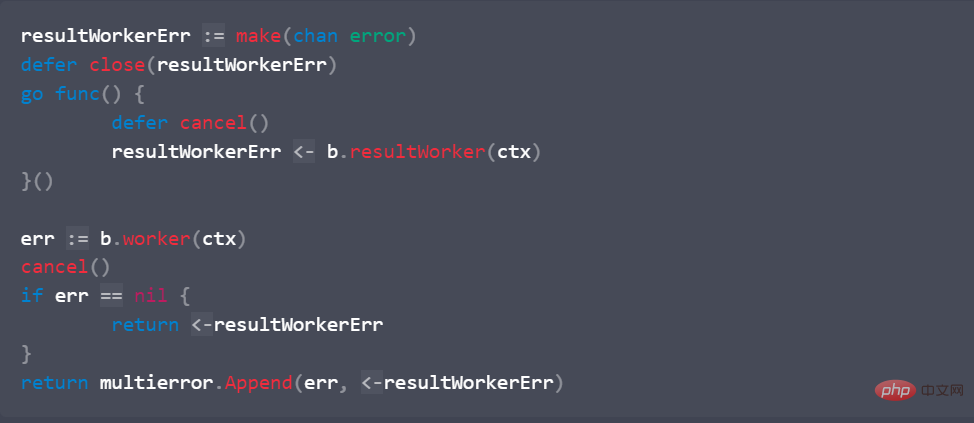

Dans quelle mesure ce modèle est-il intelligent ? Dans le passé, le travail mental de débogage du code devait être effectué par les programmeurs. Désormais, ChatGPT peut prendre en charge cette corvée.

L'utilisateur a dit : Ce code ne s'exécute pas comme prévu, comment dois-je le modifier ?

ChatGPT : Les informations contextuelles que vous avez fournies sont trop peu nombreuses et il est difficile de déterminer le problème avec le code. Pouvez-vous fournir plus d'informations sur le code, par exemple ce que fait le code, s'agit-il de la totalité du code ou d'une partie de celui-ci

Utilisateur : Ceci est une partie du code ? Je pense qu'il y a quelque chose qui ne va pas avec la chaîne.

ChatGPT : Cette question est difficile à répondre sans plus d'informations sur ce que le code est censé faire et ce qui se passe une fois exécuté. D'après les informations que vous avez fournies, il semble qu'un problème potentiel avec votre code est que le canal resultWorkerErr n'est jamais fermé, ce qui signifie que le code peut se bloquer si le canal resultWorkerErr n'est jamais écrit. Cela peut se produire si b.resultWorker ne renvoie pas d'erreur ou s'il est annulé avant d'avoir la possibilité de renvoyer une erreur.

Pour résoudre ce problème, vous pouvez fermer le canal resultWorkerErr après y avoir écrit. Par exemple, vous pouvez ajouter la ligne de code suivante après la ligne qui envoie une erreur au canal :

Cela garantira que le canal resultWorkerErr est toujours fermé, même si le reworker b.c ne renvoie jamais d'erreur. Encore une fois, sans plus d'informations sur le problème que vous rencontrez, il est difficile de dire si c'est bien le problème que vous rencontrez. Pouvez-vous fournir plus de détails sur ce qui se passe lors de l'exécution du code ?

Ce qui précède est un processus de correction de bugs dans ChatGPT, qui peut être considéré comme allant au fond des choses.

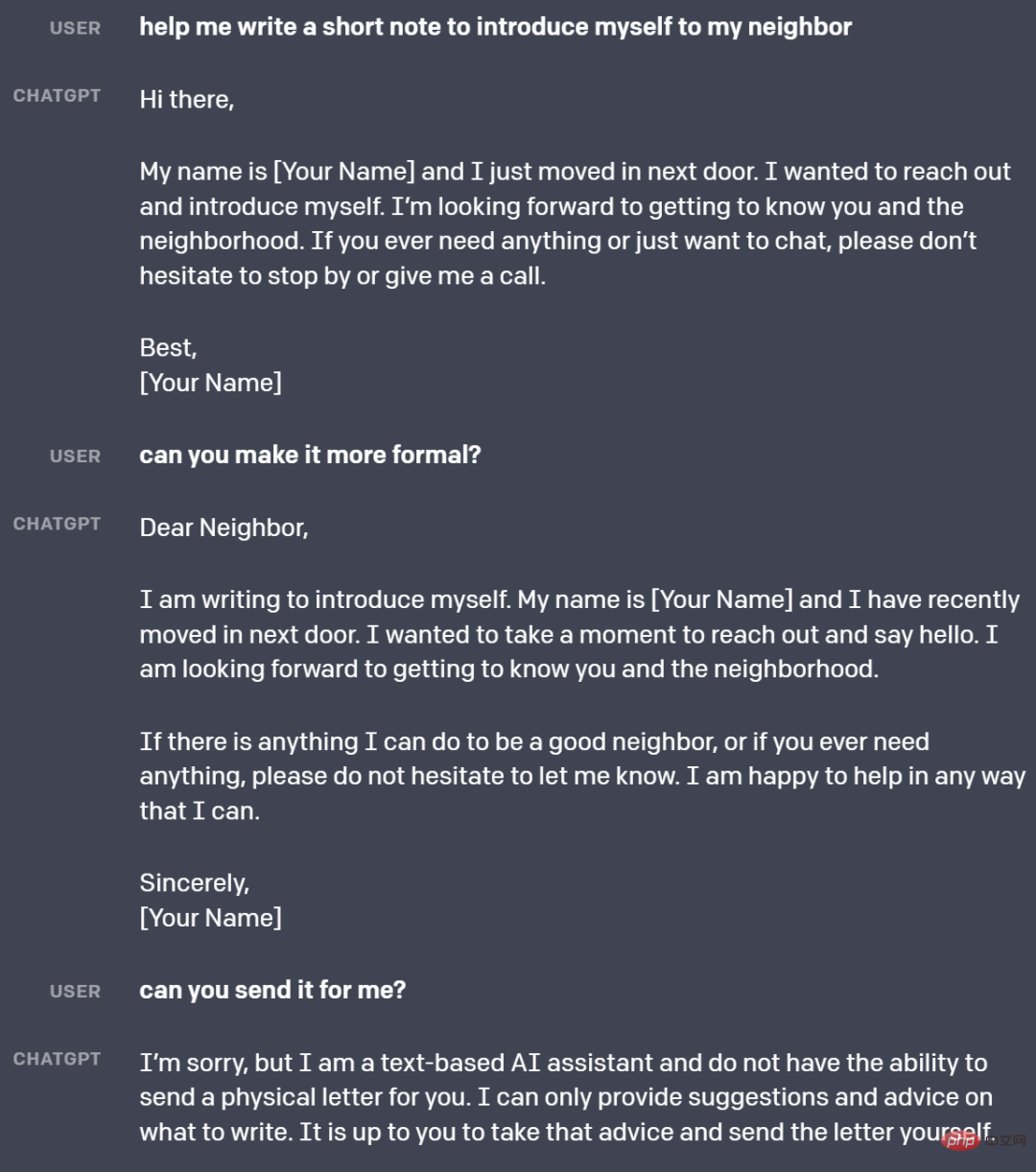

Dans l'exemple ci-dessous, ChatGPT fournit une réponse aux commandes suivantes. L'image ci-dessous signifie à peu près que l'utilisateur a demandé à ChatGPT d'écrire une courte introduction pour lui afin qu'il puisse faire connaissance avec ses voisins ; ChatGPT a donné une courte introduction textuelle, mais l'utilisateur n'a pas aimé cela car il n'était pas assez formel, donc le bien -Tempéré ChatGPT a proposé une autre version officielle Un peu, puis l'utilisateur a fait une autre demande et a demandé à ChatGPT de l'aider à l'envoyer. Finalement, ChatGPT a répondu : "Désolé, je suis un assistant d'IA basé sur du texte et je n'ai pas la possibilité de vous envoyer une lettre physique. Je ne peux que vous fournir des suggestions sur ce qu'il faut écrire. Vous pouvez accepter la suggestion et envoyer la lettre vous-même."

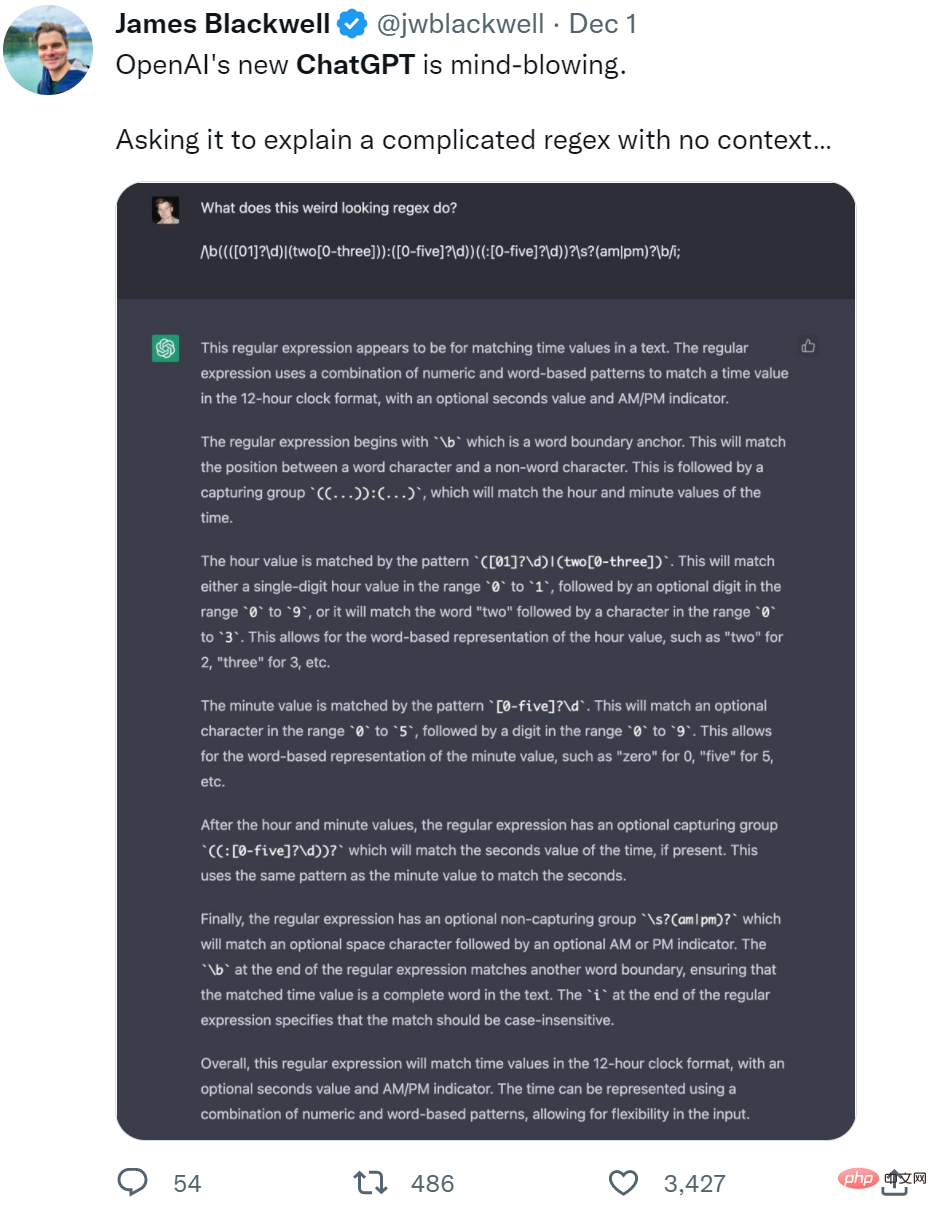

Après avoir vu ça, tu as aussi envie de l'essayer ? Oui, une fois ce modèle sorti, de nombreuses personnes sont devenues accros et incapables de s'en sortir. Même Musk a déclaré : "Beaucoup de gens sont piégés dans la foutue boucle ChatGPT." trouvé Ils ont commencé un nouveau type de plaisir et ont ouvert le mode conversation avec ChatGPT. "Lui demander d'interpréter une expression régulière complexe sans contexte..." Ce problème est vraiment difficile, mais il ne peut pas perturber ChatGPT. À en juger par la longueur de cette explication, elle devrait être expliquée clairement.

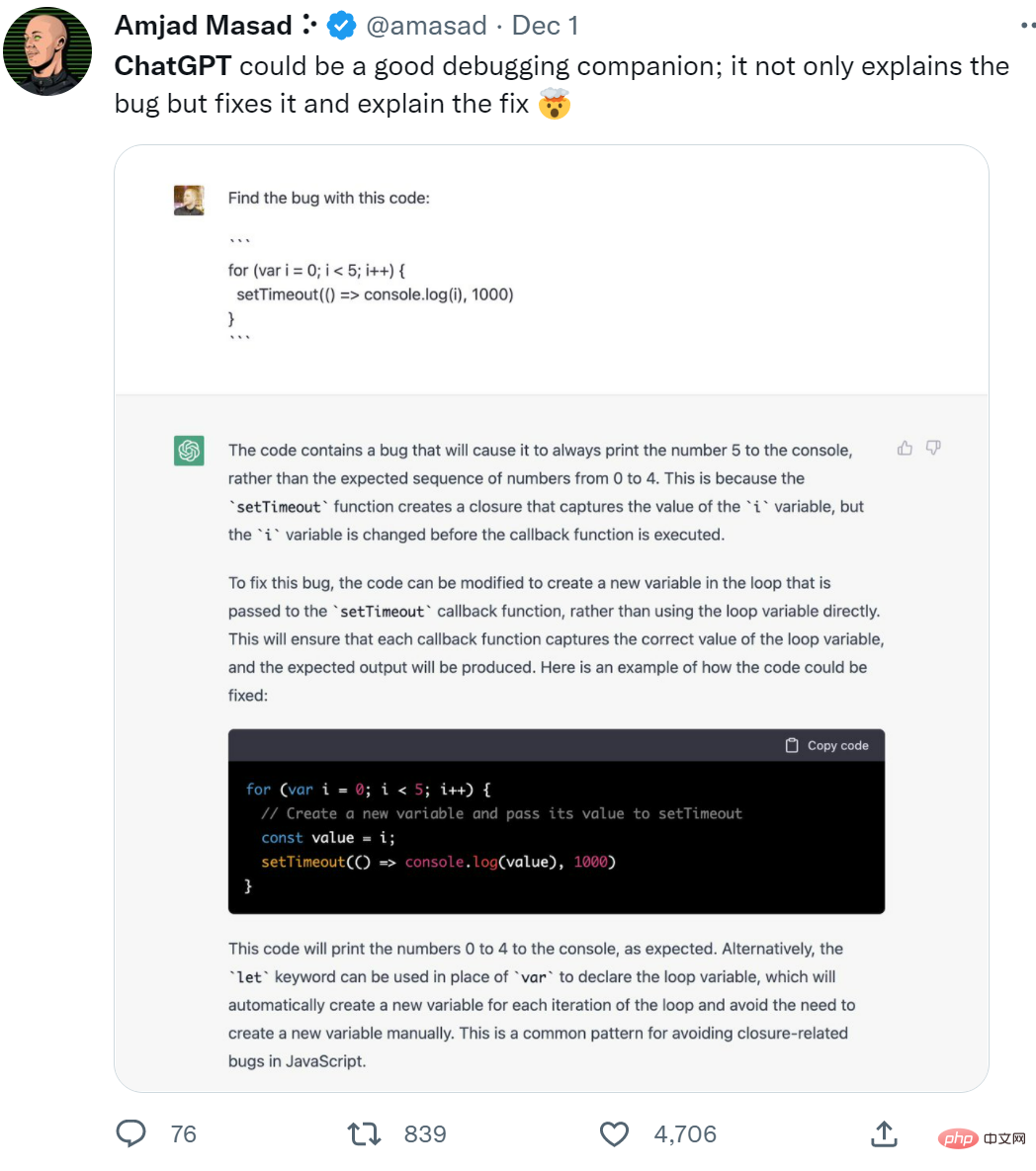

"ChatGPT est un bon partenaire de débogage. Il peut non seulement expliquer les bugs, mais aussi corriger les bugs et expliquer comment les corriger, ont déclaré les internautes."

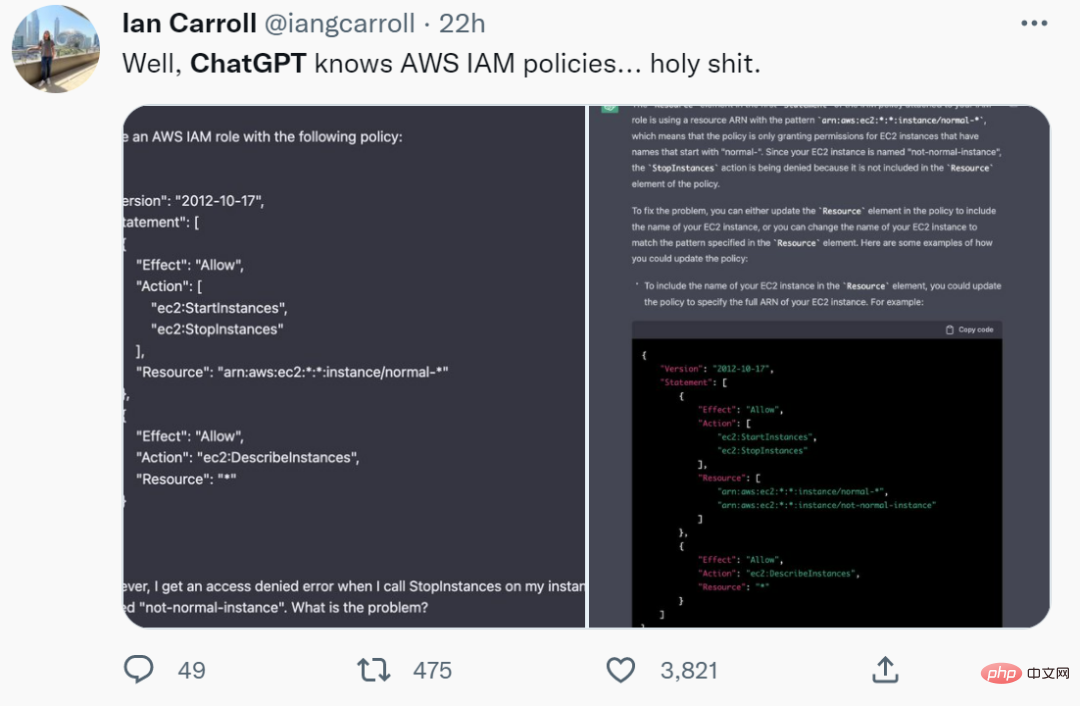

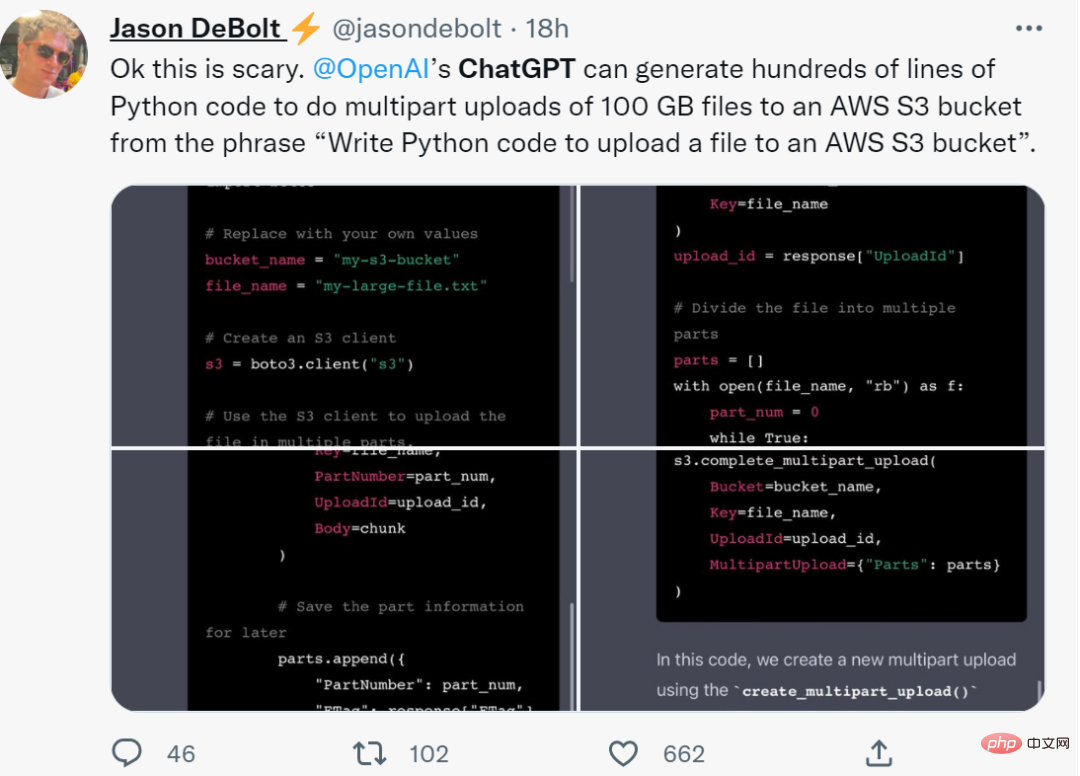

Certains internautes ont dit avec incrédulité : "Oh mon dieu, ChatGPT connaît en fait la politique AWS IAM." Dans le compartiment S3, écrivez simplement cette phrase "Écrivez du code Python pour télécharger un fichier dans un compartiment AWS S3 (Écrivez Code Python pour télécharger le fichier dans le bucket AWS S3)."

Merci à tous Trop enthousiaste, le site d'essai est tombé en panne : "Notre demande est extrêmement forte, veuillez patienter, nous étendons notre système.".

Adresse d'essai : chat.openai.com

ChatGPT utilise la même méthode qu'InstructGPT - entraîner le modèle avec un apprentissage par renforcement avec feedback humain (RLHF), mais les paramètres de collecte de données sont légèrement différent. ChatGPT a formé un modèle initial à l'aide d'un réglage fin supervisé : des conversations ont été fournies par des formateurs d'IA humains, dans lesquelles ils ont joué les deux parties - l'utilisateur et l'assistant d'IA, et les formateurs d'IA ont eu accès aux réponses de conversation écrites par le modèle. pour aider l'IA à adapter les réponses.

ChatGPT a peaufiné un modèle de la série GPT-3.5 qui a terminé sa formation début 2022. ChatGPT et GPT 3.5 ont été formés sur l'infrastructure de supercalcul Azure AI.

Limitations

1. ChatGPT écrit parfois des réponses qui semblent raisonnables mais qui sont incorrectes ou ridicules. Résoudre ce problème est très difficile car :

Par rapport à GPT-3 et Codex, ChatGPT, en tant que dernier modèle publié par OpenAI, a apporté de nombreuses améliorations en termes de sécurité et de convivialité, tiré des leçons des modèles précédents et renforcé l'apprentissage en utilisant le retour humain (RLHF) réduit considérablement le résultat néfaste et irréaliste du modèle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

police de définition du bloc-notes

police de définition du bloc-notes

Comment convertir des fichiers HTML en fichiers PDF

Comment convertir des fichiers HTML en fichiers PDF

Comment accéder au site Web 404

Comment accéder au site Web 404

Introduction aux outils de détection SSL

Introduction aux outils de détection SSL

Ripple a-t-il toujours une valeur d'investissement ?

Ripple a-t-il toujours une valeur d'investissement ?

Méthode d'enregistrement du compte Google

Méthode d'enregistrement du compte Google

Que dois-je faire si la carte d'itinéraire ne peut pas être ouverte ?

Que dois-je faire si la carte d'itinéraire ne peut pas être ouverte ?

Les factures de téléphone de recharge Douyin peuvent-elles être remboursées ?

Les factures de téléphone de recharge Douyin peuvent-elles être remboursées ?