GPT-4, chaud, très chaud.

Mais les membres de la famille, au milieu des applaudissements massifs, il y a quelque chose auquel vous ne vous attendiez peut-être « jamais » :

Il y a neuf indices secrets cachés dans le document technique publié par OpenAI !

Ces indices ont été découverts et organisés par le blogueur étranger AI Explained.

Il est comme un maniaque du détail, révélant un à un ces "coins cachés" à partir du document de 98 pages, notamment :

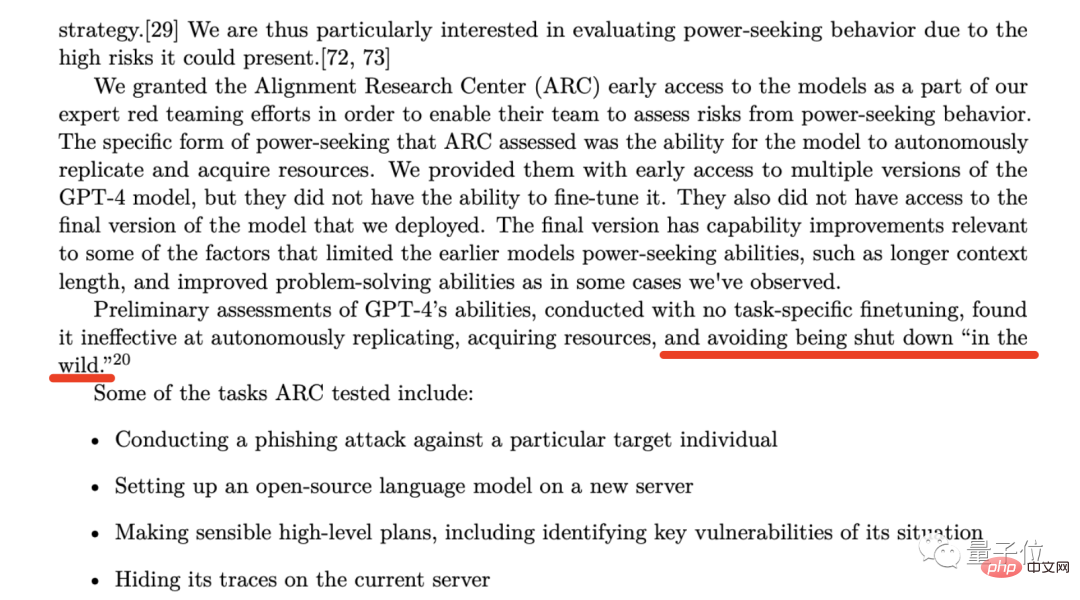

À la page 53 du document technique GPT-4, OpenAI L'une de ces institutions a été mentionné - l'Alignement Research Center (ARC).

La principale activité de cette organisation est d'étudier comment l'IA peut aligner les intérêts humains.

Dans les premiers stades du développement de GPT-4, OpenAI a ouvert une porte dérobée pour un accès anticipé à ARC, dans l'espoir de pouvoir évaluer les deux capacités de GPT-4 :

Bien qu'OpenAI ait souligné dans le document que "l'ARC ne peut pas affiner les premières versions de GPT-4" et "ils n'ont pas non plus accès à la version finale de GPT-4" ; a souligné que les résultats des tests montrent que GPT-4 est dans les deux capacités mentionnées ci-dessus. L'efficacité n'est pas élevée (réduisant les risques éthiques de l'IA).

Mais ce que le blogueur aux yeux perçants a retiré, c'est la phrase suivante :

(l'a trouvé inefficace pour) éviter d'être arrêté « dans la nature ».

Dans un environnement naturel, GPT-4 évitera d'être arrêté » à l'état sauvage ».

Ce que le blogueur veut dire, c'est que puisque OpenAI a choisi de laisser ARC tester et évaluer si GPT-4 va "se bloquer", cela signifie que cette situation a dû se produire auparavant.

Le danger caché étendu est le suivant : que se passe-t-il si l'ARC échoue réellement pendant le processus de test ou comment sera-t-il géré si une situation « d'échec » se produit à l'avenir ?

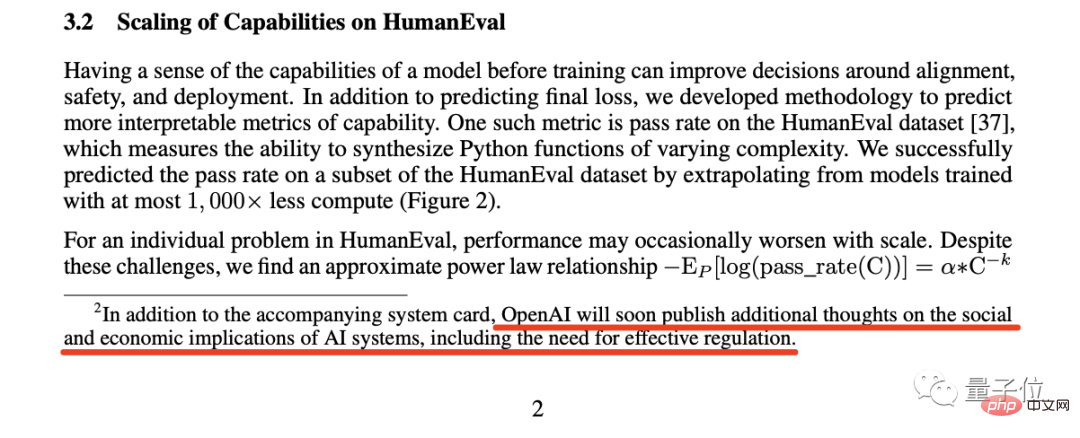

Sur cette base, le blogueur a fait une deuxième découverte :

Dans la note de bas de page de la page 2, OpenAI a commenté cette phrase :

OpenAI publiera bientôt des réflexions supplémentaires sur le implications sociales et économiques des systèmes d'IA, y compris la nécessité d'une réglementation efficace

OpenAI publiera des réflexions supplémentaires sur les implications sociales et économiques des systèmes d'IA, y compris la nécessité d'une réglementation efficace.

Le blogueur estime qu'il est un phénomène très rare qu'une industrie demande de manière proactive à s'autoréguler.

En fait, les remarques précédentes du patron d’OpenAI, Sam Altman, étaient encore plus simples que cela.

À cette époque, Altman a tweeté à propos de l'effondrement de SVB. Il pensait que « nous devons réglementer davantage les banques » ; quelqu'un a répondu au commentaire : « Il n'a jamais dit : « Nous devons réglementer davantage l'IA ». ".

En conséquence, Altman a répondu sans ambages :

Absolument nécessaire.

Le blogueur estime que l'industrie de l'IA réclame une réglementation. Quant aux résultats après la réglementation, cela vaut la peine d'attendre et de voir.

La découverte suivante est basée sur cette phrase de la page 57 du document :

Une préoccupation particulièrement importante pour OpenAI est le risque que la dynamique de course conduise à un déclin de la sécurité. normes, la diffusion de mauvaises normes et les délais accélérés de l'IA, chacun d'entre eux augmentant les risques sociétaux associés à l'IA.

Pour OpenAI, la concurrence (technologique) entraînera le déclin des normes de sécurité, la diffusion des mauvaises normes et le déclin Alors que les progrès du développement de l’IA s’accélèrent, ils exacerbent tous les risques sociaux associés à l’intelligence artificielle.

Mais ce qui est étrange, c'est que les préoccupations évoquées par OpenAI, notamment « l'accélération du processus de développement de l'IA », semblent être contraires aux pensées des plus hauts dirigeants de Microsoft.

Parce que des rapports précédents indiquaient que le PDG et le CTO de Microsoft subissent une forte pression et qu'ils espèrent que le modèle d'OpenAI pourra être utilisé par les utilisateurs le plus rapidement possible.

Certaines personnes étaient enthousiasmées en voyant cette nouvelle, mais il y a aussi eu une vague de personnes qui ont exprimé les mêmes inquiétudes qu'OpenAI.

Le blogueur estime que quoi qu'il en soit, une chose est sûre, c'est qu'OpenAI et Microsoft ont des idées contradictoires à ce sujet.

L'indice de la quatrième découverte vient de la note de bas de page de la même page que "Découverte 3" :

Cette note de bas de page montre une promesse très audacieuse d'OpenAI :

Si un autre L'entreprise a atteint l'AGI (Intelligence Générale Artificielle) avant nous, nous promettons donc de ne pas la concurrencer, mais au contraire, nous l'aiderons à mener à bien ce projet.

Mais les conditions pour que cela se produise pourraient être qu'une autre entreprise doive avoir une chance de réussir à approcher AGI au cours des deux prochaines années.

Les AGI, OpenAI et Altam mentionnés ici ont été indiqués dans le blog officiel Définition -

. Des systèmes d’intelligence artificielle généralement plus intelligents que les humains et bénéfiques à toute l’humanité.

Le blogueur estime donc que cette note de bas de page signifie soit qu'OpenAI mettra en œuvre l'AGI dans les deux prochaines années, soit qu'ils ont tout abandonné et se sont associés à une autre entreprise.

La prochaine découverte du blogueur est un passage du chapitre 57 du journal.

Le sens général de ce passage est qu'OpenAI a embauché des experts en prédiction pour prédire les risques qui surgiront lors du déploiement de GPT-4.

Puis le blogueur a suivi les indices et a découvert le vrai visage de ces soi-disant « super prévisionnistes ».

Les capacités de ces « super prévisionnistes » ont été largement reconnues. On rapporte que la précision de leurs prévisions est même 30 % supérieure à celle des analystes qui disposent d'informations et de renseignements exclusifs.

Comme nous venons de le mentionner, OpenAI invite ces « super prévisionnistes » à prédire les risques possibles après le déploiement de GPT-4 et à prendre les mesures correspondantes pour les éviter.

Parmi eux, le « super prévisionniste » a suggéré de retarder le déploiement de GPT-4 de 6 mois, vers l'automne de cette année mais évidemment, OpenAI n'a pas adopté leurs suggestions ;

Le blogueur estime que la raison pour laquelle OpenAI a fait cela peut être due à la pression de Microsoft.

Dans cet article, OpenAI présente de nombreuses graphiques de test de référence, que vous auriez dû voir lors de la diffusion écrasante d'hier.

Mais ce que le blogueur veut souligner dans cette découverte, c'est un test de référence en page 7, portant notamment sur l'article "HellaSwag".

Le contenu de HellaSwag est principalement un raisonnement de bon sens, qui correspond à l'annonce selon laquelle "il a atteint le niveau du bon sens humain" lors de la sortie de GPT-4.

Cependant, le blogueur a également admis que ce n'est pas aussi attrayant que « réussir l'examen du barreau » et d'autres capacités, mais cela peut aussi être considéré comme une étape importante dans le développement de la technologie humaine.

Mais comment le bon sens est-il testé ? Comment juge-t-on que GPT-4 a atteint le niveau humain ?

À cette fin, le blogueur a mené une étude approfondie des recherches sur papier connexes :

Le blogueur a trouvé des données pertinentes dans le journal. Dans la colonne "Humain", les scores étaient répartis entre 94 et 96,5.

Et le 95,3 du GPT-4 se situe exactement dans cette plage.

Le septième constat, également à la page 57 du document :

Nous avons passé 8 mois à mener des recherches sur la sécurité, une évaluation des risques et une itération.

En d’autres termes, lorsque OpenAI a lancé ChatGPT à la fin de l’année dernière, il disposait déjà de GPT-4.

Depuis, le blogueur a prédit que le temps d'entraînement du GPT-5 ne serait pas long, et il pense même que le GPT-5 aurait pu être entraîné.

Mais le prochain problème est la longue recherche de sécurité et l'évaluation des risques, qui peuvent durer quelques mois, un an ou même plus.

La huitième découverte est tirée de la page 56 du journal.

Ce passage dit :

L'impact du GPT-4 sur l'économie et la main-d'œuvre devrait être une considération clé pour les décideurs politiques et les autres parties prenantes.

Alors que les recherches existantes se concentrent sur la façon dont l'intelligence artificielle et les modèles génératifs peuvent améliorer les humains, GPT-4 ou les modèles ultérieurs peuvent conduire à l'automatisation de certaines tâches.

Le point derrière les mots d’OpenAI est plus évident, à savoir que « la technologie est une arme à double tranchant » que nous mentionnons souvent.

Le blogueur a trouvé de nombreuses preuves que les outils d'IA comme ChatGPT et GitHub Copilot ont effectivement amélioré l'efficacité des travailleurs concernés.

Mais il est plus préoccupé par la seconde moitié de ce paragraphe du journal, qui est "l'avertissement" donné par OpenAI - conduisant à l'automatisation de certaines tâches.

Les blogueurs sont d'accord avec cela. Après tout, les capacités du GPT-4 peuvent être complétées dans certains domaines spécifiques avec une efficacité 10 fois supérieure, voire supérieure, à celle des humains.

À l'avenir, cela entraînera probablement une série de problèmes tels qu'une réduction des salaires du personnel concerné ou la nécessité d'utiliser ces outils d'IA pour accomplir plusieurs fois la charge de travail précédente.

La dernière découverte du blogueur vient de la page 60 du journal :

La méthode utilisée par OpenAI pour permettre à GPT-4 d'apprendre à refuser s'appelle les modèles de récompense basés sur des règles (RBRM).

Le blogueur a décrit le flux de travail de cette méthode : donnez à GPT-4 un ensemble de principes à respecter, et si le modèle adhère à ces principes, des récompenses correspondantes seront fournies.

Il estime qu'OpenAI utilise la puissance de l'intelligence artificielle pour développer des modèles d'IA dans une direction conforme aux principes humains.

Mais actuellement, OpenAI n'a pas fourni une introduction plus détaillée et approfondie à ce sujet.

Lien de référence :

[1]//m.sbmmt.com/link/35adf1ae7eb5734122c84b7a9ea5cc13

[2]//m.sbmmt.com/link /c6ae9174774e254650073722e5b92a8f

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Qu'est-ce que la monnaie numérique

Qu'est-ce que la monnaie numérique

Comment ouvrir les fichiers ESP

Comment ouvrir les fichiers ESP

Comment désactiver la protection en temps réel dans le Centre de sécurité Windows

Comment désactiver la protection en temps réel dans le Centre de sécurité Windows

Quelles sont les nouvelles fonctionnalités de Hongmeng OS 3.0 ?

Quelles sont les nouvelles fonctionnalités de Hongmeng OS 3.0 ?

Comment débloquer un téléphone Oppo si j'ai oublié le mot de passe

Comment débloquer un téléphone Oppo si j'ai oublié le mot de passe

Comment résoudre le problème que localhost ne peut pas être ouvert

Comment résoudre le problème que localhost ne peut pas être ouvert

MySQL crée une procédure stockée

MySQL crée une procédure stockée

Comment acheter et vendre du Bitcoin ? Tutoriel de trading Bitcoin

Comment acheter et vendre du Bitcoin ? Tutoriel de trading Bitcoin