Récemment, de nombreuses percées inattendues ont été réalisées dans le domaine des images générées par du texte, et de nombreux modèles peuvent remplir la fonction de création d'images diversifiées et de haute qualité basées sur des instructions textuelles. Bien que les images générées soient déjà très réalistes, les modèles actuels sont souvent efficaces pour générer des images d'objets physiques tels que des paysages et des objets, mais ont du mal à générer des images avec un degré élevé de détails cohérents, comme les images avec des textes de glyphes complexes tels que des caractères chinois. .

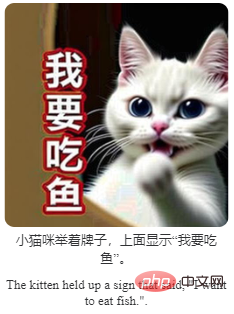

Afin de résoudre ce problème, des chercheurs d'OPPO et d'autres institutions ont proposé un cadre d'apprentissage général GlyphDraw, conçu pour permettre au modèle de générer des images intégrées à un texte cohérent. Il s'agit du premier travail dans le domaine de l'image. synthèse pour résoudre le problème de la génération des caractères chinois.

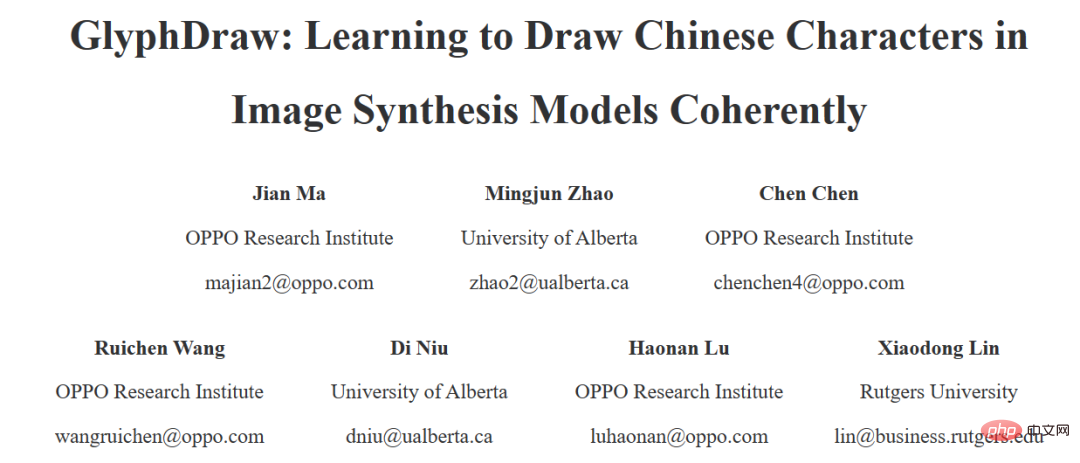

Jetons d'abord un coup d'œil à l'effet de génération. Par exemple, générez un slogan d'avertissement pour le hall d'exposition :

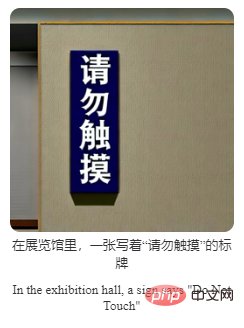

Générez un panneau d'affichage :

Ajoutez un bref texte. description à l'image, texte Les styles peuvent également être diversifiés :

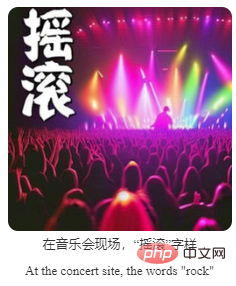

De plus, l'exemple le plus intéressant et le plus pratique est de générer des émoticônes :

Bien que les résultats présentent quelques défauts , l'effet de génération global a été très bon. Dans l'ensemble, les principales contributions de cette recherche comprennent :

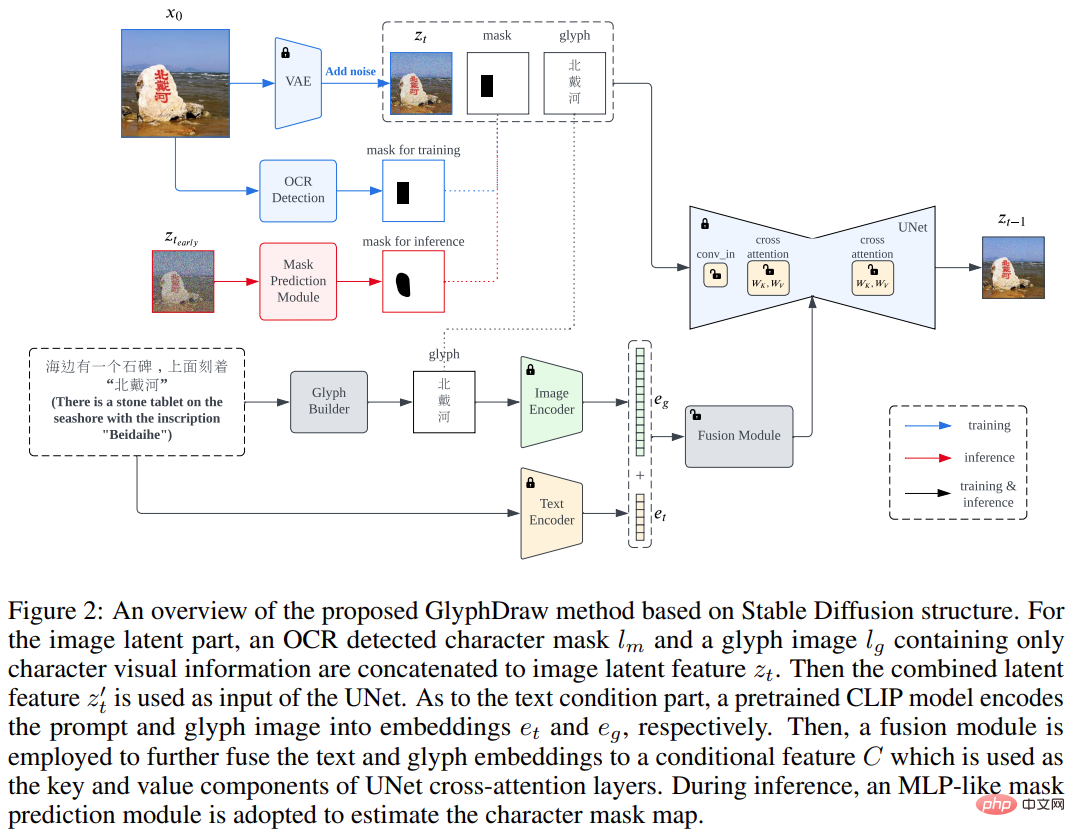

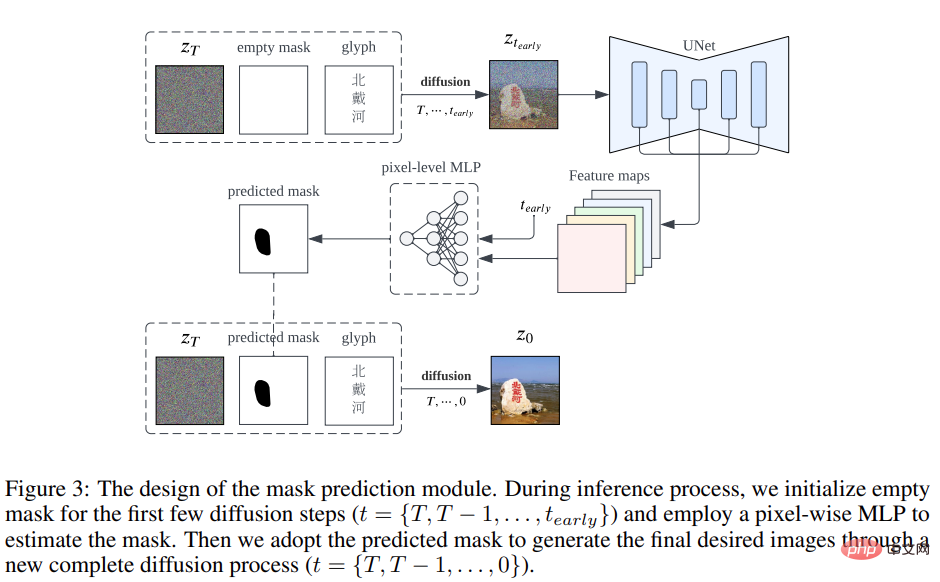

Cette étude a d'abord conçu une stratégie complexe de construction d'ensembles de données image-texte, puis a proposé un cadre d'apprentissage général GlyphDraw basé sur l'algorithme de synthèse d'image open source Stable Diffusion, comme le montre Figure 2 ci-dessous.

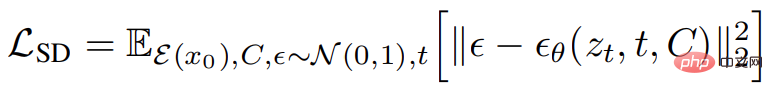

L'objectif global d'entraînement de Stable Diffusion peut être exprimé par la formule suivante :

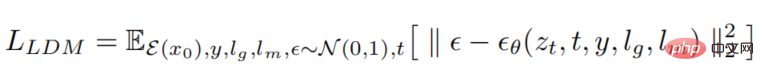

GlyphDraw est basé sur le mécanisme d'attention croisée de Stable Diffusion, où le vecteur latent d'entrée d'origine z_t est remplacé par une concaténation du vecteur latent d'image z_t, du masque de texte l_m et de l'image glyphe l_g.

De plus, la condition C est équipée de fonctionnalités hybrides de glyphe et de texte en utilisant des modules de fusion spécifiques au domaine. L'introduction du masque de texte et des informations sur les glyphes permet à l'ensemble du processus de formation d'obtenir un contrôle de diffusion précis, élément clé pour améliorer les performances du modèle, et de générer finalement des images avec du texte en caractères chinois.

Plus précisément, la représentation en pixels des informations textuelles, en particulier les formes de texte complexes telles que les caractères pictographiques chinois, est très différente de celle des objets naturels. Par exemple, le mot chinois « ciel » est composé de plusieurs traits dans une structure bidimensionnelle, et son image naturelle correspondante est « ciel bleu parsemé de nuages blancs ». En revanche, les caractères chinois ont des caractéristiques très fines, et même de petits mouvements ou déformations peuvent conduire à un rendu de texte incorrect, rendant impossible la génération d'images.

Il existe également un problème clé à prendre en compte lors de l'intégration de caractères dans des arrière-plans d'images naturels, à savoir contrôler avec précision la génération de pixels de texte tout en évitant d'affecter les pixels d'image naturels adjacents. Afin de restituer des caractères chinois parfaits sur des images naturelles, les auteurs ont soigneusement conçu deux composants clés intégrés dans le modèle de synthèse par diffusion, à savoir le contrôle de position et le contrôle des glyphes.

Contrairement à l'entrée conditionnelle globale d'autres modèles, la génération de caractères doit accorder plus d'attention aux zones locales spécifiques de l'image car la distribution des caractéristiques latentes des pixels de caractère est très différente de celle des pixels naturels de l'image. Afin d'éviter l'effondrement de l'apprentissage du modèle, cette étude propose de manière innovante un contrôle de zone de localisation à granularité fine pour découpler la distribution entre les différentes zones.

En plus du contrôle de position, un autre enjeu important est le contrôle fin de la synthèse des traits des caractères chinois. Compte tenu de la complexité et de la diversité des caractères chinois, il est extrêmement difficile d’apprendre simplement à partir de grands ensembles de données image-texte sans aucune connaissance préalable explicite. Afin de générer avec précision des caractères chinois, cette étude intègre des images de glyphes explicites comme informations conditionnelles supplémentaires dans le processus de diffusion du modèle.

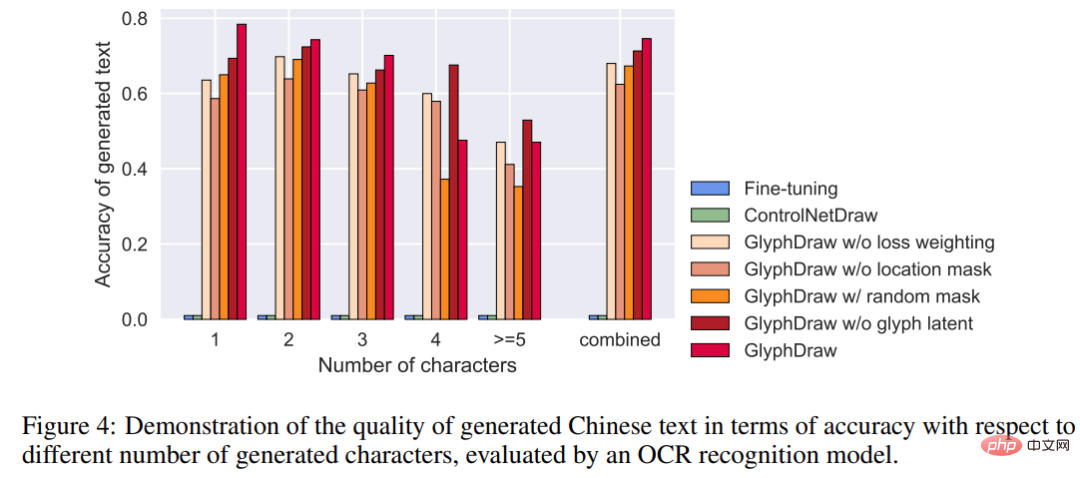

Étant donné qu'il n'existe aucun ensemble de données précédent spécifiquement pour la génération d'images de caractères chinois, cette étude a d'abord construit un ensemble de données de référence ChineseDrawText pour une évaluation qualitative et quantitative, puis a testé et comparé la précision de la génération ChineseDrawText. de plusieurs méthodes (évaluées par le modèle de reconnaissance OCR).

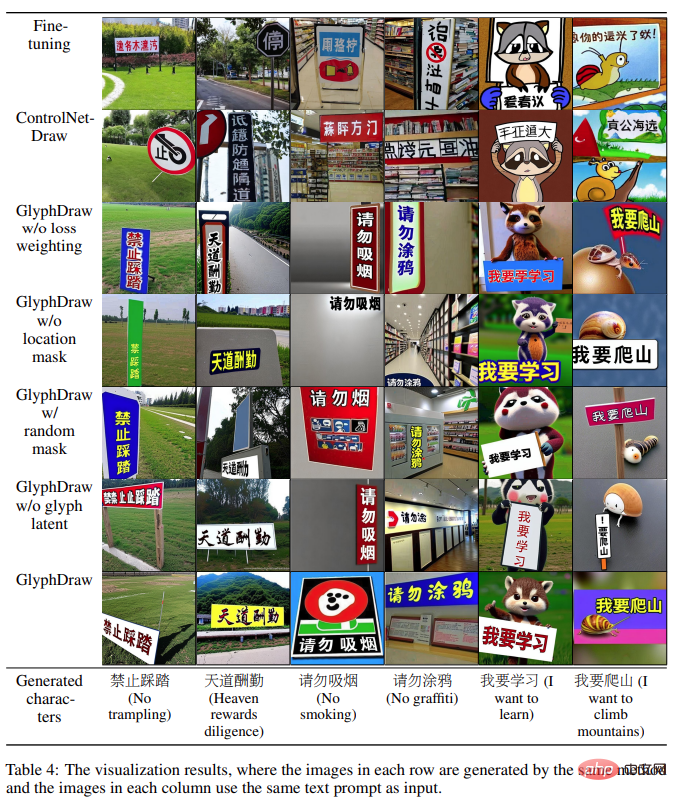

Le modèle GlyphDraw proposé dans cette étude a atteint une précision moyenne de 75 % en utilisant efficacement les informations auxiliaires de glyphe et de position, démontrant ainsi les excellentes capacités de génération d'images de caractères du modèle. Les résultats de la comparaison visuelle de plusieurs méthodes sont présentés dans la figure ci-dessous :

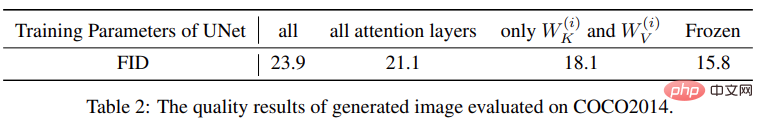

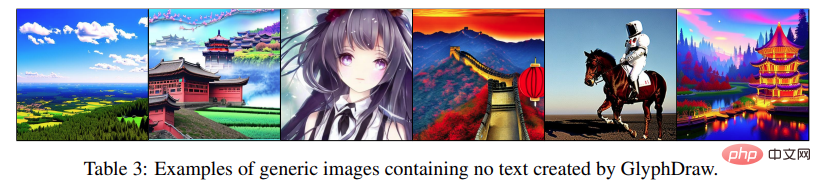

De plus, GlyphDraw peut également maintenir les performances de synthèse d'images en domaine ouvert en limitant les paramètres de formation du FID de synthèse d'images générale sur MS-COCO FID-. 10k n'est diminué que de 2,3.

Les lecteurs intéressés peuvent lire le texte original de l'article pour en savoir plus sur la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Solution en cas d'échec de session

Solution en cas d'échec de session

Comment définir un écran large ppt

Comment définir un écran large ppt

Les étincelles Douyin peuvent-elles être rallumées si elles sont éteintes depuis plus de trois jours ?

Les étincelles Douyin peuvent-elles être rallumées si elles sont éteintes depuis plus de trois jours ?

Pourquoi vue.js signale-t-il une erreur ?

Pourquoi vue.js signale-t-il une erreur ?

Que faire si votre adresse IP est attaquée

Que faire si votre adresse IP est attaquée

La différence entre le compte de service WeChat et le compte officiel

La différence entre le compte de service WeChat et le compte officiel

entrée du site officiel de msdn

entrée du site officiel de msdn

La différence entre fprintf et printf

La différence entre fprintf et printf