Auteur | Migüel Jetté

Compilé | bluemin

Éditeur | Chen Caixian

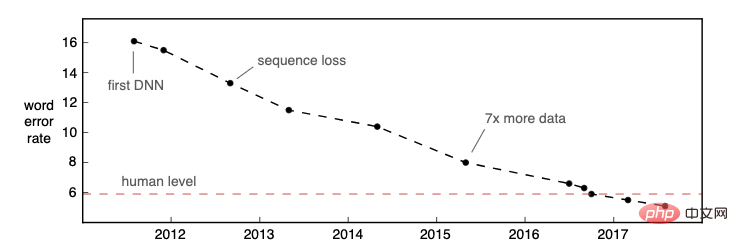

Au cours des deux dernières années, la reconnaissance automatique de la parole (Automatic Speech Recognition, ASR) a connu un développement important dans l'utilisation commerciale. Plusieurs modèles ASR au niveau de l'entreprise entièrement basés sur des réseaux de neurones ont été lancés avec succès, tels qu'Alexa, Rev, AssemblyAI, ASAPP, etc. En 2016, Microsoft Research a publié un article annonçant que son modèle avait atteint des performances de niveau humain (mesurées par le taux d'erreur de mots) sur l'ensemble de données « Switchboard » vieux de 25 ans. La précision de l'ASR continue de s'améliorer, atteignant des performances de niveau humain sur davantage d'ensembles de données et de cas d'utilisation.

Source de l'image : article de blog d'Awni Hannun "La reconnaissance vocale n'est pas résolue"

Comme la précision de la reconnaissance de la technologie ASR s'est considérablement améliorée et que les scénarios d'application sont devenus de plus en plus abondants, nous pensons que : ce n'est pas le cas maintenant l'apogée de l'utilisation commerciale de l'ASR, la recherche et les applications commerciales dans ce domaine restent à explorer. Nous prévoyons que la recherche et les systèmes commerciaux liés à l'IA vocale se concentreront sur les cinq domaines suivants au cours des dix prochaines années :

"Au cours des dix prochaines années, nous déploierons de véritables modèles ASR. dans les environnements de production Des modèles multilingues qui permettent aux développeurs de créer des applications que tout le monde peut comprendre dans n'importe quelle langue, libérant véritablement la puissance de la reconnaissance vocale dans le monde entier »

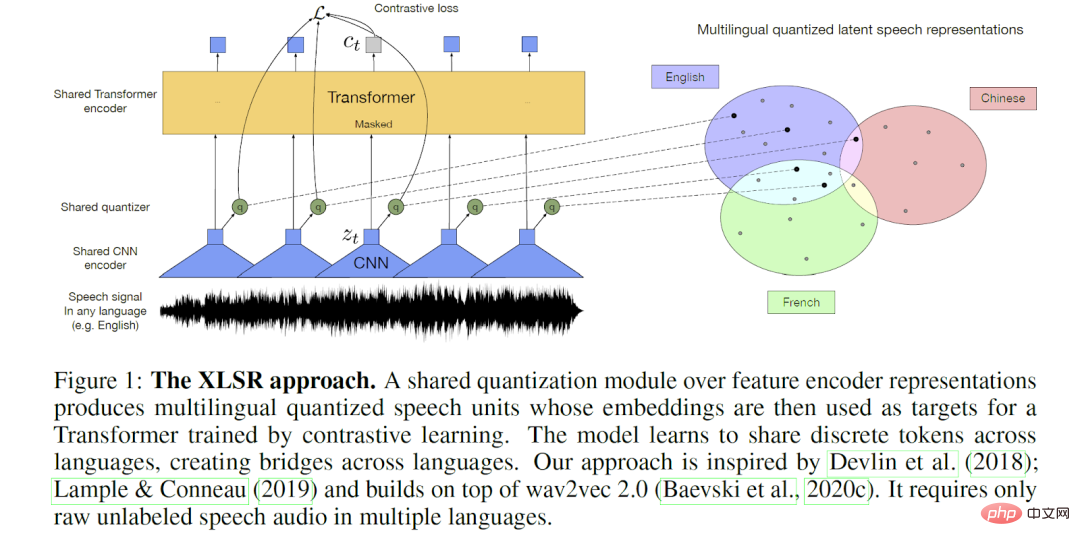

Source : Alexis Conneau et al. article d'apprentissage de représentation pour la reconnaissance vocale

Les modèles ASR commerciaux d'aujourd'hui utilisent principalement des ensembles de données en anglais pour la formation, ils ont donc une plus grande précision pour la saisie en anglais. L’anglais suscite un plus grand intérêt à long terme dans le monde universitaire et industriel en raison de la disponibilité des données et de la demande du marché. Bien que la précision de reconnaissance des langues commerciales populaires telles que le français, l'espagnol, le portugais et l'allemand soit également raisonnable, il existe clairement une longue traîne de langues avec des données de formation limitées et une qualité de sortie ASR relativement faible.

De plus, la plupart des systèmes d'entreprise sont basés sur un seul langage, qui ne peut pas être appliqué aux scénarios multilingues propres à de nombreuses sociétés. Le multilinguisme peut prendre la forme de langues dos à dos, comme la programmation médiatique dans les pays bilingues. Amazon a fait de grands progrès pour résoudre ce problème en lançant récemment un produit intégrant l'identification de la langue (LID) et l'ASR. En revanche, le translangage (également connu sous le nom de changement de code) est un système linguistique utilisé par un individu pour combiner des mots et la grammaire de deux langues dans la même phrase. C’est un domaine dans lequel le monde universitaire continue de faire des progrès intéressants.

Tout comme le domaine du traitement du langage naturel adopte une approche multilingue, nous verrons l’ASR emboîter le pas au cours de la prochaine décennie. À mesure que nous apprendrons à tirer parti des technologies émergentes de bout en bout, nous formerons des modèles multilingues à grande échelle capables de transférer l’apprentissage entre plusieurs langues. Le XLS-R de Meta en est un bon exemple : dans une démo, les utilisateurs pouvaient parler n'importe laquelle des 21 langues sans spécifier de langue, et le modèle serait finalement traduit en anglais. En comprenant et en appliquant les similitudes entre les langues, ces systèmes ASR plus intelligents fourniront une disponibilité ASR de haute qualité pour les cas d'utilisation de langues à faibles ressources et de langues mixtes et permettront des applications de qualité commerciale.

« Au cours de la prochaine décennie, nous pensons que les systèmes ASR commerciaux produiront des objets de transcription plus riches contenant plus que de simples mots. De plus, nous prévoyons que cette sortie plus riche sera reconnue. par des organismes de normalisation tels que le W3C afin que toutes les API renvoient des résultats construits de manière similaire. Cela libérera davantage le potentiel des applications vocales pour tout le monde dans le monde

" Bien que le National Institute of Standards and Technology (NIST). Il y a un long chemin à parcourir. tradition d'exploration de la « transcription riche », mais les efforts visant à l'incorporer dans des formats standardisés et évolutifs pour la sortie ASR sont encore relativement superficiels. Le concept de transcription riche impliquait initialement la majuscule, la ponctuation et la journalisation, mais s'est dans une certaine mesure étendu aux rôles du locuteur et à une gamme d'événements vocaux non verbaux. Les innovations attendues incluent la transcription de discours superposés de différents locuteurs, d'émotions variables et d'autres caractéristiques paralinguistiques, ainsi qu'une gamme de scènes et d'événements de parole non linguistiques, voire non humains, ainsi que la transcription de la diversité textuelle ou linguistique. Tanaka et al. décrivent un scénario dans lequel un utilisateur peut souhaiter choisir parmi des options de transcription de richesse variable, et évidemment la quantité et la nature des informations supplémentaires que nous prévoyons sont spécifiables, en fonction de l'application en aval.

Les systèmes ASR traditionnels sont capables de générer une grille de multiples hypothèses dans le processus de reconnaissance des mots prononcés, ce qui s'est avéré très utile dans la transcription assistée par l'homme, les systèmes de dialogue parlé et la recherche d'informations. L'inclusion des n meilleures informations dans un format de sortie riche encouragera davantage d'utilisateurs à utiliser le système ASR, améliorant ainsi l'expérience utilisateur. Bien qu'il n'existe actuellement aucune norme pour structurer ou stocker les informations supplémentaires actuellement ou potentiellement générées lors du décodage vocal, l'Open Speech Transcription Standard (OVTS) de CallMiner constitue une étape solide dans cette direction, permettant aux entreprises d'explorer et de choisir facilement plusieurs fournisseurs ASR.

Nous prévoyons qu'à l'avenir, les systèmes ASR produiront des sorties plus riches dans des formats standard, permettant des applications en aval plus puissantes. Par exemple, un système ASR peut générer l'ensemble complet des maillages possibles, et une application peut utiliser ces données supplémentaires pour effectuer une transcription automatisée intelligente lors de l'édition de la transcription. De même, les transcriptions ASR qui incluent des métadonnées supplémentaires telles que les dialectes régionaux détectés, les accents, le bruit ambiant ou l'humeur peuvent permettre des applications de recherche plus puissantes.

« Au cours de cette décennie, l'ASR à grande échelle (c'est-à-dire privatisée, abordable, fiable et rapide) fera partie de la vie quotidienne de chacun. capable de rechercher des vidéos, d'indexer tous les contenus médiatiques auxquels nous participons et de rendre chaque vidéo accessible aux consommateurs malentendants du monde entier. ASR sera la clé pour rendre chaque audio et vidéo accessible et exploitable. "

.

Nous utilisons peut-être tous beaucoup de logiciels audio et vidéo : podcasts, streaming sur les réseaux sociaux, vidéos en ligne, discussions de groupe en temps réel, réunions Zoom, etc. Pourtant, le contenu pertinent est rarement retranscrit dans la pratique. Aujourd'hui, la transcription de contenu est devenue l'un des plus grands marchés pour les API ASR et connaîtra une croissance exponentielle au cours de la prochaine décennie, notamment en raison de leur précision et de leur prix abordable. Cela dit, la transcription ASR n'est actuellement utilisée que pour des applications spécifiques (diffusion vidéo, certaines conférences et podcasts, etc.). En conséquence, de nombreuses personnes ne peuvent pas accéder à ces contenus médiatiques et ont du mal à trouver des informations pertinentes après une diffusion ou un événement.

À l’avenir, cette situation va changer. Comme Matt Thompson l'avait prédit en 2010, à un moment donné, l'ASR deviendra suffisamment bon marché et suffisamment répandu pour que nous puissions expérimenter ce qu'il a appelé la « capacité de parole ». Nous prévoyons qu’à l’avenir, presque tous les contenus audio et vidéo seront transcrits et rendus instantanément accessibles, stockables et consultables à grande échelle. Mais le développement de l’ASR ne s’arrêtera pas là, nous espérons également que ces contenus seront exploitables. Nous espérons que chaque audio et vidéo consommé ou utilisé fournira un contexte supplémentaire, tel que des informations générées automatiquement à partir d'un podcast ou d'une conférence, ou un résumé automatique des moments clés de la vidéo, etc. Nous espérons que les systèmes NLP pourront routiniser le traitement ci-dessus.

« D'ici la fin de ce siècle, nous aurons des systèmes ASR évolutifs qui sont comme un organisme vivant, apprenant constamment avec l'aide humaine ou l'autosupervision. Apprenez à partir de différents canaux dans le monde réel, comprenez de nouveaux mots et variantes linguistiques en temps réel plutôt que de manière asynchrone, auto-débogez et surveillez automatiquement différentes utilisations »

À mesure que l'ASR devient courant et couvre de plus en plus de cas d'utilisation. la collaboration homme-machine jouera un rôle clé. La formation du modèle ASR le reflète bien. Aujourd'hui, les ensembles de données open source et les modèles pré-entraînés réduisent les barrières à l'entrée pour les fournisseurs ASR. Cependant, le processus de formation reste assez simple : collecter des données, annoter les données, entraîner le modèle, évaluer les résultats, améliorer le modèle. Mais il s’agit d’un processus lent et, dans de nombreux cas, sujet aux erreurs en raison de difficultés de réglage ou de données insuffisantes. Garnerin et al. ont observé que l'absence de métadonnées et les incohérences dans la représentation entre les corpus rendent difficile la garantie d'une précision égale dans les performances ASR, ce qui est également le problème que Reid et Walker ont tenté de résoudre lors du développement de la norme de métadonnées.

À l'avenir, les humains superviseront efficacement la formation ASR grâce à des moyens intelligents et joueront un rôle de plus en plus important dans l'accélération de l'apprentissage automatique. Les approches humaines dans la boucle placent les évaluateurs humains dans la boucle d'apprentissage automatique/de rétroaction, permettant un examen et un ajustement continus des résultats du modèle. Cela rendra l’apprentissage automatique plus rapide et plus efficace, ce qui se traduira par une production de meilleure qualité. Plus tôt cette année, nous avons discuté de la manière dont les améliorations apportées à l'ASR permettraient aux transcripteurs humains de Rev (appelés « Revvers ») d'effectuer une post-édition des brouillons ASR, les rendant ainsi plus productifs. La transcription de Revver peut être directement entrée dans le modèle ASR amélioré, formant ainsi un cercle vertueux.

Un domaine dans lequel les experts en langage humain font partie intégrante de l'ASR est la normalisation de texte inverse (ITN), dans laquelle ils convertissent les chaînes reconnues (comme « cinq dollars ») dans leur forme écrite attendue (comme « 5 $ »). Pusateri et al. ont proposé une approche hybride utilisant « des modèles grammaticaux et statistiques faits à la main », et Zhang et al.

« Comme tous les systèmes d'intelligence artificielle, les futurs systèmes ASR adhéreront à des principes éthiques plus stricts en matière d'intelligence artificielle afin que le système traite tout le monde de manière égale et ait un degré plus élevé d'explicabilité. et respecter la vie privée des utilisateurs et de leurs données. »

Les futurs systèmes ASR suivront les quatre principes de l'éthique de l'intelligence artificielle : l'équité, l'explicabilité, le respect de la vie privée et la responsabilité.

Équité : un système ASR équitable peut reconnaître la parole quels que soient les antécédents, le statut socio-économique ou d'autres caractéristiques de l'orateur. Il convient de noter que la construction d'un tel système nécessite d'identifier et de réduire les biais dans nos modèles et nos données de formation. Heureusement, les gouvernements, les ONG et les entreprises travaillent déjà à créer l’infrastructure nécessaire pour identifier et atténuer les préjugés.

Interprétabilité : les systèmes ASR ne seront plus des « boîtes noires » : ils expliqueront la collecte et l'analyse des données, les performances du modèle et les processus de sortie selon les besoins. Cette exigence de transparence supplémentaire permet une meilleure surveillance humaine de la formation et des performances des modèles. Comme Gerlings et al., nous envisageons l'interprétabilité du point de vue d'un large éventail de parties prenantes (notamment les chercheurs, les développeurs, les clients et, dans le cas de Rev, les transcripteurs). Les chercheurs voudront peut-être connaître la raison de la sortie d'un texte erroné afin d'atténuer le problème ; tandis que les transcripteurs voudront peut-être des preuves de la raison pour laquelle ASR pense qu'il agit ainsi pour les aider à évaluer son efficacité, en particulier dans les situations bruyantes où l'ASR peut être plus efficace que les personnes. "entendre" mieux. Weitz et al. ont fait des premiers pas importants vers l'interprétabilité pour les utilisateurs finaux dans le contexte de la reconnaissance de mots clés audio. Laguarta et Subirana ont incorporé l'interprétation guidée par un clinicien dans un système de biomarqueurs de la parole pour la détection de la maladie d'Alzheimer.

Respect de la vie privée : la « voix » est considérée comme des « données personnelles » en vertu de diverses lois américaines et internationales. Par conséquent, la collecte et le traitement des enregistrements vocaux sont soumis à une stricte protection de la vie privée. Chez Rev, nous fournissons déjà des capacités de sécurité et de contrôle des données, et les futurs systèmes ASR respecteront davantage la confidentialité des données des utilisateurs et celle des modèles. Dans de nombreux cas, cela impliquera très probablement de pousser le modèle ASR vers la périphérie (sur l'appareil ou le navigateur). Les défis liés à la confidentialité de la voix stimulent la recherche dans ce domaine, et de nombreuses juridictions, comme l'Union européenne, ont lancé des efforts législatifs. Le domaine de l’apprentissage automatique préservant la confidentialité promet d’attirer l’attention sur cet aspect critique de la technologie afin qu’elle puisse être largement acceptée et approuvée par le public.

Responsabilité : Nous surveillerons le système ASR pour nous assurer qu'il respecte les trois premiers principes. Cela nécessite à son tour un investissement en ressources et en infrastructures pour concevoir et développer les systèmes de surveillance nécessaires et pour prendre des mesures en réponse aux conclusions. Les entreprises déployant des systèmes ASR seront responsables de leur utilisation de la technologie et déploieront des efforts spécifiques pour adhérer aux principes éthiques de l’ASR. Il convient de mentionner que les humains, en tant que concepteurs, mainteneurs et consommateurs de systèmes ASR, seront responsables de la mise en œuvre et de l’application de ces principes – encore un autre exemple de collaboration homme-machine.

Lien de référence : https://thegradient.pub/the-future-of-speech-recognition/https://awni.github.io/speech-recognition/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Comment enregistrer un e-mail professionnel

Comment enregistrer un e-mail professionnel

La différence entre injectif et surjectif

La différence entre injectif et surjectif

Téléchargement de l'application Ouyi

Téléchargement de l'application Ouyi

Mot de passe WiFi

Mot de passe WiFi

Le jeton de connexion n'est pas valide

Le jeton de connexion n'est pas valide

Comment utiliser les macros Excel

Comment utiliser les macros Excel

Qu'est-ce qu'un fichier de dump ?

Qu'est-ce qu'un fichier de dump ?