Le plus grand modèle de langage protéique à ce jour a été publié !

Il y a un an, AlphaFold2, l’open source de DeepMind, a été lancé dans Nature et Science, bouleversant les cercles universitaires de la biologie et de l’IA.

Un an plus tard, Meta est arrivé avec ESMFold, qui était un ordre de grandeur plus rapide.

Non seulement il est rapide, mais le modèle comporte également 15 milliards de paramètres.

LeCun a tweeté pour faire l'éloge, il s'agit d'une belle nouvelle réalisation de l'équipe protéique Meta-FAIR.

Le co-auteur Zeming Lin a révélé que le grand modèle avec 3 milliards de paramètres a été formé sur 256 GPU pendant 3 semaines, tandis qu'ESMfold a pris 10 jours sur 128 GPU. Quant à la version à 15 milliards de paramètres, elle n'est toujours pas claire.

Il a également dit que le code sera définitivement open source plus tard, alors restez à l'écoute !

Aujourd'hui, notre protagoniste est ESMFold, un modèle qui prédit directement la structure de haute précision, de bout en bout, au niveau atomique à partir de séquences protéiques individuelles.

Adresse papier : https://www.biorxiv.org/content/10.1101/2022.07.20.500902v1

Inutile de dire les avantages apportés par 15 milliards de paramètres - grâce à la formation, les grands modèles d'aujourd'hui peuvent prédire les trois -structure dimensionnelle des protéines avec une précision de taille atomique.

En termes de précision, ESMFold est presque le même qu'AlphaFold2 et RoseTTAFold.

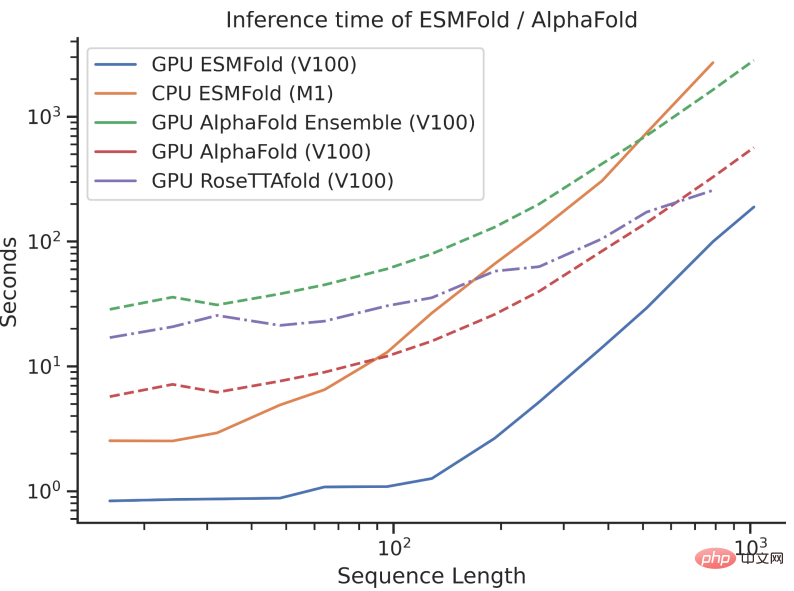

Cependant, la vitesse d'inférence d'ESMFold est d'un ordre de grandeur plus rapide que celle d'AlphaFold2 !

Il peut être difficile de comprendre la comparaison de vitesse entre les trois en parlant d'ordre de grandeur. Il suffit de regarder l'image ci-dessous pour comprendre.

Bien qu'AlphaFold2 et RoseTTAFold aient obtenu un succès révolutionnaire sur le problème de la prédiction de la structure par résolution atomique, ils s'appuient également sur l'utilisation d'alignements de séquences multiples (MSA) et de modèles de structure protéique similaires pour obtenir des performances optimales.

En revanche, en tirant parti de la représentation interne du modèle de langage, ESMFold peut générer des prédictions de structure correspondantes en utilisant une seule séquence comme entrée, accélérant ainsi considérablement la prédiction de structure.

Les chercheurs ont découvert que les prédictions d’ESMFold pour les séquences de faible complexité étaient comparables aux modèles de pointe actuels.

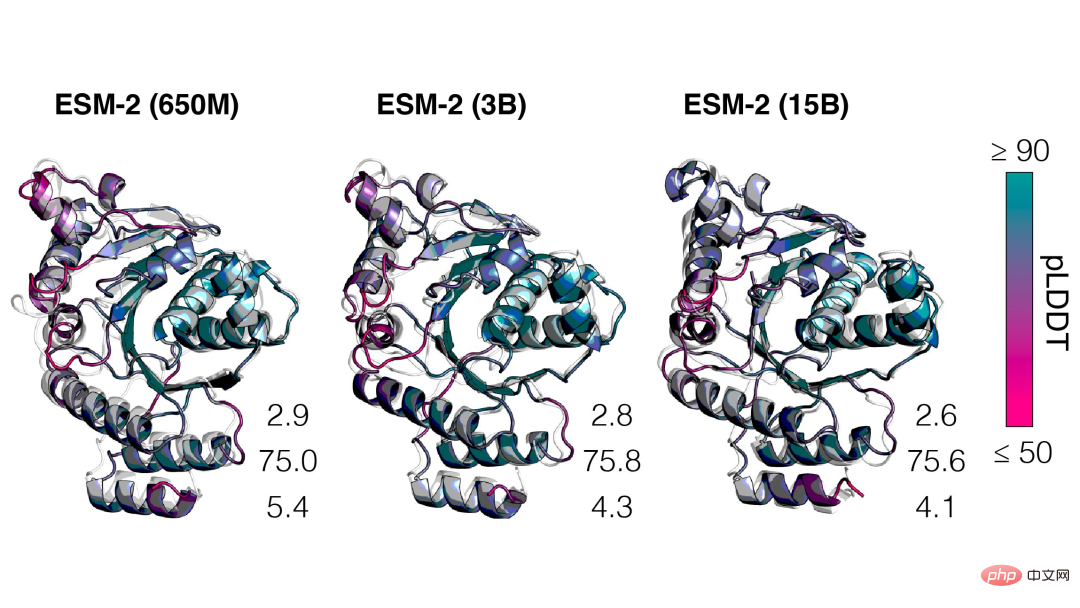

De plus, la précision de la prédiction de la structure est étroitement liée à la complexité du modèle de langage, c'est-à-dire que lorsque le modèle de langage peut mieux comprendre la séquence, il peut mieux comprendre la structure.

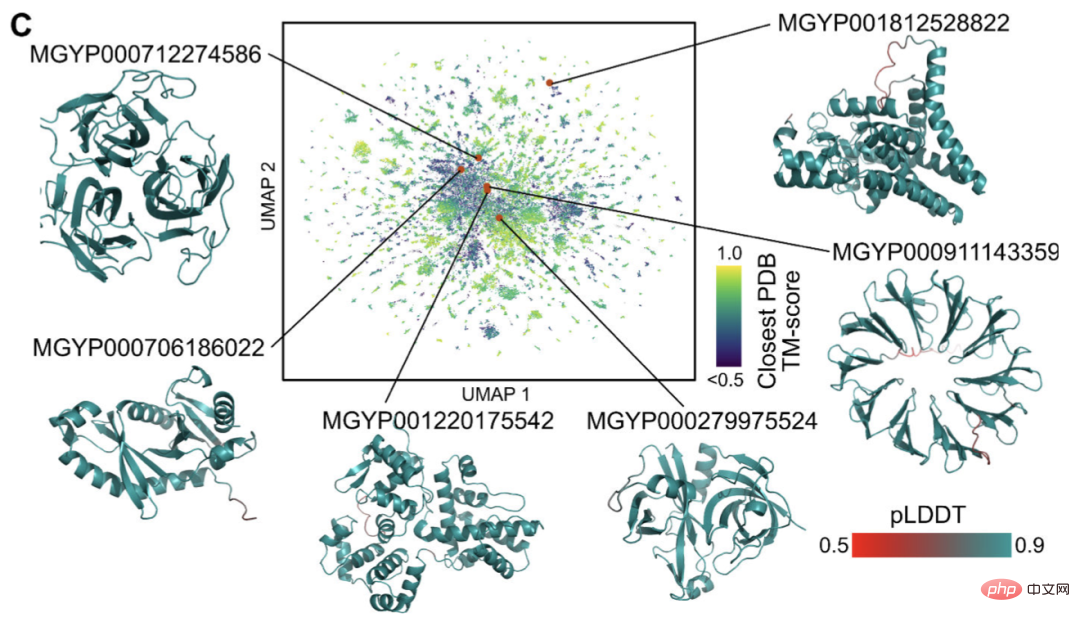

Actuellement, il existe des milliards de séquences protéiques de structure et de fonction inconnues, dont beaucoup sont dérivées du séquençage métagénomique.

Grâce à ESMFold, les chercheurs peuvent plier un échantillon aléatoire de 1 million de séquences métagénomiques en seulement 6 heures.

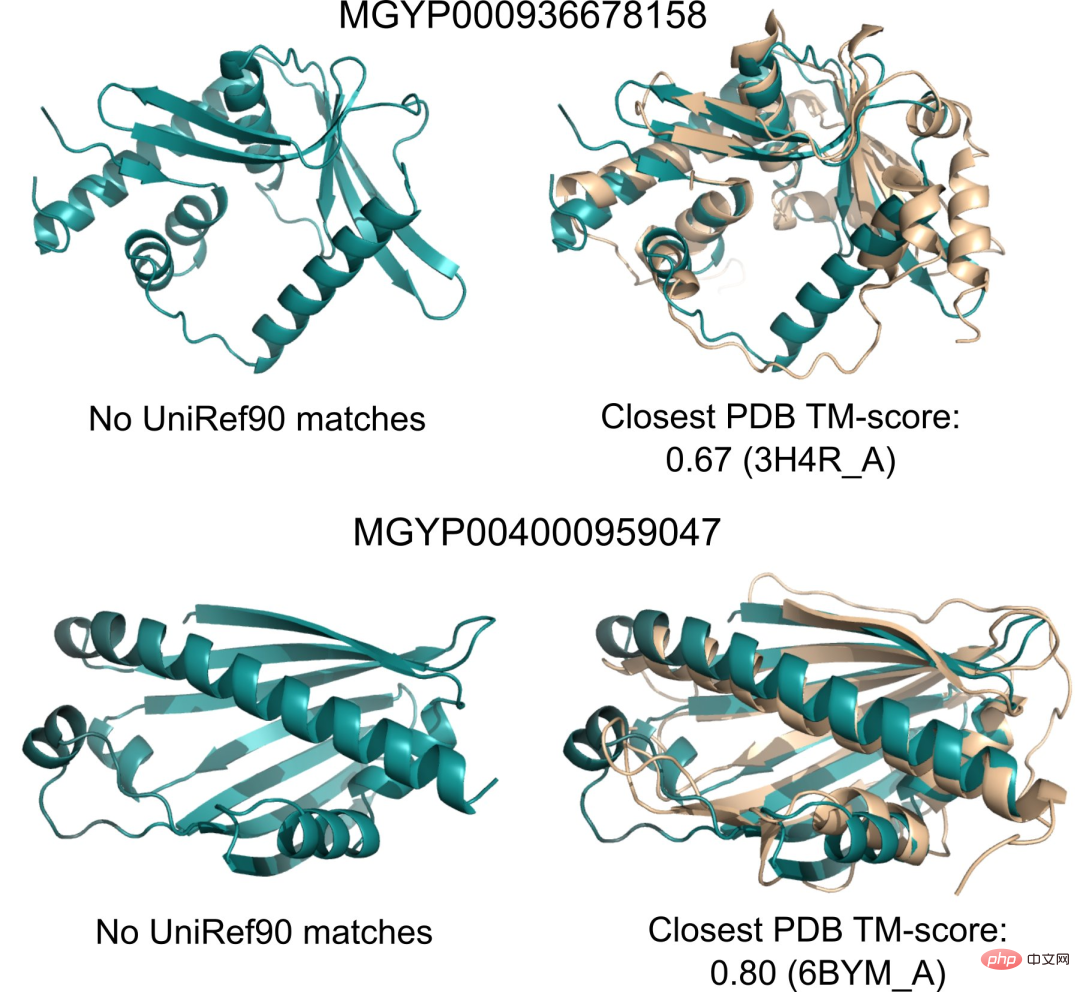

Une grande partie d'entre eux ont un niveau de confiance élevé et ne ressemblent à aucune structure connue (n'ont aucun enregistrement dans la base de données).

Les chercheurs pensent qu’ESMFold peut aider à comprendre les structures protéiques qui dépassent la compréhension actuelle.

De plus, comme les prédictions d'ESMFold sont d'un ordre de grandeur plus rapides que les modèles existants, les chercheurs peuvent utiliser ESMFold pour aider à combler le fossé entre les bases de données de séquences protéiques à croissance rapide et les bases de données sur la structure et la fonction des protéines à croissance plus lente.

Parlons ensuite en détail du nouvel ESMFold de Meta.

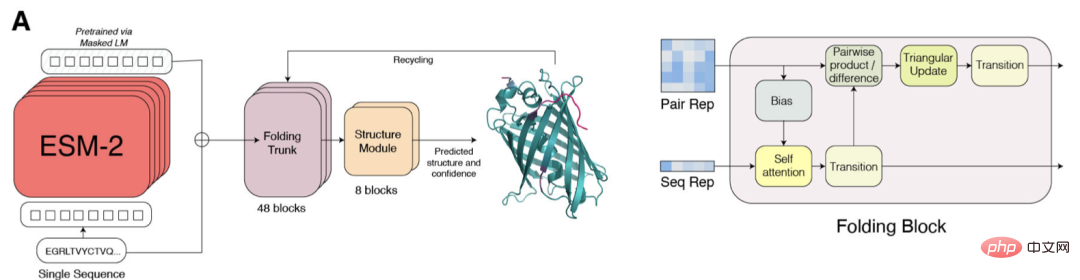

ESM-2 est un modèle de langage basé sur Transformer et utilise un mécanisme d'attention pour apprendre les modèles d'interaction entre les paires d'acides aminés dans la séquence d'entrée.

Par rapport au modèle de génération précédente ESM-1b, Meta a amélioré la structure du modèle et les paramètres de formation, et ajouté des ressources et des données informatiques. Dans le même temps, l’ajout de l’intégration de positions relatives permet de généraliser le modèle à des séquences de n’importe quelle longueur.

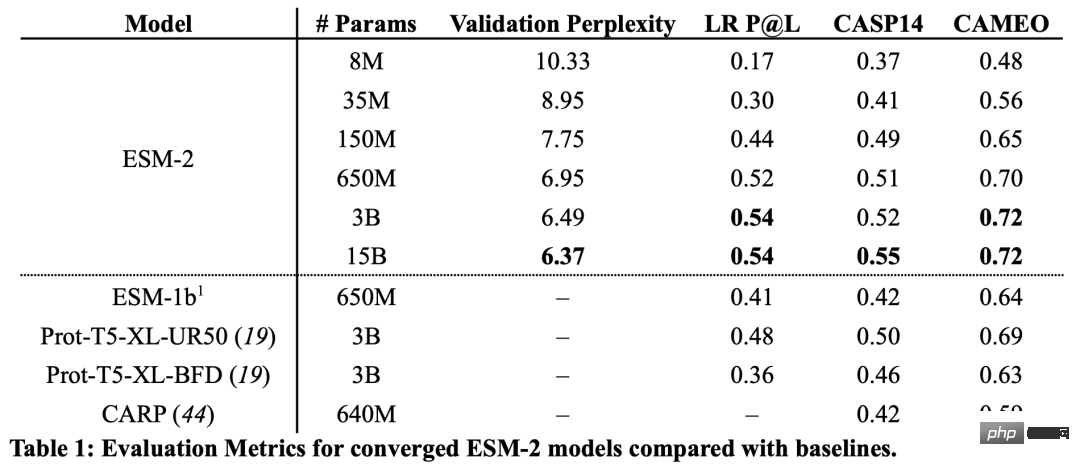

D'après les résultats, le modèle ESM-2 avec 150 millions de paramètres a mieux fonctionné que le modèle ESM-1b avec 650 millions de paramètres.

De plus, ESM-2 surpasse également les autres modèles de langage protéique en termes de prédiction de structure. Cette amélioration des performances est cohérente avec les modèles établis dans le domaine de la modélisation linguistique à grande échelle.

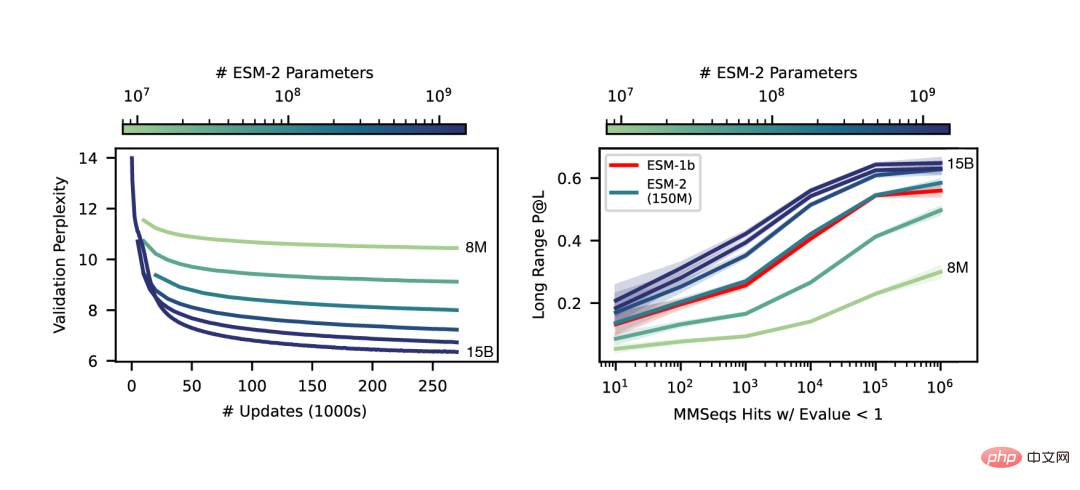

À mesure que l'échelle d'ESM-2 augmente, une grande amélioration de la précision de la modélisation du langage peut être observée.

Une différence clé entre SMFold et AlphaFold2 est que ESMFold utilise la représentation de modèle de langage, éliminant le besoin de séquences homologues explicites (sous forme de MSA) en entrée.

ESMFold simplifie l'Evoformer dans AlphaFold2 en remplaçant le module réseau coûteux en termes de calcul qui gère MSA par un module Transformer qui gère les séquences. Cette simplification signifie qu'ESMFold est nettement plus rapide que les modèles basés sur MSA.

La sortie du squelette replié est ensuite traitée par un module de structure, qui est responsable de la sortie de la structure finale au niveau atomique et de la confiance des prédictions.

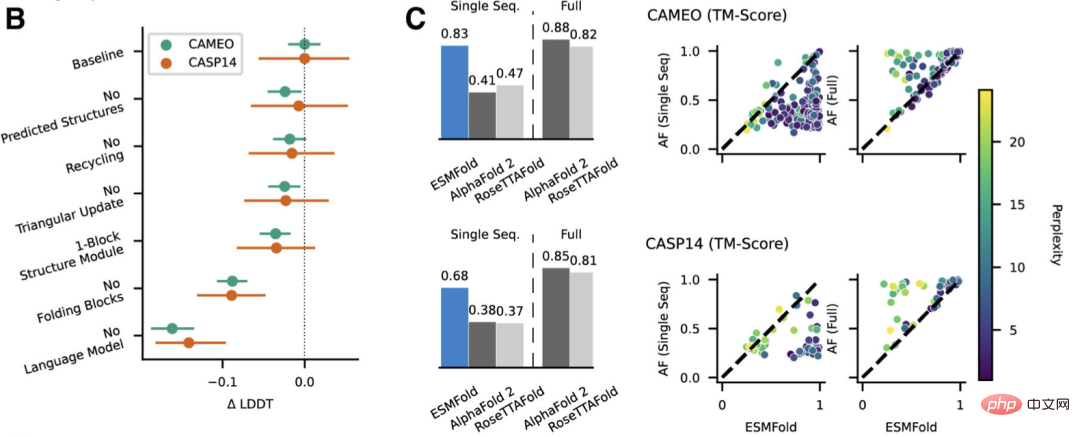

Les chercheurs ont comparé ESMFold avec AlphaFold2 et RoseTTAFold sur les ensembles de tests CAMEO (avril 2022 à juin 2022) et CASP14 (mai 2020).

Lorsqu'une seule séquence est donnée en entrée, ESMFold fonctionne bien mieux qu'Alphafold 2.

Et en utilisant le pipeline complet, AlphaFold2 a obtenu respectivement 88,3 et 84,7 sur CAMEO et CASP14. ESMFold atteint une précision comparable à RoseTTAfold sur CAMEO, avec un score TM moyen de 82,0.

Les chercheurs ont découvert qu'un modèle de langage ciblant l'apprentissage non supervisé, formé sur une vaste base de données de séquences protéiques évolutivement diverses, était capable de prédire la structure des protéines à une résolution au niveau atomique.

En élargissant les paramètres du modèle de langage à 15B, l'impact de l'échelle sur l'apprentissage de la structure des protéines peut être systématiquement étudié.

Nous voyons que la courbe non linéaire des prédictions de la structure des protéines est fonction de la taille du modèle et observons un lien étroit entre la façon dont un modèle de langage comprend une séquence et ses prédictions de structure.

Les modèles de la série ESM-2 sont les plus grands modèles de langage protéique formés à ce jour, avec seulement un ordre de grandeur en moins de paramètres que les plus grands modèles de texte récemment développés.

De plus, ESM-2 constitue une très grande amélioration par rapport au modèle précédent, même à 150 millions de paramètres, ESM-2 capture une carte structurelle plus précise que le modèle de langage de la génération ESM-1 à 650 millions de paramètres.

Les chercheurs ont déclaré que le principal moteur des performances d'ESMFold est le modèle de langage. Parce qu’il existe un lien étroit entre la perplexité des modèles de langage et l’exactitude des prédictions de structure, ils ont découvert que lorsque l’ESM-2 peut mieux comprendre les séquences protéiques, il peut réaliser des prédictions comparables aux modèles de pointe actuels.

ESMFold a obtenu une prédiction précise de la structure de résolution atomique, et le temps d'inférence est d'un ordre de grandeur plus rapide qu'AlphaFold2.

En pratique, l’avantage de vitesse est encore plus grand. Parce qu'ESMFold n'a pas besoin de rechercher des séquences liées à l'évolution pour construire le MSA.

Bien qu'il existe des moyens plus rapides de réduire le temps de recherche, celui-ci peut rester très long, quelle que soit la manière dont vous le réduisez.

Les avantages apportés par le temps d'inférence considérablement réduit sont évidents : l'augmentation de la vitesse permettra de cartographier l'espace structurel de grandes bases de données de séquences métagénomiques.

En plus des outils basés sur la structure pour identifier l'homologie et la conservation distales, la prédiction rapide et précise de la structure avec ESMFold peut également jouer un rôle important dans l'analyse structurelle et fonctionnelle de grandes nouvelles collections de séquences.

L'accès à des millions de structures prédites dans un temps limité est propice à la découverte de nouvelles connaissances sur l'étendue et la diversité des protéines naturelles et permet la découverte de structures et de fonctions protéiques complètement nouvelles.

Le co-auteur de cet article est Zeming Lin de Meta AI.

Selon sa page d'accueil personnelle, Zeming a étudié pour un doctorat à l'Université de New York et a travaillé comme ingénieur de recherche (visiteur) chez Meta AI, principalement responsable des travaux d'infrastructure back-end.

Il a étudié à l'Université de Virginie pour son baccalauréat et sa maîtrise, où lui et Yanjun Qi ont effectué des recherches sur les applications de l'apprentissage automatique, en particulier dans la prédiction de la structure des protéines.

Les domaines d'intérêt sont l'apprentissage profond, la prédiction de structure et la biologie de l'information.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quels sont les logiciels antivirus ?

Quels sont les logiciels antivirus ?

Plateforme nationale de monnaie numérique

Plateforme nationale de monnaie numérique

Comment configurer les variables d'environnement Tomcat

Comment configurer les variables d'environnement Tomcat

Que signifie c# ?

Que signifie c# ?

Comment récupérer des fichiers supprimés définitivement sur un ordinateur

Comment récupérer des fichiers supprimés définitivement sur un ordinateur

Comment ouvrir des fichiers HTML sur un téléphone mobile

Comment ouvrir des fichiers HTML sur un téléphone mobile

Méthode de récupération de base de données Oracle

Méthode de récupération de base de données Oracle

Comment résoudre les problèmes lors de l'analyse des packages

Comment résoudre les problèmes lors de l'analyse des packages