Tout à l'heure, Meta AI a publié Segment Anything Model (SAM) - le premier modèle de base pour la segmentation d'images.

SAM peut réaliser une segmentation en un clic de n'importe quel objet à partir de photos ou de vidéos, et peut migrer vers d'autres tâches sans aucun échantillon.

Dans l'ensemble, SAM suit les idées du modèle de base :

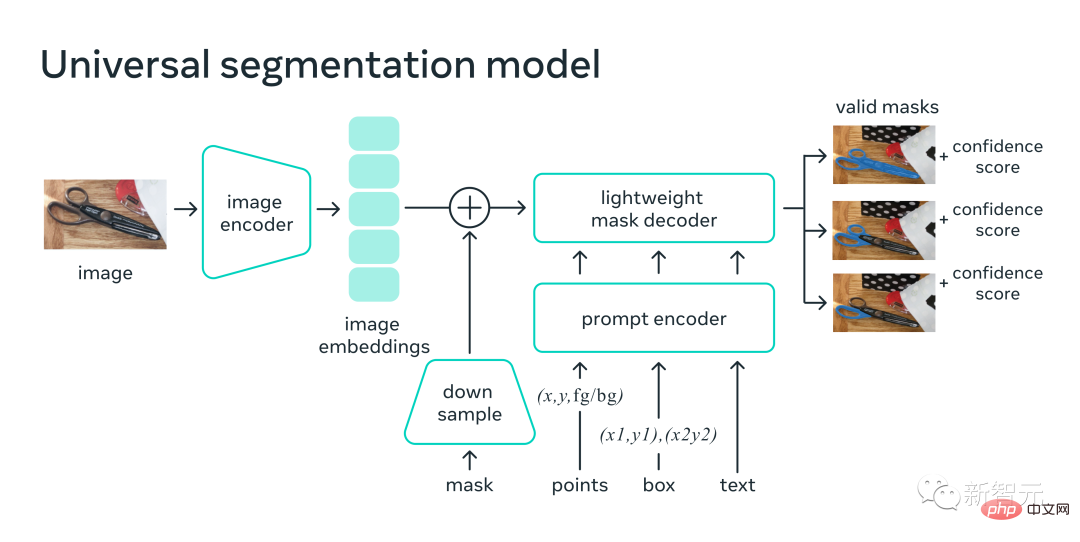

1. Une architecture très simple mais évolutive qui peut gérer des invites multimodales : texte, points clés, cadres de délimitation.

2. Processus d'annotation intuitif, étroitement lié à la conception du modèle.

3. Un volant de données qui permet d'amorcer des modèles sur de grandes quantités d'images non étiquetées.

Et il n'est pas exagéré de dire que SAM a appris le concept général d'"objets", même pour les objets inconnus, les scènes peu familières (comme sous l'eau et au microscope) et les cas ambigus.

De plus, le SAM peut également être généralisé à de nouvelles tâches et de nouveaux domaines, et les praticiens n'ont plus besoin d'affiner eux-mêmes le modèle.

Adresse papier : https://ai.facebook.com/research/publications/segment-anything/

La chose la plus puissante est que Meta implémente un paradigme de CV complètement différent, vous pouvez Dans un unifié Encodeur d'invite de framework, spécifiez un point, un cadre de délimitation et une phrase pour segmenter directement l'objet en un seul clic.

À cet égard, Jin Tian, expert en algorithmes d'IA de Tencent, a déclaré : « Le paradigme d'invite dans le domaine de la PNL a commencé à s'étendre au domaine du CV. Et cette fois, il pourrait complètement changer la pensée traditionnelle de prédiction du CV. vous pouvez vraiment le faire. Utilisez un modèle pour segmenter n'importe quel objet de manière dynamique !"

Jim Fan, scientifique en IA chez NVIDIA, a même fait l'éloge de ceci : Nous avons atteint le "moment GPT-3" dans le domaine de la vision par ordinateur !

Alors le CV n’existe vraiment plus ?

SAM : "Découpez" tous les objets de n'importe quelle image en un seul clic

Segment Anything est le premier modèle de base dédié à la segmentation d'images.

La segmentation fait référence à l'identification des pixels d'une image appartenant à un objet et a toujours été la tâche principale de la vision par ordinateur.

Cependant, si vous souhaitez créer un modèle de segmentation précis pour une tâche spécifique, cela nécessite généralement un travail hautement spécialisé de la part d'experts. Ce processus nécessite une infrastructure de formation en IA et une grande quantité de données dans le domaine soigneusement étiquetées, donc le seuil. est extrêmement élevé.

Afin de résoudre ce problème, Meta a proposé un modèle de base pour la segmentation d'images-SAM. Ce modèle indicatif, formé sur diverses données, est non seulement adaptable à une variété de tâches, mais fonctionne également de la même manière que les indices sont utilisés dans les modèles PNL.

Le modèle SAM saisit le concept de « qu'est-ce qu'un objet » et peut générer un masque pour n'importe quel objet dans n'importe quelle image ou vidéo, même pour les objets qu'il n'a pas vus pendant la formation.

SAM est si polyvalent qu'il couvre une variété de cas d'utilisation et peut être utilisé immédiatement dans de nouveaux domaines d'imagerie sans formation supplémentaire, qu'il s'agisse de photos sous-marines ou de microscopie cellulaire. En d’autres termes, SAM a déjà la capacité de migrer sans échantillon.

Meta a déclaré avec enthousiasme sur le blog : On peut s'attendre à ce qu'à l'avenir, SAM soit utilisé dans toute application nécessitant de rechercher et de segmenter des objets dans des images.

SAM peut faire partie d'un système d'IA plus vaste pour développer une compréhension multimodale plus générale du monde, comme la compréhension du contenu visuel et textuel des pages Web.

Dans le domaine de l'AR/VR, SAM peut sélectionner des objets en fonction de la ligne de mire de l'utilisateur, puis « mettre à niveau » les objets en 3D.

Pour les créateurs de contenu, SAM peut extraire des zones d'image pour un collage ou un montage vidéo.

SAM peut également localiser et suivre des animaux ou des objets dans des vidéos, aidant ainsi la recherche en sciences naturelles et en astronomie.

Dans le passé, il y avait deux façons de résoudre le problème de segmentation.

L'une est la segmentation interactive, qui peut segmenter des objets de n'importe quelle catégorie, mais nécessite d'affiner le masque par itération.

La seconde est la segmentation automatique, qui permet de segmenter des objets spécifiques définis à l'avance, mais le processus de formation nécessite une grande quantité d'annotations manuelles d'objets (par exemple, pour segmenter un chat, des milliers d'exemples sont nécessaires).

En bref, aucune de ces deux méthodes ne peut fournir une méthode de segmentation universelle et entièrement automatique.

Et SAM peut être vu comme une généralisation de ces deux méthodes, il peut facilement effectuer une segmentation interactive et une segmentation automatique.

Sur l'interface d'invite du modèle, un large éventail de tâches de segmentation peut être effectué en concevant simplement les invites correctes (clics, zones, texte, etc.) pour le modèle.

De plus, SAM est formé sur un ensemble de données diversifié et de haute qualité contenant plus d'un milliard de masques, permettant au modèle de se généraliser à de nouveaux objets et images au-delà de ce qu'il a observé pendant la formation. En conséquence, les praticiens n’ont plus besoin de collecter leurs propres données de segmentation pour affiner les modèles en fonction des cas d’utilisation.

Ce type de flexibilité qui peut être généralisé à de nouvelles tâches et de nouveaux domaines est une première dans le domaine de la segmentation d'images.

(1) SAM permet aux utilisateurs de segmenter des objets en un seul clic ou de cliquer de manière interactive sur de nombreux points, et peut également utiliser des indices de cadre de délimitation pour le modèle.

(2) Face à l'ambiguïté des objets segmentés, SAM peut générer plusieurs masques valides, ce qui constitue une capacité essentielle pour résoudre les problèmes de segmentation dans le monde réel.

(3) SAM peut découvrir et bloquer automatiquement tous les objets de l'image. (4) Après avoir précalculé les intégrations d'images, SAM peut générer des masques de segmentation pour n'importe quelle invite en temps réel, permettant aux utilisateurs d'interagir avec le modèle en temps réel.

Le SAM formé par les chercheurs peut renvoyer des masques de segmentation valides pour n'importe quelle invite. Les indices peuvent être des points de premier plan/arrière-plan, des zones ou des masques approximatifs, du texte de forme libre ou généralement toute information indiquant qu'une segmentation est nécessaire dans l'image.

L'exigence d'un masque valide signifie simplement que même dans les cas où l'indice est ambigu et peut faire référence à plusieurs objets (par exemple, un point sur une chemise peut représenter une chemise ou une personne portant une chemise), le résultat doit être un de ces objets masque raisonnable.

Les chercheurs ont observé que les tâches de pré-formation et la collecte de données interactive imposent des contraintes spécifiques sur la conception des modèles.

En particulier, le modèle doit s'exécuter en temps réel sur le CPU dans un navigateur Web afin que le personnel standard puisse interagir efficacement avec SAM en temps réel pour l'annotation.

Bien que les contraintes d'exécution impliquent un compromis entre la qualité et la durée d'exécution, les chercheurs ont découvert qu'en pratique, des conceptions simples peuvent donner de bons résultats.

L'encodeur d'images de SAM produit des intégrations uniques pour les images, tandis que le décodeur léger convertit à la volée tous les indices en intégrations vectorielles. Ces deux sources d’informations sont ensuite combinées dans un décodeur léger qui prédit les masques de segmentation.

Après avoir calculé l'intégration de l'image, SAM peut générer un morceau d'image en seulement 50 millisecondes et donner n'importe quelle invite dans le navigateur Web.

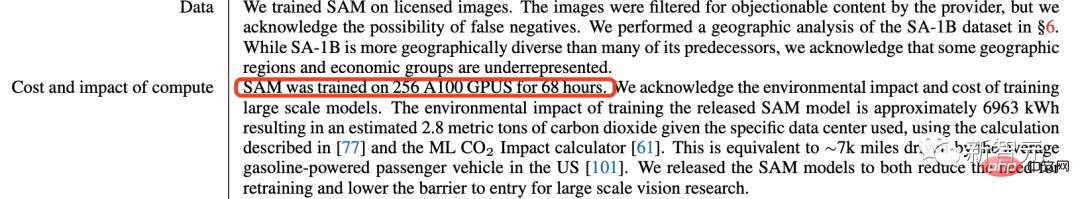

Le dernier modèle SAM a été formé sur 256 images A100 pendant 68 heures (près de 5 jours).

Démonstration du projet

Les invites pour spécifier le contenu à segmenter dans l'image peuvent réaliser diverses tâches de segmentation sans formation supplémentaire.

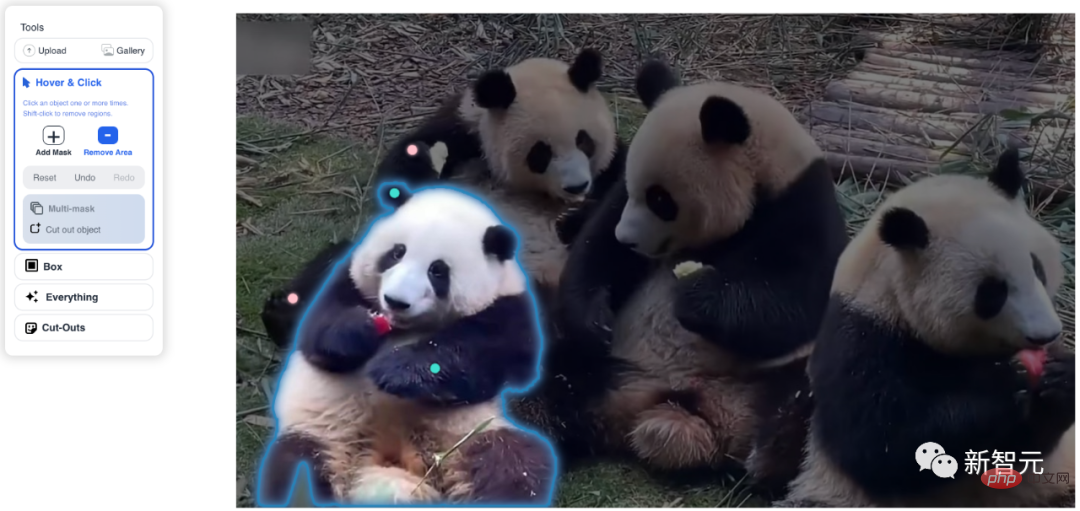

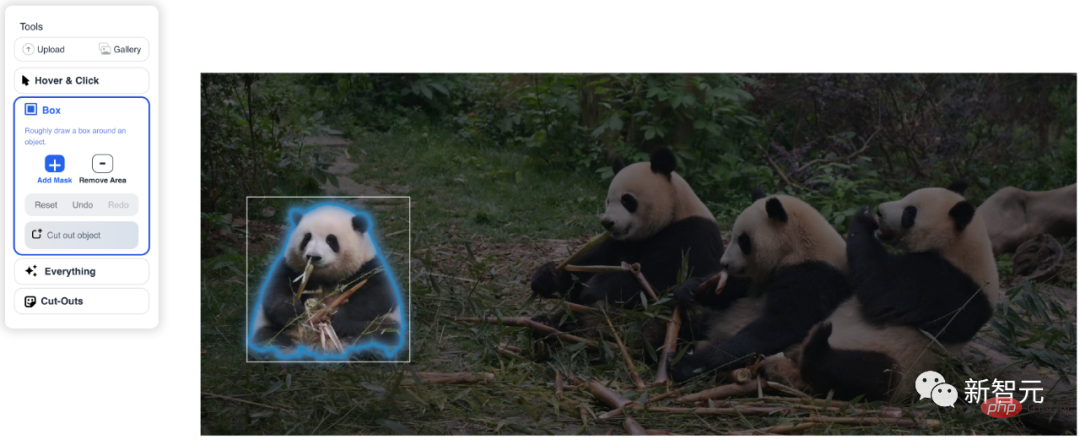

Utilisez des points et des cases interactifs comme invites

Segmentez automatiquement tous les éléments de l'image

est ambigu Les invites sont générées plusieurs masques valides

SAM peut accepter les invites de saisie d'autres systèmes.

Par exemple, sélectionnez l'objet correspondant en fonction des informations de mise au point visuelle de l'utilisateur provenant du casque AR/VR. Le développement par Meta d’une IA capable de comprendre le monde réel ouvrira la voie à son futur voyage métavers.

Vous pouvez également implémenter la segmentation texte-objet à l'aide des conseils de cadre de délimitation du détecteur d'objet.

Les masques de sortie peuvent être utilisés comme entrée dans d'autres systèmes d'IA.

Par exemple, le masque d'un objet peut être suivi dans une vidéo, transformé en 3D via des applications d'édition d'imagerie ou utilisé pour des tâches créatives telles que le collage.

SAM apprend une idée générale de ce qu'est un objet - cette compréhension lui permet de faire des généralisations sans tir à des objets et des images inconnus, tandis qu'aucun supplément une formation est nécessaire.

Sélectionnez Hover&Click, cliquez sur Ajouter un masque et un vert Cliquez, un point rouge apparaîtra après avoir cliqué sur Supprimer la zone, mangez Le Huahua d'Apple a été immédiatement encerclé.

Dans la fonction Box, sélectionnez simplement la case et la reconnaissance sera terminée immédiatement.

Après avoir cliqué sur Tout, tous les objets reconnus par le système seront immédiatement extraits.

Après avoir choisi les découpes, vous obtiendrez une boulette triangulaire en quelques secondes.

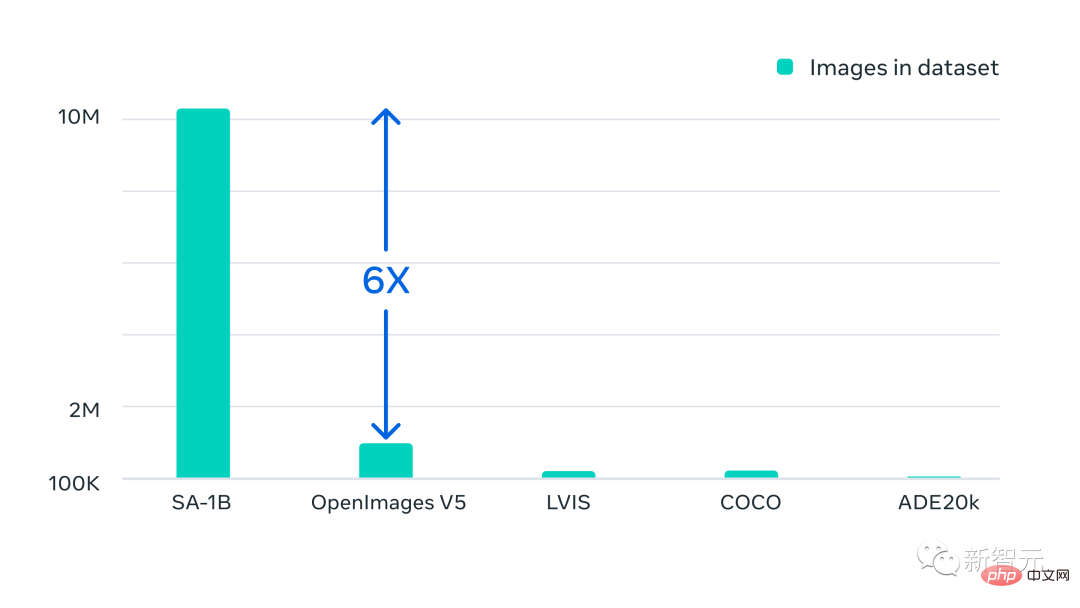

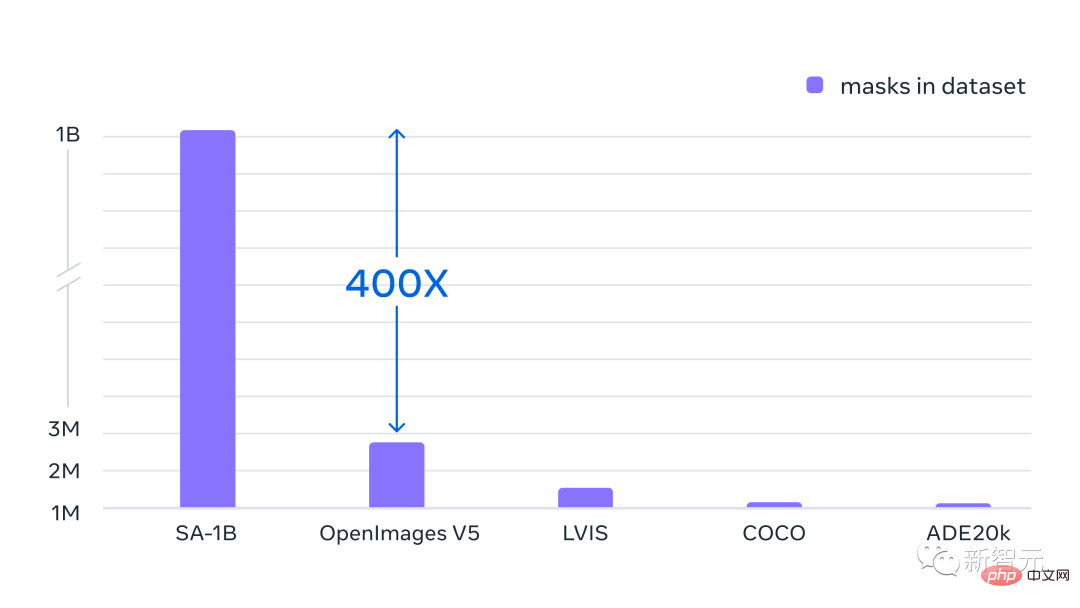

En plus des nouveaux modèles publiés, Meta a également publié SA-1B, le plus grand ensemble de données de segmentation à ce jour.

Cet ensemble de données comprend 11 millions d'images diverses, haute résolution et préservant la confidentialité, et 1,1 milliard de masques de segmentation de haute qualité.

Les caractéristiques globales de l'ensemble de données sont les suivantes :

· Nombre total d'images : 11 millions

· Nombre total de masques : 1,1 milliard

· Masque moyen par image : 100

· Résolution moyenne de l'image : 1500 × 2250 pixels

REMARQUE : les annotations d'image ou de masque n'ont pas d'étiquettes de classe

Meta souligne que ces données sont collectées via notre moteur de données et que tous les masques sont entièrement générés par SAM Généré automatiquement.

Avec le modèle SAM, la collecte de nouveaux masques de segmentation est plus rapide que jamais, et l'annotation interactive d'un masque ne prend que 14 secondes environ.

Le processus d'annotation par masque est seulement 2 fois plus lent que l'annotation des cadres de délimitation. En utilisant l'interface d'annotation la plus rapide, l'annotation des cadres de délimitation prend environ 7 secondes.

L'annotation de masque entièrement manuelle basée sur des polygones du modèle SAM COCO est 6,5 fois plus rapide que les précédents efforts de collecte de données de segmentation à grande échelle et 2 fois plus rapide que le plus grand effort d'annotation de données précédent (également assisté par modèle).

Cependant, s'appuyer sur des masques d'annotation interactifs ne suffit pas pour créer plus d'un milliard d'ensembles de données masqués. Par conséquent, Meta a construit un moteur de données pour créer des ensembles de données SA-1B.

Ce moteur de données comporte trois "engrenages":

1. Annotation auxiliaire du modèle

2 Le mélange d'annotation entièrement automatique et d'annotation auxiliaire permet d'augmenter la diversité des masques collectés

3. . Création de masques entièrement automatisée, permettant l'évolutivité de l'ensemble de données

Notre ensemble de données final comprend plus de 1,1 milliard de masques de segmentation collectés sur environ 11 millions d'images autorisées et préservant la confidentialité.

SA-1B contient 400 fois plus de masques que n'importe quel ensemble de données de segmentation existant. Et les études d’évaluation humaine confirment que les masques sont de haute qualité et diversifiés et, dans certains cas, sont même qualitativement comparables aux masques précédents provenant d’ensembles de données plus petits et entièrement annotés manuellement.

Les images du SA-1B ont été obtenues grâce à des fournisseurs de photos de plusieurs pays, couvrant différentes zones géographiques et niveaux de revenus.

Bien que certaines zones géographiques soient encore sous-représentées, SA-1B possède plus d'images et une meilleure représentation globale dans toutes les régions que les ensembles de données de segmentation précédents.

Enfin, Meta espère que ces données pourront constituer la base de nouveaux ensembles de données comprenant des annotations supplémentaires, telles que des descriptions textuelles associées à chaque masque. "Le maître RBG dirige l'équipe" vision par ordinateur et apprentissage automatique.

En 2012, Ross Girshick a obtenu son doctorat en informatique de l'Université de Chicago sous la direction de Pedro Felzenszwalb.Avant de rejoindre FAIR, Ross était chercheur chez Microsoft Research et postdoctorant à l'Université de Californie à Berkeley, où ses mentors étaient Jitendra Malik et Trevor Darrell.

Il a reçu le PAMI Young Researcher Award en 2017, le PAMI Mark Everingham Award en 2017 et 2021 en reconnaissance de ses contributions aux logiciels open source.

Internautes : le CV n'existe vraiment plus

Meta a créé ce modèle de base de segmentation dans le domaine du CV, qui a fait crier de nombreux internautes "Maintenant, le CV n'existe vraiment plus."

Le méta-scientifique Justin Johnson a déclaré : « Pour moi, le moteur de données de Segment Anything et le RLHF de ChatGPT représentent une nouvelle ère d'intelligence artificielle à grande échelle. Plutôt que de tout apprendre à partir de données réseau bruyantes, nous pouvons intelligemment appliquer l'annotation humaine combinée au Big Data. "

Le seul regret est que la sortie du modèle SAM ait été principalement dirigée par Ross Girshick, mais He Yaming était absent.

L'ami "Matrix Mingzi" a déclaré que cet article prouve en outre que la multimodalité est l'avenir du CV et que le CV pur n'a pas de lendemain.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Introduction au système d'exploitation Linux

Introduction au système d'exploitation Linux

Solution d'erreur SQL 5120

Solution d'erreur SQL 5120

Comment centrer la page Web dans Dreamweaver

Comment centrer la page Web dans Dreamweaver

puce FAI

puce FAI

minidump.dmp

minidump.dmp

Comment clearfix implémente la compensation des flotteurs

Comment clearfix implémente la compensation des flotteurs

Outil de requête de nom de domaine d'enregistrement

Outil de requête de nom de domaine d'enregistrement

Comment utiliser l'outil de capture de paquets HttpCanary

Comment utiliser l'outil de capture de paquets HttpCanary