Das weltweit erste Open-Source-Videogenerierungsmodell für Sora-ähnliche Architektur ist da!

Der gesamte Trainingsprozess, einschließlich der Datenverarbeitung, aller Trainingsdetails und Modellgewichte, ist offen.

Dies ist das gerade veröffentlichte Open-Sora 1.0.

Der tatsächliche Effekt ist wie folgt: Es kann den geschäftigen Verkehr in der Nachtszene der geschäftigen Stadt erzeugen.

Sie können auch eine Luftbildperspektive verwenden, um die Szene der Klippenküste und des gegen die Felsen plätschernden Meerwassers zu zeigen.

Oder der weite Sternenhimmel unter Zeitrafferfotografie.

Seit seiner Veröffentlichung ist die Enthüllung und Reproduktion von Sora aufgrund seiner atemberaubenden Effekte und des Mangels an technischen Details zu einem der am meisten diskutierten Themen in der Entwickler-Community geworden. Beispielsweise hat das Colossal-AI-Team einen Sora-Trainings- und Inferenzreplikationsprozess gestartet, der die Kosten um 46 % senken kann.

Nach nur zwei Wochen veröffentlichte das Team erneut die neuesten Fortschritte, reproduzierte eine Sora-ähnliche Lösung und stellte die technische Lösung sowie detaillierte praktische Tutorials kostenlos und Open Source auf GitHub zur Verfügung.

Dann stellt sich die Frage: Wie kann man Sora reproduzieren?

Open-Sora Open-Source-Adresse: https://github.com/hpcaitech/Open-Sora

Die Sora-Replikationslösung umfasst vier Aspekte:

Das Modell übernimmt die Sora-homologe Architektur Diffusion Transformer (DiT).

Es basiert auf PixArt-α, einem hochwertigen Open-Source-Graphmodell mit DiT-Architektur. Auf dieser Basis wird eine zeitliche Aufmerksamkeitsschicht eingeführt und auf Videodaten erweitert.

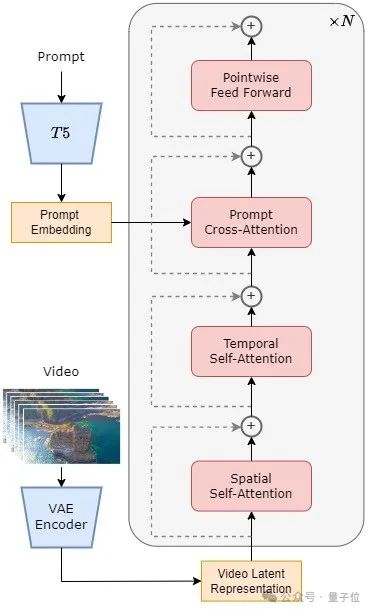

Konkret umfasst die gesamte Architektur ein vortrainiertes VAE, einen Text-Encoder und ein STDiT-Modell (Spatial Temporal Diffusion Transformer), das den räumlich-zeitlichen Aufmerksamkeitsmechanismus nutzt.

Unter diesen ist die Struktur jeder Schicht von STDiT in der folgenden Abbildung dargestellt.

Es verwendet eine serielle Methode, um ein eindimensionales zeitliches Aufmerksamkeitsmodul mit einem zweidimensionalen räumlichen Aufmerksamkeitsmodul zu überlagern, um zeitliche Beziehungen zu modellieren. Nach dem zeitlichen Aufmerksamkeitsmodul wird das Kreuzaufmerksamkeitsmodul verwendet, um die Semantik des Textes auszurichten.

Im Vergleich zum Vollaufmerksamkeitsmechanismus reduziert eine solche Struktur den Trainings- und Inferenzaufwand erheblich.

Im Vergleich zum Latte-Modell, das ebenfalls den räumlich-zeitlichen Aufmerksamkeitsmechanismus verwendet, kann STDiT die Gewichte des vorab trainierten Bild-DiT besser nutzen, um das Training an Videodaten fortzusetzen.

△STDiT-Strukturdiagramm

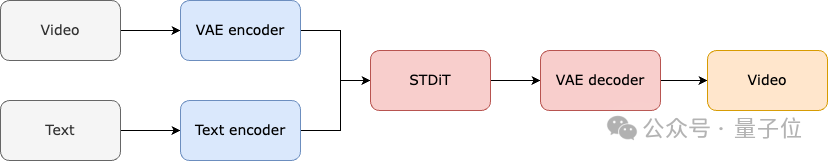

Der Trainings- und Inferenzprozess des gesamten Modells ist wie folgt.

Es versteht sich, dass in der Trainingsphase zunächst der vorab trainierte Variational Autoencoder (VAE)-Encoder zum Komprimieren der Videodaten verwendet wird und dann das STDiT-Diffusionsmodell zusammen mit der Texteinbettung im komprimierten latenten Raum trainiert wird.

In der Inferenzphase wird ein Gaußsches Rauschen zufällig aus dem latenten Raum des VAE abgetastet und zusammen mit der Prompt-Einbettung in STDiT eingegeben, um die entrauschten Merkmale zu erhalten. Schließlich wird es in den VAE-Decoder eingegeben und dekodiert, um ein Video zu erhalten.

△Modelltrainingsprozess

Im Trainingsreproduktionsteil bezieht sich Open-Sora auf Stable Video Diffusion (SVD).

Es ist in 3 Phasen unterteilt:

Bei jeder Stufe wird das Training basierend auf den Gewichten der vorherigen Stufe fortgesetzt. Im Vergleich zum einstufigen Training von Grund auf erreicht das mehrstufige Training das Ziel einer qualitativ hochwertigen Videogenerierung effizienter, indem die Daten schrittweise erweitert werden.

△Dreistufiger Trainingsplan

△Dreistufiger Trainingsplan

Das Team nutzte die umfangreichen Bilddaten und die vinzentinische Graphentechnologie im Internet, um zunächst ein hochwertiges vinzentinisches Graphenmodell zu trainieren und dieses Modell als Initialisierungsgewicht für die nächste Stufe des Video-Vortrainings zu verwenden.

Da es derzeit keine qualitativ hochwertige räumlich-zeitliche VAE gibt, verwenden sie gleichzeitig vorab trainierte Bild-VAE mit stabiler Diffusion.

Dies stellt nicht nur die überlegene Leistung des ursprünglichen Modells sicher, sondern reduziert auch die Gesamtkosten für das Video-Vortraining erheblich.

Diese Phase erhöht hauptsächlich die Generalisierungsfähigkeit des Modells und erfasst effektiv die Zeitreihenkorrelation des Videos.

Es muss eine große Menge an Videodaten für das Training verwendet und die Vielfalt der Videomaterialien sichergestellt werden.

Gleichzeitig fügt das Modell der zweiten Stufe ein zeitliches Aufmerksamkeitsmodul hinzu, das auf dem vinzentinischen Graphenmodell der ersten Stufe basiert, um zeitliche Beziehungen in Videos zu lernen. Die verbleibenden Module bleiben mit der ersten Stufe konsistent und laden die Gewichte der ersten Stufe als Initialisierung, während die Ausgabe des zeitlichen Aufmerksamkeitsmoduls auf Null initialisiert wird, um eine effizientere und schnellere Konvergenz zu erreichen.

Das Colossal-AI-Team verwendete die Open-Source-Gewichte von PixArt-alpha als Initialisierung des STDiT-Modells der zweiten Stufe und das T5-Modell als Text-Encoder. Für das Vortraining verwendeten sie eine kleine Auflösung von 256 x 256, was die Konvergenzgeschwindigkeit weiter erhöhte und die Trainingskosten senkte.

△Open-Sora-Generierungseffekt (Stichwort: Aufnahmen der Unterwasserwelt, in der eine Schildkröte gemächlich zwischen Korallenriffen schwimmt)

Berichten zufolge kann diese Phase die Qualität der Modellgenerierung erheblich verbessern. Die verwendete Datengröße ist um eine Größenordnung geringer als in der vorherigen Stufe, aber die Dauer, Auflösung und Qualität der Videos sind höher.

Durch die Feinabstimmung auf diese Weise kann eine effiziente Erweiterung der Videoerzeugung von kurz auf lang, von niedriger Auflösung auf hohe Auflösung und von niedriger Wiedergabetreue auf hohe Wiedergabetreue erreicht werden.

Erwähnenswert ist, dass Colossal-AI auch den Ressourcenverbrauch jeder Stufe detailliert offengelegt hat.

Im Reproduktionsprozess von Open-Sora nutzten sie 64 H800 für das Training. Das Gesamttrainingsvolumen der zweiten Stufe beträgt 2808 GPU-Stunden, was etwa 7.000 US-Dollar entspricht, und das Trainingsvolumen der dritten Stufe beträgt 1920 GPU-Stunden, was etwa 4.500 US-Dollar entspricht. Nach vorläufiger Schätzung kontrollierte der gesamte Trainingsplan den Open-Sora-Reproduktionsprozess erfolgreich auf etwa 10.000 US-Dollar.

Um den Schwellenwert und die Komplexität der Sora-Wiederholung weiter zu reduzieren, stellt das Colossal-AI-Team außerdem ein praktisches Videodaten-Vorverarbeitungsskript im Code-Warehouse bereit, sodass jeder problemlos mit dem Vortraining für Sora-Wiederholungen beginnen kann.

Einschließlich des Herunterladens öffentlicher Videodatensätze, der Segmentierung langer Videos in kurze Videoclips basierend auf der Aufnahmekontinuität und der Verwendung des Open-Source-Großsprachenmodells LLaVA zur Generierung präziser Aufforderungswörter.

Der von ihnen bereitgestellte Batch-Code zur Generierung von Videotiteln kann ein Video mit zwei Karten und 3 Sekunden mit Anmerkungen versehen, und die Qualität liegt nahe an GPT-4V.

Das finale Video/Text-Paar kann direkt zum Training genutzt werden. Mit dem auf GitHub bereitgestellten Open-Source-Code können Sie einfach und schnell die für das Training erforderlichen Video-/Textpaare auf Ihrem eigenen Datensatz generieren und so den technischen Schwellenwert und die vorbereitende Vorbereitung für den Start eines Sora-Replikationsprojekts erheblich reduzieren.

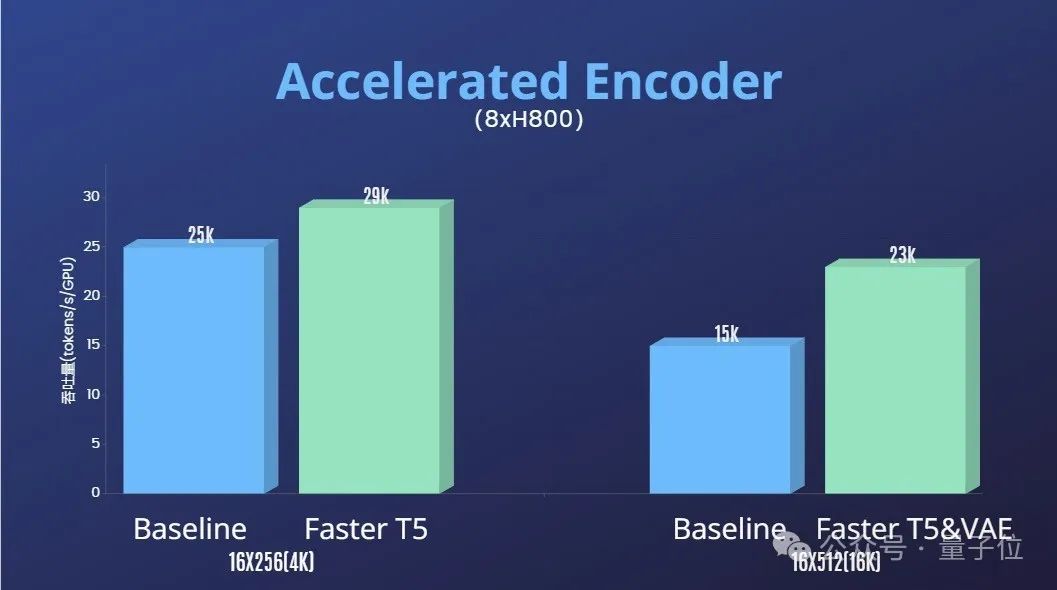

Darüber hinaus bietet das Colossal-AI-Team auch eine Lösung zur Trainingsbeschleunigung.

Durch effiziente Trainingsstrategien wie Bedieneroptimierung und Hybridparallelität wurde beim Training der Verarbeitung von Videos mit 64 Bildern und einer Auflösung von 512 x 512 ein 1,55-facher Beschleunigungseffekt erzielt.

Gleichzeitig kann dank des heterogenen Speicherverwaltungssystems von Colossal-AI eine 1-minütige 1080p-HD-Video-Trainingsaufgabe ungehindert auf einem einzigen Server (8H800) durchgeführt werden.

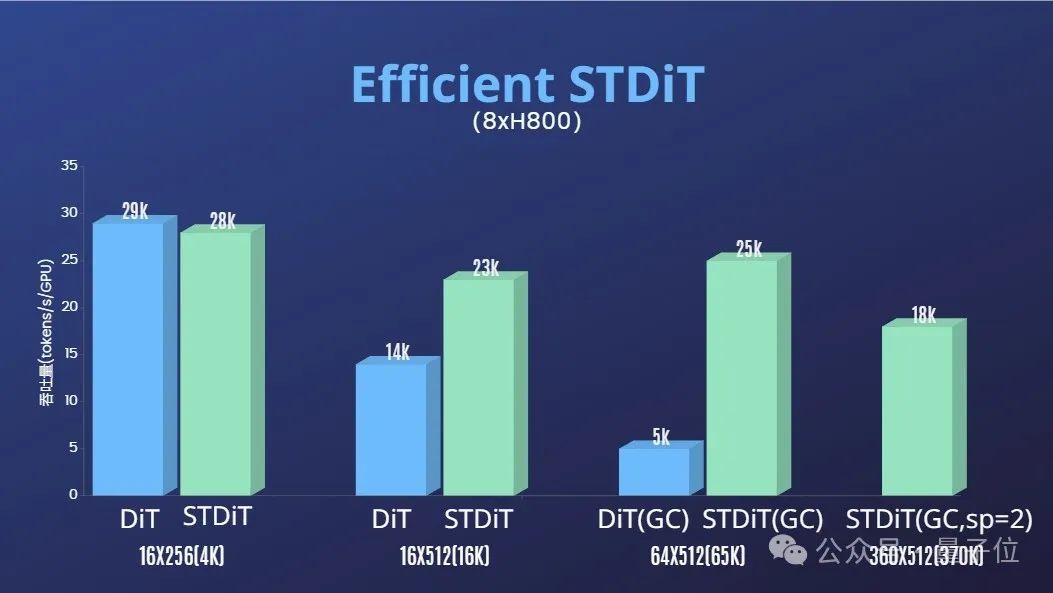

Und das Team stellte außerdem fest, dass die STDiT-Modellarchitektur auch während des Trainings eine hervorragende Effizienz zeigte.

Im Vergleich zu DiT, das den Vollaufmerksamkeitsmechanismus nutzt, erreicht STDiT mit zunehmender Anzahl von Bildern eine bis zu fünffache Beschleunigung, was besonders bei realen Aufgaben wie der Verarbeitung langer Videosequenzen von entscheidender Bedeutung ist.

Schließlich veröffentlichte das Team auch weitere Open-Sora-Generationseffekte.

, Dauer 00:25

Das Team und Qubits gaben bekannt, dass sie Open-Sora-bezogene Lösungen und Entwicklungen langfristig aktualisieren und optimieren werden. In Zukunft werden mehr Videotrainingsdaten verwendet, um qualitativ hochwertigere, längere Videoinhalte zu generieren und Funktionen mit mehreren Auflösungen zu unterstützen.

In Bezug auf praktische Anwendungen gab das Team bekannt, dass es die Umsetzung in Filmen, Spielen, Werbung und anderen Bereichen vorantreiben wird.

Interessierte Entwickler können das GitHub-Projekt besuchen, um mehr zu erfahren~

Open-Sora Open-Source-Adresse: https://github.com/hpcaitech/Open-Sora

Referenzlink:

[1]https://arxiv .org/abs/2212.09748 Skalierbare Diffusionsmodelle mit Transformatoren.

[2]https://arxiv.org/abs/2310.00426 PixArt-α: Schnelles Training des Diffusionstransformators für die fotorealistische Text-zu-Bild-Synthese.

[3]https://arxiv.org/abs/2311.15127 Stabile Videodiffusion: Skalierung latenter Videodiffusionsmodelle auf große Datensätze.

[4]https://arxiv.org/abs/2401.03048 Latte: Latent Diffusion Transformer für die Videoerzeugung.

[5]https://huggingface.co/stabilityai/sd-vae-ft-mse-original.

[6]https://github.com/google-research/text-to-text-transfer-transformer.

[7]https://github.com/haotian-liu/LLaVA.

[8]https://hpc-ai.com/blog/open-sora-v1.0.

Das obige ist der detaillierte Inhalt vonDie weltweit erste Sora-ähnliche Open-Source-Reproduktionslösung ist da! Vollständige Offenlegung aller Trainingsdetails und Modellgewichte. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Rangliste der Kryptowährungsbörsen

Rangliste der Kryptowährungsbörsen

Was bedeutet unabhängige Direktverbindung?

Was bedeutet unabhängige Direktverbindung?

ERR_CONNECTION_REFUSED

ERR_CONNECTION_REFUSED

So integrieren Sie Ideen in Tomcat

So integrieren Sie Ideen in Tomcat

Was bedeutet das Formatieren eines Mobiltelefons?

Was bedeutet das Formatieren eines Mobiltelefons?

Ranking ausländischer CDN-Dienstleister

Ranking ausländischer CDN-Dienstleister