„Es ist keineswegs ein einfacher Ausschnitt.“

ControlNet-Autor Die neueste Forschung hat eine Welle hoher Aufmerksamkeit erhalten –

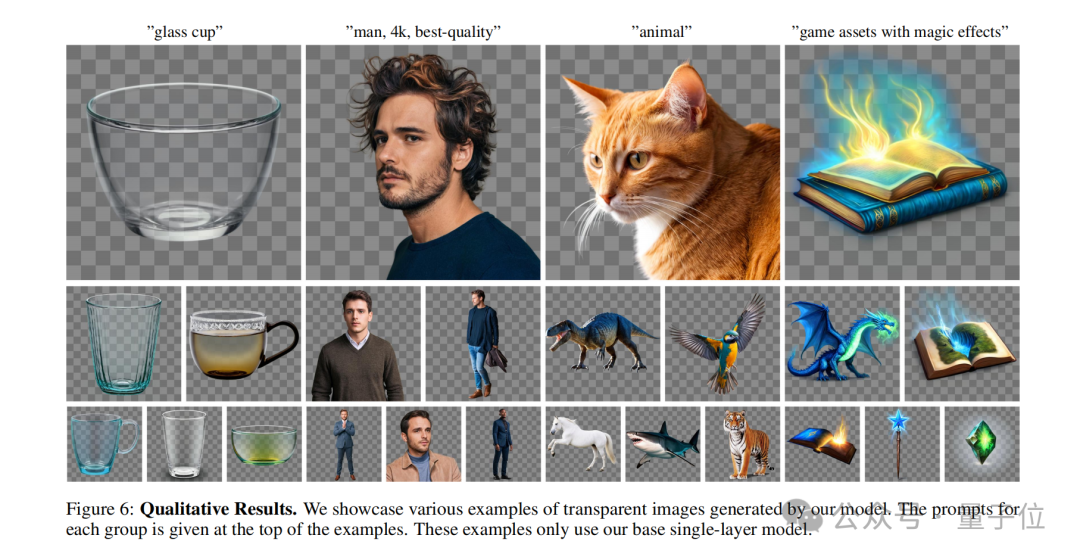

Geben Sie mir eine Aufforderung, Sie können Stable Diffusion verwenden, um direkt einzelne oder mehrere zu generieren transparente Ebenen (PNG) !

Zum Beispiel:

Eine Frau mit unordentlichen Haaren im Schlafzimmer.

Frau mit unordentlichen Haaren, im Schlafzimmer.

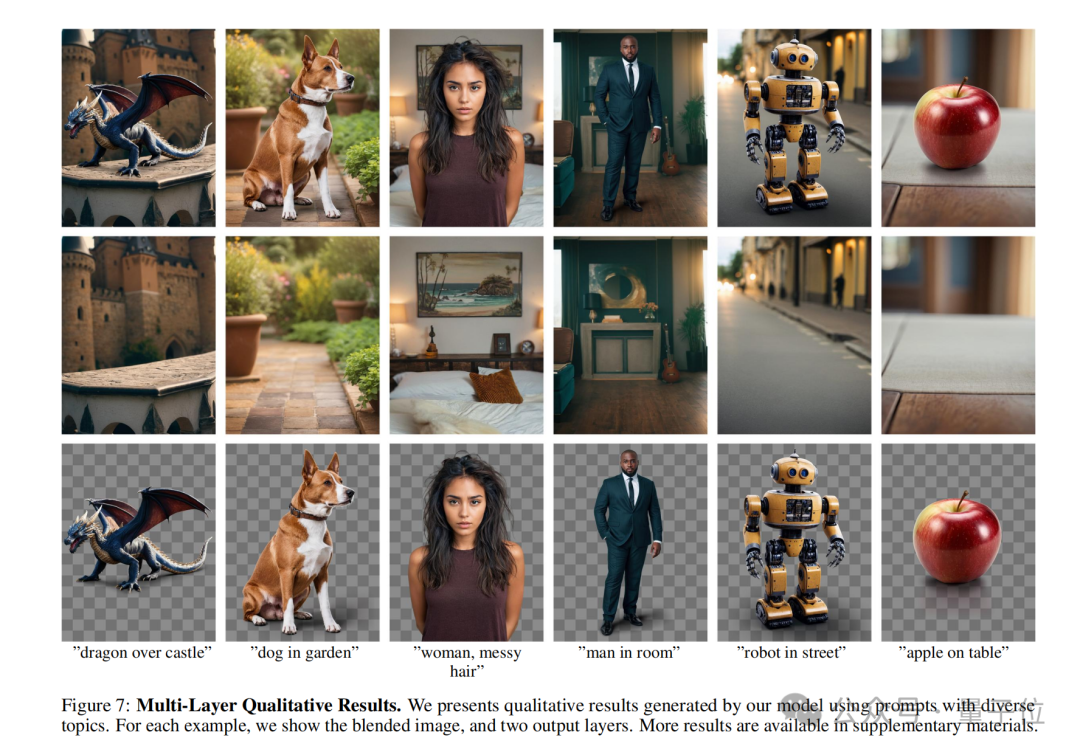

Sie können sehen, dass die KI nicht nur ein vollständiges Bild erzeugt hat, das der Eingabeaufforderung entspricht, sondern sogar der Hintergrund und die Zeichen können getrennt werden.

Und wenn Sie das Charakter-PNG-Bild vergrößern und genauer betrachten, können Sie erkennen, dass die Haarsträhnen klar definiert sind.

Schauen Sie sich ein anderes Beispiel an:

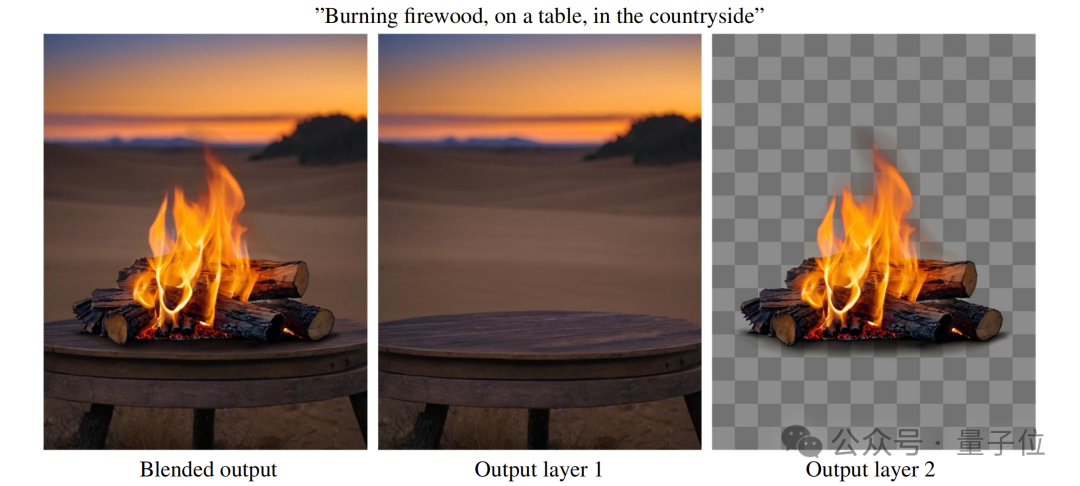

Brennendes Brennholz, auf einem Tisch, auf dem Land.

Brennendes Brennholz, auf einem Tisch, auf dem Land.

In ähnlicher Weise kann durch Vergrößern des PNG des „brennenden Streichholzes“ sogar der schwarze Rauch um die Flamme herum abgetrennt werden:

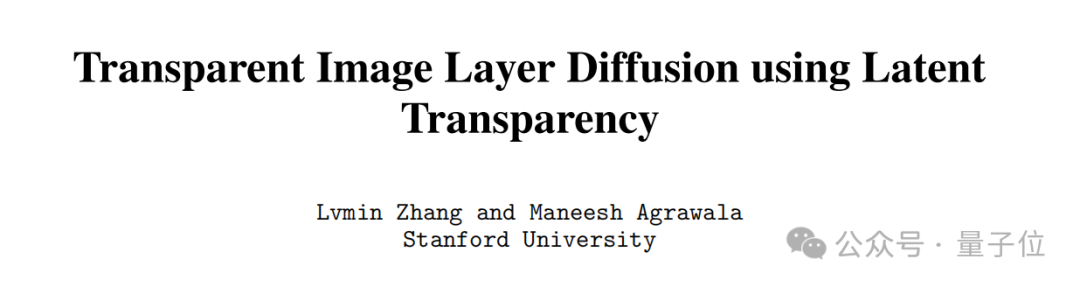

Das ist das Autor von ControlNet Die vorgeschlagene neue Methode LayerDiffusion ermöglicht es groß angelegten vorab trainierten latenten Diffusionsmodellen, transparente Bilder zu erzeugen.

Es lohnt sich noch einmal zu betonen, dass LayerDiffusion keineswegs so einfach ist wie das Ausschneiden von Bildern, der Fokus liegt auf der Generierung.

Wie Internetnutzer sagten:

Dies ist heutzutage einer der Kernprozesse in der Animations- und Videoproduktion. Wenn dieser Schritt bestanden werden kann, kann man sagen, dass die SD-Konsistenz kein Problem mehr darstellt.

Einige Internetnutzer dachten, dass eine solche Arbeit nicht schwierig sei, es gehe nur darum, „übrigens einen Alphakanal hinzuzufügen“, aber was ihn überraschte, war:

Es dauerte so lange, bis die Ergebnisse herauskamen.

Wie wird LayerDiffusion implementiert?

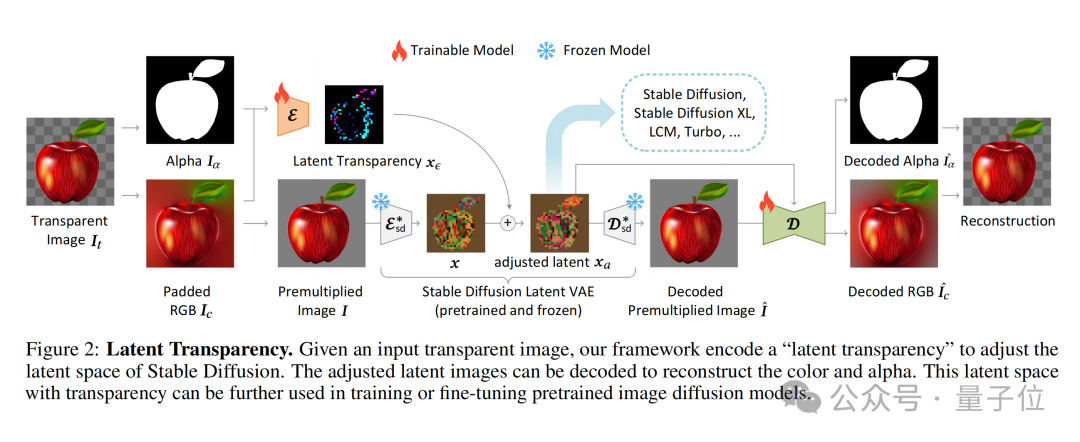

Der Kern von LayerDiffusion ist eine Methode namens latente Transparenz(latente Transparenz).

Einfach ausgedrückt ermöglicht es das Hinzufügen von Transparenz zum Modell, ohne die latente Verteilung des vorab trainierten latenten Diffusionsmodells (z. B. Stable Diffusion) zu zerstören.

In Bezug auf die konkrete Implementierung kann es als Hinzufügen einer sorgfältig entworfenen kleinen Störung (Offset) zum latenten Bild verstanden werden. Diese Störung wird als zusätzlicher Kanal codiert, der zusammen mit dem RGB-Kanal ein vollständiges latentes Bild darstellt.

Um die Kodierung und Dekodierung von Transparenz zu erreichen, hat der Autor zwei unabhängige neuronale Netzwerkmodelle trainiert: eines ist der Latent-Transparenz-Encoder(Latent-Transparenz-Encoder) und das andere ist der Latent-Transparenz-Decoder(Latent Transparenzdecoder).

Der Encoder empfängt den RGB-Kanal und den Alpha-Kanal des Originalbilds als Eingabe und wandelt die Transparenzinformationen in einen Offset im latenten Raum um.

Der Decoder empfängt das angepasste latente Bild und das rekonstruierte RGB-Bild und extrahiert die Transparenzinformationen aus dem latenten Raum, um das ursprüngliche transparente Bild zu rekonstruieren.

Um sicherzustellen, dass die zusätzliche potenzielle Transparenz die zugrunde liegende Verteilung des vorab trainierten Modells nicht zerstört, schlagen die Autoren eine „Harmlosigkeit“-Metrik (Harmlosigkeit) vor.

Diese Metrik bewertet die Auswirkung der latenten Transparenz, indem sie die Decodierungsergebnisse des angepassten latenten Bildes durch den Decoder des ursprünglichen vorab trainierten Modells mit dem Originalbild vergleicht.

Während des Trainingsprozesses verwendet der Autor auch eine Gelenkverlustfunktion (Gelenkverlustfunktion) , die Rekonstruktionsverlust (Rekonstruktionsverlust) , Identitätsverlust (Identitätsverlust) und Diskriminatorverlust (Diskriminatorverlust) kombiniert ).

Ihre Funktionen sind:

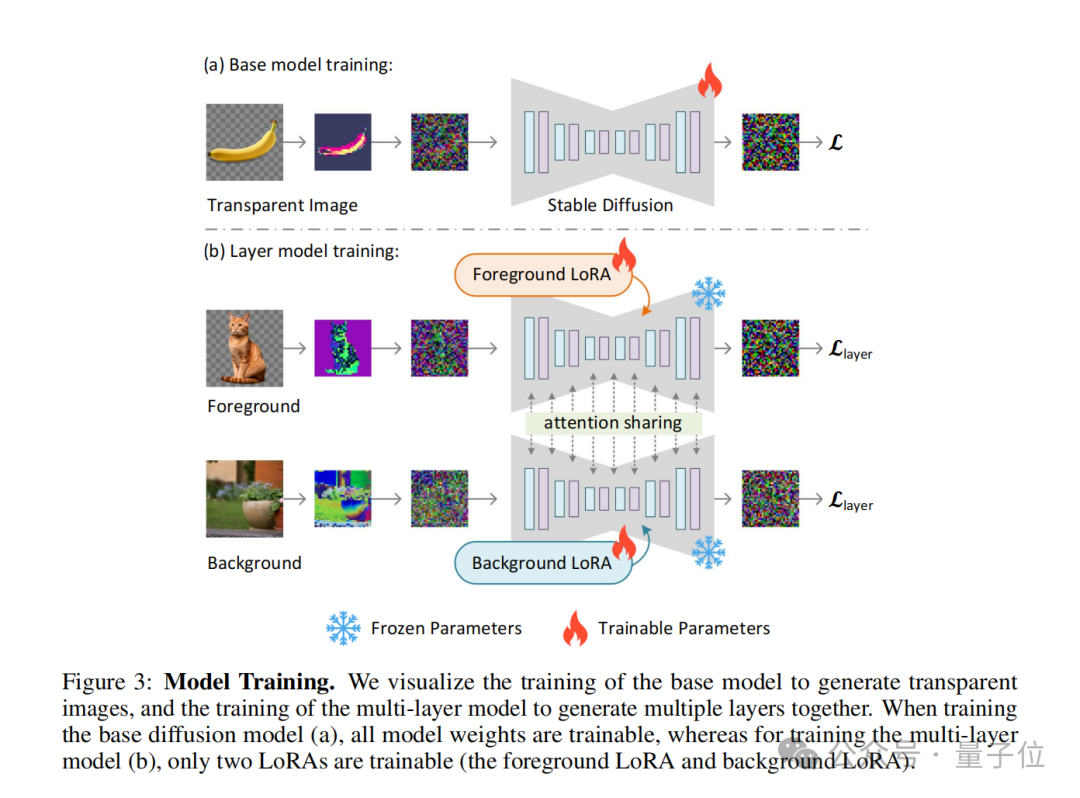

Mit diesem Ansatz kann jedes latente Diffusionsmodell in einen transparenten Bildgenerator umgewandelt werden, indem es einfach an den angepassten latenten Raum angepasst wird.

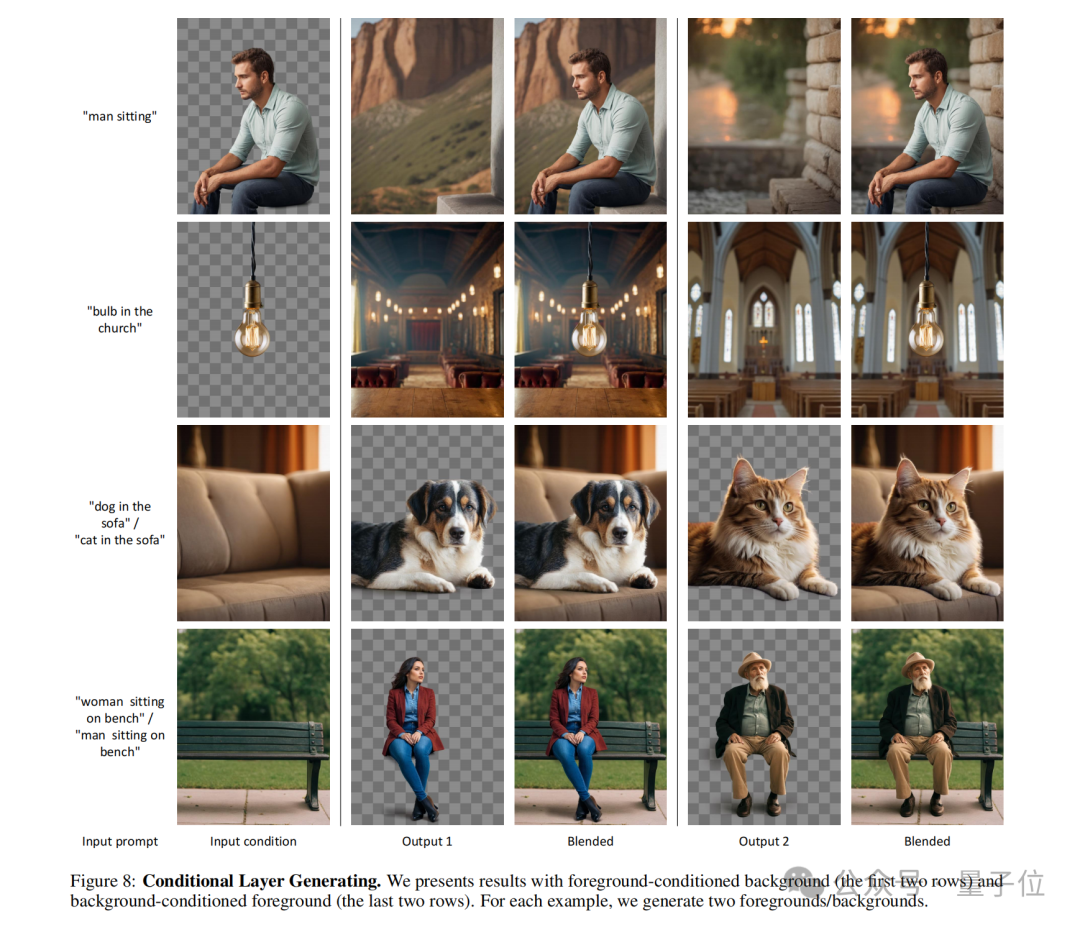

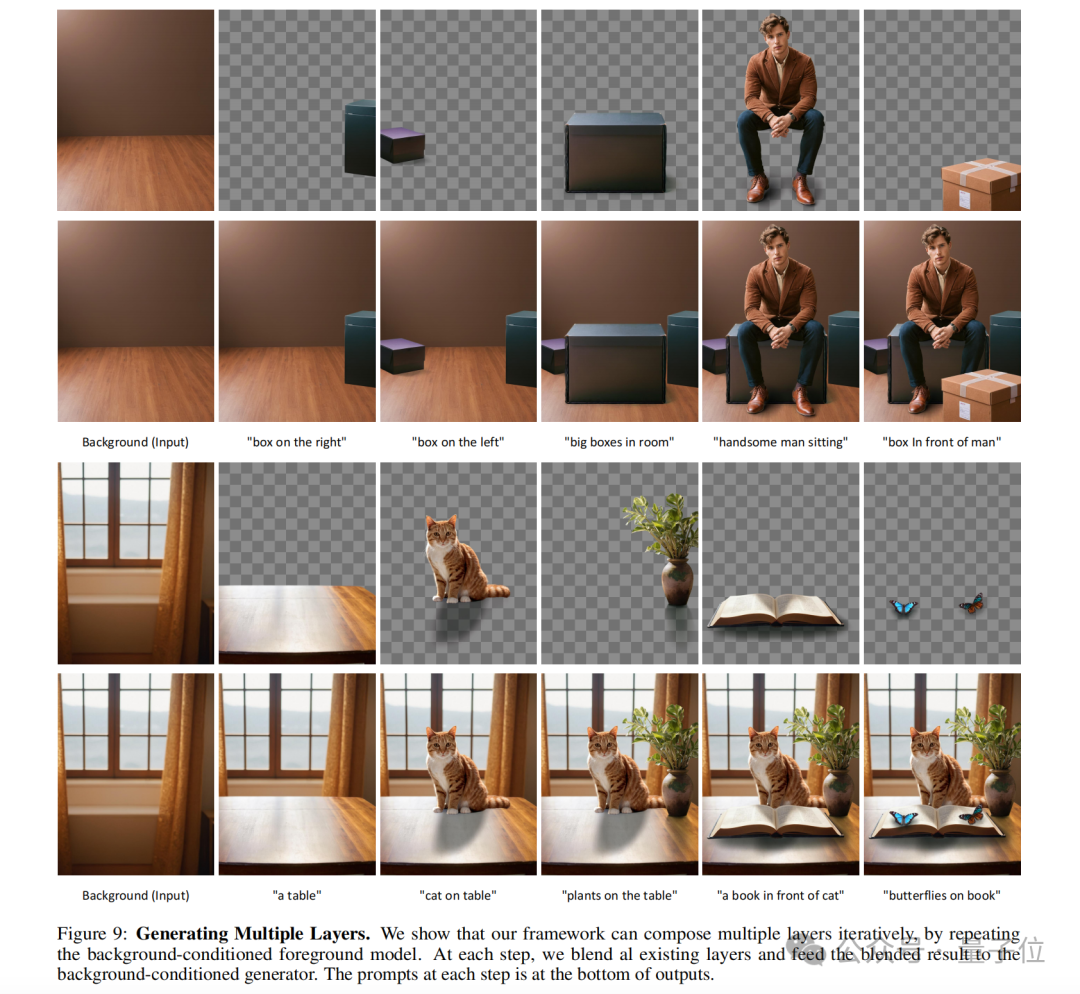

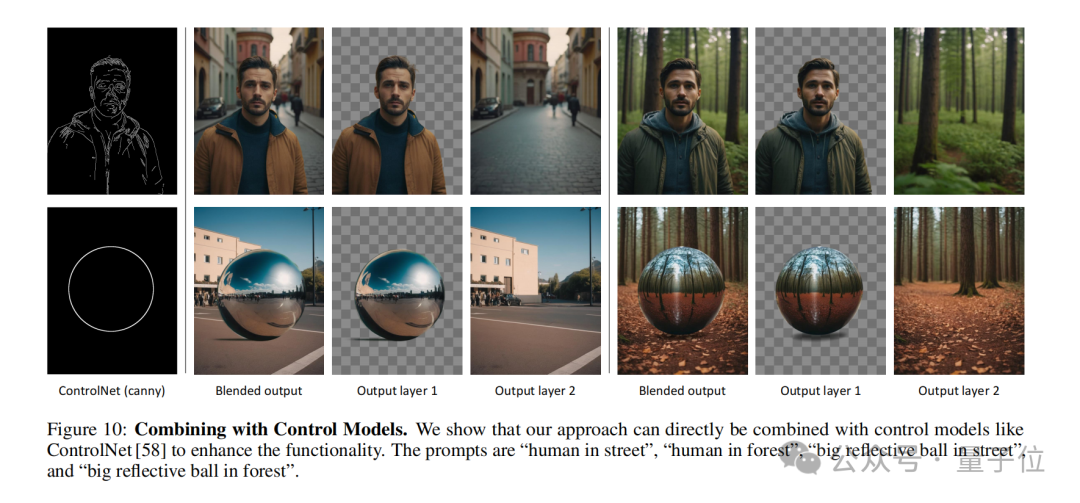

Das Konzept der latenten Transparenz kann auch erweitert werden, um mehrere transparente Ebenen zu generieren, und mit anderen bedingten Kontrollsystemen kombiniert werden, um komplexere Bildgenerierungsaufgaben zu erfüllen, wie z. B. die Generierung von Vordergrund-/Hintergrundbedingungen, die Generierung gemeinsamer Ebenen und die Inhaltsstruktur von Ebenen Kontrolle usw. Es ist erwähnenswert, dass der Autor auch zeigt, wie man ControlNet einführt, um die Funktionen von LayerDiffusion zu bereichern: in den folgenden Punkten zusammengefasst werden.

Native Generierung vs. Nachbearbeitung

Native Generierung vs. Nachbearbeitung

LayerDiffusion ist eine native Methode zur Generierung transparenter Bilder, die Transparenzinformationen direkt während des Generierungsprozesses berücksichtigt und kodiert. Das bedeutet, dass das Modell beim Generieren des Bildes einen Alphakanal  erstellt und so ein Bild mit Transparenz erzeugt.

erstellt und so ein Bild mit Transparenz erzeugt.

Traditionelle Ausschnittmethoden umfassen in der Regel zunächst das Erzeugen oder Erhalten eines Bildes und das anschließende Trennen von Vorder- und Hintergrund mithilfe von Bildbearbeitungstechniken

(z. B. Chroma Key, Kantenerkennung, benutzerdefinierte Masken usw.). Dieser Ansatz erfordert häufig zusätzliche Schritte zur Handhabung der Transparenz und kann bei komplexen Hintergründen oder Kanten zu unnatürlichen Übergängen führen.

LayerDiffusion arbeitet im latenten Raum (latenter Raum), einer Zwischendarstellung, die es dem Modell ermöglicht, komplexere Bildmerkmale zu lernen und zu generieren. Durch die Kodierung der Transparenz im latenten Raum kann das Modell die Transparenz während der Generierung auf natürliche Weise verarbeiten, ohne dass komplexe Berechnungen auf Pixelebene erforderlich sind.

Traditionelle Ausschnitttechnologie wird normalerweise im Pixelraum durchgeführt, was eine direkte Bearbeitung des Originalbildes beinhalten kann, wie z. B. Farbersetzung, Kantenglättung usw. Bei diesen Methoden kann es zu Schwierigkeiten bei der Handhabung durchscheinender Effekte (z. B. Feuer, Rauch) oder komplexer Kanten kommen.

Datensatz und Training

LayerDiffusion verwendet für das Training einen großen Datensatz, der transparente Bildpaare enthält, sodass das Modell die komplexe Verteilung erlernen kann, die zum Generieren hochwertiger transparenter Bilder erforderlich ist.

Herkömmliche Mattierungsmethoden stützen sich möglicherweise auf kleinere Datensätze oder spezifische Trainingssätze, was ihre Fähigkeit zur Bewältigung verschiedener Szenarien einschränken kann.

Flexibilität und Kontrolle

LayerDiffusion bietet mehr Flexibilität und Kontrolle, da es dem Benutzer ermöglicht, die Generierung von Bildern durch Textaufforderungen zu steuern und mehrere Ebenen generieren kann, die gemischt und kombiniert werden können, um komplexe Szenen zu erstellen.

Herkömmliche Ausschneidemethoden haben möglicherweise eine eingeschränktere Kontrolle, insbesondere wenn es um komplexe Bildinhalte und Transparenz geht.Qualitätsvergleich

Benutzeruntersuchungen zeigen, dass von LayerDiffusion generierte transparente Bilder in den meisten Fällen von Benutzern bevorzugt werden(97 %) , was darauf hindeutet, dass der generierte transparente Inhalt optisch mit kommerziellen transparenten Assets vergleichbar und möglicherweise sogar besser ist .

Herkömmliche Ausschneidemethoden erzielen in manchen Fällen möglicherweise nicht die gleiche Qualität, insbesondere bei schwierigen Transparenzen und Kanten. Alles in allem bietet LayerDiffusion eine fortschrittlichere und flexiblere Methode zum Generieren und Verarbeiten transparenter Bilder. Es kodiert Transparenz direkt während des Generierungsprozesses und ist in der Lage, qualitativ hochwertige Ergebnisse zu erzielen, die mit herkömmlichen Ausschnittmethoden nur schwer zu erreichen sind. Über den AutorWie wir gerade erwähnt haben, ist einer der Autoren dieser Studie der Erfinder des berühmten ControlNet –Zhang Lumin.

Er schloss sein Bachelor-Studium an der Universität Suzhou ab. Als Student im ersten Jahr veröffentlichte er zehn hochkarätige Arbeiten. Zhang Lumin studiert derzeit an der Stanford University für seinen Doktortitel, aber man kann sagen, dass er sehr zurückhaltend ist und sich noch nicht einmal bei Google Scholar registriert hat.

Das obige ist der detaillierte Inhalt vonNeues Werk des Autors von ControlNet: KI-Malerei kann in Ebenen unterteilt werden! Das Projekt erhielt 660 Sterne, ohne Open Source zu sein. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So speichern Sie in Pycharm geschriebene Programme

So speichern Sie in Pycharm geschriebene Programme

So entschlüsseln Sie die Bitlocker-Verschlüsselung

So entschlüsseln Sie die Bitlocker-Verschlüsselung

Einführung in die Klassifizierung von Linux-Systemen

Einführung in die Klassifizierung von Linux-Systemen

Was macht Xiaohongshu?

Was macht Xiaohongshu?

Win10-Upgrade-Patch-Methode

Win10-Upgrade-Patch-Methode

So implementieren Sie die Online-Chat-Funktion von Vue

So implementieren Sie die Online-Chat-Funktion von Vue

So reparieren Sie LSP

So reparieren Sie LSP

wie man eine Website erstellt

wie man eine Website erstellt