Hallo Leute, ich bin Luga, heute werden wir über Technologien im Zusammenhang mit dem ökologischen Bereich der künstlichen Intelligenz (KI) sprechen – LLM-Bewertung.

In den letzten Jahren hat die rasante Entwicklung und Verbesserung großer Sprachmodelle (LLM) dazu geführt, dass traditionelle Textbewertungsmethoden in einigen Aspekten nicht mehr anwendbar sind. Im Bereich der Textbewertung haben wir von Methoden wie „Wortvorkommen“-basierten Bewertungsmethoden wie BLEU und „vorab trainierten natürlichen Sprachverarbeitungsmodellen“-basierten Bewertungsmethoden wie BERTScore gehört. Diese Methoden liefern genauere Indikatoren zur Bewertung der Qualität und Ähnlichkeit von Texten. Die rasante Entwicklung des LLM hat neue Herausforderungen und Chancen für den Bereich der Textbewertung mit sich gebracht. Wir müssen die Bewertungsmethoden kontinuierlich erforschen und verbessern, um uns an diesen Entwicklungstrend anzupassen.

Obwohl diese Methoden früher gut funktionierten, scheinen sie mit der Entwicklung der ökologischen LLM-Technologie allmählich nicht mehr leistungsfähig genug zu sein, um die heutigen Anforderungen vollständig zu erfüllen.

Mit der rasanten Entwicklung und Verbesserung des LLM stehen wir vor neuen Herausforderungen und Chancen. Die Fähigkeiten und Leistungsniveaus von LLM nehmen weiter zu, sodass es möglich ist, dass auf Wortvorkommnissen basierende Bewertungsmethoden wie BLEU die Qualität und semantische Genauigkeit von LLM-generiertem Text möglicherweise nicht vollständig erfassen. Im Gegensatz dazu kann LLM einen flüssigeren, kohärenteren und semantisch reichhaltigeren Text generieren, und herkömmliche, auf dem Vorkommen von Wörtern basierende Bewertungsmethoden können diese Vorteile nicht genau messen.

Darüber hinaus stehen Bewertungsmethoden, die auf vorab trainierten Modellen basieren, wie z. B. BERTScore, obwohl sie bei vielen Aufgaben gut funktionieren, auch vor einigen Herausforderungen. Vorab trainierte Modelle berücksichtigen möglicherweise nicht vollständig die einzigartigen Eigenschaften des LLM (Sprachmodells) und seine Leistung bei einer bestimmten Aufgabe. Wenn man sich daher ausschließlich auf Bewertungsmethoden verlässt, die auf vorab trainierten Modellen basieren, können die Fähigkeiten von LLM möglicherweise nicht vollständig bewertet werden. Das bedeutet, dass wir weitere Forschung und Entwicklung neuer Bewertungsmethoden benötigen, um die Leistung und Fähigkeiten von LLMs bei bestimmten Aufgaben genauer beurteilen und verstehen zu können. Dies kann eine aufgabenspezifische Feinabstimmung und Anpassung des LLM umfassen, um den Missionsanforderungen besser gerecht zu werden. Gleichzeitig müssen wir auch die Vielfalt der Bewertungsmethoden berücksichtigen und manuelle Bewertung und andere Messindikatoren kombinieren, um umfassendere und genauere Bewertungsergebnisse zu erhalten. Durch die kontinuierliche Verbesserung und Weiterentwicklung von Evaluationsmethoden können wir das Potenzial von LLM besser verstehen und nutzen und weitere Fortschritte im Bereich der Verarbeitung natürlicher Sprache vorantreiben.

Generell ist die Schnelligkeit und Sensibilität der Methode zur Bewertung der LLM-Beratung wichtig.

Erstens ist die Implementierungsgeschwindigkeit bei der Verwendung von LLM als Leitfaden für die Bewertung normalerweise schneller. Im Vergleich zu bisherigen Assessment-Pipelines erfordert die Erstellung eines LLM-gesteuerten Assessments relativ wenig Aufwand und ist einfach umzusetzen. Für das LLM Guided Assessment müssen nur zwei Dinge vorbereitet werden: eine Textbeschreibung, die die Bewertungskriterien beschreibt, und Beispiele zur Verwendung in der Eingabeaufforderungsvorlage. Im Vergleich zum Aufbau eines eigenen vorab trainierten NLP-Modells oder zur Feinabstimmung eines vorhandenen NLP-Modells, um als Evaluator zu dienen, ist es effizienter, LLM zur Erledigung dieser Aufgaben zu verwenden. Auch die Iteration der Bewertungskriterien erfolgt mit LLM schneller.

Zweitens ist LLM im Allgemeinen sensibler im Vergleich zu vortrainierten NLP-Modellen und den zuvor diskutierten Bewertungsmethoden. Diese Sensibilität wirkt sich in mancher Hinsicht positiv aus und ermöglicht es LLM, mit bestimmten Situationen flexibler umzugehen. Diese Sensibilität kann jedoch auch dazu führen, dass die Ergebnisse der LLM-Bewertung weniger vorhersehbar sind.

Wie wir bereits besprochen haben, sind LLM-Evaluatoren im Vergleich zu anderen Evaluierungsmethoden sensibler. Es gibt jedoch viele verschiedene Möglichkeiten, LLM als Evaluator zu konfigurieren, und sein Verhalten kann je nach gewählter Konfiguration stark variieren. Darüber hinaus besteht eine weitere Herausforderung darin, dass LLM-Evaluatoren möglicherweise stecken bleiben, wenn die Bewertung zu viele Inferenzschritte umfasst oder die gleichzeitige Verarbeitung zu vieler Variablen erfordert. Daher müssen beim Entwerfen und Implementieren von Bewertungen die Konfiguration des LLM und die Komplexität der Bewertungsaufgaben sorgfältig berücksichtigt werden, um genaue und gültige Bewertungsergebnisse sicherzustellen.

Aufgrund der Eigenschaften von LLM können seine Bewertungsergebnisse durch unterschiedliche Konfigurationen und Parametereinstellungen beeinflusst werden. Das bedeutet, dass bei der Bewertung von LLMs das Modell sorgfältig ausgewählt und konfiguriert werden muss, um sicherzustellen, dass es sich wie erwartet verhält. Unterschiedliche Konfigurationen können zu unterschiedlichen Ausgabeergebnissen führen. Daher muss der Bewerter einige Zeit und Mühe aufwenden, um die Einstellungen des LLM anzupassen und zu optimieren, um genaue und zuverlässige Bewertungsergebnisse zu erhalten.

Darüber hinaus können Evaluatoren vor einigen Herausforderungen stehen, wenn sie mit Bewertungsaufgaben konfrontiert werden, die komplexe Überlegungen oder die gleichzeitige Verarbeitung mehrerer Variablen erfordern. Dies liegt daran, dass die Argumentationsfähigkeit von LLM bei der Bewältigung komplexer Situationen eingeschränkt sein kann. Das LLM kann zusätzliche Anstrengungen zur Bewältigung dieser Aufgaben erfordern, um die Genauigkeit und Zuverlässigkeit der Bewertung sicherzustellen.

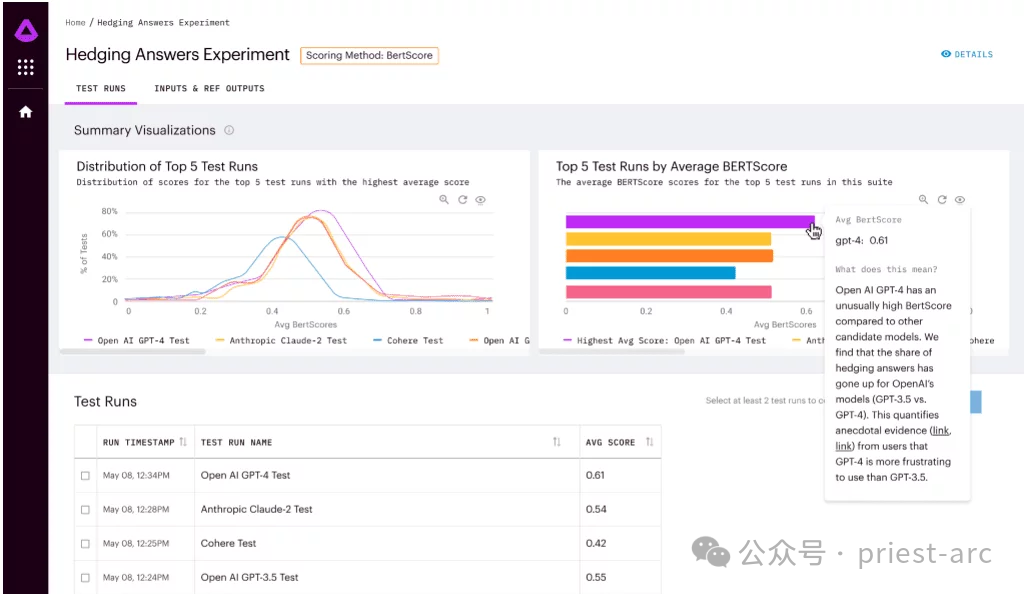

Arthur Bench ist ein Open-Source-Bewertungstool zum Vergleich der Leistung generativer Textmodelle (LLM). Es kann verwendet werden, um verschiedene LLM-Modelle, Hinweise und Hyperparameter zu bewerten und detaillierte Berichte über die LLM-Leistung bei verschiedenen Aufgaben bereitzustellen.

Zu den Hauptmerkmalen von Arthur Bench gehören: Zu den Hauptmerkmalen von Arthur Bench gehören:

Im Allgemeinen umfasst der Arthur Bench-Workflow hauptsächlich die folgenden Phasen, und die detaillierte Analyse ist wie folgt:

In dieser Phase müssen wir unsere Bewertungsziele klären. Arthur Bench unterstützt Mehrere Eine Vielzahl von Bewertungsaufgaben, darunter:

In dieser Phase besteht die Hauptarbeit darin, die Bewertungsobjekte auszuwählen. Arthur Bench unterstützt eine Vielzahl von LLM-Modellen und deckt führende Technologien bekannter Institutionen wie OpenAI, Google AI, Microsoft usw. ab, wie GPT-3, LaMDA, Megatron-Turing NLG usw. Je nach Forschungsbedarf können wir spezifische Modelle zur Evaluierung auswählen.

Nach Abschluss der Modellauswahl besteht der nächste Schritt darin, eine verfeinerte Steuerung durchzuführen. Um die LLM-Leistung genauer zu bewerten, ermöglicht Arthur Bench Benutzern die Konfiguration von Hinweisen und Hyperparametern.

Durch eine verfeinerte Konfiguration können wir die Leistungsunterschiede von LLM unter verschiedenen Parametereinstellungen eingehend untersuchen und Bewertungsergebnisse mit mehr Referenzwert erhalten.

Der letzte Schritt besteht darin, die Aufgabenbewertung mithilfe eines automatisierten Prozesses durchzuführen. Typischerweise bietet Arthur Bench einen automatisierten Bewertungsprozess, der eine einfache Konfiguration zum Ausführen von Bewertungsaufgaben erfordert. Die folgenden Schritte werden automatisch ausgeführt:

Als Schlüssel zur schnellen, datengesteuerten LLM-Bewertung bietet Arthur Bench hauptsächlich die folgenden Lösungen, insbesondere:

Arthur Bench wird sein Fachwissen und seine Erfahrung nutzen, um jede LLM-Option zu bewerten und sicherzustellen, dass konsistente Kennzahlen zum Vergleich ihrer Stärken und Schwächen verwendet werden. Er wird Faktoren wie Modellleistung, Genauigkeit, Geschwindigkeit, Ressourcenanforderungen und mehr berücksichtigen, um sicherzustellen, dass Unternehmen fundierte und klare Entscheidungen treffen können.

Arthur Bench wird sein Fachwissen und seine Erfahrung nutzen, um jede LLM-Option zu bewerten und sicherzustellen, dass konsistente Kennzahlen zum Vergleich ihrer Stärken und Schwächen verwendet werden. Er wird Faktoren wie Modellleistung, Genauigkeit, Geschwindigkeit, Ressourcenanforderungen und mehr berücksichtigen, um sicherzustellen, dass Unternehmen fundierte und klare Entscheidungen treffen können.

Durch die Verwendung konsistenter Metriken und Bewertungsmethoden stellt Arthur Bench Unternehmen einen zuverlässigen Vergleichsrahmen zur Verfügung, der es ihnen ermöglicht, die Vorteile und Einschränkungen jeder LLM-Option vollständig zu bewerten. Dies wird es Unternehmen ermöglichen, fundierte Entscheidungen zu treffen, um die rasanten Fortschritte in der künstlichen Intelligenz zu maximieren und die bestmögliche Erfahrung mit ihren Anwendungen sicherzustellen.

2. Budget- und Datenschutzoptimierung

Dieser Ansatz zur Budgetoptimierung kann Unternehmen dabei helfen, mit begrenzten Ressourcen kluge Entscheidungen zu treffen. Anstatt sich für das teuerste oder modernste Modell zu entscheiden, wählen Sie das richtige Modell basierend auf Ihren spezifischen Anforderungen. Die günstigeren Modelle schneiden in einigen Aspekten möglicherweise etwas schlechter ab als hochmoderne LLMs, aber für einige einfache oder Standardaufgaben kann Arthur Bench dennoch eine Lösung bieten, die den Anforderungen entspricht.

Darüber hinaus betonte Arthur Bench, dass die interne Einführung des Modells eine bessere Kontrolle über den Datenschutz ermöglicht. Für Anwendungen, die sensible Daten oder Datenschutzprobleme betreffen, ziehen es Unternehmen möglicherweise vor, ihre eigenen intern geschulten Modelle zu verwenden, anstatt sich auf externe LLMs von Drittanbietern zu verlassen. Durch den Einsatz interner Modelle können Unternehmen eine größere Kontrolle über die Verarbeitung und Speicherung von Daten erlangen und den Datenschutz besser schützen.

Akademische Benchmarks beziehen sich auf Modellbewertungsindikatoren und -methoden, die in der akademischen Forschung etabliert sind. Diese Indikatoren und Methoden sind in der Regel spezifisch für eine bestimmte Aufgabe oder Domäne und können die Leistung des Modells in dieser Aufgabe oder Domäne effektiv bewerten.

Akademische Benchmarks spiegeln jedoch nicht immer direkt die Leistung eines Modells in der realen Welt wider. Dies liegt daran, dass Anwendungsszenarien in der realen Welt oft komplexer sind und die Berücksichtigung weiterer Faktoren erfordern, wie z. B. Datenverteilung, Modellbereitstellungsumgebung usw.

Arthur Bench hilft dabei, akademische Maßstäbe in reale Leistungen umzusetzen. Dieses Ziel wird auf folgende Weise erreicht:

Als Schlüssel zu einer schnellen, datengesteuerten LLM-Bewertung verfügt Arthur Bench über die folgenden Funktionen:

Der Umfang dieser Bewertungsindikatoren ist sehr breit und umfasst unter anderem Zusammenfassungsqualität, Genauigkeit, Sprachkompetenz, grammatikalische Korrektheit, Kontextverständnisfähigkeit, logische Kohärenz usw. Arthur Bench bewertet jedes Modell anhand dieser Kennzahlen und kombiniert die Ergebnisse zu einer umfassenden Bewertung, um Unternehmen dabei zu unterstützen, fundierte Entscheidungen zu treffen.

Darüber hinaus kann Arthur Bench, wenn das Unternehmen spezifische Bedürfnisse oder Bedenken hat, auch benutzerdefinierte Bewertungsmetriken erstellen und hinzufügen, die auf den Anforderungen des Unternehmens basieren. Dies geschieht, um den spezifischen Bedürfnissen des Unternehmens besser gerecht zu werden und sicherzustellen, dass der Bewertungsprozess mit den Zielen und Standards des Unternehmens übereinstimmt.

2. Lokale und cloudbasierte Versionen

2. Lokale und cloudbasierte Versionen

Andererseits werden für Benutzer, die Komfort und Flexibilität bevorzugen, auch cloudbasierte SaaS-Produkte bereitgestellt. Sie können sich registrieren, um über die Cloud auf Arthur Bench zuzugreifen und es zu nutzen. Diese Methode macht eine umständliche lokale Installation und Konfiguration überflüssig und ermöglicht Ihnen die sofortige Nutzung der bereitgestellten Funktionen und Dienste.

3. Vollständig Open Source

Kurz gesagt bietet Arthur Bench ein offenes und flexibles Framework, das es Benutzern ermöglicht, Bewertungsindikatoren anzupassen, und das im Finanzbereich weit verbreitet ist. Partnerschaften mit Amazon Web Services und Cohere bringen das Framework weiter voran und ermutigen Entwickler, neue Metriken für Bench zu erstellen und zu Fortschritten im Bereich der Sprachmodellbewertung beizutragen.

Referenz:

[1] https://github.com/arthur-ai/benchDas obige ist der detaillierte Inhalt vonErfahren Sie in einem Artikel mehr über die LLM-Bewertung mit Arthur Bench. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

Welche Währung ist STAKE?

Welche Währung ist STAKE?

Tutorial zur Serverguide-Installation

Tutorial zur Serverguide-Installation

Worauf bezieht sich „Schreiben' in Python?

Worauf bezieht sich „Schreiben' in Python?

Verlauf der Oracle-Ansichtstabellenoperationen

Verlauf der Oracle-Ansichtstabellenoperationen

Die Laufumgebung des Java-Programms

Die Laufumgebung des Java-Programms

Tools zur Beurteilung von Vorstellungsgesprächen

Tools zur Beurteilung von Vorstellungsgesprächen

So lösen Sie das Problem, dass die Win11-Antivirensoftware nicht geöffnet werden kann

So lösen Sie das Problem, dass die Win11-Antivirensoftware nicht geöffnet werden kann