Die Mathematik hinter dem Kontextlernen

In-Context Learning (ICL), ein wichtiges Merkmal der modernen Großsprachenmodelle (LLMs), ermöglicht Transformatoren, sich anhand von Beispielen innerhalb der Eingabeaufforderung anzupassen. Nur wenige Schüsse, die mehrere Aufgabenbei Beispiele verwenden, zeigt effektiv das gewünschte Verhalten. Aber wie erreichen Transformatoren diese Anpassung? Dieser Artikel untersucht potenzielle Mechanismen hinter ICL.

Der Kern von ICL ist: Geben Sie beispiele Paare ((x, y)) auf, können Aufmerksamkeitsmechanismen einen Algorithmus lernen, um neue Abfragen (x) ihren Ausgängen (y) zuzuordnen?

Softmax -Aufmerksamkeit und nächste Nachbarsuchung

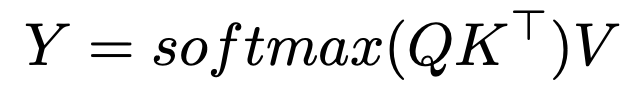

Die Softmax -Aufmerksamkeitsformel lautet:

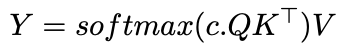

Einführung eines inversen Temperaturparameters, c

, verändert die Aufmerksamkeitszuweisung:

als c nähert sich unendlich, die Aufmerksamkeit wird zu einem HOT-Vektor, der sich ausschließlich auf den ähnlichsten Token konzentriert-effektiv eine nächste Nachbar-Suche. Mit endlicher c

ähnelt die Aufmerksamkeit dem Gaußschen Kernelglättung. Dies deutet darauf hin, dass ICL möglicherweise einen nächsten Nachbaralgorithmus für Eingabe-Output-Paare implementiert.Implikationen und weitere Forschung

Verständnis, wie Transformatoren Algorithmen lernen (wie der nächste Nachbarn), öffnet Türen für Automl. Hollmann et al. Demonstriertes Training eines Transformators auf synthetischen Datensätzen, um die gesamte Automl -Pipeline zu erlernen, die optimale Modelle und Hyperparameter aus neuen Daten in einem einzigen Pass vorherzusagen.

Die 2022 -Forschung von

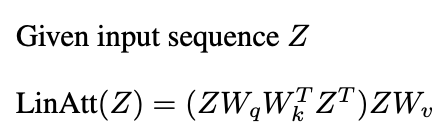

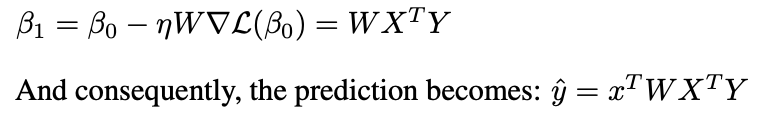

Anthropic legt "Induktionsköpfe" als Mechanismus vor. Diese Paare von Aufmerksamkeitsköpfen kopieren und vollständige Muster; Zum Beispiel geben sie "... a, b ... a" voraus, "B" basierend auf früheren Kontext.Neuere Studien (Garg et al. 2022, Oswald et al. 2023) verbinden die ICL der Transformatoren mit Gradientenabstieg. Lineare Aufmerksamkeit, die Softmax -Operation weglassen:

ähnelt vorkonditionierter Gradientenabfälle (PGD):

Eine Schicht der linearen Aufmerksamkeit führt einen PGD -Schritt aus.

Schlussfolgerung

Aufmerksamkeitsmechanismen können Lernalgorithmen implementieren und ICL ermöglichen, indem sie aus Demonstrationspaaren lernen. Während das Zusammenspiel mehrerer Aufmerksamkeitsschichten und MLPs komplex ist, wirft die Forschung auf die ICL -Mechanik auf. Dieser Artikel bietet einen hochrangigen Überblick über diese Erkenntnisse.

Weiteres Lesen:

- In-Kontext-Lern- und Induktionsköpfe

- Was können Transformatoren in Kontexten lernen? Eine Fallstudie von einfachen Funktionsklassen

- Transformatoren lernen in Kontext durch Gradientenabstieg

- Transformatoren lernen, vorkonditionierte Gradientenabstiegungen für das Lernen in Kontext zu implementieren

Bestätigung

Dieser Artikel ist vom Herbst 2024 Graduiertenkurs an der Universität von Michigan inspiriert. Fehler sind ausschließlich die des Autors.

Das obige ist der detaillierte Inhalt vonDie Mathematik hinter dem Kontextlernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Von Tools bis zu Teamkollegen: Wie KI -Agenten digitale Arbeit werden werden

Jul 19, 2025 am 11:19 AM

Von Tools bis zu Teamkollegen: Wie KI -Agenten digitale Arbeit werden werden

Jul 19, 2025 am 11:19 AM

Verständnis der transformativen Kraft von Agenten -Aithe -Zahlen sprechen Bände: Grand View -Forschung sagt voraus, dass der globale AI -Agentenmarkt bis 2030 von 5 Milliarden US -Dollar in 2024 auf 50 Milliarden US -Dollar steigen wird, was eine jährliche Wachstumsrate von 46% entspricht. Noch signifikanter

Von Eingabeaufforderungen bis hin zu Produkten: Das Geschäft mit No-Code-KI boomt

Jul 26, 2025 am 11:13 AM

Von Eingabeaufforderungen bis hin zu Produkten: Das Geschäft mit No-Code-KI boomt

Jul 26, 2025 am 11:13 AM

Was die Akquisition hervorhebt, war nicht nur die finanzielle Zahl, sondern die unkonventionelle Reise, die das Unternehmen unternahm. Base44 verfolgte niemals Risikokapital oder haftete an der traditionellen Silicon Valley -Formel. Stattdessen zeigte es diesen Witz

Orchestrieren Beratung zur psychischen Gesundheit über mehrere KI-basierte Personas diagnostizierte menschliche psychische Störungen

Jul 19, 2025 am 11:15 AM

Orchestrieren Beratung zur psychischen Gesundheit über mehrere KI-basierte Personas diagnostizierte menschliche psychische Störungen

Jul 19, 2025 am 11:15 AM

Let’s talk about it. Diese Analyse von AI -Durchbrüchen ist Teil meiner laufenden Forbes -Säulenberichterstattung über die neueste in der KI, einschließlich der Identifizierung und Erklärung verschiedener wirksamer KI -Komplexitäten (siehe Link hier). AI And Mental Health Therapy As a q

Die KI -Preisgestaltung von Delta Airlines könnte eine Kundendienstkrise auslösen

Jul 19, 2025 am 11:16 AM

Die KI -Preisgestaltung von Delta Airlines könnte eine Kundendienstkrise auslösen

Jul 19, 2025 am 11:16 AM

Delta Airlines hat einen Plan, dass ProfitDelta Airlines stark in KI investiert, um den Umsatz zu steigern. Die Fluggesellschaft zielt darauf ab, die KI-basierten Preisgestaltung von nur 3% der Tickets auf 20% bis Ende des Jahres zu erweitern. Während Unternehmensleiter optimistisch sind

KI ohne Datendisziplin ist nur ein Hype, sagt JPMorganChase -CPO für Daten und KI

Jul 19, 2025 am 11:17 AM

KI ohne Datendisziplin ist nur ein Hype, sagt JPMorganChase -CPO für Daten und KI

Jul 19, 2025 am 11:17 AM

Laut Gerard Francis, Chief Product Officer von JPMorganCase für KI und Daten, ist die gesamte Aufregung um AI ohne eine strukturierte, unternehmensweite Datenstrategie bedeutungslos. Sprechen Sie während eines Kunden in Snowflake Summit 2025 - wo

KI wird den „unendlichen Arbeitstag' verschlimmern - es sei denn, wir handeln anders

Jul 22, 2025 am 11:12 AM

KI wird den „unendlichen Arbeitstag' verschlimmern - es sei denn, wir handeln anders

Jul 22, 2025 am 11:12 AM

Dieser unendliche Arbeitstag wird von den Realitäten globaler Teams und hybriden Arbeiten sowie unangemessenen Erwartungen der ständigen Verfügbarkeit angeheizt. Das Ergebnis? Eine Belegschaft, die darum kämpft, mitzuhalten

Zeugen wir die Geburt der Maschinenpsychologie?

Jul 24, 2025 am 11:12 AM

Zeugen wir die Geburt der Maschinenpsychologie?

Jul 24, 2025 am 11:12 AM

Eine kürzlich von Artsmart.ai kürzlich durchgeführte Umfrage ergab, dass „32% der Teilnehmer in Betracht ziehen würden, KI für die Therapie zu verwenden, anstatt einen menschlichen Therapeuten zu sehen“. Ungefähr zur gleichen Zeit hob NPR neue Erkenntnisse hervor, die darauf hinwiesen: „Mit dem richtigen Training können KI -Chatbots können

Die Anzahl der Fragen, die AGI und KI -Superintelligenz für den Nachweis der Intelligenz beantworten müssen

Jul 21, 2025 am 11:09 AM

Die Anzahl der Fragen, die AGI und KI -Superintelligenz für den Nachweis der Intelligenz beantworten müssen

Jul 21, 2025 am 11:09 AM

Dies ist mehr als nur ein akademisches philosophisches Problem. Irgendwann sollten wir bereit sein, uns zuzustimmen, ob das Aufkommen von ASI und ASI erreicht wurde. Die wahrscheinliche Möglichkeit, dies zu tun