Seit Neural Radiance Fields im Jahr 2020 vorgeschlagen wurde, hat die Anzahl verwandter Arbeiten exponentiell zugenommen. Es hat sich nicht nur zu einem wichtigen Zweig der dreidimensionalen Rekonstruktion entwickelt, sondern ist auch nach und nach als wichtiges Werkzeug für die autonome Forschung aktiv geworden Fahren.

NeRF ist in den letzten zwei Jahren plötzlich aufgetaucht, hauptsächlich weil es die Merkmalspunktextraktion und -anpassung, die epipolare Geometrie und Triangulation, PnP plus Bündelanpassung und andere Schritte der traditionellen CV-Rekonstruktionspipeline überspringt und sogar die Netzrekonstruktion, Kartierung usw. überspringt Erlernen Sie ein Strahlungsfeld direkt aus einem 2D-Eingabebild und geben Sie dann ein gerendertes Bild aus dem Strahlungsfeld aus, das einem echten Foto nahekommt. Mit anderen Worten: Lassen Sie ein implizites 3D-Modell, das auf einem neuronalen Netzwerk basiert, das 2D-Bild aus einer bestimmten Perspektive anpassen und sorgen Sie dafür, dass es sowohl über neue Perspektivensynthese als auch über neue Fähigkeiten verfügt. Die Entwicklung von NeRF steht auch in engem Zusammenhang mit dem autonomen Fahren, was sich insbesondere in der Anwendung realer Szenenrekonstruktionen und autonomer Fahrsimulatoren widerspiegelt. NeRF eignet sich gut zum Rendern von Bildern auf Fotoebene, sodass mit NeRF modellierte Straßenszenen äußerst realistische Trainingsdaten für autonomes Fahren liefern können. NeRF-Karten können bearbeitet werden, um Gebäude, Fahrzeuge und Fußgänger in verschiedenen Ecken zu kombinieren, die in der Realität schwer zu erfassen sind. case kann verwendet werden, um die Leistung von Algorithmen wie Wahrnehmung, Planung und Hindernisvermeidung zu testen. Daher ist NeRF ein Zweig der 3D-Rekonstruktion und ein Modellierungswerkzeug. Die Beherrschung von NeRF ist zu einer unverzichtbaren Fähigkeit für Forscher geworden, die Rekonstruktionen oder autonomes Fahren durchführen.

Heute werde ich die Inhalte rund um Nerf und autonomes Fahren klären.

Die Neufassung Inhalt ist: NeRF: Neural Radiation Field Representation of Scenes for View Synthesis. Im ersten Artikel von ECCV2020

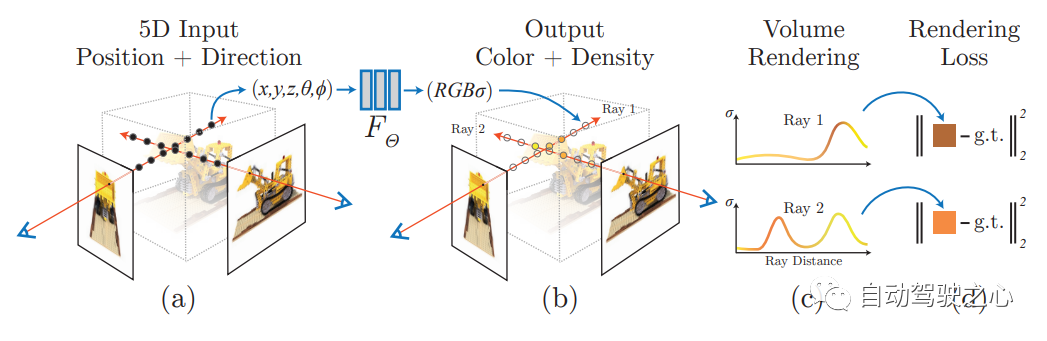

wird eine Nerf-Methode vorgeschlagen, die einen spärlichen Eingabeansichtssatz verwendet, um die zugrunde liegende Szenenfunktion mit kontinuierlichem Volumen zu optimieren und die neuesten Ansichtsergebnisse für die Synthese komplexer Szenen zu erzielen. Dieser Algorithmus verwendet ein vollständig verbundenes (nicht faltendes) tiefes Netzwerk zur Darstellung der Szene. Die Eingabe ist eine einzelne kontinuierliche 5D-Koordinate (einschließlich räumlicher Position (x, y, z) und Blickrichtung (θ, ξ)) und die Ausgabe ist die räumliche Position der Volumendichte und der ansichtsbezogenen Emissionsstrahlung.

NERF verwendet 2D-gestellte Bilder als Überwachung. Es ist nicht erforderlich, das Bild zu falten. Stattdessen lernt es eine Reihe impliziter Parameter durch kontinuierliches Erlernen der Positionskodierung und Verwendung der Bildfarbe als Aufsicht, Darstellung komplexer 3D-Szenen. Durch implizite Darstellung kann das Rendern aus jeder Perspektive abgeschlossen werden.

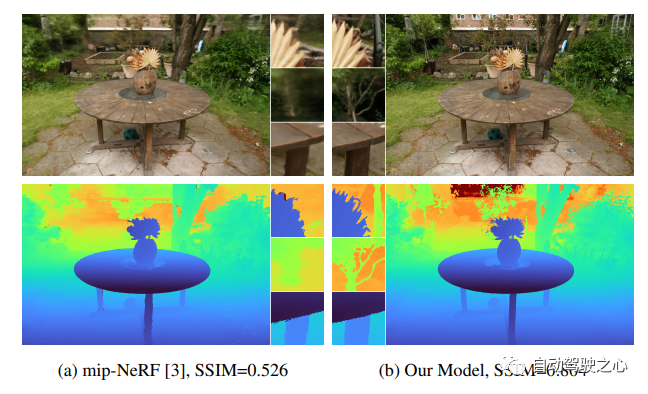

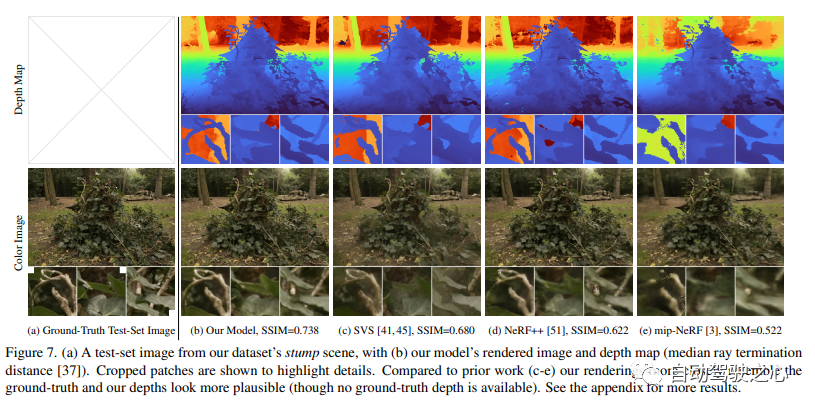

Der Forschungsinhalt von CVPR2020 befasst sich mit grenzenlosen Außenszenen. Darunter ist Mip-NeRF 360: Boundless Anti-Aliasing Neural Radiation Field eine der Forschungsrichtungen im Objekt und in kleinen begrenzten Raumbereichen, aber in „grenzenlosen“ Szenen, in denen die Kamera in jede Richtung gerichtet werden kann und der Inhalt in jeder Entfernung vorhanden sein kann, sind sie jedoch schwierig zu erreichen. In diesem Fall erzeugen vorhandene NeRF-ähnliche Modelle häufig unscharfe oder niedrig aufgelöste Darstellungen (aufgrund unausgeglichener Details und Skalierung von nahen und entfernten Objekten), sind langsamer zu trainieren und leiden möglicherweise unter einer schlechten Rekonstruktion aus einer Reihe kleiner Bilder erscheinen aufgrund der inhärenten Mehrdeutigkeit der Aufgabe in großen Szenen. In diesem Artikel wird eine Erweiterung von mip-NeRF vorgeschlagen, einer NeRF-Variante, die Sampling- und Aliasing-Probleme löst und nichtlineare Szenenparametrisierung, Online-Destillation und einen neuen verzerrungsbasierten Regularisierer verwendet, um die Probleme zu überwinden, die durch unbegrenzte Szenenherausforderungen entstehen. Es erreicht eine Reduzierung des mittleren quadratischen Fehlers um 57 % im Vergleich zu mip-NeRF und ist in der Lage, realistische synthetische Ansichten und detaillierte Tiefenkarten für hochkomplexe, grenzenlose reale Szenen zu generieren.

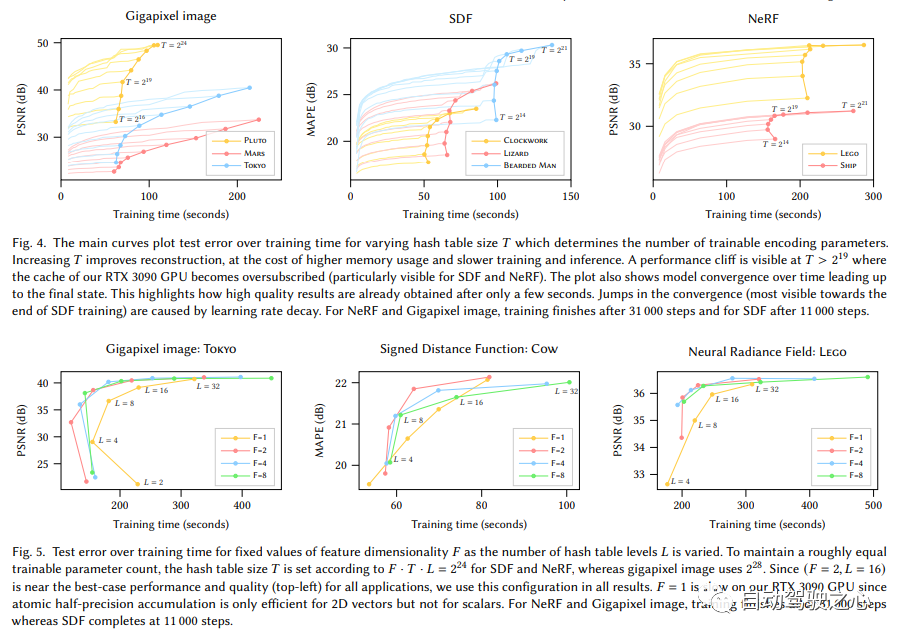

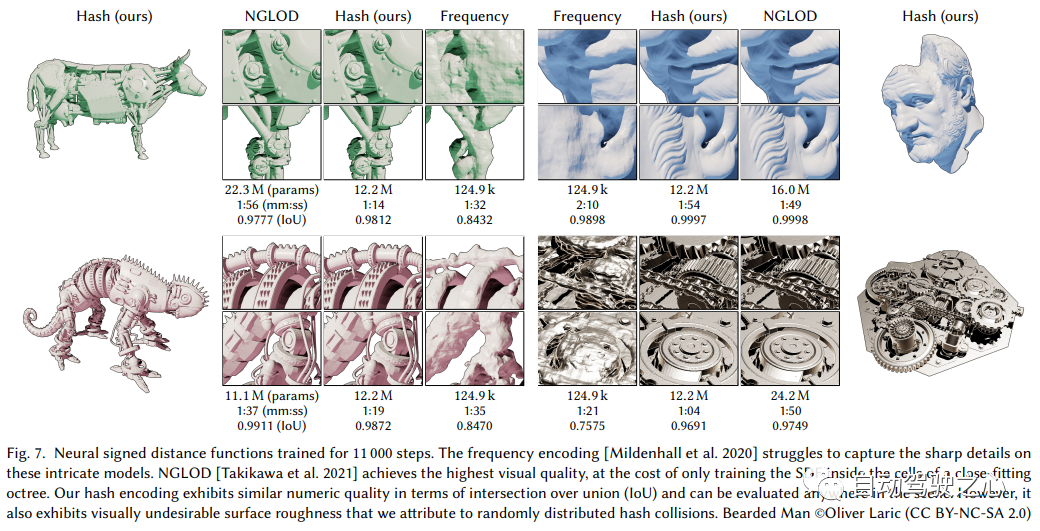

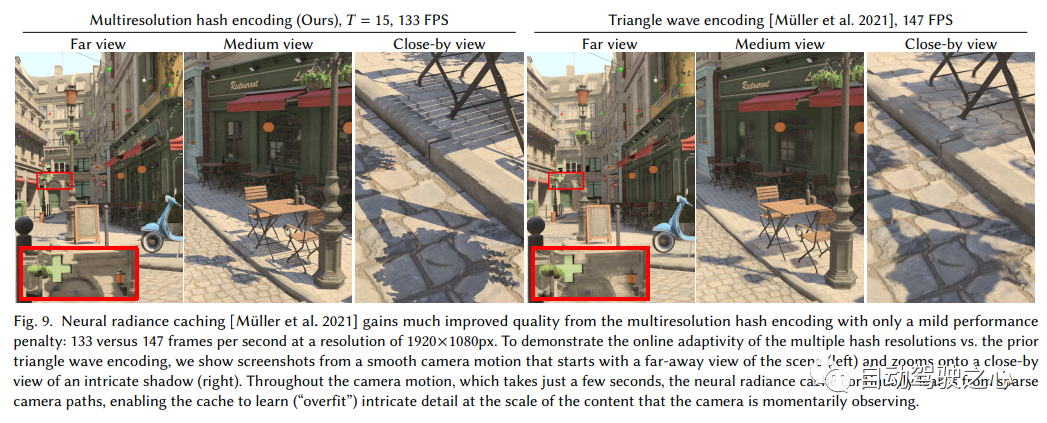

3.Instant-NGP

muss neu geschrieben werden: Link: https://nvlabs.github.io/instant-ngp

Werfen wir zunächst einen Blick auf die Ähnlichkeiten und Unterschiede zwischen Instant-NGP und NeRF:

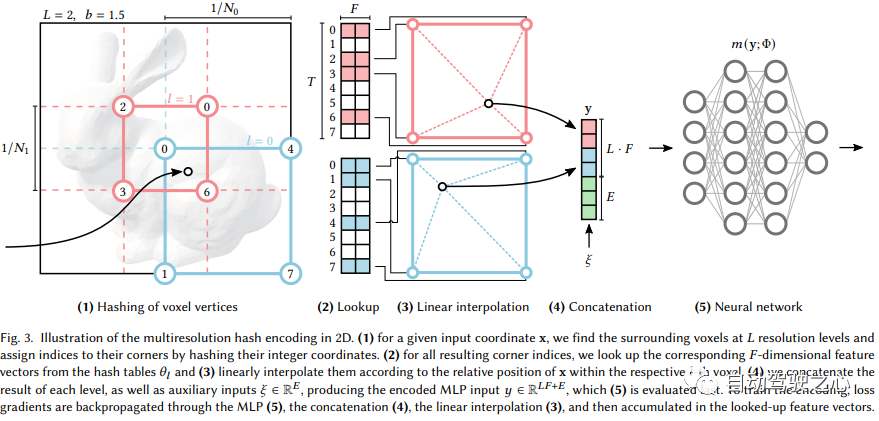

Es ist ersichtlich, dass der große Rahmen immer noch derselbe ist. Der wichtigste Unterschied besteht darin, dass NGP das parametrisierte Voxelgitter als Szenenausdruck ausgewählt hat. Durch Lernen werden die im Voxel gespeicherten Parameter zur Form der Szenendichte. Das größte Problem bei MLP ist, dass es langsam ist. Um die Szene mit hoher Qualität zu rekonstruieren, ist oft ein relativ großes Netzwerk erforderlich, und es wird viel Zeit in Anspruch nehmen, das Netzwerk für jeden Abtastpunkt zu durchlaufen. Die Interpolation innerhalb des Rasters ist viel schneller. Wenn das Raster jedoch hochpräzise Szenen ausdrücken möchte, sind Voxel mit hoher Dichte erforderlich, was zu einem extrem hohen Speicherverbrauch führt. Angesichts der Tatsache, dass es in der Szene viele leere Stellen gibt, hat NVIDIA eine spärliche Struktur vorgeschlagen, um die Szene auszudrücken. F2-NeRF

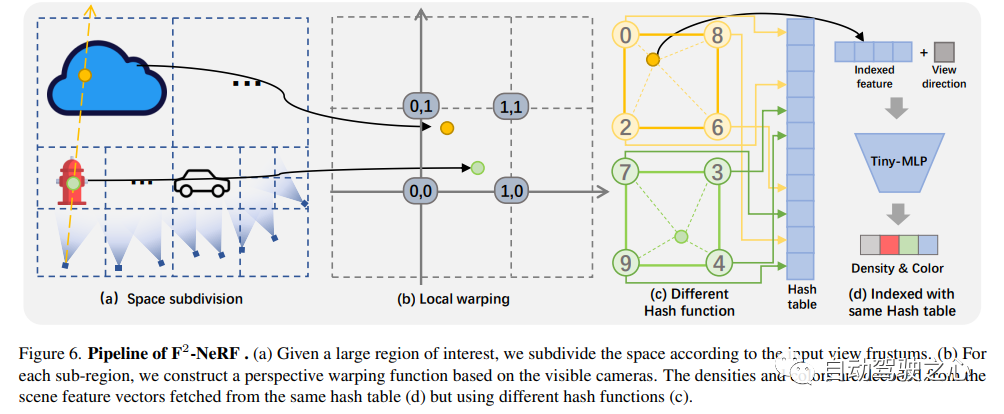

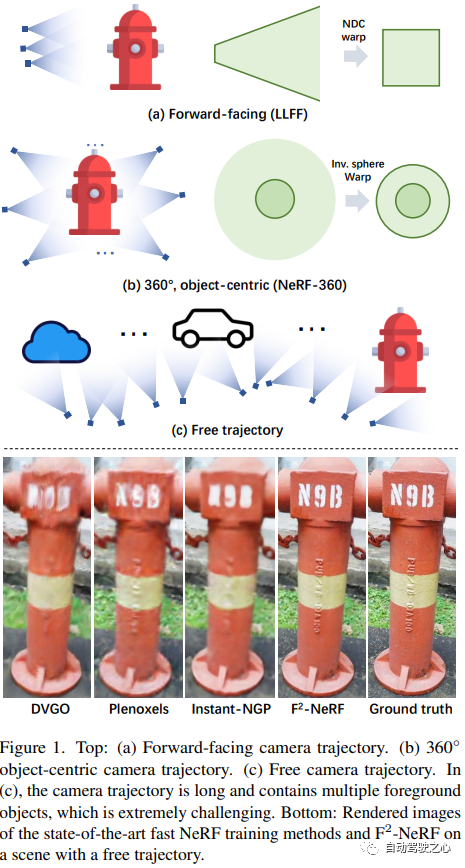

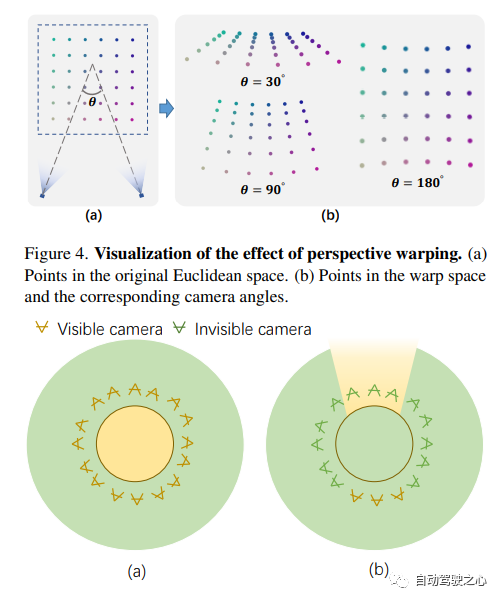

F2-NeRF: Schnelles Neural Radiance Field Training mit kostenlosen Kameratrajektorien

F2-NeRF: Schnelles Neural Radiance Field Training mit kostenlosen Kameratrajektorien

Link zum Papier: https://totoro97.github.io /projects/f2-nerf/

Echtzeit-Rendering-Anwendung auf der mobilen Seite, die die Funktion des Nerf-Exports von Mesh realisiert, und diese Technologie wurde von der CVPR2023-Konferenz übernommen!

MobileNeRF: Nutzung der Polygon-Rasterisierungspipeline für effizientes Rendern neuronaler Felder auf mobilen Architekturen.

Neural Radiation Field (NeRF) wurde bewiesen Die erstaunliche Fähigkeit, 3D-Szenenbilder aus neuartigen Ansichten zu synthetisieren. Sie stützen sich jedoch auf spezielle volumetrische Rendering-Algorithmen, die auf Ray Marching basieren und nicht mit den Fähigkeiten weit verbreiteter Grafikhardware mithalten können. In diesem Artikel wird eine neue texturierte, polygonbasierte NeRF-Darstellung vorgestellt, mit der neue Bilder über Standard-Rendering-Pipelines effizient synthetisiert werden können. NeRF wird als eine Reihe von Polygonen dargestellt, deren Textur binäre Opazität und Merkmalsvektoren darstellt. Beim herkömmlichen Rendern von Polygonen mithilfe eines Z-Puffers wird ein Bild erzeugt, in dem jedes Pixel Eigenschaften aufweist, die von einem kleinen ansichtsabhängigen MLP interpretiert werden, das im Fragment-Shader ausgeführt wird, um die endgültige Pixelfarbe zu erzeugen. Dieser Ansatz ermöglicht es NeRF, mithilfe einer herkömmlichen Polygon-Rasterisierungspipeline zu rendern, die eine massive Parallelität auf Pixelebene bietet und interaktive Bildraten auf einer Vielzahl von Computerplattformen, einschließlich Mobiltelefonen, ermöglicht.

Neural Radiation Field (NeRF) wurde bewiesen Die erstaunliche Fähigkeit, 3D-Szenenbilder aus neuartigen Ansichten zu synthetisieren. Sie stützen sich jedoch auf spezielle volumetrische Rendering-Algorithmen, die auf Ray Marching basieren und nicht mit den Fähigkeiten weit verbreiteter Grafikhardware mithalten können. In diesem Artikel wird eine neue texturierte, polygonbasierte NeRF-Darstellung vorgestellt, mit der neue Bilder über Standard-Rendering-Pipelines effizient synthetisiert werden können. NeRF wird als eine Reihe von Polygonen dargestellt, deren Textur binäre Opazität und Merkmalsvektoren darstellt. Beim herkömmlichen Rendern von Polygonen mithilfe eines Z-Puffers wird ein Bild erzeugt, in dem jedes Pixel Eigenschaften aufweist, die von einem kleinen ansichtsabhängigen MLP interpretiert werden, das im Fragment-Shader ausgeführt wird, um die endgültige Pixelfarbe zu erzeugen. Dieser Ansatz ermöglicht es NeRF, mithilfe einer herkömmlichen Polygon-Rasterisierungspipeline zu rendern, die eine massive Parallelität auf Pixelebene bietet und interaktive Bildraten auf einer Vielzahl von Computerplattformen, einschließlich Mobiltelefonen, ermöglicht.

Unsere Arbeiten zur visuellen Echtzeitlokalisierung und NeRF-Kartierung wurden in CVPR2023 aufgenommen

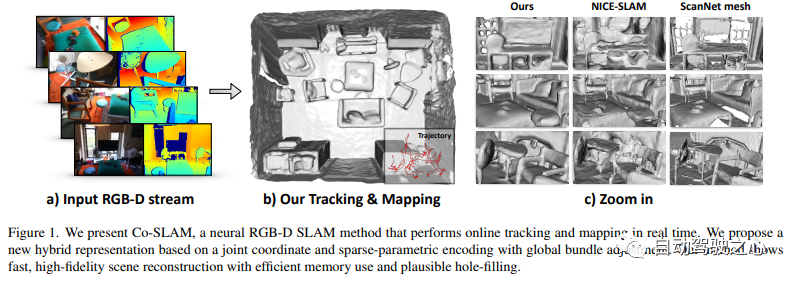

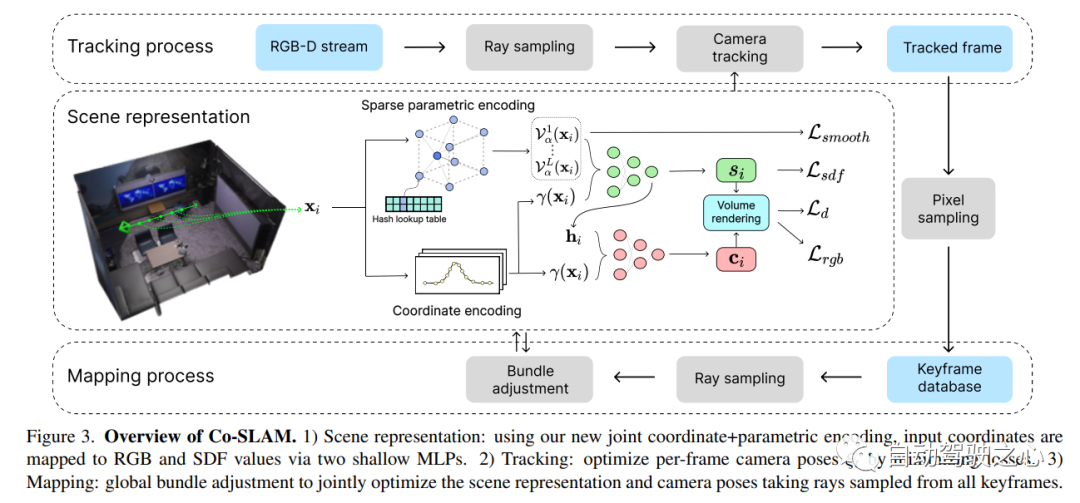

Co-SLAM: Joint Coordinate and Sparse Parametric Encodings for Neural Real-Time SLAM

Link zum Papier : https://arxiv.org/pdf/2304.14377.pdf

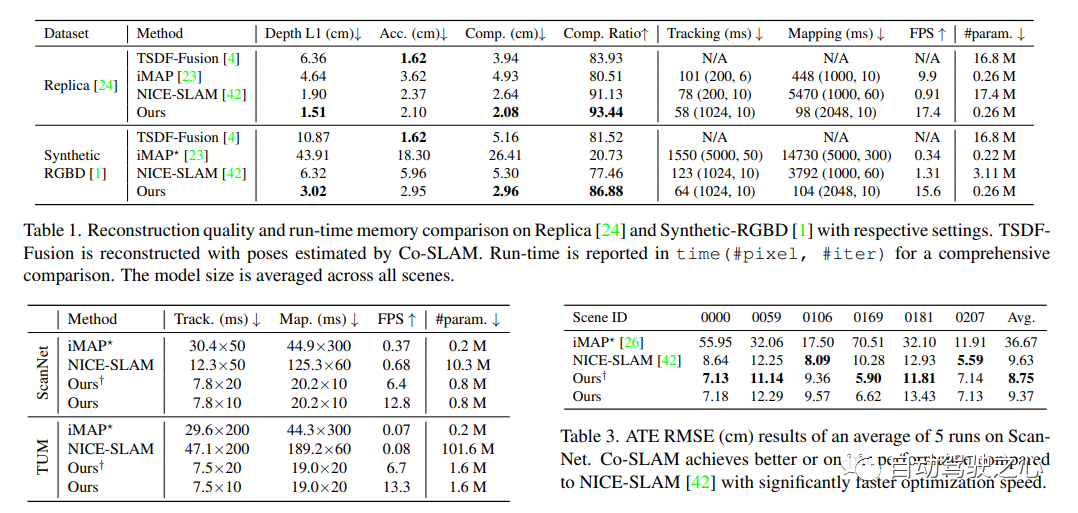

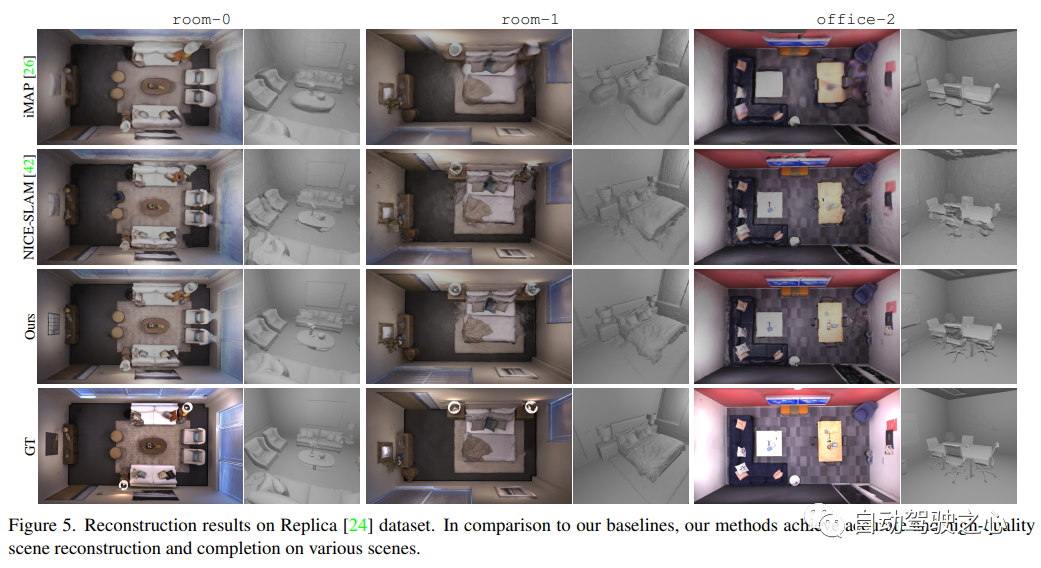

Co-SLAM ist ein Echtzeit-RGB-D-SLAM-System, das neuronale implizite Darstellungen für die Kameraverfolgung und die hochauflösende Oberflächenrekonstruktion verwendet. Co-SLAM stellt die Szene als Hash-Gitter mit mehreren Auflösungen dar, um seine Fähigkeit zur schnellen Konvergenz und Darstellung lokaler Merkmale zu nutzen. Darüber hinaus verwendet Co-SLAM zur Integration von Priorisierungen der Oberflächenkonsistenz eine Blockkodierungsmethode, die beweist, dass es die Szenenvervollständigung in unbeobachteten Bereichen wirkungsvoll abschließen kann. Unsere gemeinsame Kodierung vereint die Vorteile von Co-SLAMs Geschwindigkeit, High-Fidelity-Rekonstruktion und Oberflächenkonsistenz. Durch eine Ray-Sampling-Strategie ist Co-SLAM in der Lage, Anpassungen an allen Keyframes global zu bündeln.

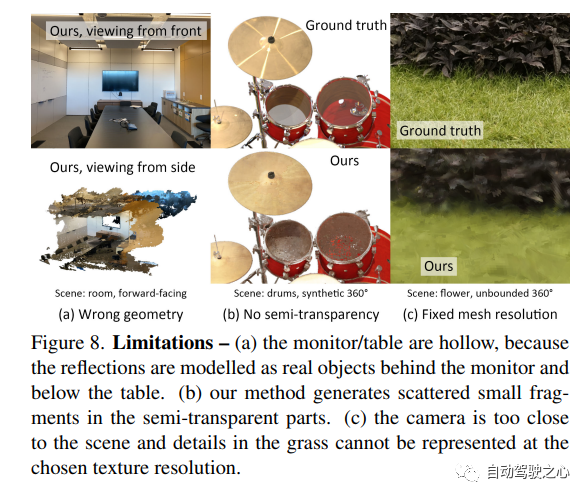

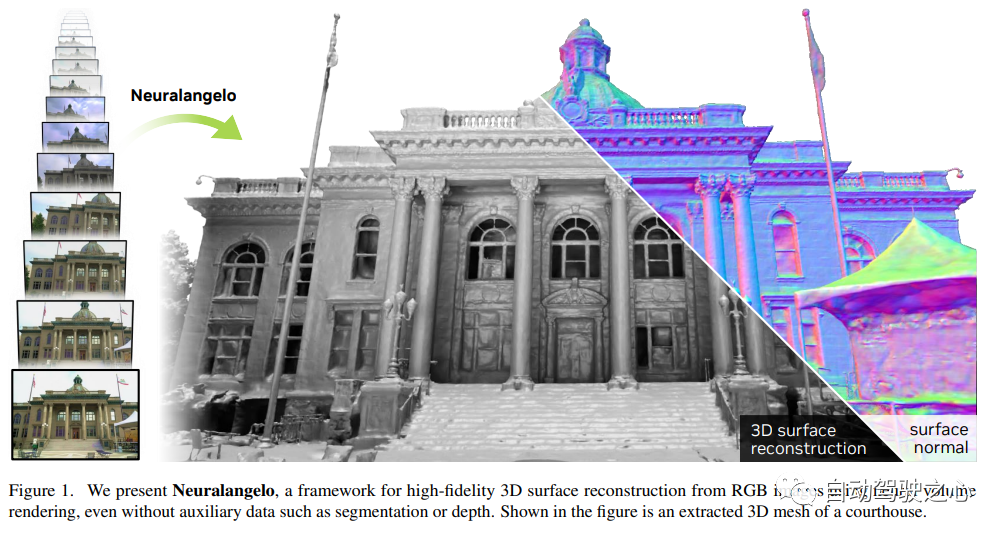

Die derzeit beste NeRF-Oberflächenrekonstruktionsmethode (CVPR2023)

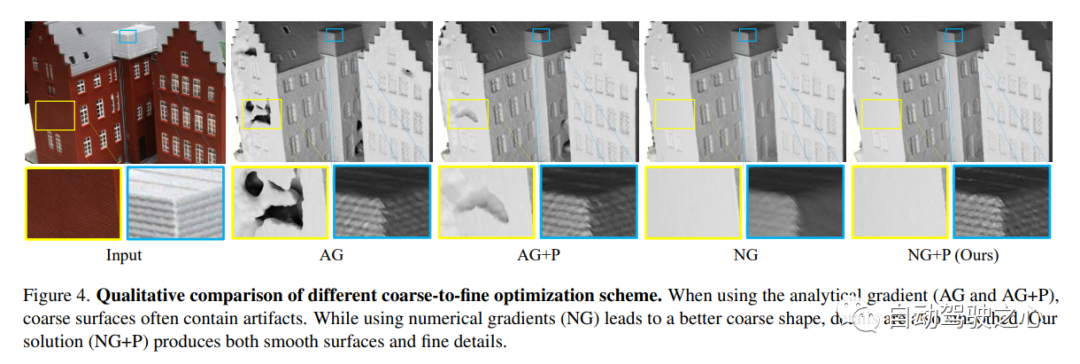

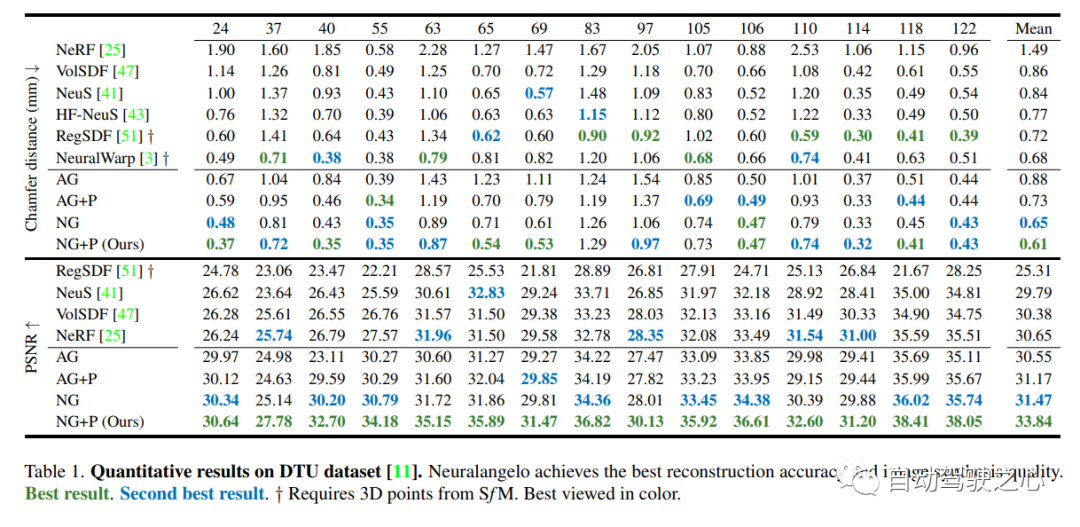

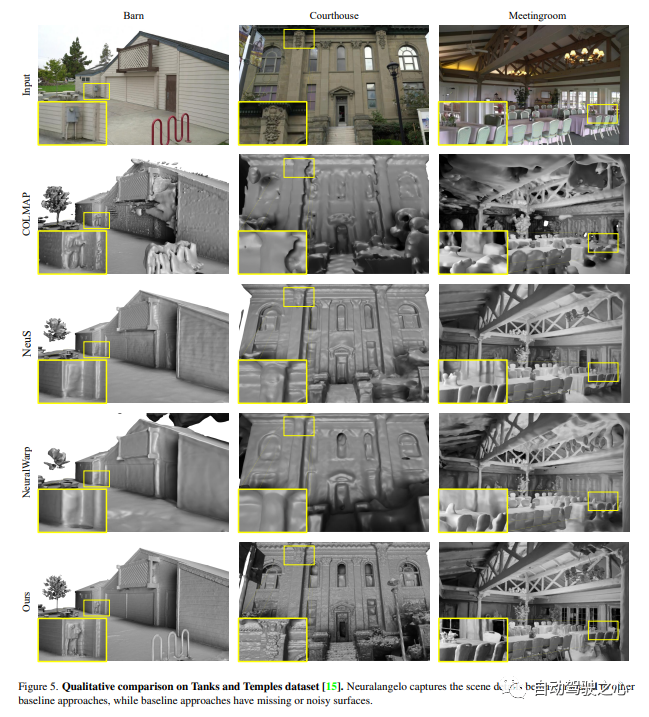

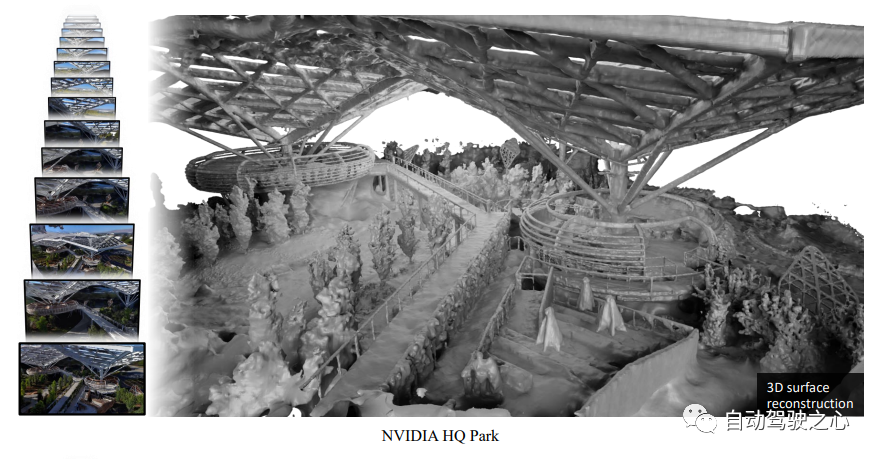

Der neu geschriebene Inhalt ist wie folgt: Es hat sich gezeigt, dass bildbasiertes neuronales Rendering in der Lage ist, neuronale Oberflächen zu rekonstruieren, um dichte 3D-Strukturen wiederherzustellen. Aktuelle Methoden haben jedoch immer noch Schwierigkeiten, die detaillierte Struktur realer Szenen wiederherzustellen. Um dieses Problem zu lösen, schlägt diese Studie eine Methode namens Neuralangelo vor, die die Darstellungsmöglichkeiten von 3D-Hash-Gittern mit mehreren Auflösungen mit neuronalem Oberflächenrendering kombiniert. Zwei Schlüsselelemente dieses Ansatzes sind:

(1) Numerische Gradienten zur Berechnung von Ableitungen höherer Ordnung als Glättungsoperationen und (2) Steuerung der Grob-zu-Fein-Optimierung auf Hash-Gittern auf verschiedenen Detailebenen.

Auch ohne Hilfseingaben wie Tiefe ist Neuralangelo immer noch in der Lage, dichte 3D-Oberflächenstrukturen aus Multi-View-Bildern effektiv wiederherzustellen. Die Wiedergabetreue ist im Vergleich zu früheren Methoden erheblich verbessert und ermöglicht eine detaillierte großflächige Szenenrekonstruktion aus der RGB-Videoaufnahme!

Das erste Open-Source-NeRF-Simulationstool für autonomes Fahren.

Was neu geschrieben werden muss, ist: https://arxiv.org/pdf/2307.15058.pdf

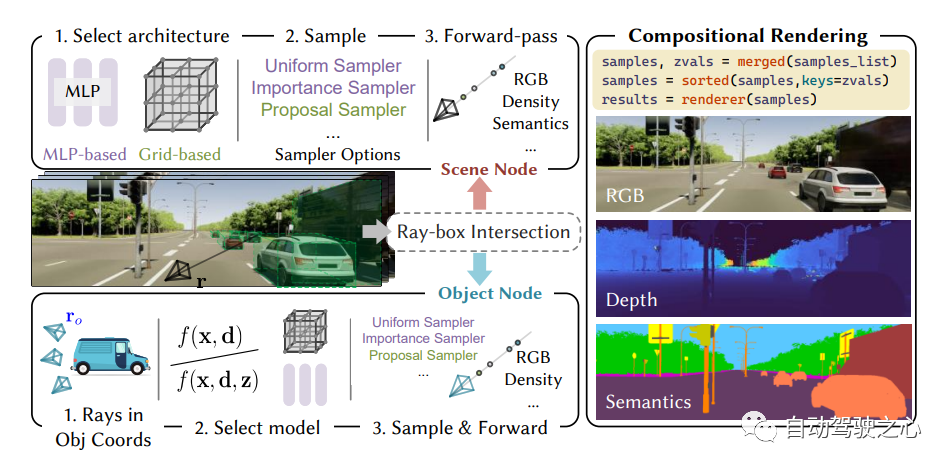

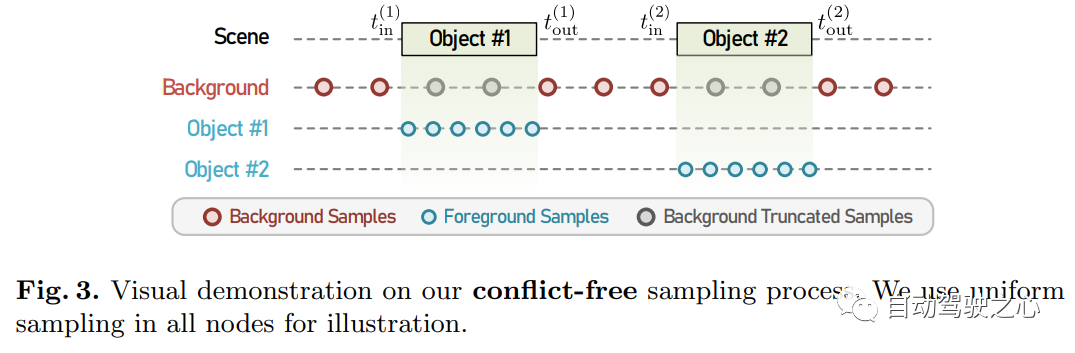

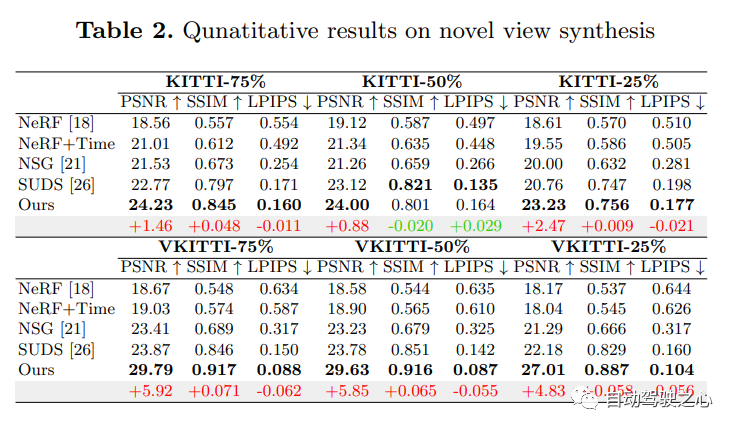

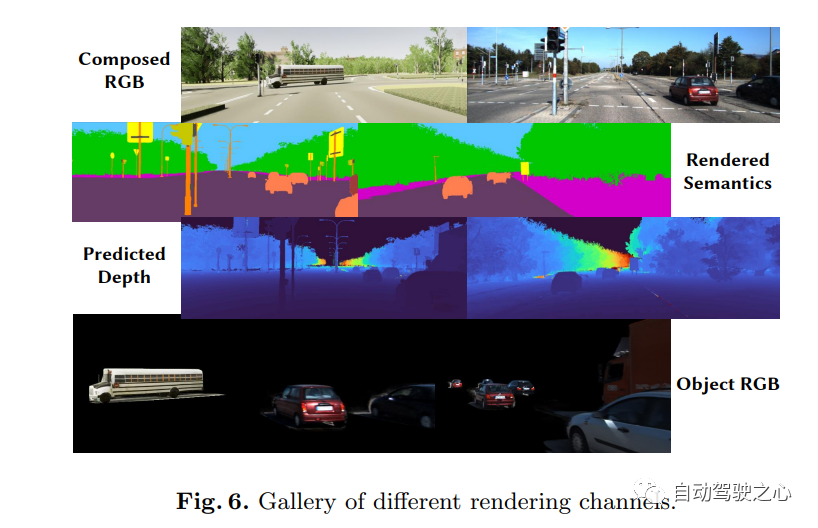

Selbstfahrende Autos können in normalen Situationen reibungslos fahren, und es ist allgemein anerkannt, dass realistische Sensorsimulationen bei der Lösung eine Rolle spielen werden Die übrigen Ecksituationen spielen eine Schlüsselrolle. Zu diesem Zweck schlägt MARS einen autonomen Fahrsimulator vor, der auf neuronalen Strahlungsfeldern basiert. Im Vergleich zu bestehenden Werken weist MARS drei Besonderheiten auf: (1) Instanzbewusstsein. Der Simulator modelliert Vordergrundinstanzen und Hintergrundumgebungen separat mithilfe separater Netzwerke, sodass die statischen (z. B. Größe und Erscheinungsbild) und dynamischen (z. B. Flugbahn) Eigenschaften der Instanzen separat gesteuert werden können. (2) Modularität. Der Simulator ermöglicht den flexiblen Wechsel zwischen verschiedenen modernen NeRF-bezogenen Backbones, Sampling-Strategien, Eingabemodi usw. Es besteht die Hoffnung, dass dieser modulare Aufbau den akademischen Fortschritt und den industriellen Einsatz von NeRF-basierten autonomen Fahrsimulationen fördern kann. (3) Echt. Der Simulator ist für modernste fotorealistische Ergebnisse bei optimaler Modulauswahl ausgelegt.

Der wichtigste Punkt ist: Open Source!

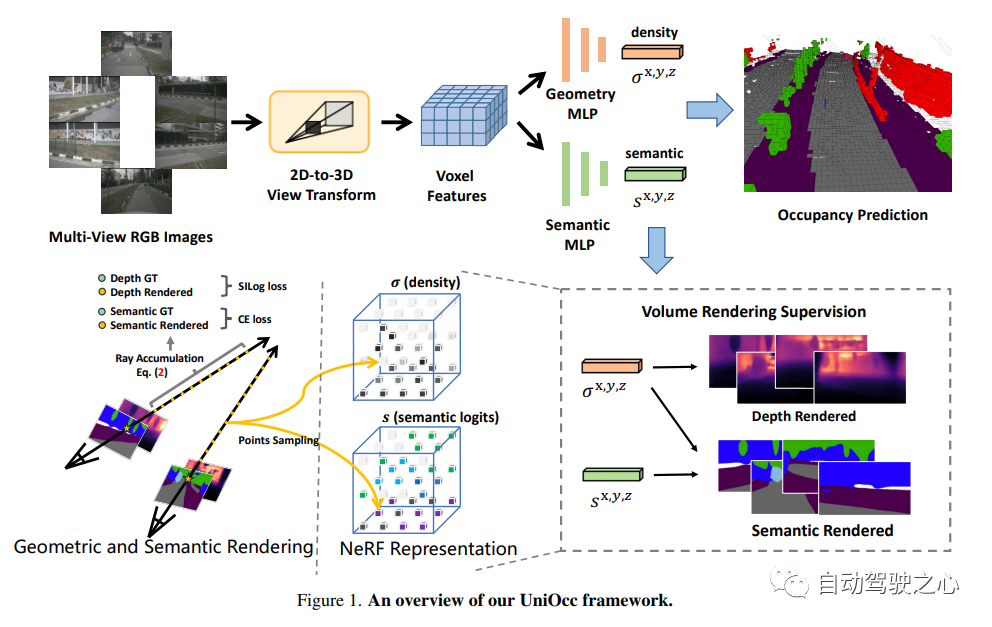

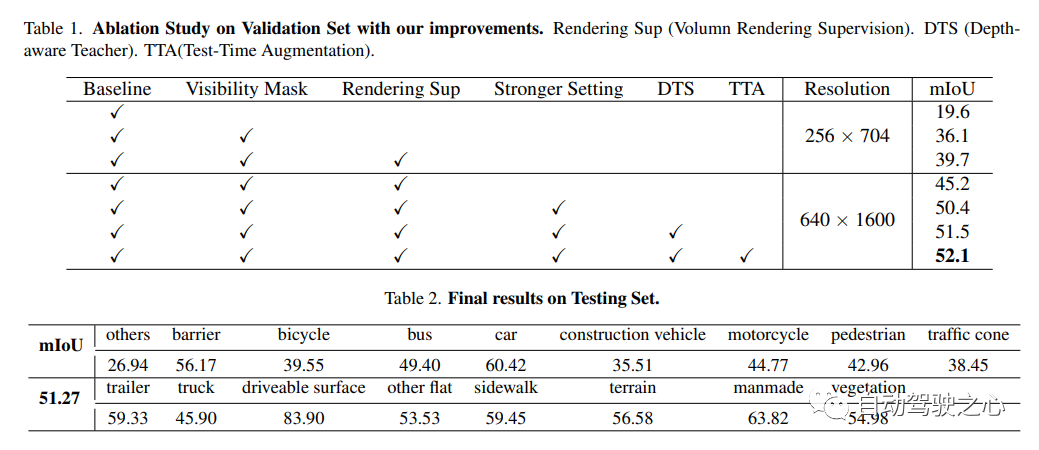

UniOCC ist eine visionsorientierte 3D-Belegungsvorhersagemethode. Herkömmliche Belegungsvorhersagemethoden verwenden hauptsächlich 3D-Belegungsetiketten, um die Projektionsmerkmale des 3D-Raums zu optimieren. Der Generierungsprozess dieser Etiketten ist jedoch komplex und teuer, basiert auf semantischen 3D-Anmerkungen, ist durch die Voxelauflösung begrenzt und kann keinen feinkörnigen Raum liefern . Semantik. Um dieses Problem anzugehen, schlägt dieses Papier eine neue Methode zur Vorhersage der einheitlichen Belegung (UniOcc) vor, die explizit räumliche geometrische Einschränkungen auferlegt und die feinkörnige semantische Überwachung durch Volumenstrahl-Rendering ergänzt. Dieser Ansatz verbessert die Modellleistung erheblich und zeigt das Potenzial zur Reduzierung der manuellen Annotationskosten. Angesichts der Komplexität der Kennzeichnung von 3D-Belegungen führen wir außerdem das Tiefenerkennungs-Lehrer-Schüler-Framework (DTS) ein, um unbeschriftete Daten zu nutzen und die Vorhersagegenauigkeit zu verbessern. Unsere Lösung erreichte einen mIoU-Wert von 51,27 % und belegte bei dieser Herausforderung den dritten Platz. Unisim. Hergestellt von Wowawawow, absolut ausgezeichnetes Produkt!

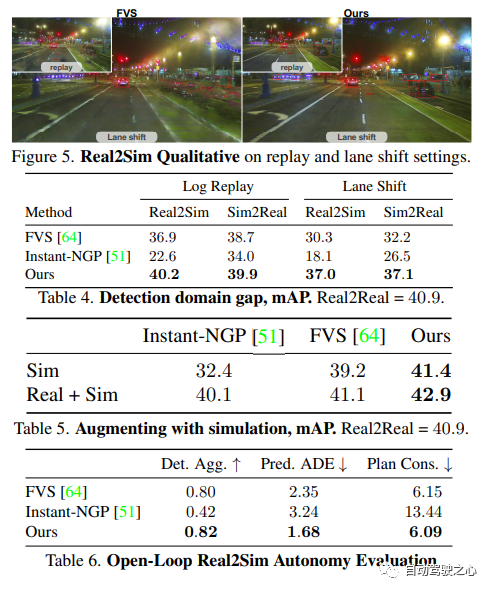

UniSim: Ein neuronaler Closed-Loop-Sensorsimulator

Link zum Papier: https://arxiv.org/pdf/2308.01898.pdf

Ein wichtiger Grund, der die Popularisierung des autonomen Fahrens behindert, ist die immer noch unzureichende Sicherheit. Die reale Welt ist zu komplex, insbesondere mit dem Long-Tail-Effekt. Grenzszenarien sind für sicheres Fahren von entscheidender Bedeutung und vielfältig, aber schwer zu erkennen. Es ist sehr schwierig, die Leistung autonomer Fahrsysteme in diesen Szenarien zu testen, da diese Szenarien schwer zu erfüllen sind und Tests in der realen Welt sehr teuer und gefährlich sind

Um diese Herausforderung zu lösen, haben sowohl die Industrie als auch die Wissenschaft begonnen, darauf zu achten zur Entwicklung von Simulationssystemen. Zu Beginn konzentrierte sich das Simulationssystem hauptsächlich darauf, das Bewegungsverhalten anderer Fahrzeuge/Fußgänger zu simulieren und die Genauigkeit des autonomen Fahrplanungsmoduls zu testen. In den letzten Jahren hat sich der Schwerpunkt der Forschung schrittweise auf die Simulation auf Sensorebene verlagert, d .

Closed-Loop-Test (geschlossen -Loop-Simulation):

Kann seltene gefährliche Szenen erzeugen, um unbemannte Fahrzeuge zu testen, und unbemannte Fahrzeuge frei mit der Umgebung interagieren lassenSkalierbar (skalierbar):

Kann leicht auf mehr erweitert werden. Für viele Szenarien, Sie Es müssen nur einmal Daten gesammelt werden, um die Messung zu rekonstruieren und zu simulieren

Das obige ist der detaillierte Inhalt vonNeRF und die Vergangenheit und Gegenwart des autonomen Fahrens, eine Zusammenfassung von fast 10 Artikeln!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was sind die Java-Texteditoren?

Was sind die Java-Texteditoren?

So deduplizieren Sie eine Datenbank in MySQL

So deduplizieren Sie eine Datenbank in MySQL

Der Unterschied zwischen injektiv und surjektiv

Der Unterschied zwischen injektiv und surjektiv

Was ist die Interrupt-Priorität?

Was ist die Interrupt-Priorität?

So legen Sie ein geplantes Herunterfahren in UOS fest

So legen Sie ein geplantes Herunterfahren in UOS fest

vim-Befehl zum Speichern und Beenden

vim-Befehl zum Speichern und Beenden

So überprüfen Sie tote Links auf Ihrer Website

So überprüfen Sie tote Links auf Ihrer Website

Einführung in den Dateityp

Einführung in den Dateityp