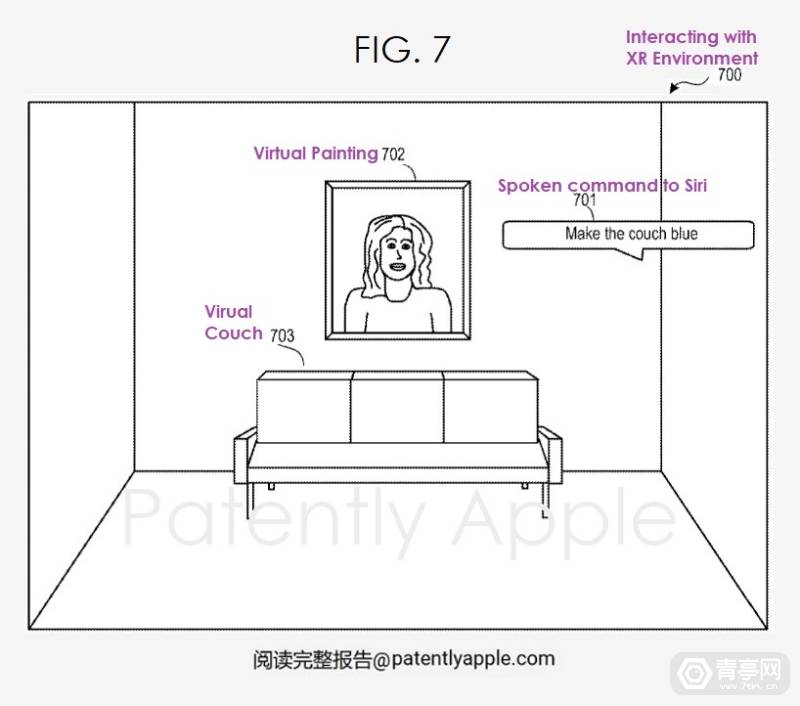

Im Februar letzten Jahres demonstrierte Meta eine auf dem AIGC-Gameplay basierende Funktion zur Entwicklung virtueller Welten: Builder Bot, die sich dadurch auszeichnet, dass sie durch die Erkennung von Sprachbefehlen entsprechende Elemente in der virtuellen Szene generieren kann, was die Schwierigkeit der VR-Szenengenerierung vereinfachen kann. In einem kürzlich vom USPTO veröffentlichten Apple-Patent wurde auf ein ähnliches Konzept hingewiesen. Beispielsweise können Benutzer dem Sprachassistenten Siri befehlen, der physischen Szene virtuelle Möbel hinzuzufügen, die Farbe der Möbel zu ändern usw.

Laut Qingting.com lautet die Patentnummer US20230206912A1. Der Inhalt beschreibt hauptsächlich eine Reihe neuer Siri-Sprachbefehle, die zur Steuerung von Textverarbeitungsprogrammen (Text eingeben, Schriftarten ändern usw.), XR-Szenen usw. verwendet werden können. Obwohl es nicht speziell für XR entwickelt wurde, enthält das Patent mindestens acht Absätze, in denen XR-Anwendungen vorgestellt werden, und zwei der Patenterfinder stammen aus dem XR-Team, nämlich Apple AR/VR Engineering Manager Cedric Bray und der leitende AR/VR-Softwareentwickler Helmut Garstenauer.

Das obige ist der detaillierte Inhalt vonApple AIGC-Patent: Virtuelle AR/VR-Szenen können durch Sprachbefehle generiert werden. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was bedeutet Apple LTE-Netzwerk?

Was bedeutet Apple LTE-Netzwerk?

Die Rolle des „Bitte nicht stören'-Modus von Apple

Die Rolle des „Bitte nicht stören'-Modus von Apple

So lösen Sie das Problem, dass Apple nicht mehr als 200 Dateien herunterladen kann

So lösen Sie das Problem, dass Apple nicht mehr als 200 Dateien herunterladen kann

So schließen Sie Port 135 445

So schließen Sie Port 135 445

Projektor-Handy

Projektor-Handy

Welche Methoden gibt es, Crawler zu verhindern?

Welche Methoden gibt es, Crawler zu verhindern?

Welche Plattform ist 1688?

Welche Plattform ist 1688?

Welche Methoden gibt es, um das Passwort in MySQL zu ändern?

Welche Methoden gibt es, um das Passwort in MySQL zu ändern?