Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail für die Einreichung: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Die Autoren dieses Artikels sind Professor Zhang Peng von der Abteilung für Intelligenz und Informatik der Tianjin-Universität, sein Masterstudent Zhao Jiaming und sein Doktorand Schüler Qiao Wenbo und Gao Jue. Diese Forschungsarbeit wurde von der National Natural Science Foundation of China und dem Tianjin University-China Science and Technology Wenge Joint Laboratory finanziert.

- Papiertitel: Quantum Implicit Neural Representations

- Autoren des Papiers: Jiaming Zhao, Wenbo Qiao, Peng Zhang*, Hui Gao

- Link zum Papier: https://arxiv.org/abs /2406.03873

Das Quantum Intelligence and Language Understanding-Team der Universität Tianjin führte Quantencomputing innovativ in den Bereich der impliziten neuronalen Repräsentation ein und schlug das Quantum Implicit Representation Network (Q. uantum Iimplizite RePräsentation NNetzwerk, QIREN). Im Vergleich zur klassischen neuronalen Netzwerkmethode verfügt diese Methode theoretisch über exponentiell stärkere Signaldarstellungsfähigkeiten. Experimentelle Ergebnisse bestätigen auch, dass QIREN bei Signaldarstellungsaufgaben tatsächlich eine hervorragende Leistung zeigt, die über das SOTA-Modell hinausgeht. Mit weniger Parametern wird der Anpassungsfehler um bis zu 35 % reduziert. Die Kerngedanken und wichtigsten Schlussfolgerungen dieses Papiers sind in Abbildung 1 dargestellt. Relevante Beiträge wurden von ICML 2024, einer der maßgeblichsten Konferenzen im Bereich maschinelles Lernen, angenommen.傅 Abbildung 1. Klassisches Fourier-Neuronales Netzwerk und Quanten-Fourier-Neuronales Netzwerk.  In den letzten Jahren hat die implizite neuronale Darstellung als aufkommende Signaldarstellungsmethode große Aufmerksamkeit erregt. Implizite neuronale Darstellungen haben eine Reihe einzigartiger Vorteile gegenüber herkömmlichen diskreten Gitterdarstellungen, beispielsweise Bildern, die durch ein Pixelgitter dargestellt werden. Erstens verfügt es über die Fähigkeit einer „unendlichen Auflösung“ und kann mit jeder räumlichen Auflösung abtasten. Zweitens bietet die implizite neuronale Darstellung eine hervorragende Speicherplatzeinsparung und eine bequeme Datenspeicherung. Aufgrund dieser einzigartigen Vorteile hat sich die implizite neuronale Darstellung schnell zu einem gängigen Paradigma für die Darstellung von Signalen wie Bildern, Objekten und 3D-Szenen entwickelt. Die meisten frühen Forschungen zu impliziten neuronalen Darstellungen basierten auf ReLU-basierten mehrschichtigen Perzeptronen (MLPs). Allerdings ist es für ReLU-basiertes MLP schwierig, den Hochfrequenzteil des Signals genau zu modellieren, wie in Abbildung 2 dargestellt. Neuere Forschungen haben damit begonnen, den Einsatz von Fourier-Neuronalen Netzen (FNN) zu untersuchen, um diese Einschränkung zu überwinden. Angesichts immer komplexerer Anpassungsaufgaben in realen Anwendungen erfordern klassische Fourier-Neuronale Netze jedoch auch immer mehr Trainingsparameter, was den Bedarf an Rechenressourcen erhöht. Die in diesem Artikel vorgeschlagene quantenimplizite neuronale Darstellung nutzt Quantenvorteile, um Parameter und Rechenaufwand zu reduzieren. Diese Lösung kann neue Inspirationen in den Bereich der impliziten neuronalen Darstellung und sogar des maschinellen Lernens bringen.

In den letzten Jahren hat die implizite neuronale Darstellung als aufkommende Signaldarstellungsmethode große Aufmerksamkeit erregt. Implizite neuronale Darstellungen haben eine Reihe einzigartiger Vorteile gegenüber herkömmlichen diskreten Gitterdarstellungen, beispielsweise Bildern, die durch ein Pixelgitter dargestellt werden. Erstens verfügt es über die Fähigkeit einer „unendlichen Auflösung“ und kann mit jeder räumlichen Auflösung abtasten. Zweitens bietet die implizite neuronale Darstellung eine hervorragende Speicherplatzeinsparung und eine bequeme Datenspeicherung. Aufgrund dieser einzigartigen Vorteile hat sich die implizite neuronale Darstellung schnell zu einem gängigen Paradigma für die Darstellung von Signalen wie Bildern, Objekten und 3D-Szenen entwickelt. Die meisten frühen Forschungen zu impliziten neuronalen Darstellungen basierten auf ReLU-basierten mehrschichtigen Perzeptronen (MLPs). Allerdings ist es für ReLU-basiertes MLP schwierig, den Hochfrequenzteil des Signals genau zu modellieren, wie in Abbildung 2 dargestellt. Neuere Forschungen haben damit begonnen, den Einsatz von Fourier-Neuronalen Netzen (FNN) zu untersuchen, um diese Einschränkung zu überwinden. Angesichts immer komplexerer Anpassungsaufgaben in realen Anwendungen erfordern klassische Fourier-Neuronale Netze jedoch auch immer mehr Trainingsparameter, was den Bedarf an Rechenressourcen erhöht. Die in diesem Artikel vorgeschlagene quantenimplizite neuronale Darstellung nutzt Quantenvorteile, um Parameter und Rechenaufwand zu reduzieren. Diese Lösung kann neue Inspirationen in den Bereich der impliziten neuronalen Darstellung und sogar des maschinellen Lernens bringen. Abbildung 2. Verschiedene Frequenzkomponenten des realen Bildes (oben) und verschiedene Frequenzkomponenten des angepasst durch ReLU-basiertes MLP (unten)

Abbildung 3. Modellarchitektur Die Gesamtarchitektur des Modells QIREN ist in Abbildung 3 dargestellt. Besteht aus N gemischten Schichten und linearen Schichten am Ende. Das Modell verwendet Koordinaten als Eingabe und gibt Signalwerte aus. Die Daten gelangen zunächst in die Hybridschicht, beginnend mit der linearen Schicht und der BatchNorm-Schicht, was zu Folgendem führt:

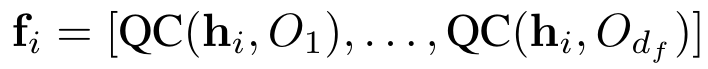

und werden dann in den Quantenschaltkreis QC zum erneuten Hochladen von Daten eingespeist. In Abbildung 2 (b) und (c) geben wir die spezifische Implementierung der Quantenschaltungen der Parameterschicht und der Kodierungsschicht an. Die Parameterschicht besteht aus K gestapelten Blöcken. Jeder Block enthält ein Spin-Gate, das auf jedes Qubit angewendet wird, sowie CNOT-Gates, die im Round-Robin-Verfahren verbunden sind. Die Codierungsschicht wendet Gates auf jedes Qubit an. Schließlich messen wir den erwarteten Wert eines Quantenzustands relativ zu einer Observablen. Die Ausgabe eines Quantenschaltkreises ist gegeben durch:

wobei O eine beliebige beobachtbare Größe darstellt. Die Ausgabe der n-ten Mischebene wird als Eingabe der (n+1)-ten Ebene verwendet. Schließlich fügen wir eine lineare Ebene zum Empfangen und Ausgeben hinzu. Wir verwenden den mittleren quadratischen Fehler (MSE) als Verlustfunktion, um das Modell zu trainieren:

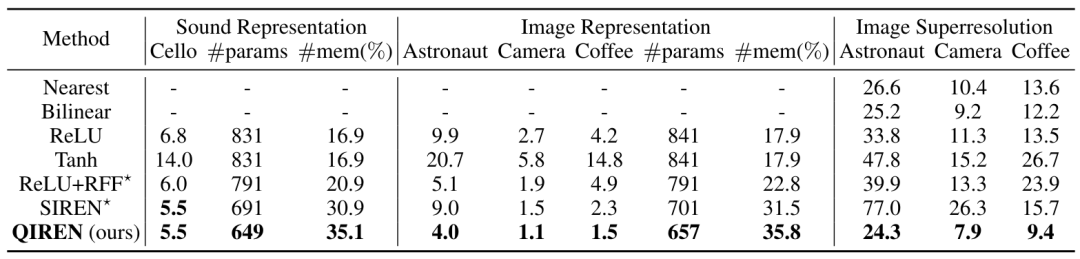

Modelltheoretische AnalyseIn einigen früheren Studien wurden die mathematischen Eigenschaften der Quantenschaltung zum erneuten Hochladen von Daten enthüllt. Im Wesentlichen besteht die Quantenschaltung zum erneuten Hochladen von Daten darin, die Zielfunktion in das Formular einzufügen einer Fourier-Reihe. Frühere Arbeiten untersuchten jedoch nur mehrschichtige Single-Qubit-Schaltkreise oder einschichtige Multi-Qubit-Schaltkreise und verglichen sie nicht mit klassischen Methoden und fanden nicht die Vorteile von Quantenschaltkreisen zum erneuten Hochladen von Daten. Wir erweitern unsere Forschung auf mehrschichtige Multi-Qubit-Schaltkreise. Darüber hinaus haben wir bewiesen, dass im Bereich der impliziten neuronalen Darstellung das hybride Quanten-Neuronale Netzwerk QIREN, dessen Kernkomponente Quantenschaltkreise zum erneuten Hochladen von Daten ist, exponentielle Vorteile gegenüber klassischen Methoden aufweist. Wir haben die Rolle der Quantenschicht und der klassischen Schicht in QIREN analysiert und in den folgenden drei Punkten zusammengefasst: 1 Unter optimalen Bedingungen nimmt die Fähigkeit des erneuten Hochladens von Daten zur Darstellung der Fourier-Reihe des Quantenschaltkreises zu Die Größe der Schaltung wächst exponentiell. Eine spezifische Ableitung finden Sie in den Abschnitten 4.2 und 4.3 des Papiers. 2. Die Funktion der linearen Schicht besteht darin, das Spektrum weiter zu erweitern und die Frequenz anzupassen, wodurch die Anpassungsleistung verbessert wird. Das Anwenden einer linearen Schicht vor dem Hochladen von Daten in eine Quantenschaltung entspricht der Anpassung der Eigenwerte des Hamilton-Operators der Codierungsschicht, was sich letztendlich auf das Spektrum auswirkt. Dieser Ansatz hat zwei Vorteile. Erstens kann es das Spektrum vergrößern. Bei der Codierung nur mit Gates entstehen im Spektrum einige redundante Terme. Diese Redundanz kann durch den Einsatz linearer Schichten reduziert werden. Zweitens ermöglicht es die Anpassung der Abdeckung des Spektrums, um Frequenzen mit größeren Koeffizienten abzudecken, die wichtiger sind. Daher kann das Hinzufügen einer linearen Schicht die Anpassungsleistung von QIREN weiter verbessern. 3. Die Rolle der Batchnorm-Schicht besteht darin, die Konvergenz des Quantenmodells zu beschleunigen. In neuronalen Feedforward-Netzen durchlaufen Daten normalerweise vor der Aktivierungsfunktion die BatchNorm-Schicht, wodurch das Problem des verschwindenden Gradienten wirksam verhindert wird. In ähnlicher Weise ersetzen Quantenschaltungen in QIREN die Aktivierungsfunktion und spielen eine Rolle bei der Bereitstellung von Nichtlinearität (die Quantenschaltung selbst ist linear, aber der Prozess des Hochladens klassischer Daten in die Quantenschaltung ist nichtlinear). Daher haben wir hier eine BatchNorm-Ebene hinzugefügt, um die Konvergenz des Modells zu stabilisieren und zu beschleunigen. Experimentelle Ergebnisse Wir haben die überlegene Leistung von QIREN bei der Darstellung von Signalen, insbesondere Hochfrequenzsignalen, durch Bilddarstellungs- und Tondarstellungsaufgaben bestätigt. Die experimentellen Ergebnisse sind in Tabelle 1 aufgeführt. QIREN und SIREN zeigten bei der Klangdarstellungsaufgabe eine ähnliche Leistung. Obwohl die Leistung der beiden Modelle vergleichbar zu sein scheint, ist es erwähnenswert, dass unser Modell mit den wenigsten Parametern eine Speichereinsparung von 35,1 % erzielt und die Konvergenz von SIREN die Einstellung geeigneter Hyperparameter erfordert, während unser Modell diese Einschränkung nicht hat. Anschließend analysierten wir die Modellausgabe aus einer Frequenzperspektive. Wir visualisieren das Spektrum der Modellausgabe in Abbildung 4. Es ist offensichtlich, dass die vom Modell ausgegebenen Niederfrequenzverteilungen der realen Situation nahe kommen. Wenn es jedoch um Hochfrequenzverteilungen geht, passen sowohl QIREN als auch SIREN gut, gefolgt von ReLU-basiertem MLP mit zufälligen Fourier-Features (RFF). ReLU-basierten und Tanh-basierten MLPs fehlt sogar der hochfrequente Teil des Signals.

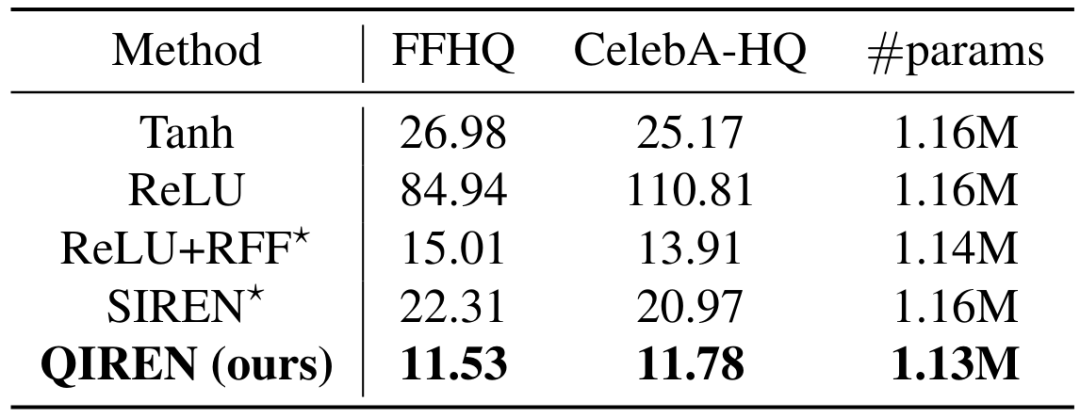

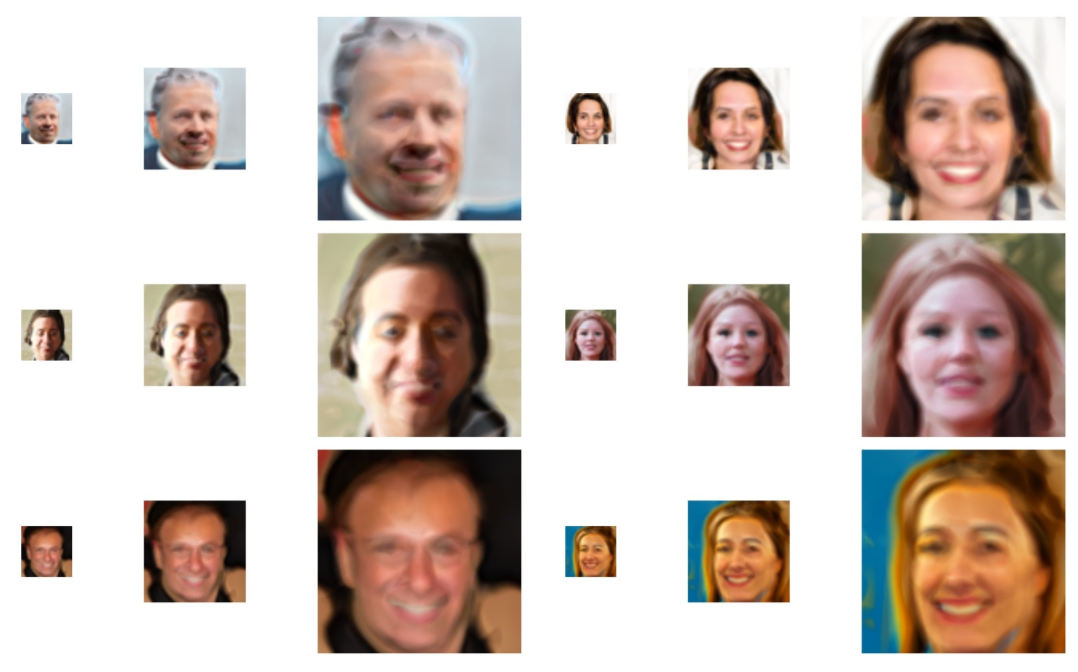

Tabelle 1. MSE() des Modells für Signaldarstellung und Bild-Superauflösungsaufgaben. Modelle, die als SOTA gelten, sind mit * gekennzeichnet. params stellt die Menge der Modellparameter dar und mem stellt den vom Modell im Vergleich zur diskreten Gitterdarstellung eingesparten Speicher dar.任 Abbildung 4. Der Ton zeigt das Spektrum der Modellausgabe in der Aufgabe an. Im Vergleich zum SOTA-Modell erzielt Qiren eine maximale Fehlerreduzierung von 34,8 %. Um die Signaldarstellungsfähigkeiten des Modells weiter zu untersuchen, verwenden wir Filter, um die Hochfrequenz- und Niederfrequenzkomponenten seiner Ausgabe zu trennen und die Anpassungsfehler dieser beiden Komponenten zu vergleichen. Die Ergebnisse sind in Abbildung 5 dargestellt. QIREN erreicht durchweg die geringsten Fehler bei der Anpassung hoch- und niederfrequenter Komponenten. Abbildung 5. Relativ Der Fehler jedes Modells im Vergleich zum Tanh-basierten MLP. Schattierte Bereiche stellen niederfrequente Fehler dar, während nicht schattierte Bereiche hochfrequente Fehler darstellen. Neueste Forschungsergebnisse stellen ein bahnbrechendes Framework vor, um implizite neuronale Darstellungen auf die Bilderzeugung zu erweitern. Genauer gesagt nutzt das Framework ein Hypernetzwerk, das Zufallsverteilungen als Eingabe verwendet, um Parameter zu generieren, die das Netzwerk implizit charakterisieren. Anschließend werden diese generierten Parameter dem impliziten Repräsentationsnetzwerk zugewiesen. Schließlich generiert das implizite Darstellungsnetzwerk Bilder, indem es Koordinaten als Eingabe verwendet. Um sicherzustellen, dass die generierten Bilder mit unseren gewünschten Ergebnissen übereinstimmen, wird ein kontradiktorischer Ansatz verwendet. In dieser Aufgabe übernehmen wir ein solches Framework und bauen auf StyleGAN2 auf. Die experimentellen Ergebnisse sind in Tabelle 2 dargestellt. Wir untersuchen außerdem einige spannende Funktionen des QIREN-Generators weiter, wie in den Abbildungen 6 und 7 dargestellt. F Tabelle 2. FID-Score des Modells für FFHQ- und CELEBA-HQ-Datensätze.

Abbildung 7. Aussagekräftige Bildrauminterpolation

Diese Arbeit integriert nicht nur Quantenvorteile in die implizite neuronale Darstellung, sondern eröffnet auch eine vielversprechende Anwendungsrichtung für Quanten Neuronale Netze – implizite neuronale Darstellung. Es ist hervorzuheben, dass implizite neuronale Darstellungen viele weitere potenzielle Anwendungen haben, beispielsweise die Darstellung von Szenen oder 3D-Objekten, die Vorhersage von Zeitreihen und die Lösung von Differentialgleichungen. Für eine große Klasse von Aufgaben, die kontinuierliche Signale modellieren, können wir die Einführung impliziter Darstellungsnetzwerke als Grundkomponente in Betracht ziehen. Basierend auf den theoretischen und experimentellen Grundlagen dieses Artikels können wir QIREN in zukünftigen Arbeiten auf diese Anwendungen erweitern, und es wird erwartet, dass QIREN in diesen Bereichen bessere Ergebnisse mit weniger Parametern liefert. Gleichzeitig haben wir ein geeignetes Anwendungsszenario für Quantenmaschinelles Lernen gefunden. Dadurch wird die weitere praktische und innovative Forschung innerhalb der Gemeinschaft des Quantenmaschinellen Lernens gefördert.

Das obige ist der detaillierte Inhalt vonICML 2024 |. Die Signaldarstellung ist exponentiell stärker, die Speichereinsparung übersteigt 35 %, das quantenimplizite Darstellungsnetzwerk kommt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!