Jenseits der kausalen Sprachmodellierung

Neurips 2024 Spotlight: Optimierung des Sprachmodells Vorabbau mit selektiver Sprachmodellierung (SLM)

Vor kurzem habe ich ein faszinierendes Papier von Neurips 2024 vorgestellt, "Nicht alle Token sind das, was Sie für die Vorabstärke benötigen", in einer lokalen Lesegruppe. Dieses Papier befasst sich überraschend einfache, aber wirkungsvolle Frage: Ist die nächste Vorhersage für Jedes -Token während des Sprachmodells vorab vorab?

Der Standardansatz beinhaltet massive webkrapte Datensätze und die allgemeine Anwendung von Kausalsprachenmodellierung (CLM). Dieses Papier stellt diese Annahme in Frage und schlägt vor, dass einige Token den Lernprozess eher behindern als helfen. Die Autoren zeigen, dass die Fokussierung des Trainings auf "nützliche" Token die Dateneffizienz und die nachgeschaltete Aufgabenleistung erheblich verbessert. Dieser Beitrag fasst ihre Kernideen und wichtigen experimentellen Erkenntnisse zusammen.

Das Problem: Rauschen und ineffizientes Lernen

Große Webkorpora enthält zwangsläufig Geräusche. Während die Filterung auf Dokumentebene hilft, liegt das Rauschen häufig in einzelnen Dokumenten. Diese lauten Token verschwenden Computerressourcen und verwechseln möglicherweise das Modell.Die Autoren analysierten die Lerndynamik auf Token-Ebene und kategorisieren Token anhand ihrer Querentropy-Verlust-Flugbahn:

- l → L (niedrig bis niedrig): schnell gelernt und liefert einen minimalen weiteren Nutzen.

- H → L (hoch bis niedrig): anfangs schwierig, aber schließlich gelernt; Wertvolle Lernmöglichkeiten darstellen.

- H → H (hoch bis hoch): konstant schwierig, oft aufgrund der inhärenten Unvorhersehbarkeit (Aleatorikunsicherheit).

- l → h (niedrig bis hoch): ursprünglich gelernt, wird aber später problematisch, möglicherweise aufgrund von Kontextverschiebungen oder Rauschen.

Die Lösung: Selektive Sprachmodellierung (SLM)

Die vorgeschlagene Lösung, selektive Sprachmodellierung (SLM), bietet einen gezielteren Ansatz:

-

Referenzmodell (RM) Training: Eine hochwertige Teilmenge der Daten wird verwendet, um ein vorgebildetes Basismodell zu optimieren und ein Referenzmodell (RM) zu erstellen. Dieser RM fungiert als Benchmark für Token "Nützlichkeit".

-

Berechnung des Überschusses: Für jeden Token im großen Korpus wird der Unterschied zwischen dem Verlust des RM und dem aktuellen Trainingsmodellverlust (der "Überlust") berechnet. Ein höherer Überschussverlust zeigt ein höheres Verbesserungspotential.

-

Selektive Backpropagation: Der vollständige Vorwärtspass wird an allen Token durchgeführt, aber die Backpropagation tritt nur für die oberen k% von Tokens mit dem höchsten Überschussverlust auf. Dies konzentriert sich dynamisch das Training auf die wertvollsten Token.

Experimentelle Ergebnisse: Signifikante Gewinne

SLM zeigt signifikante Vorteile in verschiedenen Experimenten:

-

mathematische Domäne: on openWebmath , SLM erzielte im Vergleich zu Standard-CLM bis zu 10% Leistungssteigerungen bei GSM8K und Mathematik-Benchmarks und erreichten 5-10-mal schneller. Ein 7B-Modell stimmte mit einem hochmodernen Modell mit nur 3% seiner Trainingstoken überein. Die Feinabstimmung steigerte die Leistung für ein 1B-Modell um über 40%.

-

Allgemeine Domäne: Auch bei einem starken vorgeborenen Basismodell ergab SLM eine durchschnittliche Verbesserung von ungefähr 5,8% gegenüber 15 Benchmarks, insbesondere in herausfordernden Domänen wie Code und Mathematik.

-

Selbstreferenzierung: Selbst ein schnell trainierter RM aus dem Rohkorpus lieferte einen Genauigkeitsschub von 2-3% und eine Reduzierung der verwendeten Token um 30-40%.

Schlussfolgerung und zukünftige Arbeit

Dieses Papier bietet wertvolle Einblicke in die Lerndynamik auf Token-Ebene und führt SLM ein, eine hochwirksame Technik zur Optimierung des Sprachmodells-Vorbaues. Zukünftige Forschungsanweisungen umfassen die Skalierung von SLM zu größeren Modellen, die Erforschung von API-basierten Referenzmodellen, das Integrieren von Verstärkungslernen, die Verwendung mehrerer Referenzmodelle und das Ausrichten von SLM mit Sicherheits- und Wahrhaftigkeit. Diese Arbeit stellt einen erheblichen Fortschritt im effizienten und effektiven Sprachmodell Training dar.

Das obige ist der detaillierte Inhalt vonJenseits der kausalen Sprachmodellierung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

KI -Investor stillte zum Stillstand? 3 Strategische Wege zum Kauf, Bau oder Partner mit KI -Anbietern

Jul 02, 2025 am 11:13 AM

KI -Investor stillte zum Stillstand? 3 Strategische Wege zum Kauf, Bau oder Partner mit KI -Anbietern

Jul 02, 2025 am 11:13 AM

Das Investieren boomt, aber Kapital allein reicht nicht aus. Mit zunehmender Bewertungen und Verblassen der Unterscheidungskraft müssen Investoren in AI-fokussierten Risikokonstrumentfonds eine wichtige Entscheidung treffen: Kaufen, Bau oder Partner, um einen Vorteil zu erlangen? Hier erfahren Sie, wie Sie jede Option bewerten - und PR

Agi und KI -Superintelligenz werden die Annahmesperre der menschlichen Decke stark treffen

Jul 04, 2025 am 11:10 AM

Agi und KI -Superintelligenz werden die Annahmesperre der menschlichen Decke stark treffen

Jul 04, 2025 am 11:10 AM

Reden wir darüber. Diese Analyse eines innovativen KI -Durchbruchs ist Teil meiner laufenden Forbes -Säulenberichterstattung über die neueste in der KI, einschließlich der Identifizierung und Erklärung verschiedener wirksamer KI -Komplexitäten (siehe Link hier). Auf dem Weg zu Agi und

Erstellen Sie Ihre erste LLM -Anwendung: Ein Anfänger -Tutorial

Jun 24, 2025 am 10:13 AM

Erstellen Sie Ihre erste LLM -Anwendung: Ein Anfänger -Tutorial

Jun 24, 2025 am 10:13 AM

Haben Sie jemals versucht, Ihr eigenes großes Sprachmodell (LLM) zu erstellen? Haben Sie sich jemals gefragt, wie Menschen ihre eigene LLM -Anwendung stellen, um ihre Produktivität zu steigern? LLM -Anwendungen haben sich in jedem Aspekt als nützlich erwiesen

Kimi K2: Das mächtigste Open-Source-Agentenmodell

Jul 12, 2025 am 09:16 AM

Kimi K2: Das mächtigste Open-Source-Agentenmodell

Jul 12, 2025 am 09:16 AM

Erinnern Sie sich an die Flut chinesischer Open-Source-Modelle, die die Genai-Industrie Anfang dieses Jahres gestört haben? Während Deepseek die meisten Schlagzeilen machte, war Kimi K1.5 einer der herausragenden Namen in der Liste. Und das Modell war ziemlich cool.

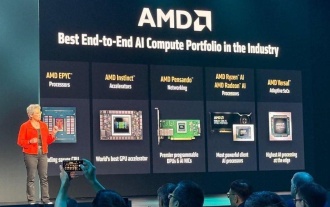

AMD baut immer wieder an Dynamik in KI auf

Jun 28, 2025 am 11:15 AM

AMD baut immer wieder an Dynamik in KI auf

Jun 28, 2025 am 11:15 AM

Insgesamt denke ich, dass die Veranstaltung wichtig war, um zu zeigen, wie AMD den Ball für Kunden und Entwickler auf dem Feld bewegt. Unter SU, M.O. ist klare, ehrgeizige Pläne zu haben und gegen sie auszuführen. Ihr Verhältnis von „Say/Do“ ist hoch. Das Unternehmen tut es

Zukünftige Vorhersage einer massiven Intelligenz -Explosion auf dem Weg von AI zu AGI

Jul 02, 2025 am 11:19 AM

Zukünftige Vorhersage einer massiven Intelligenz -Explosion auf dem Weg von AI zu AGI

Jul 02, 2025 am 11:19 AM

Reden wir darüber. Diese Analyse eines innovativen KI -Durchbruchs ist Teil meiner laufenden Forbes -Säulenberichterstattung über die neueste in der KI, einschließlich der Identifizierung und Erklärung verschiedener wirksamer KI -Komplexitäten (siehe Link hier). Für diejenigen Leser, die h

Grok 4 gegen Claude 4: Was ist besser?

Jul 12, 2025 am 09:37 AM

Grok 4 gegen Claude 4: Was ist besser?

Jul 12, 2025 am 09:37 AM

Bis Mitte 2025 heizt sich das KI „Wettret“ auf, und Xai und Anthropic haben beide ihre Flaggschiff-Modelle GROK 4 und Claude 4 veröffentlicht. Diese beiden Modelle befinden

Kette von Gedanken zum Argumentieren von Modellen kann langfristig nicht funktionieren

Jul 02, 2025 am 11:18 AM

Kette von Gedanken zum Argumentieren von Modellen kann langfristig nicht funktionieren

Jul 02, 2025 am 11:18 AM

Wenn Sie beispielsweise einem Modell eine Frage wie: "Was macht (x) Person bei (x) Firma?" Möglicherweise sehen Sie eine Argumentationskette, die ungefähr so aussieht, vorausgesetzt, das System weiß, wie man die erforderlichen Informationen abgerufen: Details zum CO finden