设想一下,当你站在房间内,准备向门口走去,你是通过自回归的方式逐步规划路径吗?实际上,你的路径是一次性整体生成的。

最新研究指出,利用扩散模型的规划模块可以同时生成长序列的轨迹规划,更符合人类的决策方式。此外,扩散模型在策略表征和数据合成方面还能为现有的决策智能算法提供更为优化的方案。

来自上海交通大学的团队撰写的综述论文《Diffusion Models for Reinforcement Learning: A Survey》梳理了扩散模型在强化学习相关领域的应用。综述指出现有强化学习算法面临长序列规划误差累积、策略表达能力受限、交互数据不足等挑战,而扩散模型已经展现出解决强化学习问题中的优势,并为应对上述长期以来的挑战带来新的思路。

论文链接:https://arxiv.org/abs/2311.01223

项目地址:https://github.com/apexrl/Diff4RLSurvey

该综述对扩散模型在强化学习中的作用进行了分类,总结了不同强化学习场景中扩散模型的成功案例。最后,综述展望了未来利用扩散模型解决强化学习问题的发展方向。

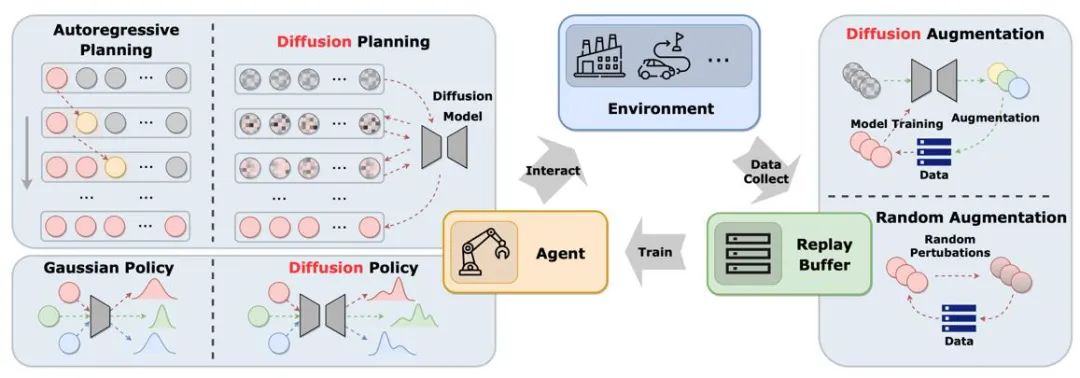

图中展示了扩散模型在经典智能体-环境-经验回放池循环中的作用。与传统解决方案相比,扩散模型为系统引入了新的元素,提供了更全面的信息交互和学习机会。通过这种方式,智能体能够更好地适应环境变化,并且优化其决策

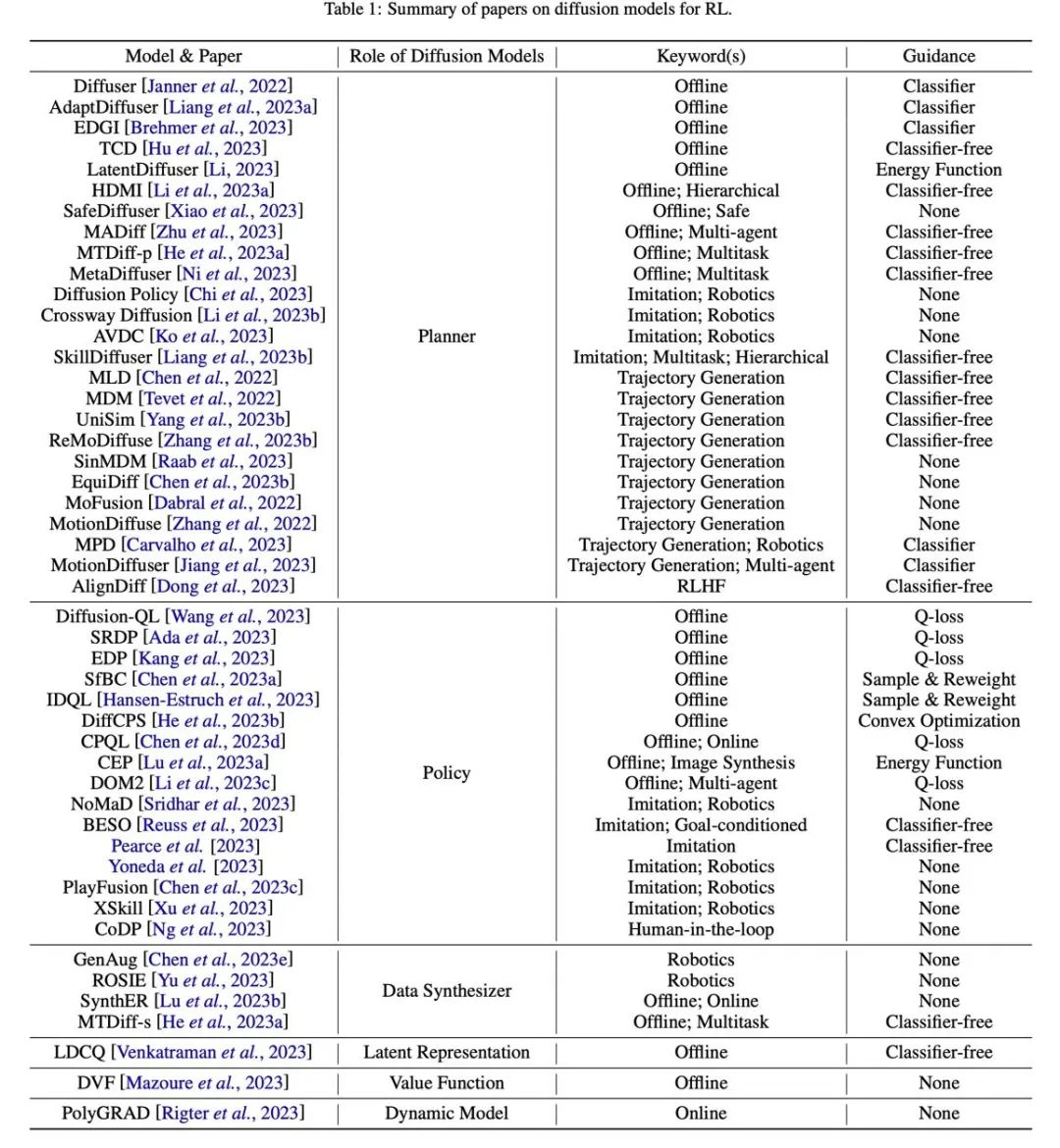

文章根据扩散模型在强化学习中扮演角色的不同,分类比较了扩散模型的应用方式和特点。

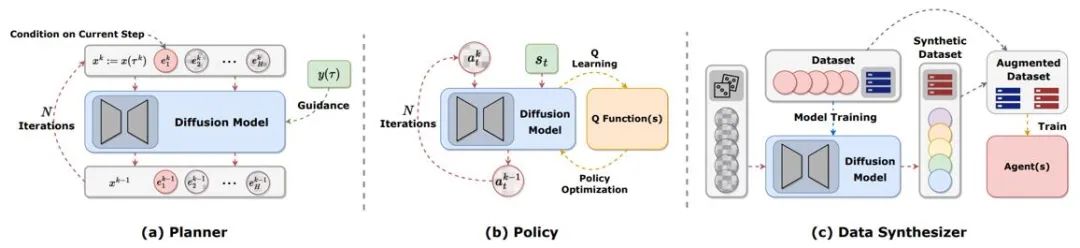

图 2:扩散模型在强化学习中扮演的不同角色。

轨迹规划

强化学习中的规划指通过使用动态模型在想象中做决策,再选择最大化累积奖励的适当动作。规划的过程通常会探索各种动作和状态的序列,从而提升决策的长期效果。在基于模型的强化学习(MBRL)框架中,规划序列通常以自回归方式进行模拟,导致累积误差。扩散模型可以同时生成多步规划序列。现有文章用扩散模型生成的目标非常多样,包括 (s,a,r)、(s,a)、仅有 s、仅有 a 等等。为了在在线评估时生成高奖励的轨迹,许多工作使用了有分类器或无分类器的引导采样技术。

策略表征

扩散规划器更近似传统强化学习中的 MBRL,与之相对,将扩散模型作为策略更类似于无模型强化学习。Diffusion-QL 首先将扩散策略与 Q 学习框架结合。由于扩散模型拟合多模态分布的能力远超传统模型,扩散策略在由多个行为策略采样的多模态数据集中表现良好。扩散策略与普通策略相同,通常以状态作为条件生成动作,同时考虑最大化 Q (s,a) 函数。Diffusion-QL 等方法在扩散模型训练时加上加权的价值函数项,而 CEP 从能量的视角构造加权回归目标,用价值函数作为因子,调整扩散模型学到的动作分布。

数据合成

扩散模型可以作为数据合成器,来缓解离线或在线强化学习中数据稀少的问题。传统强化学习数据增强方法通常只能对原有数据进行小幅扰动,而扩散模型强大的分布拟合能力使其可以直接学习整个数据集的分布,再采样出新的高质量数据。

其他类型

除了以上几类,还有一些零散的工作以其他方式使用扩散模型。例如,DVF 利用扩散模型估计值函数。LDCQ 首先将轨迹编码到隐空间上,再在隐空间上应用扩散模型。PolyGRAD 用扩散模型学习环境动态转移,允许策略和模型交互来提升策略学习效率。

离线强化学习

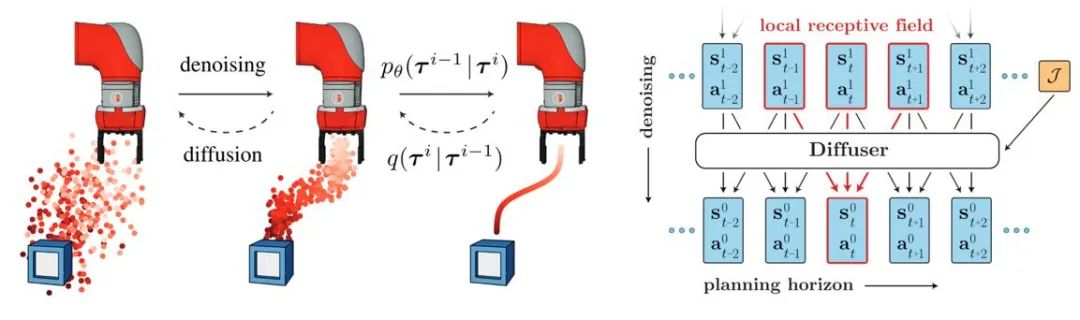

扩散模型的引入有助于离线强化学习策略拟合多模态数据分布并扩展了策略的表征能力。Diffuser 首先提出了基于分类器指导的高奖励轨迹生成算法并启发了大量的后续工作。同时,扩散模型也能应用在多任务与多智能体强化学习场景。

图 3:Diffuser 轨迹生成过程和模型示意图

在线强化学习

研究者证明扩散模型对在线强化学习中的价值函数、策略也具备优化能力。例如,DIPO 对动作数据重标注并使用扩散模型训练,使策略避免了基于价值引导训练的不稳定性;CPQL 则验证了单步采样扩散模型作为策略能够平衡交互时的探索和利用。

模仿学习

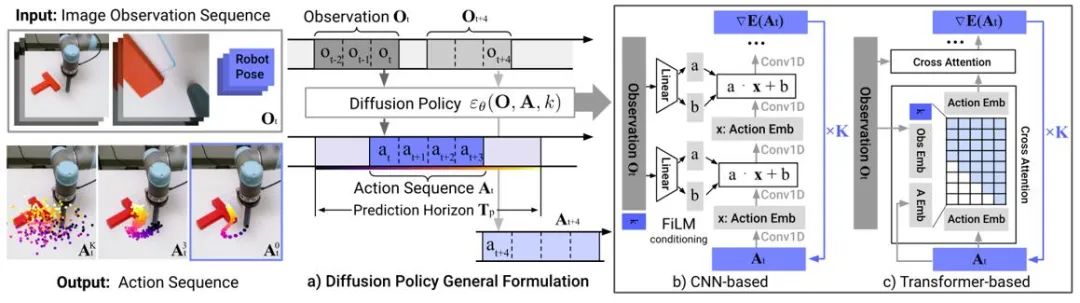

模仿学习通过学习专家演示数据来重建专家行为。扩散模型的应用有助于提高策略表征能力以及学习多样的任务技能。在机器人控制领域,研究发现扩散模型能够在保持时序稳定性的条件下预测闭环动作序列。Diffusion Policy 采用图像输入的扩散模型生成机器人动作序列。实验表明扩散模型能够生成有效闭环动作序列,同时保证时序一致性。

图 4:Diffusion Policy 模型示意图

轨迹生成

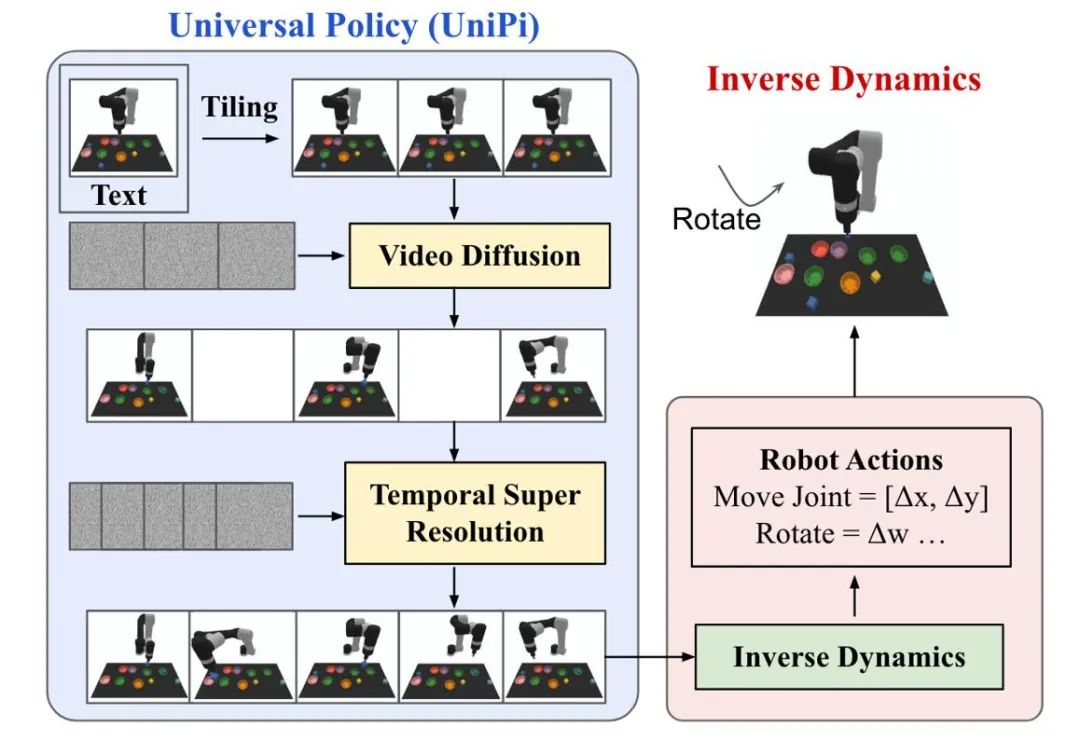

扩散模型在强化学习中的轨迹生成主要聚焦于人类动作生成以及机器人控制两类任务。扩散模型生成的动作数据或视频数据被用于构建仿真模拟器或训练下游决策模型。UniPi 训练了一个视频生成扩散模型作为通用策略,通过接入不同的逆动力学模型来得到底层控制命令,实现跨具身的机器人控制。

图 5:UniPi 决策过程示意图。

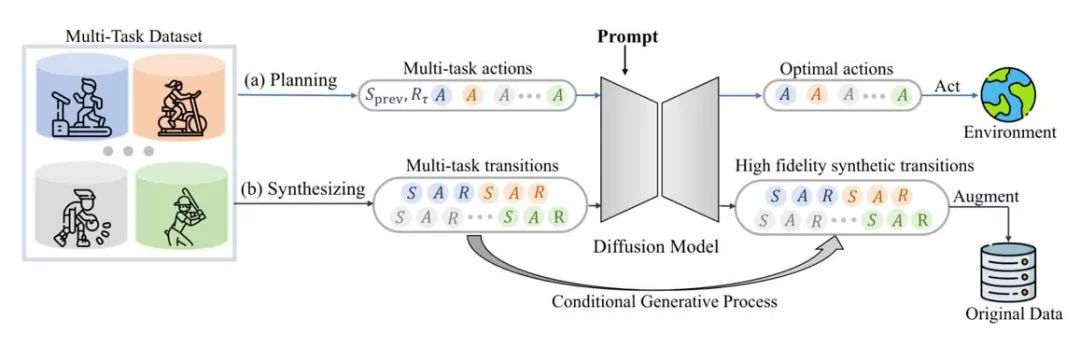

数据增强

扩散模型还可以直接拟合原始数据分布,在保持真实性的前提下提供多样的动态扩展数据。例如,SynthER 和 MTDiff-s 通过扩散模型生成了训练任务的完整环境转移信息并将其应用于策略的提升,且结果显示生成数据的多样程度以及准确性都优于历史方法。

图 6:MTDiff 进行多任务规划和数据增强的示意图

生成式仿真环境

如图 1 所示,现有研究主要利用扩散模型来克服智能体和经验回放池的局限性,利用扩散模型增强仿真环境的研究比较少。Gen2Sim 利用文生图扩散模型在模拟环境中生成多样化的可操作物体来提高机器人精密操作的泛化能力。扩散模型还有可能在仿真环境中生成状态转移函数、奖励函数或多智能体交互中的对手行为。

加入安全约束

通过将安全约束作为模型的采样条件,基于扩散模型的智能体可以做出满足特定约束的决策。扩散模型的引导采样允许通过学习额外的分类器来不断加入新的安全约束,而原模型的参数保持不变,从而节省额外的训练开销。

检索增强生成

检索增强生成技术能够通过访问外部数据集增强模型能力,在大语言模型上得到广泛的应用。通过检索与智能体当前状态相关的轨迹并输入到模型中,基于扩散的决策模型在这些状态下的性能同样可能得到提升。如果检索数据集不断更新,智能体有可能在不重新训练的情况下表现出新的行为。

组合多种技能

与分类器引导或无分类器引导相结合,扩散模型可以组合多种简单技能来完成复杂任务。离线强化学习中的早期结果也表明扩散模型可以共享不同技能之间的知识,从而有可能通过组合不同技能实现零样本迁移或持续学习。

图 7:相关论文汇总分类表格。

以上是扩散模型如何构建新一代决策智能体?超越自回归,同时生成长序列规划轨迹的详细内容。更多信息请关注PHP中文网其他相关文章!