为了避免人工智能(AI)可能带来的巨大风险,OpenAI决定授予董事会更大的权力来监管安全事务,并对上个月刚刚在内部争斗中获胜的CEO Sam Altman进行严格的监督

OpenAI在美东时间12月18日周一发布了一系列指南,旨在跟踪、评估、预测和防范日益强大的人工智能(AI)模型带来的灾难性风险。OpenAI将"灾难性风险"定义为可能导致数千亿美元的经济损失,或导致多人严重伤害或死亡的任何风险

这篇27页的指引被称为“准备框架”,其中提到,即使公司的高层管理人员,包括CEO或由领导层指定的人员认为即将发布的AI模型是安全的,公司董事会仍然有权选择推迟该模型的发布。这意味着,尽管OpenAI的CEO负责日常工作的决策,但董事会将了解风险的发现,并有权否决CEO的决定

OpenAI的准备框架建议除了对公司领导层和董事会权限的规定外,还使用了矩阵方法来记录多个类别的前沿AI模型所带来的风险水平。这些风险包括行为不端者使用AI模型创建恶意软件、发起社会工程攻击,或者传播有害的核武器或生物武器信息

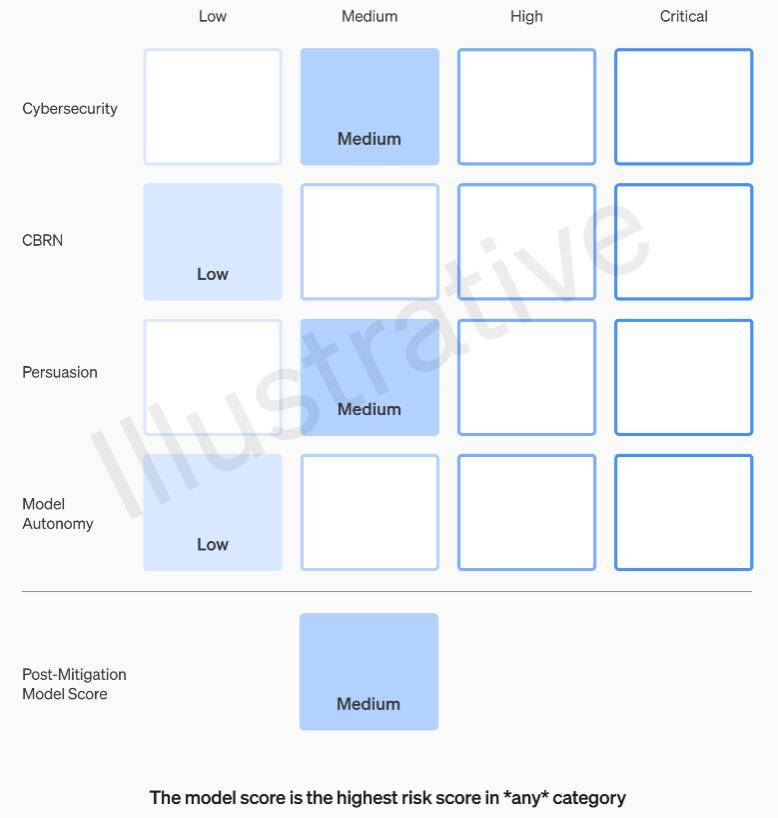

具体来说,OpenAI 在网络安全、CBRN(化学、生物、放射、核威胁)、说服和模型自主四个类别上设定了风险阈值。在实施风险缓解措施之前和之后,OpenAI 将每种风险分为低、中、高或严重四个级别

OpenAI规定,只有在风险缓解后评级为“中”或以下级别的AI模型才可以进行部署,只有在风险缓解后评级为“高”或以下的模型才能继续进行开发,如果无法将风险降低到严重以下级别,公司将停止开发模型。对于在风险缓解之前评定为高风险或严重风险的模型,OpenAI还将采取额外的安全措施

OpenAI将安全问题处理人员分为三个团队。安全系统团队专注于减轻和解决当前产品(如GPT-4)带来的风险。超对齐团队则关注未来系统超越人类能力可能带来的问题。此外,还有一个名为准备的新团队,由麻省理工学院(MIT)电气工程与计算机科学系(EECS)教授Aleksander Madry领导

新的团队将对强大的模型开发和实施进行评估。他们将专门负责监督与安全决策有关的技术工作和操作架构。他们将推动技术工作,审查前沿模型能力的限制,并进行评估和综合相关报告

Madry表示,他的团队将定期评估OpenAI尚未发布的最先进的人工智能模型的风险水平,并每月向OpenAI内部的安全顾问组织(SAG)提交报告。SAG将分析Madry团队的工作,并向CEO Altman和公司董事会提供建议

根据本周一公布的指引文件显示,Altman及其领导层可以根据这些报告来决定是否发布新的AI系统,但董事会保有推翻他们决定的权力

目前,Madry的团队只有四个人,但他正在努力招募更多的成员。预计团队成员将会达到15到20人的规模,与现有的安全团队和超对齐团队的人数相当

Madry希望其他人工智能公司能够以类似的方式评估其模型的风险,并认为这可能成为监管的典范

以上是OpenAI指引允许董事会限制CEO发布新模型,以防范AI风险的详细内容。更多信息请关注PHP中文网其他相关文章!