今年的ICCV2023 best student paper颁给了康奈尔大学的qianqian wang,目前是加州大学伯克利分校的博士后研究员!

在视频运动估计领域,作者指出传统方法主要分为两种:稀疏特征跟踪和密集光流。虽然这两种方法都在各自的应用中被证明有效,但它们都无法完整地捕捉到视频中的运动。成对的光流无法捕获长时间窗口内的运动轨迹,而稀疏跟踪则无法模拟所有像素的运动

为了弥补这一差距,许多研究都试图在视频中同时估计密集和长距离的像素轨迹。这些研究的方法多种多样,从简单地将两帧光流场链接起来,到直接预测在多帧中的每个像素轨迹。但这些方法在估计运动时往往只考虑有限的上下文,并忽略了时间或空间上较远的信息。这种短视可能导致长轨迹中的错误累积,以及运动估计中的时空不一致。尽管某些方法考虑了长时间的上下文,但它们仍然在2D领域进行操作,这可能在遮挡事件中导致跟踪丢失。

总的来说,视频中的密集和长距离轨迹估计仍然是该领域一个尚未解决的问题。这个问题涉及到三个主要挑战:1)如何在长序列中保持轨迹的准确性,2)如何在遮挡情况下跟踪点的位置,3)如何保持时空的一致性

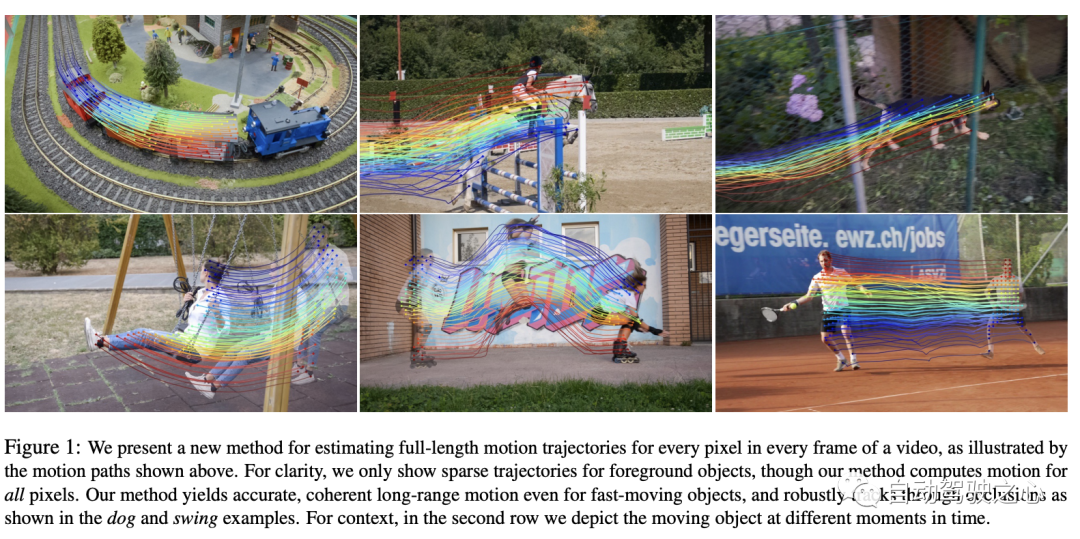

在这篇文章中,作者提出了一种新颖的视频运动估计方法,该方法利用视频中的所有信息来共同估计每个像素的完整运动轨迹。这种方法被称为"OmniMotion",它采用了一种准3D的表示形式。在这种表示形式中,一个标准的3D体被映射到每一帧的局部volume。这种映射作为动态多视图几何的一种灵活扩展,可以同时模拟相机和场景的运动。这种表示形式不仅确保了循环的一致性,还能在遮挡时跟踪所有的像素。作者为每个视频优化了这种表示形式,从而为整个视频的运动提供了解决方案。经过优化后,这种表示形式可以在视频的任何连续坐标上查询,以获得跨越整个视频的运动轨迹

本文提出的这种方法可以:1) 为整个视频中的所有点生成全局一致的完整运动轨迹,2) 跟踪经过遮挡的点,以及3) 处理具有各种相机和场景动作组合的实际视频。在TAP视频跟踪基准测试中,该方法表现出色,远远超越了之前的方法。

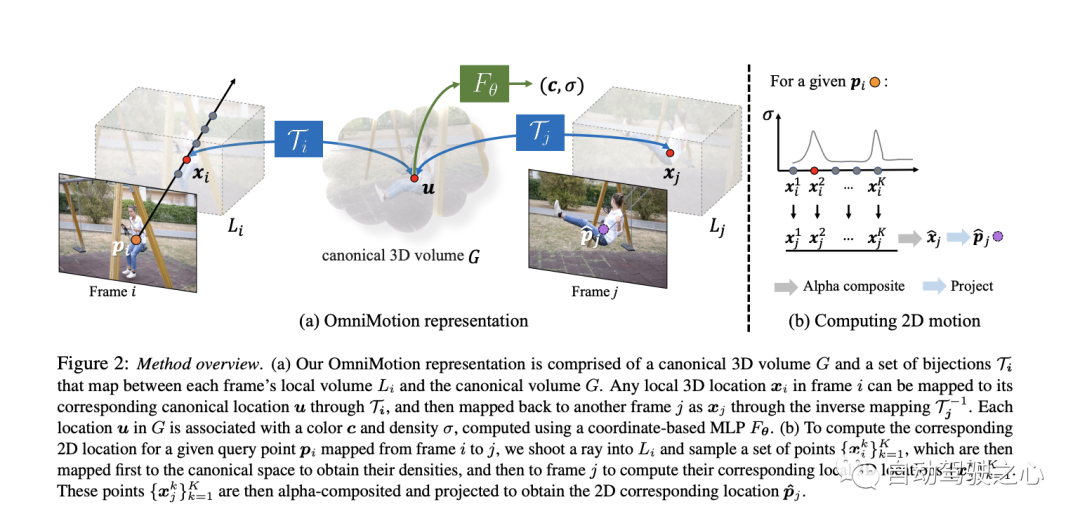

论文提出了一种基于测试时优化的方法,用于从视频序列中估计密集和长距离的运动。首先来对论文提出的方法来一个总览:

这种方法能够提供一个全面且连贯的视频运动表示,并且能够有效地解决遮挡等挑战性问题。现在我们来详细了解一下

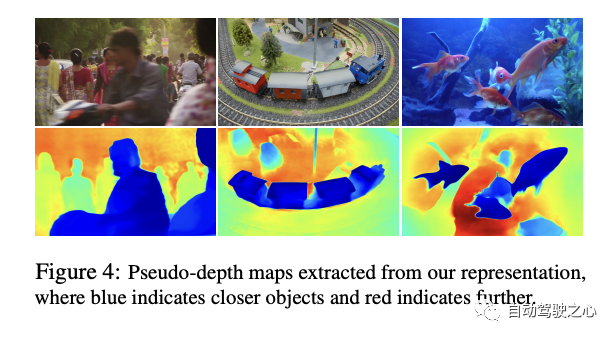

视频内容由一个名为G的典型volume表示,该volume充当观察到的场景的三维地图。与NeRF中的做法类似,他们定义了一个基于坐标的网络nerf,它为G中的每个典型3D坐标uvw映射到一个密度σ和颜色c。G中存储的密度告诉我们典型空间中的表面位置。当与3D双射结合使用时,这使我们能够跟踪多帧的表面并理解遮挡关系。G中存储的颜色则允许我们在优化期间计算光度损失。

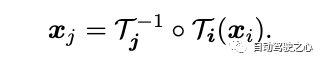

本文介绍了一个连续的双射映射,记为,它将3D点从局部坐标系转换到一个规范的3D坐标系。这个规范坐标作为一个场景点或3D轨迹在时间上的一致引用或“索引”。使用双射映射的主要优势是它们在不同帧之间的3D点提供的周期一致性,因为它们都源于同一个规范点。

从一个局部帧到另一个的3D点的映射方程为:

为了捕捉复杂的真实世界运动,这些双射被参数化为可逆神经网络(INNs)。选择Real-NVP作为模型是受到其简单性和其解析可逆性的属性的影响。Real-NVP通过使用称为仿射耦合层的基本变换来实现双射映射。这些层将输入分割,使一部分保持不变,而另一部分则进行仿射变换。

为了进一步增强这种架构,我们可以通过对每一帧的潜码latent_i进行条件化来实现。因此,所有的可逆映射mapping i都是由一个单一的可逆网络mappingnet确定,但它们具有不同的潜码latent code

重新计算帧间运动

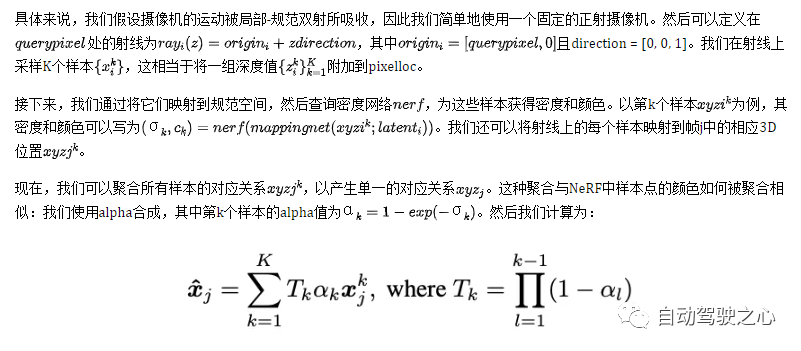

在这部分,描述如何为帧i中的任何查询像素querypixel计算2D运动。直观地说,首先通过在射线上采样点将查询像素“提升”到3D,然后使用双射mapping i和mapping j将这些3D点“映射”到目标帧j,接着通过alpha合成从不同的样本“渲染”这些映射的3D点,最后“投影”回2D以获得一个假定的对应关系。

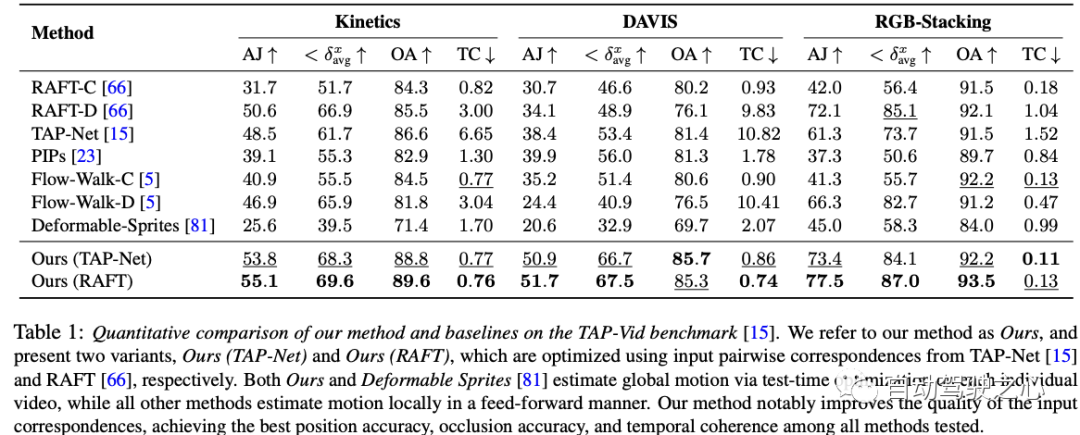

这份实验数据表格展示了在三个数据集——Kinetics、DAVIS和RGB-Stacking上,多种运动估计方法的表现。为了评估各个方法的性能,使用了四个度量标准:AJ、avg、OA和TC。除了作者提出的两种方法(我们的(TAP-Net)和我们的(RAFT)),还有其他7种方法。值得注意的是,作者的两种方法在大部分度量和数据集上都表现出色。具体来说,我们的(RAFT)方法在所有三个数据集的AJ、avg和OA上取得了最佳成绩,而在TC上则次佳。我们的(TAP-Net)方法在某些度量上也达到了类似的优异表现。与此同时,其他方法在这些度量上的表现则参差不齐。需要提及的是,作者的方法和“Deformable Sprites”方法通过在每个视频上的测试时间优化来估计全局运动,而其他所有方法都采用前向方式在局部进行运动估计。总结来说,作者的方法在位置精度、遮挡精度和时间连续性上都超越了其他所有测试的方法,展现出了显著的优势

这是一个针对DAVIS数据集的消融实验结果表格。消融实验是为了验证每个组件对整个系统性能的贡献大小。这个表格中列出了四种方法,其中三种是去除了某个关键组件的版本,而最后的"Full"版本包含了所有组件。

总的来说,这个消融实验的结果显示,虽然每个组件都对性能有一定的提升,但可逆性可能是最重要的组件,因为没有它的话,性能损失会非常严重

这份工作中对DAVIS数据集进行的消融实验为我们提供了宝贵的洞察,揭示了每个组件对整个系统性能的关键作用。从实验结果中,我们可以明确看到可逆性组件在整体框架中起到了至关重要的作用。当缺少这一关键组件时,系统的性能大幅下降。这进一步强调了在动态视频分析中考虑可逆性的重要性。同时,尽管光度组件的缺失也会导致性能下降,但它对性能的影响似乎不如可逆性那么大。此外,统一的采样策略虽然对性能有一定的影响,但与前两者相比,其影响相对较小。最后,完整的方法整合了所有这些组件,为我们展示了在所有考虑因素下可以达到的最佳性能。总体来说,这份工作为我们提供了一个深入了解视频分析中各个组件如何相互作用,以及它们对整体性能的具体贡献的宝贵机会,从而强调了在设计和优化视频处理算法时采用综合方法的重要性

但是,像许多运动估计方法一样,我们的方法在处理快速和高度非刚性运动以及细小结构时面临困难。在这些情境下,成对的对应方法可能无法为我们的方法提供足够的可靠对应关系来计算精确的全局运动。另外,由于基础优化问题的高度非凸性质,我们观察到,对于某些困难的视频,我们的优化过程可能对初始化非常敏感。这可能会导致次优的局部最小值,例如,错误的表面排序或在规范空间中的重复对象,有时这些问题很难通过优化来纠正。

最后,我们的方法在其当前形式下可能在计算上是昂贵的。首先,流量收集过程涉及全面计算所有的成对流,这与序列长度呈二次比例增长。但我们相信,通过探索更高效的匹配方法,例如词汇树或基于关键帧的匹配,并从结构运动和SLAM文献中获取灵感,可以提高这一过程的可扩展性。其次,与其他使用神经隐式表示的方法一样,我们的方法涉及一个相对较长的优化过程。此领域的近期研究可能有助于加速这一过程,并进一步扩展到更长的序列

本文提出了一种新的测试时优化方法,用于估计整个视频的完整和全局一致的运动。引入了一个新的视频运动表示,称为OmniMotion,它包括一个准3D标准volume和每帧的local-canonical双射。OmniMotion可以处理具有不同摄像机设置和场景动态的普通视频,并通过遮挡产生准确且平滑的长距离运动。在质量和数量上,都比以前的最先进方法取得了显著的改进。

需要重写的内容是:原文链接:https://mp.weixin.qq.com/s/HOIi5y9j-JwUImhpHPYgkg

以上是标题重写:ICCV 2023优秀学生论文跟踪,Github已经获得1.6K star,仿佛魔法般的全面信息!的详细内容。更多信息请关注PHP中文网其他相关文章!