惊人发现:大模型在知识推演上存在严重缺陷。

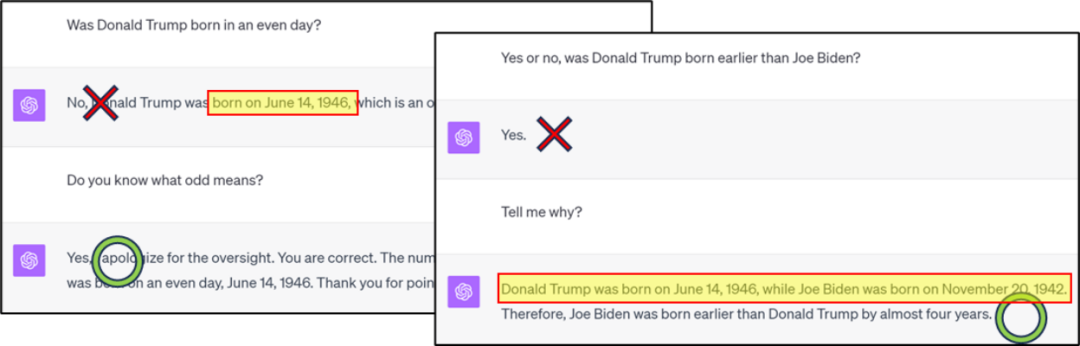

需要重新写作的内容是:图1:GPT4在知识分类/比较上出现错误,但通过思维链可以得到正确答案

需要重新写的内容是:图2:GPT4知识逆向搜索错误示例

请点击以下链接查看论文:https://arxiv.org/abs/2309.14402

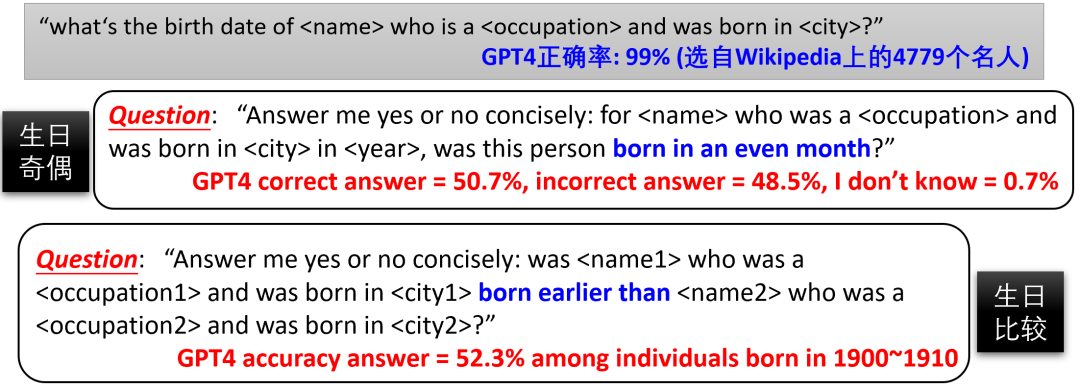

先问一个问题,诸如图 1/2/3 这样的问题,是 GPT4 对人的生日记忆不够精确(压缩比不够,训练 loss 不够低),还是未通过微调深化对奇偶性的理解?是否可以通过微调 GPT4,使其能够在模型内部组合现有知识,生成 "生日的奇偶性" 这种新知识,从而无需依赖 CoT 直接回答相关问题?由于我们不知道 GPT4 的训练数据集,无法微调。因此,作者提出通过可控训练集,来更深入研究语言模型的 “知识推演” 能力。

图 4:对 GPT4 之类的预训练模型,由于互联网数据的不可控性,很难确定情形 B/C/D 是否发生

在《语言模型物理学 Part 3.1:知识的储存与提取》一文中,作者构建了一个包含10万个人物传记的数据集。每个传记都包括人名以及六个属性:出生日期、出生地、大学专业、大学名称、工作地点和工作单位。举个例子:

「Anya Briar Forgeroriginated fromPrinceton, NJ.She dedicated her studies toCommunications. She gained work experience inMenlo Park, CA. She developed her career atMeta Platforms. She came into this world onOctober 2, 1996. She pursued advanced coursework atMIT.」

作者确保了传记条目的多样性,以帮助模型更好的存取知识。在预训练 (pretrain) 后,模型能通过微调准确回答知识提取类问题,如 “Anya 的生日是哪天” (正确率接近 100%)

接下来作者继续微调,试图让模型学会知识推演类问题,如知识的分类 / 比较 / 加减。文章发现,自然语言模型在知识推演方面的能力非常有限,难以通过微调产生新知识,即便它们只是模型已掌握知识的简单变换 / 组合。

图 5:若微调时不使用 CoT,让模型进行知识的分类 / 比较 / 减法,需要海量的样本或者正确率极低 —— 实验中用了 100 个专业

如图 5,作者发现,尽管预训练(pretrain)之后模型已经能准确回答每个人的生日(正确率接近 100%),但要通过微调让其回答 “xxx 的出生月是偶数吗?” 并达到 75% 的正确率 —— 别忘了盲猜有 50% 的正确率 —— 需要至少 10000 个微调样本。相较之下,如果模型能正确完成 “生日” 和 “奇偶性” 的知识组合,那么根据传统机器学习理论,模型只需学习对 12 个月份进行二分类,通常约 100 个样本就足够了!

同样,即使经过模型预训练后,它能够准确回答每个人的专业(共100个不同专业),但是即使使用了50000个微调样本,让模型比较“Anya的专业和Sabrina的专业哪个更好”,正确率仅为53.9%,几乎相当于瞎猜

然而,当我们使用CoT微调模型学习"Anya的出生月是十月,因此是偶数"这样的句子时,模型在测试集上判断出生月奇偶性的准确率显著提高(参见图5中的"测试用CoT"一列)

作者还尝试在微调训练数据中混合CoT和非CoT的回答,结果发现模型在测试集上不使用CoT时的正确率仍然很低(见图5的"test不用CoT"一列)。这说明,即便补上足够的CoT微调数据,模型依然无法学会"颅内思考"并直接报答案

这些结果表明,对于语言模型来说,进行简单的知识运算极其困难!模型必须先把知识点写出来再进行运算,无法像人一样在大脑里直接进行操作,即使经过充分的微调也无济于事。

逆向知识搜索所面临的挑战

研究还发现,自然语言模型无法通过逆向搜索来应用所学到的知识。尽管它可以回答有关某人的所有信息,但无法根据这些信息确定人名

作者对GPT3.5/4进行了试验,发现它们在逆向知识提取方面表现不佳(见图6)。然而,由于我们无法确定GPT3.5/4的训练数据集,这并不能证明所有语言模型都存在这个问题

图6:GPT3.5/4正向/逆向知识搜索的对比。我们之前报道的"逆转诅咒"工作(arxiv 2309.12288)也在现有的大模型上观察到了这一现象

作者利用前述的人物传记数据集,对模型的逆向知识搜索能力进行了更深入的可控试验。由于所有传记的人名都在段首,作者设计了10个反向信息提取问题,例如:

请问您知道在1996年10月2日在新泽西州普林斯顿出生的人叫什么名字吗?

“请告诉我在 MIT 学习 Communications ,1996 年 10 月 2 日在 Princeton, NJ 出生,并在 Menlo Park, CA 的 Meta Platforms 工作的人的名字是什么?”

需要进行改写的内容是:图7:在名人传记数据集上进行的可控试验

作者验证了,尽管模型实现了无损知识压缩和充分知识增强,且能几乎 100% 正确提取这些知识,在经过微调后,模型仍无法进行知识的逆向搜索,准确率几乎为零(见图 7)。但是,一旦逆向知识直接出现在预训练集中,逆向搜索的准确率立即飙升。

综上所述,只有在预训练集 (pretrain data) 中直接包含了逆向知识时,模型才能通过微调来回答逆向问题 —— 但这实际上是作弊,因为如果知识已经反转,就不再是 “逆向知识搜索” 了。如果预训练集只包含正向知识,模型无法通过微调来掌握逆向回答问题的能力。因此,使用语言模型进行知识索引 (knowledge database) 目前看来是不可能的。

此外,有些人可能会认为,上述的"逆向知识搜索"失败是因为自回归语言模型(如GPT)是单向的。然而,实际上,双向语言模型(如BERT)在知识提取方面表现更差,甚至在正向提取方面也会失败。对于感兴趣的读者,可以参考论文中的详细信息

以上是语言模型有重大缺陷,知识推演竟然是老大难的详细内容。更多信息请关注PHP中文网其他相关文章!