近期,浙江大学ReLER实验室将SAM与视频分割进行深度结合,发布Segment-and-Track Anything (SAM-Track)。

SAM-Track赋予了SAM对视频目标进行跟踪的能力,并支持多种方式(点、画笔、文字)进行交互。

在此基础上,SAM-Track统一了多个传统视频分割任务,达成了一键分割追踪任意视频中的任意目标,将传统视频分割外推至通用视频分割。

SAM-Track具有卓越的性能,在复杂场景下仅需单卡就能高质量地稳定跟踪数百个目标。

项目地址:https://github.com/z-x-yang/Segment-and-Track-Anything

论文地址:https://arxiv.org/abs/2305.06558

SAM-Track支持语言输入作为Prompt。比如,给定类别文本「熊猫」,便可一键实例级分割追踪所有属于「熊猫」这一类别的目标。

也可进一步给出更详细的描述,比如输入文字「最左边的熊猫」,SAM-Track可以定位至特定目标进行分割追踪。

相较于传统视频追踪算法,SAM-Track的另一个强大之处在于可对大量目标同时进行跟踪分割,并自动检测新出现的物体。

SAM-Track还支持多种交互方式组合使用,用户可根据实际需求搭配。比如使用画笔来框定与人体紧密连接的滑板,防止分割多余物体,而后使用点击选择人体。

全自动视频目标分割与追踪自然也不在话下,各种应用场景包括街景、航拍、AR、动画、医学图像等,均可一键分割追踪并自动检测新出现的物体。

如果对自动分割结果不满意,用户可在此基础上进行编辑修正,例如使用点击来修正过分割的电车。

同时最新版本的SAM-Track支持对追踪结果进行在线浏览,可选择中间任意一帧的分割结果进行修改和新增目标,并再次追踪。

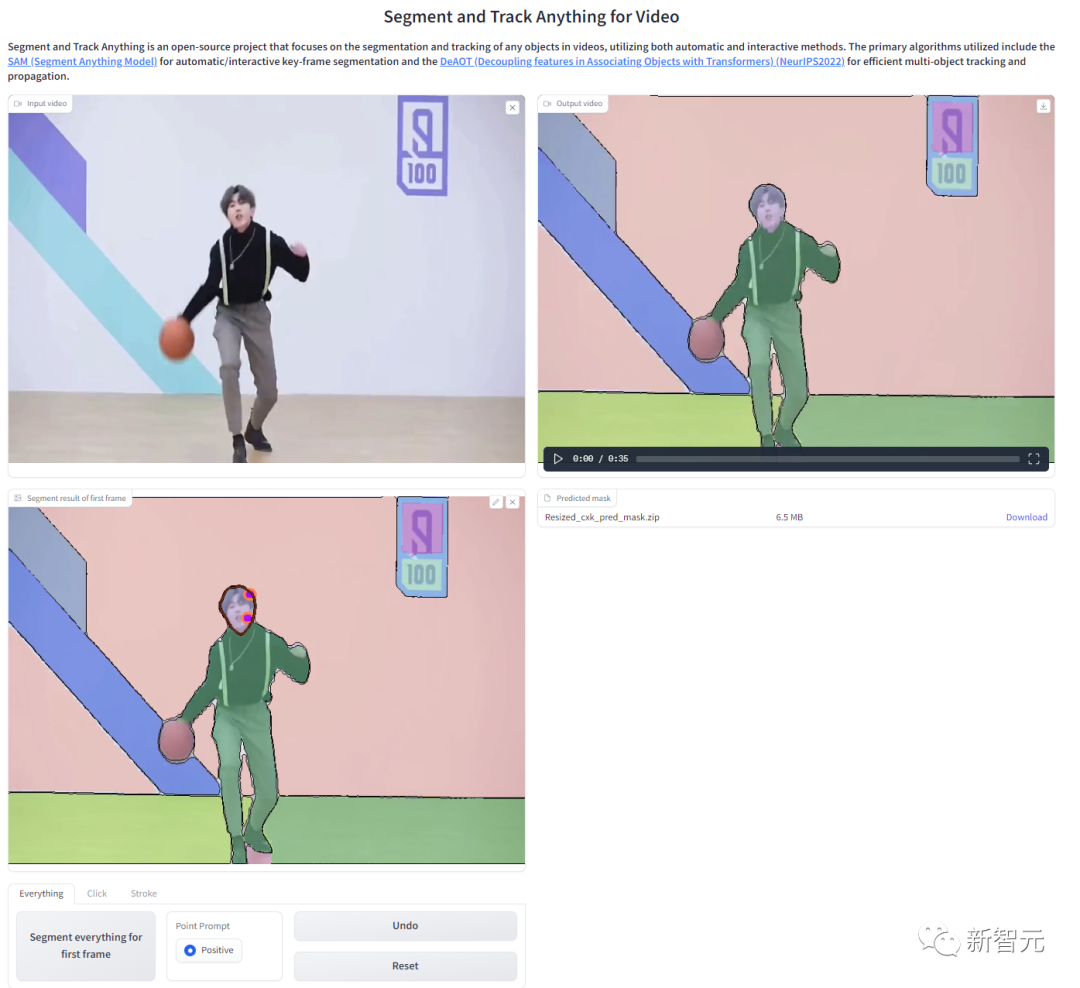

为了方便用户线上体验,项目提供了WebUI,可通过Colab一键部署:

SAM-Track模型基于ECCV'22 VOT Workshop四个赛道的冠军方案DeAOT。

DeAOT是一个高效的多目标VOS模型,在给定首帧物体标注的情况下,可以对视频其余帧中的物体进行追踪分割。

DeAOT采用一种识别机制,将一个视频中的多个目标嵌入到同一高维空间中,从而实现了同时对多个物体进行追踪。

DeAOT在多物体追踪方面的速度表现能够与其他针对单个物体追踪的VOS方法相媲美。

此外,通过基于分层的Transformer的传播机制,DeAOT更好地聚合了长时序和短时序信息,表现出了优异的追踪性能。

由于DeAOT需要参考帧的标注来初始化,为了提高便捷性,SAM-Track使用了最近在图像分割领域大放异彩的Segment Anything Model(SAM)模型来获取标注信息。

利用SAM出色的零样本迁移能力,以及多种交互方式,SAM-Track能高效地为DeAOT获取高质量的参考帧标注信息。

虽然SAM模型在图像分割领域表现出色,但它无法输出语义标签,且文本提示也不能很好地支持Referring Object Segmentation及其他依赖深层语义理解的任务。

因此,SAM-Track模型进一步集成了Grounding-DINO,实现了高精度的语言引导的视频分割。Grounding DINO是一个开放集合目标检测模型,具有很好的语言理解能力。

根据输入的类别或目标对象的详细描述,Grounding-DINO可以检测到目标并返回位置框。

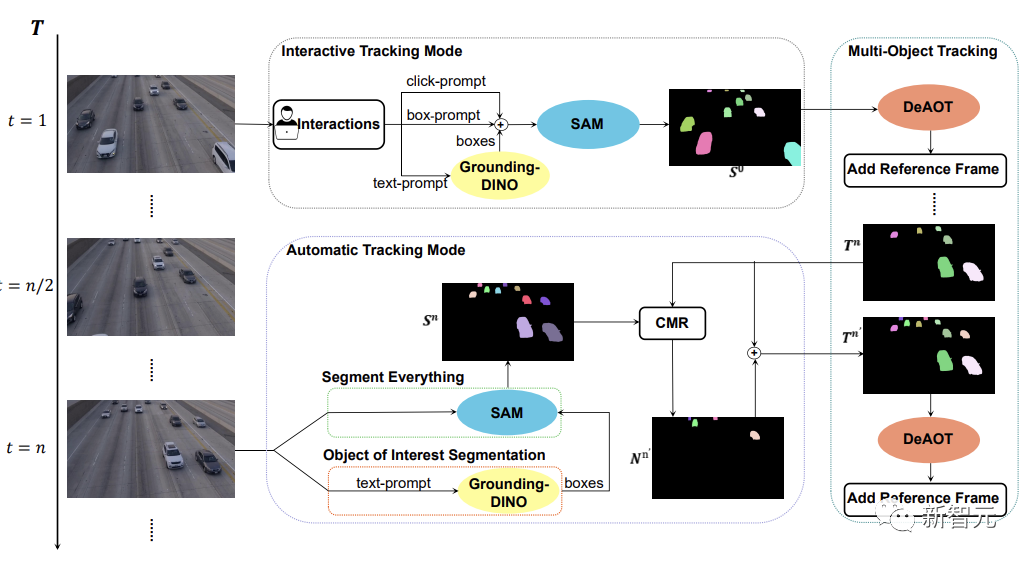

如下图所示,SAM-Track模型支持了三种物体跟踪模式,分别为交互跟踪模式、自动跟踪模式以及融合模式。

对于交互跟踪模式,SAM-Track模型首先会应用SAM,在参考帧中利用点击或画框的方式选中目标,直到得到用户满意的交互分割结果。

如果想要实现语言引导的视频物体分割,SAM-Track则会调用Grounding-DINO根据输入的文本,先得到目标物体的位置框,并在此基础上通过SAM得到感兴趣物体的分割结果。

最后DeAOT将交互分割结果作为参考帧,对选中的目标进行追踪。在追踪的过程中,DeAOT会将过去帧中的视觉嵌入和高维ID嵌入分层传播到当前帧中,实现逐帧追踪分割多个目标对象。因此,SAM-Track能过支持多模态的交互方式来追踪分割视频中的感兴趣物体。

然而,交互跟踪模式无法处理视频中出现的新出现的物体。限制了SAM-Track在特定领域的应用,例如,自动驾驶,智慧城市等。

为了进一步拓展SAM-Track的应用范围和性能,SAM-Track实现了自动跟踪模式,对视频中出现的新物体进行追踪。

自动跟踪模式通过Segment Everything和Object of Interest Segmentation两种方式来获得每n帧中新出现的物体的注释。对于新出现的物体的ID分配问题,SAM-Track采用了比较掩码模块(CMR)来确定新的对象的ID。

融合模式则是把交互跟踪模式和自动跟踪模式相结合。通过交互式跟踪模式用户可以很方便地获取视频中第一帧的注释,而自动跟踪模式则可以处理视频后续帧中出现的未被选中的新对象。追踪方法的组合扩大了SAM-Track的应用范围,增加了SAM-Track的实用性。

以上是视频分割大结局!浙大最新发布SAM-Track:通用智能视频分割一键直达的详细内容。更多信息请关注PHP中文网其他相关文章!