译者 | 李睿

审校 | 孙淑娟

BigScience研究项目日前发布了一个大型语言模型BLOOM,乍一看,它看起来像是复制OpenAI的GPT-3的又一次尝试。

但BLOOM与其他大型自然语言模型(LLM)的不同之处在于,它在研究、开发、培训和发布机器学习模型方面所做的努力。

近年来,大型科技公司将大型自然语言模型(LLM)就像严守商业机密一样隐藏起来,而BigScience团队从项目一开始就把透明与开放放在了BLOOM的中心。

其结果是一个大型语言模型,可以供研究和学习,并可供所有人使用。BLOOM所建立的开源和开放合作示例对大型自然语言模型(LLM)和其他人工智能领域的未来研究非常有益。但仍有一些需要解决的大型语言模型固有的一些挑战。

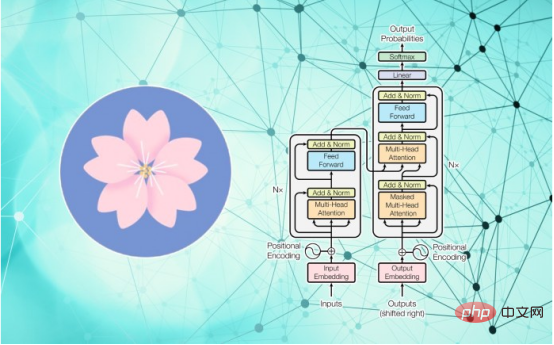

BLOOM是“BigScience大型开放科学开放获取多语言模型”的简称。从数据来看,它与GPT-3和OPT-175B并没有太大的区别。它是一个非常大的Transformer 模型,拥有1760亿个参数,使用1.6TB的数据进行训练,其中包括自然语言和软件源代码。

与GPT-3一样,它可以通过零镜头或少镜头学习执行许多任务,其中包括文本生成、摘要、问题回答和编程等。

但BLOOM的重要性在于其背后的组织和构建过程。

BigScience是一个研究项目,由机器学习模型中心“Hugging Face”于2021年启动。根据其网站的描述,该项目“旨在展示在人工智能/自然语言处理研究社区内创建、学习和共享大型语言模型和大型研究工件的另一种方式。”

在这方面,BigScience从欧洲核子研究中心(CERN)和大型强子对撞机(LHC)等科学创造计划中获得了灵感,在这些计划中,开放的科学合作促进了对整个研究社区有用的大规模人工制品的创造。

从2021年5月以来的一年时间里,来自60个国家和250多个机构的1000多名研究人员在BigScience共同创造了BLOOM。

虽然大多数主要的大型自然语言模型(LLM)都只接受英语文本的训练,但BLOOM的训练语料库包括46种自然语言和13种编程语言。这对于主要语言不是英语的许多地区都很有用。

BLOOM也打破了对大型科技训练公司模型的实际依赖。大型自然语言模型(LLM)的主要问题之一是训练和调整成本过高。这一障碍使得具有1000亿个参数大型自然语言模型(LLM)成为拥有雄厚资金的大型科技公司的专属领域。近年来,人工智能实验室被大型科技公司吸引,以获得补贴的云计算资源,并为其研究提供资金。

相比之下,BigScience研究团队获得了法国国家科学研究中心的300万欧元资助,用于在超级计算机Jean Zay上训练BLOOM。而没有任何协议授予商业公司这项技术的独家许可,也没有承诺将该模型实现商业化,并将其转化为可盈利的产品。

此外,BigScience团队对模型训练的整个过程是完全透明的。他们发布了数据集、会议记录、讨论和代码,以及训练模型的日志和技术细节。

研究人员正在研究该模型的数据和元数据,并发布有趣的发现。

例如,研究人中David McClure于2022年7月12日在推特上表示,“我一直在研究来自Bigscience和Hugging Face的非常酷的BLOOM模型背后的训练数据集。其中有来自英语语料库的1000万块样本,大约占总数的1.25%、用'all-distilroberta-v1'编码,然后从UMAP到2d。”

当然,经过训练的模型本身可以在Hugging Face的平台上下载,这减轻了研究人员花费数百万美元进行训练的痛苦。

Facebook公上个月在一些限制下开源了其中一个大型自然语言模型(LLM)。然而,BLOOM带来的透明度是前所未有的,并有望为该行业设立一个新的标准。

BLOOM训练联合负责人Teven LeScao表示,“与工业人工智能研究实验室的保密性相比,BLOOM证明了最强大的人工智能模型可以由更广泛的研究社区以负责和开放的方式进行训练和发布。”

虽然BigScience为人工智能研究和大型语言模型带来开放性和透明度的努力值得称赞,但该领域固有的挑战仍然没有改变。

大型自然语言模型(LLM)研究正朝着越来越大的模型发展,这将进一步增加训练和运行成本。BLOOM使用384个Nvidia Tesla A100 GPU (每个价格约为约3.2万美元)进行训练。而更大的模型将需要更大的计算集群。BigScience团队已经宣布将继续创建其他开源大型自然语言模型(LLM),但该团队将如何为其日益昂贵的研究提供资金还有待观察。例如,OpenAI最初是一家非盈利组织,后来变成了一家销售产品、依赖微软资金的盈利性组织。

另一个有待解决的问题是运行这些模型的巨大成本。压缩后的BLOOM模型的大小为227GB,运行它需要拥有数百GB内存的专用硬件。作为比较,GPT-3需要的计算集群相当于Nvidia DGX 2,其价格约为40万美元。“Hugging Face”计划推出一个API平台,使研究人员能够以每小时40美元左右的价格使用该模型,这是一笔不小的成本。

运行BLOOM的成本还将影响希望构建由大型自然语言模型(LLM)支持的产品的应用机器学习社区、初创公司和组织。目前,OpenAI提供的GPT-3API更适合产品开发。而了解BigScience和Hugging Face将朝哪个方向发展,使开发者能够在其有价值的研究基础上开发产品,这将成为一件有趣的事情。

在这方面,人们期待BigScience在未来发布的模型中有更小的版本。与媒体经常描述的相反,大型自然语言模型(LLM)仍然遵循“没有免费的午餐”的原则。这意味着在应用机器学习时,一个针对特定任务进行微调的更紧凑的模型比一个在许多任务上具有平均性能的非常大的模型更有效。例如,Codex是GPT-3的一个修改版本,它以GPT-3的一小部分规模和成本为编程提供了很好的帮助。GitHub目前提供基于Codex的产品Copilot,每月收费10美元。

随着BLOOM希望建立的新文化,而研究未来学术和应用人工智能走向何方将是一件有趣的事情。

原文标题:BLOOM can set a new culture for AI research—but challenges remain,作者:Ben Dickson

以上是BLOOM可以为人工智能研究创造一种新的文化,但挑战依然存在的详细内容。更多信息请关注PHP中文网其他相关文章!