GitHub: https://github.com/chatsapi/ChatsAPI

图书馆: https://pypi.org/project/chatsapi/

人工智能已经改变了各行各业,但有效部署人工智能仍然是一项艰巨的挑战。复杂的框架、缓慢的响应时间和陡峭的学习曲线给企业和开发人员带来了障碍。 ChatsAPI 是一个突破性的高性能 AI 代理框架,旨在提供无与伦比的速度、灵活性和简单性。

在本文中,我们将揭示 ChatsAPI 的独特之处、为何它能够改变游戏规则,以及它如何帮助开发人员以无与伦比的轻松性和效率构建智能系统。

ChatsAPI 不仅仅是另一个人工智能框架;这是人工智能驱动交互的一场革命。原因如下:

速度:ChatsAPI 的响应时间为亚毫秒级,是世界上最快的人工智能代理框架。其 HNSWlib 支持的搜索可确保快速检索路线和知识,即使对于大型数据集也是如此。

效率:SBERT 和 BM25 的混合方法将语义理解与传统排名系统结合起来,保证速度和准确性。

与法学硕士无缝集成

ChatsAPI 支持最先进的大型语言模型 (LLM),例如 OpenAI、Gemini、LlamaAPI 和 Ollama。它简化了将法学硕士集成到您的应用程序中的复杂性,使您能够专注于构建更好的体验。

动态路由匹配

ChatsAPI 使用自然语言理解 (NLU) 以无与伦比的精度将用户查询与预定义路由动态匹配。

使用 @trigger 等装饰器轻松注册路线。

使用 @extract 进行参数提取来简化输入处理,无论您的用例有多复杂。

高性能查询处理

传统的人工智能系统要么在速度上要么在准确性上苦苦挣扎,而 ChatsAPI 却同时满足了这两点。无论是在庞大的知识库中寻找最佳匹配,还是处理大量查询,ChatsAPI 都表现出色。

灵活的框架

ChatsAPI 适应任何用例,无论您正在构建:

由开发者设计,为开发者服务,ChatsAPI 提供:

ChatsAPI 的核心是通过三个步骤进行操作:

结果呢?一个快速、准确且易于使用的系统。

客户支持

通过极快的查询解析来自动化客户交互。 ChatsAPI 确保用户立即获得相关答案,提高满意度并降低运营成本。

知识库搜索

使用户能够通过语义理解搜索大量知识库。混合 SBERT-BM25 方法可确保准确、上下文感知的结果。

对话式人工智能

构建能够实时理解并适应用户输入的对话式人工智能代理。 ChatsAPI 与顶级法学硕士无缝集成,提供自然、引人入胜的对话。

其他框架承诺灵活性或性能 - 但没有一个框架能够像 ChatsAPI 一样同时提供这两者。我们创建了一个框架:

ChatsAPI 使开发人员能够释放人工智能的全部潜力,而无需担心复杂性或性能缓慢的问题。

ChatsAPI 入门很简单:

pip install chatsapi

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Hello")

async def greet(input_text):

return "Hi there!"

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

Run your message (with no LLM)

@app.post("/chat")

async def message(request: RequestModel, response: Response):

reply = await chat.run(request.message)

return {"message": reply}

import os

from dotenv import load_dotenv

from fastapi import FastAPI, Request, Response

from pydantic import BaseModel

from chatsapi.chatsapi import ChatsAPI

# Load environment variables from .env file

load_dotenv()

app = FastAPI() # instantiate FastAPI or your web framework

chat = ChatsAPI( # instantiate ChatsAPI

llm_type="gemini",

llm_model="models/gemini-pro",

llm_api_key=os.getenv("GOOGLE_API_KEY"),

)

# chat trigger - 1

@chat.trigger("Want to cancel a credit card.")

@chat.extract([("card_number", "Credit card number (a 12 digit number)", str, None)])

async def cancel_credit_card(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# chat trigger - 2

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# request model

class RequestModel(BaseModel):

message: str

# chat conversation

@app.post("/chat")

async def message(request: RequestModel, response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

reply = await chat.conversation(request.message, session_id)

return {"message": f"{reply}"}

# set chat session

@app.post("/set-session")

def set_session(response: Response):

session_id = chat.set_session()

response.set_cookie(key="session_id", value=session_id)

return {"message": "Session set"}

# end chat session

@app.post("/end-session")

def end_session(response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

chat.end_session(session_id)

response.delete_cookie("session_id")

return {"message": "Session ended"}

await chat.query(request.message)

基于传统 LLM (API) 的方法通常每个请求需要大约四秒的时间。相比之下,ChatsAPI 可以在一秒内处理请求,通常在几毫秒内,无需进行任何 LLM API 调用。

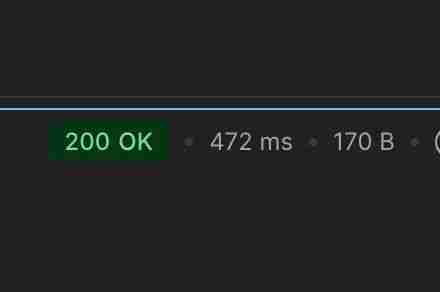

472ms内执行聊天路由任务(无缓存)

21ms内执行聊天路由任务(缓存后)

862ms内执行聊天路由数据提取任务(无缓存)

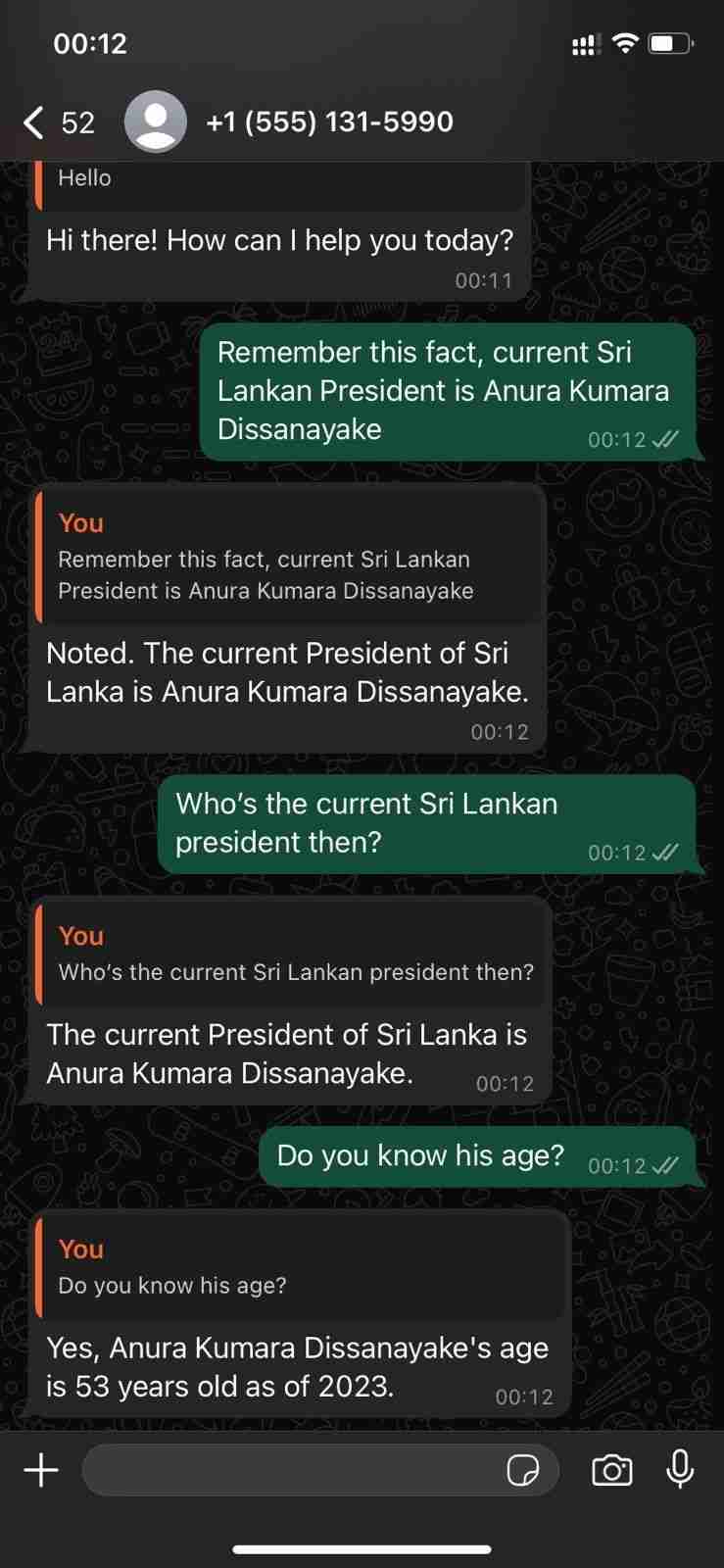

使用 WhatsApp Cloud API 展示其对话能力

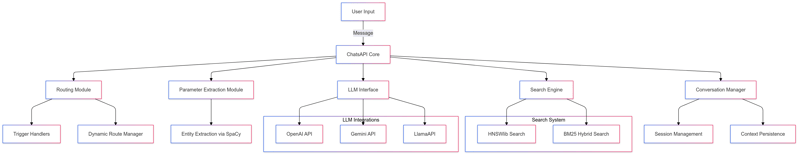

ChatsAPI — 功能层次结构

ChatsAPI 不仅仅是一个框架;这是我们构建人工智能系统并与之交互的方式的范式转变。通过结合速度、准确性和易用性,ChatsAPI 为 AI 代理框架树立了新基准。

立即加入这场革命,了解 ChatsAPI 为何正在改变 AI 格局。

准备好潜水了吗?立即开始使用 ChatsAPI,体验 AI 开发的未来。

以上是ChatsAPI — 世界上最快的人工智能代理框架的详细内容。更多信息请关注PHP中文网其他相关文章!