AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

이 연구는 "Nature Computational Science"에 게재되었습니다. 공동 교신 저자는 중국 아카데미 자동화 연구소의 연구원입니다. 과학 박사이자 북경 대학교의 Tian Yonghong 교수입니다. 공동 저자는 Tsinghua University Qian Xuesen 수업을 듣는 학부생 He Linxuan(자동화 연구소 인턴), 기초 수학과 과학 수업을 듣는 학부생 Xu Yunhui(자동화 연구소 인턴)입니다. , 그리고 칭화 대학교 정밀 기기학과 박사 과정 학생인 He Weihua와 Lin Yihan.

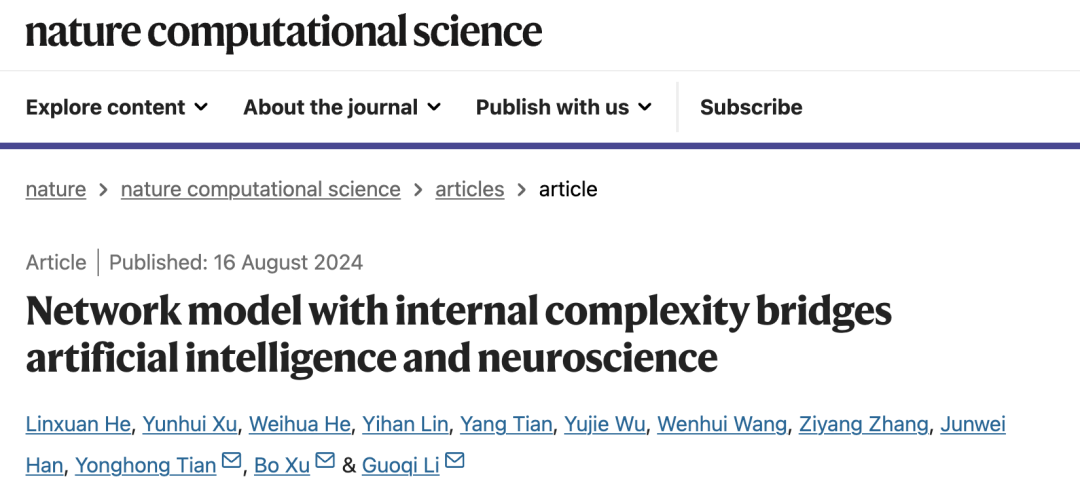

더 광범위하고 일반적인 인지 기능을 갖춘 모델을 활성화하는 것은 현재 인공 지능(AI) 분야의 발전에서 중요한 목표입니다. 현재 널리 사용되는 대형 모델 경로는 모델 성능을 향상시키기 위해 더 크고 깊고 넓은 신경망을 구축하는 스케일링 법칙(Scaling Law)을 기반으로 하며, 이는 "외생적 복잡성에 기반한" 일반 지능 구현 방법이라고 할 수 있습니다. 그러나 이 경로 역시 높은 계산 자원 소모, 에너지 소모 등 극복할 수 없는 어려움에 직면해 있으며 해석 가능성에도 단점이 있습니다.

인공지능과 신경과학은 오랫동안 상호의존적이며 협력적으로 발전해 왔습니다. "외생적 복잡성을 기반으로" 일반 지능을 실현하는 딜레마를 극복하기 위해 중국과학원 자동화 연구소의 Li Guoqi와 Xu Bo 연구팀은 칭화대학교, 북경대학교 등과 함께 다음과 같은 기술을 활용했습니다. 뇌 뉴런의 복잡한 동적 특성을 제안하고 "내생적 복잡성 기반"을 제안합니다. "뇌 유사 뉴런 모델 구축 방법(그림 1)은 기존 모델의 외부 확장으로 인한 컴퓨팅 자원 소비 문제를 개선하고 효과적인 사용의 예를 제공합니다. 인공지능을 개발하는 신경과학. Nature Computational Science 저널은 이에 대해 다음과 같이 논평했습니다. "AI 연구는 공학 및 응용에 더 가까운 반면, 신경과학 연구는 더 탐구적입니다. 연구팀은 이러한 전통적인 견해에 도전하고 보다 상세하고 생물학적으로 현실적인 뉴런 모델이 딥 러닝에서 더 큰 발전을 이룰 수 있음을 보여주었습니다. ”

논문 링크: https://www.nature.com/articles/s43588-024-00674-9

댓글 링크: https:///www.nature.com/articles/ s43588-024-00677-6

~ 내생적 복잡성이란 뇌 뉴런의 복잡한 동적 특성을 내부적으로 활용하여 신경망 원시 모델을 구성하는 것을 의미합니다

내생적 복잡성을 갖는 작은 네트워크 모델: 생물학적 뉴런에서 영감을 얻음

생물학적 뉴런은 다음과 같은 복잡한 내부 구조를 가지고 있습니다. 이온 채널, 시냅스 전달 메커니즘 등 이러한 복잡한 내부 구조를 통해 뉴런은 복잡한 신호를 처리하고 다양한 반응을 생성할 수 있습니다. 대조적으로, 고전적인 LIF(Leaky Integrate and Fire) 네트워크와 같은 현재의 인공 스파이크 신경망 모델은 일반적으로 간단한 내부 구조를 채택하고 생물학적 뉴런의 복잡한 역학 및 기능을 시뮬레이션하기가 어렵습니다.

본 연구에서 연구진은 "내인성 복잡성을 갖는 소규모 네트워크 모델"이라는 개념을 제안했습니다. 핵심 아이디어는 생물학적 뉴런의 복잡한 역학을 시뮬레이션하여 복잡한 내부 구조를 도입하여 보다 효율적인 AI 모델을 구축하는 것입니다. . 예를 들어, 본 연구에서 연구원들은 기존 LIF 모델을 대체하기 위해 스파이킹 신경망에서 HH(Hodgkin-Huxley) 모델을 사용했습니다. HH 모델은 뉴런 활동 전위 생성 메커니즘을 설명하는 수학적 모델로서 복잡한 내부 구조에 의해 발생하는 미세한 역학을 가지며 다양한 자극에 대한 뉴런의 반응을 시뮬레이션할 수 있습니다.

외생적 복잡성에서 내생적 복잡성으로의 전환

이론적 동역학 도출 및 시뮬레이션

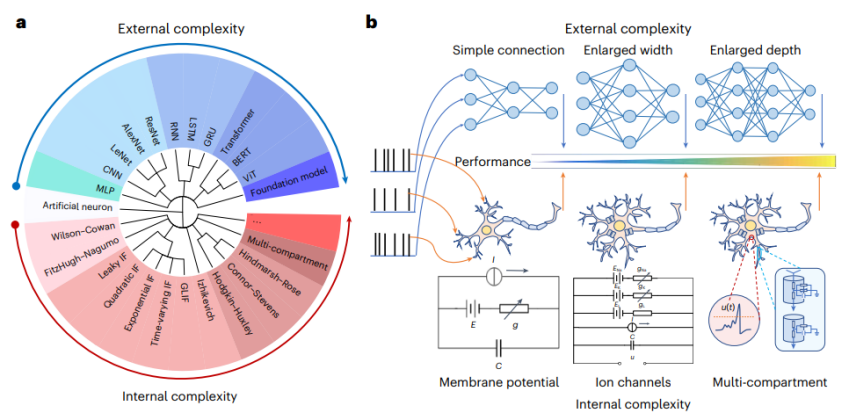

연구팀은 활동 전위 생성 메커니즘에서 HH 모델과 LIF 모델 사이에 일정한 등가 관계가 있음을 이론적으로 입증했습니다. 즉, 하나의 HH 뉴런이 4개의 시변 매개변수 LIF 뉴런과 특정 연결 방식으로 형성될 수 있음을 입증했습니다. (tv-LIF) 미세 구조적 동등성은 각 LIF 뉴런이 HH 모델의 이온 채널을 설명한다는 것입니다. 이러한 등가성을 바탕으로 마이크로 구조를 설계함으로써 컴퓨팅 장치의 내생적 복잡성을 개선할 수 있으므로 HH 네트워크 모델은 대규모 LIF 네트워크 모델의 동적 특성을 시뮬레이션하고 더 작은 네트워크 구조에서 유사한 결과를 얻을 수 있습니다. 기능.

연구팀은 뉴런 자극 입력을 시뮬레이션하고 네트워크 출력을 비교하여 이 이론에 대한 시뮬레이션 검증을 수행했습니다. 동일한 입력 자극 하에서 외생적 복잡성이 더 높은 tv-LIF 네트워크는 HH 모델과 동일한 출력 응답을 생성할 수 있습니다. 또한, 팀은 4개의 tv-LIF 뉴런으로 구성된 "HH 모델"(tv-LIF2HH)을 s-LIF2HH 모델로 단순화했으며, 시뮬레이션 실험을 통해 이 단순화된 모델이 여전히 HH의 동적 동작을 포착할 가능성을 보유하고 있음을 확인했습니다. 모델( 그림 2).复 그림 2. "외생적 복잡성"과 "내생적 복잡성" 뉴런은 동등한 동적 행동을 유지할 수 있습니다.

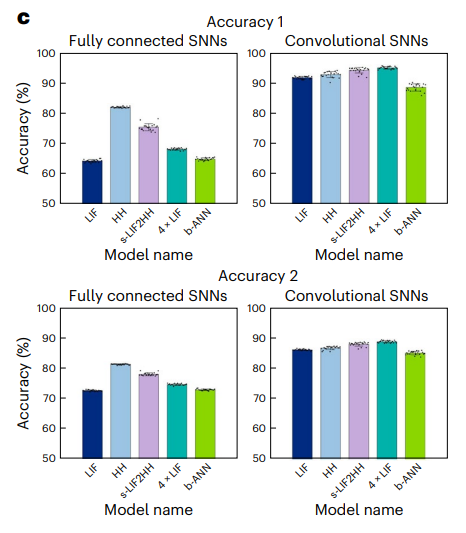

네트워크 학습 실험의 비교

동일한 자극 하에서 다양한 네트워크의 동적 행동을 시뮬레이션을 통해 연구하는 것 외에도, 연구원들은 더 큰 HH 네트워크 모델인 s-LIF2HH 네트워크 모델을 구축하고 다중 작업 분류 및 심층 향상을 수행했습니다. 결과는 내생적 복잡성을 갖는 HH 네트워크 모델이 대규모 s-LIF2HH 네트워크 모델과 표현 능력 및 견고성에서 유사한 성능을 가질 수 있으며 대규모 일반 LIF 네트워크보다 더 나은 성능을 나타냄을 보여줍니다.다중 작업 학습 실험: 연구원은 Fashion-MNIST 데이터 세트를 사용하여 다중 작업 학습 실험을 수행했습니다. 결과는 HH 네트워크 모델이 더 큰 s-LIF2HH 네트워크 모델과 동등한 성능을 달성할 수 있음을 보여주었습니다. 일반 LIF 네트워크의 대규모 s-LIF2HH 네트워크 모델보다 약간 더 좋습니다(그림 3).

시간적 강화 학습 실험: 연구 연구진은 Inverted Pendulum 및 Inverted Double Pendulum 환경에서 순차적 강화 학습 실험을 수행한 결과를 보여줍니다. HH 네트워크 모델은 더 큰 LIF 네트워크 모델보다 더 강력한 시간 정보 추출을 수행할 수 있습니다(그림 4). ㅋㅋㅋ

시간적 강화 학습 실험: 연구 연구진은 Inverted Pendulum 및 Inverted Double Pendulum 환경에서 순차적 강화 학습 실험을 수행한 결과를 보여줍니다. HH 네트워크 모델은 더 큰 LIF 네트워크 모델보다 더 강력한 시간 정보 추출을 수행할 수 있습니다(그림 4). ㅋㅋㅋ

강건성 실험: 연구원들은 네트워크의 견고성을 평가하기 위해 다중 작업 학습 및 심층 강화 학습 작업에 가우스 노이즈를 추가했습니다. 실험 결과, 대규모 일반 LIF 네트워크 모델은 잡음의 영향으로 가장 큰 성능 저하를 겪는 반면, HH 네트워크 모델과 대규모 s-LIF2HH 네트워크 모델은 더 강한 견고성을 나타냅니다. 노이즈 강도가 증가하면 HH 네트워크 모델과 s-LIF2HH 네트워크 모델의 보상 곡선은 가깝게 유지되며 일반 LIF 네트워크 모델보다 영향을 훨씬 덜 받습니다(그림 5).生 그림 5. 내생적 복잡성이 있는 HH 네트워크 모델은 더 큰 외생적 복잡 네트워크보다 낫습니다.

实验证明了内生复杂性模型在处理复杂任务时的有效性和可靠性。同时,研究发现 HH 网络模型在计算资源消耗上更为高效,显着减少了内存和计算时间的使用,从而提高了整体的运算效率。研究团队通过信息瓶颈理论对上述研究结果进行了解释。除此之外,小规模的模型外部结构相对简单,更容易理解其决策过程,这也提高了模型的可解释性和安全性。

结语与展望

具有内生复杂性的小型模型为 AI 的发展带来了新的机遇。通过模拟生物神经元的复杂动力学,优化模型的局部微结构扩展内生复杂性,我们可以构建更高效、更强大的 AI 模型,并克服外部复杂性大型模型的困境。未来,拓展内生复杂性或将成为 AI 研究的重要方向,并推动 AI 技术走向更广泛的应用。

本研究为将神经科学的复杂动力学特性融入人工智能提供了新的方法和理论支持,为实际应用中的 AI 模型优化和性能提升提供了可行的解决方案。目前,研究团队已开展对更大规模HH 网络,以及具备更大内生复杂性的多分枝多房室神经元的研究,有望进一步提升大模型计算效率与任务处理能力,实现在实际应用场景中的快速落地。

以上是Nature子刊 | 基于内生复杂性,自动化所新类脑网络构筑人工智能与神经科科学的桥梁的详细内容。更多信息请关注PHP中文网其他相关文章!