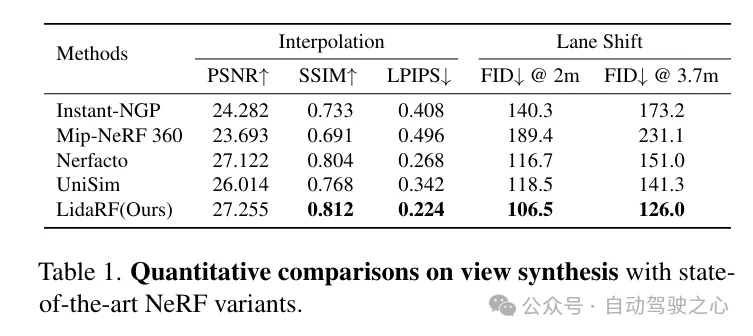

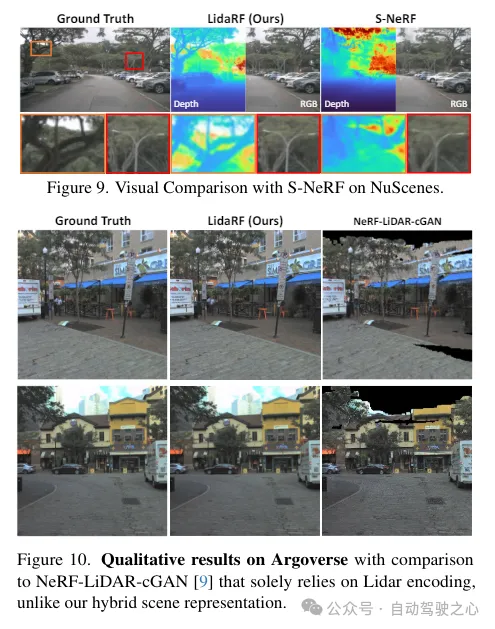

光真實感模擬在自動駕駛等應用中發揮關鍵作用,其中神經網路輻射場(NeRFs)的進步可能透過自動創建數位3D資產來實現更好的可擴展性。然而,由於街道上相機運動的高度共線性和在高速下的稀疏採樣,街景的重建品質受到影響。另一方面,該應用通常需要從偏離輸入視角的相機視角進行渲染,以準確模擬如變換車道等行為。 LidaRF提出了幾個見解,允許更好地利用光達數據來改善街景中NeRF的品質。首先,框架從雷射雷達資料中學習幾何場景表示,這些表示與基於隱式網格的解碼器相結合,從而提供了由顯示點雲提供的更強的幾何資訊。其次,提出了一種穩健的遮蔽感知深度監督訓練策略,允許透過累積使用密集雷射雷達點雲的強勢資訊來改善街景中的NeRF重建品質。第三,根據雷射雷達點的強度產生增強的訓練視角,以進一步改進在真實駕駛場景下的新視角合成中獲得的顯著改進。 這樣,透過框架從雷射雷達數據中學習到的更準確的幾何場景表示,可以一步改進方法並在真實駕駛場景下獲得更好的顯著改進。

LidaRF的貢獻主要體現在三個方面:

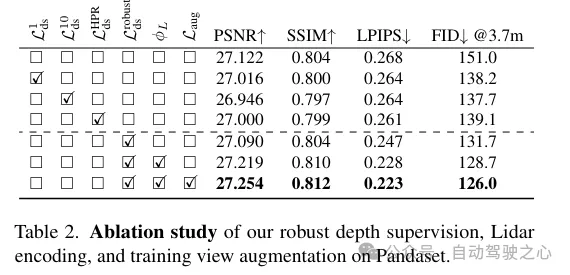

(i)混合雷射雷達編碼和網格特徵以增強場景表示。雖然光達已被用作自然的深度監控來源,但將雷射雷達納入NeRF輸入中,為幾何歸納提供了巨大的潛力,但實現起來並不簡單。為此,借用了基於網格的表示法,但將從點雲中學習的特徵整合到網格中,以繼承顯式點雲表示法的優勢。透過3D感知框架成功的啟動,利用3D稀疏療卷積網路作為有效且高效的結構,從雷射雷達點雲的局部和全局上下文中提取幾何特徵。

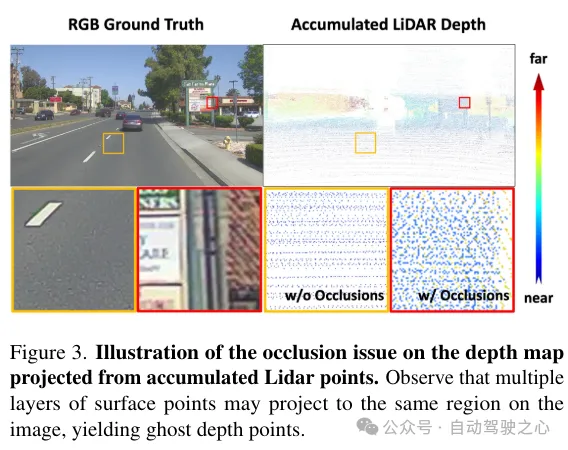

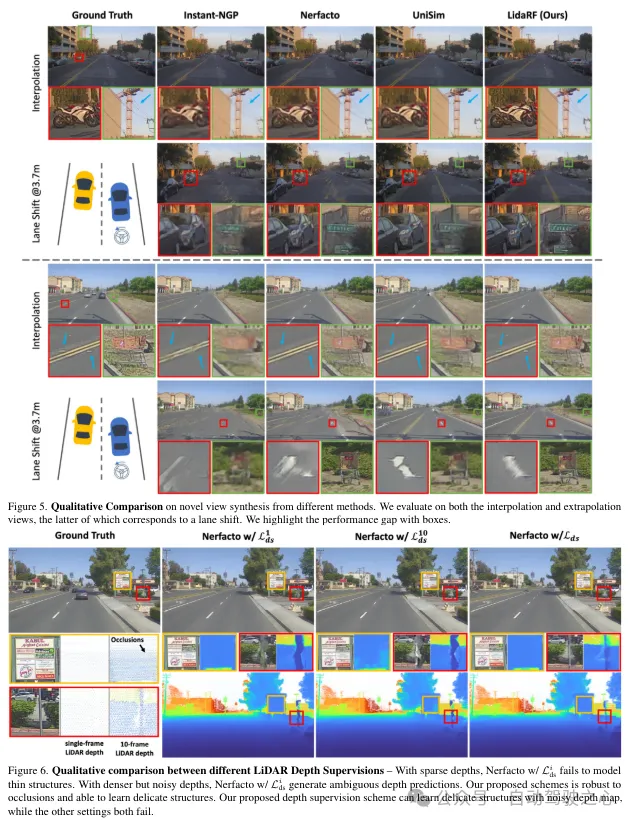

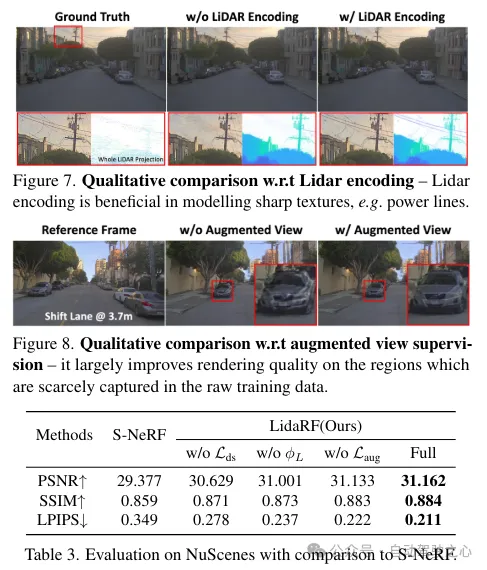

(ii)魯棒的遮蔽感知深度監督。與現有工作類似,這裡也使用光達作為深度監督的來源,但更深入。由於光達點的稀疏性限制了其有效性,尤其是在低紋理區域,透過跨鄰近幀集化光達點來產生更密集的深度圖。然而,這樣獲得的深度圖沒有考慮到遮擋,產生了錯誤的深度監督。因此,提出了一種健壯的深度監督方案,借用class學習的方式-從近場到遠場逐步監督深度,並在NeRF訓練過程中逐漸濾除錯誤的深度,從而更有效地從雷射雷達中學習深度。

(iii)基於光達的視野增強。此外,鑑於駕駛場景中的視圖稀疏性和覆蓋範圍有限,利用光達來密集化訓練視圖。也就是說,將累積的光達點投影到新的訓練視圖中;請注意,這些視圖可能與駕駛軌跡有一定的偏離。這些從雷射雷達投影的視圖被添加到訓練資料集中,它們並沒有考慮到遮蔽問題。然而,我們應用了前面提到的監督方案來解決遮蔽問題,從而提高了效能。雖然我們的方法也適用於一般場景,但在這項工作中更專注於街道場景的評估,並與現有技術相比,無論是定量還是定性,都取得了顯著的改進。

LidaRF在需要更大程度偏離輸入視圖的有趣應用中也顯示出優勢,在具有挑戰性的街道場景應用中顯著提高了NeRF的品質。

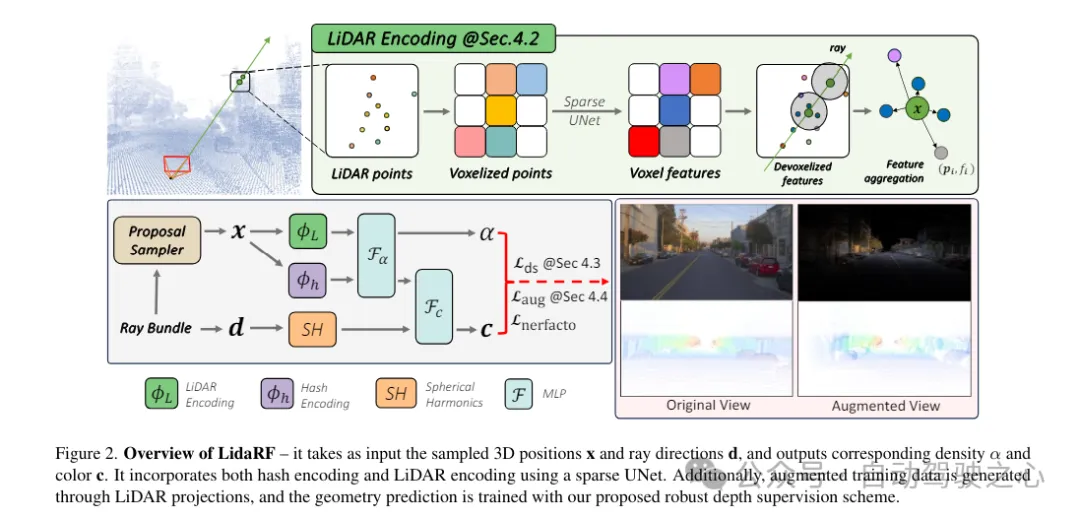

雷射雷達特徵提取。這裡詳細描述了每個雷射雷達點的幾何特徵提取過程,參考圖2,首先將整個序列的所有幀的雷射雷達點雲聚合起來,以建立更密集的點雲集合。然後將點雲體素化為體素網格,其中每個體素單元內的點的空間位置進行平均,為每個體素單元產生一個3維特徵。受到3D感知框架廣泛成功的啟發,在體素網格上使用3D稀疏UNet對場景幾何特徵進行編碼,這允許從場景幾何的全局上下文中學習。 3D稀疏UNet將體素網格及其3維特徵作為輸入,並輸出neural volumetric 特徵,每個被佔用的體素由n維特徵組成。

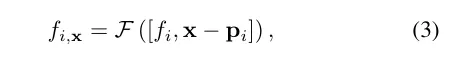

雷射雷達特徵查詢。對於沿著要渲染的射線上的每個樣本點x,如果在搜索半徑R內有至少K個附近的光達點,則查詢其光達特徵;否則,其光達特徵被設定為空(即全零)。具體來說,採用固定半徑最近鄰(FRNN)方法來搜尋與x相關的K個最近的雷射測距儀點索引集,記作。與[9]中在啟動訓練過程之前預先確定射線採樣點的方法不同,本文的方法在執行FRNN搜尋時是即時的,因為隨著NeRF訓練的收斂,來自region網路的樣本點分佈會動態地趨向於集中在表面。遵循Point-NeRF的方法,我們的方法利用一個多層感知機(MLP)F,將每個點的雷射雷達特徵映射到神經場景描述中。對於x的第i個鄰近點,F將光達特徵和相對位置作為輸入,並輸出神經場景描述為:

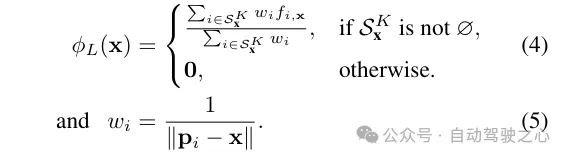

為了獲得取樣位置x處的最終雷射雷達編碼ϕ,使用標準的反距離權重法來聚合其K個鄰近點的神經場景描述

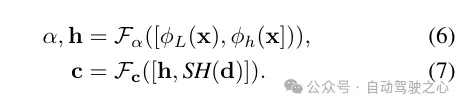

輻射解碼的特徵融合。將雷射雷達編碼ϕL與雜湊編碼ϕh進行拼接,並應用一個多層感知機Fα來預測每個樣本的密度α和密度嵌入h。最後,透過另一個多層感知機Fc,根據觀察方向d的球面諧波編碼SH和密度嵌入h來預測對應的顏色c。

#除了特徵編碼外,還透過將光達點投影到影像平面上來從它們中獲取深度監督。然而,由於雷射雷達點的稀疏性,所得益處有限,不足以重建低紋理區域,如路面。在這裡,我們提出累積相鄰的雷射雷達幀以增加密度。儘管3D點能夠準確地捕捉場景結構,但在將它們投影到影像平面以進行深度監督時,需要考慮點之間的遮蔽。遮蔽是由於相機與雷射雷達及其相鄰幀之間的位移增加而產生的,從而產生虛假的深度監督,如圖3所示。由於即使累積後雷射雷達的稀疏性,處理這個問題也非常困難,使得諸如z緩衝之類的基本原理圖形技術無法應用。在這項工作中,提出了一種穩健的監督方案,以在訓練NeRF時自動過濾掉虛假的深度監督。

遮蔽感知的穩健監督方案。本文設計了一個class訓練策略,使得模型最初使用更近、更可靠的深度資料進行訓練,這些資料更不容易受到遮蔽的影響。隨著訓練的進行,模型逐漸開始融合更遠的深度資料。同時,模型也具備了丟棄與其預測相比異常遙遠的深度監督的能力。

回想一下,由於車載攝影機的向前移動,它產生的訓練影像是稀疏的,視野覆蓋有限,這給NeRF重建帶來了挑戰,尤其是當新視圖偏離車輛軌跡時。在這裡,我們提出利用光達來增強訓練資料。首先,我們透過將每個雷射雷達幀的點雲投影到其同步的攝影機上並為RGB值進行插值來為其上色。累積上色的點雲,並將其投影到一組合成增強的視圖上,產生如圖2所示的合成影像和深度圖。

以上是LidaRF:研究用於街景神經輻射場的光達資料(CVPR\'24)的詳細內容。更多資訊請關注PHP中文網其他相關文章!