生成式大模型已經在人工智慧領域引發了重大變革,儘管人們對實現通用人工智慧(AGI)的希望日益增加,但是訓練和部署大模型所需的算力也愈發龐大。

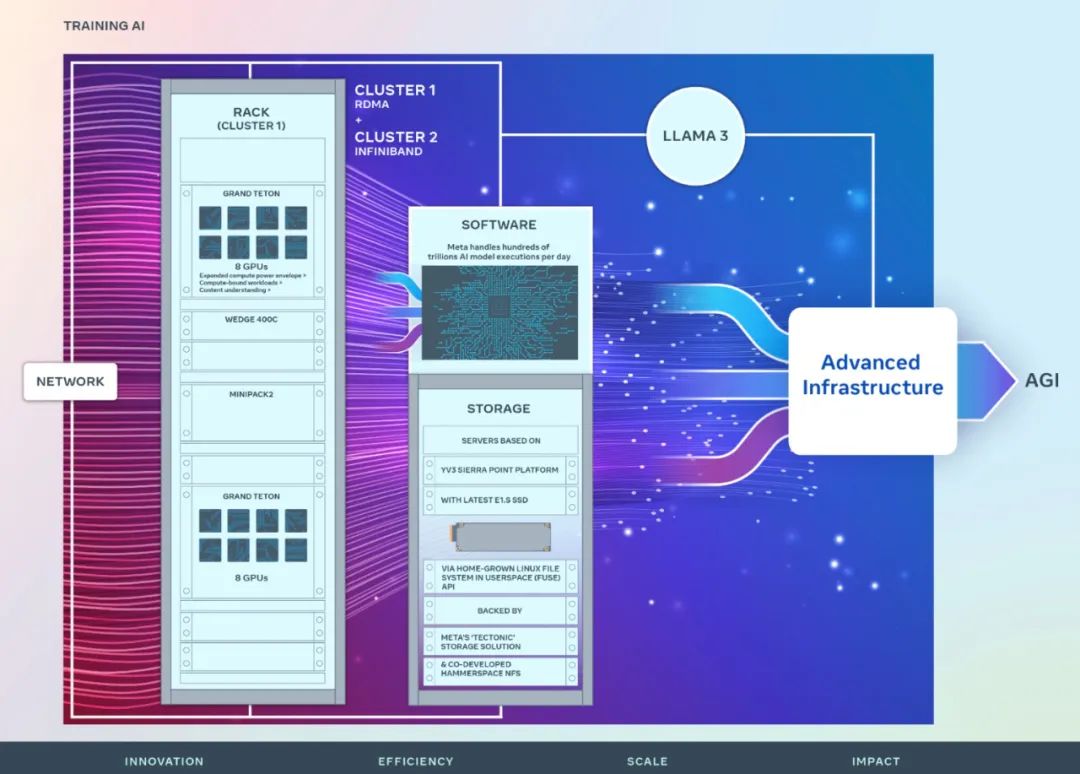

剛剛,Meta 宣布推出兩個 24k GPU 叢集(共 49152 個 H100),標誌著 Meta 為人工智慧的未來做出了一筆重大的投資。

這是 Meta 雄心勃勃的基礎設施規劃中的一部分。到 2024 年底,Meta計劃擴大其基礎設施,將包括 350000 個 NVIDIA H100 GPU,這將使其運算能力相當於近 600000 個H100。 Meta致力於不斷拓展基礎建設,以滿足未來需求。

Meta強調:「我們堅定地支援開放運算和開源技術。我們已經在Grand Teton、OpenRack和PyTorch的基礎上建立了這些運算集群,並將繼續推動整個產業的開放創新。我們將利用這些計算資源集群來訓練Llama 3。」

圖靈獎得主、Meta 首席科學家Yann LeCun 也發推文強調了這一點。

Meta分享了新叢集在硬體、網路、儲存、設計、性能和軟體方面的詳細信息,旨在為各種人工智慧工作負載提供高吞吐量和高可靠性。

Meta 的長期願景是建立開放且負責任的通用人工智慧,以便讓每個人都能廣泛使用並從中受益。

2022 年,Meta 首次分享了一個 AI 研究超級集群 (RSC) 的詳細信息,該集群配備 16000 個 NVIDIA A100 GPU。 RSC 在 Llama 和 Llama 2 的開發以及電腦視覺、NLP、語音識別、圖像生成、編碼等方向的高級人工智慧模型的開發中發揮了重要作用。

Meta 最新推出的人工智慧叢集是在前一階段的成功和教訓基礎上建構的。 Meta 強調致力於打造全方位人工智慧系統,並專注於提升研究人員和開發人員的體驗和工作效率。

兩個新叢集中採用了高效能網路結構,結合關鍵的儲存決策和每個叢集中的24576個NVIDIA Tensor Core H100 GPU,使得這兩個叢集能夠支援比RSC集群更大、更複雜的模型。

網路

#Meta 每天處理數百萬億個人工智慧模型的運作。大規模提供人工智慧模型服務需要高度先進且靈活的基礎設施。

為了優化人工智慧研究人員的端到端體驗,同時確保Meta 的資料中心高效運行,Meta 基於Arista 7800 以及Wedge400 和Minipack2 OCP 機架交換機構建造了一個採用RoCE協定(一種集群網路通訊協議,實現在乙太網路上進行遠端直接記憶體存取(RDMA))的網路結構集群。另一個群集則採用 NVIDIA Quantum2 InfiniBand 結構。這兩種解決方案都互連 400 Gbps 端點。

這兩個新集群可以用來評估不同類型的互連對於大規模訓練的適用性和可擴展性,幫助 Meta 了解未來如何設計和建立更大規模的集群。透過對網路、軟體和模型架構的仔細協同設計,Meta 成功地將 RoCE 和 InfiniBand 叢集用於大型 GenAI 工作負載,而沒有任何網路瓶頸。

計算

這兩個叢集都是使用Grand Teton 建構的,Grand Teton 是Meta 內部設計的開放GPU 硬體平台。

Grand Teton 以多代人工智慧系統為基礎,將電源、控制、運算和結構介面整合到單一機箱中,以實現更好的整體性能、訊號完整性和熱性能。它以簡化的設計提供快速的可擴展性和靈活性,使其能夠快速部署到資料中心佇列中並輕鬆進行維護和擴展。

儲存

。儲存在人工智慧訓練中發揮重要作用,但卻是最少被談論的方面之一。

隨著時間的推移,GenAI 訓練工作變得更加多模態,消耗大量圖像、視訊和文字數據,對資料儲存的需求迅速增長。

Meta 新叢集的儲存部署透過使用者空間中的本機Linux 檔案系統(FUSE) API 來滿足AI 叢集的資料和檢查點需求,該API 由Meta 的「Tectonic」分散式儲存解決方案提供支援。這種解決方案使數千個 GPU 能夠以同步方式保存和載入檢查點,同時還提供資料載入所需的靈活且高吞吐量的 EB 級儲存。

Meta 也與 Hammerspace 合作,共同開發並落地並行網路檔案系統(NFS)部署。 Hammerspace 使工程師能夠使用數千個 GPU 對作業執行互動式偵錯。

效能

Meta 建立大規模人工智慧叢集的原則之一是同時最大限度地提高效能和易用性。這是創建一流人工智慧模型的重要原則。

Meta 在突破人工智慧系統的極限時,測試擴展設計能力的最佳方法就是簡單建立一個系統,然後優化並實際測試(雖然模擬器有幫助,但也只能到此為止)。

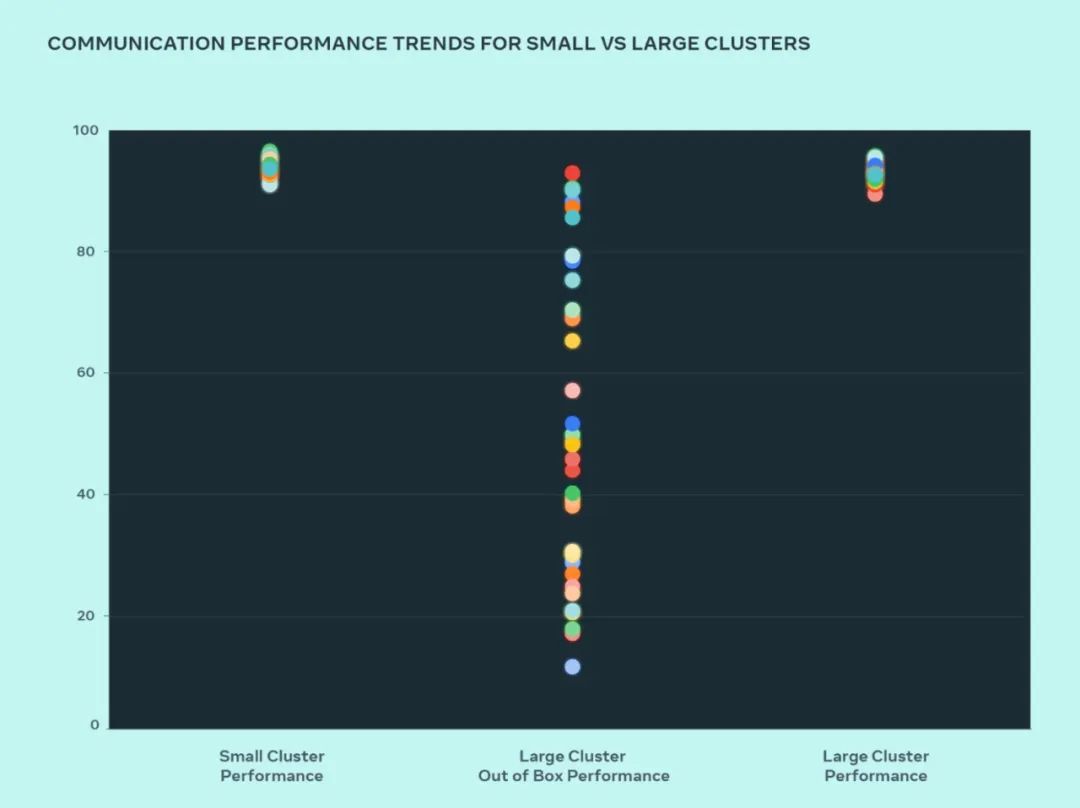

此設計,Meta 比較了小型叢集和大型叢集的效能,以了解瓶頸所在。下方顯示了當大量 GPU 以預期效能最高的通訊大小相互通訊時,AllGather 集體效能(以 0-100 範圍內的標準化頻寬表示)。

與優化的小型叢集效能相比,大型叢集的開箱即用效能最初很差且不一致。為了解決這個問題,Meta 對內部作業調度程序透過網路拓撲感知來調的方式進行了一些更改,這帶來了延遲優勢並最大限度地減少了流向網路上層的流量。

Meta 也結合 NVIDIA Collective Communications Library (NCCL) 變更優化了網路路由策略,以實現最佳的網路利用率。這有助於推動大型叢集像小型叢集一樣實現出色的預期效能。

從圖中我們可以看到,小集群效能(整體通訊頻寬和利用率)開箱即達到90% ,但未經優化的大型叢集效能利用率非常低,從10% 到90 % 不等。在優化整個系統(軟體、網路等)後,我們看到大型叢集效能恢復到理想的 90% 範圍。

除了針對內部基礎設施的軟體變更之外,Meta 還與編寫訓練框架和模型的團隊密切合作,以適應不斷發展的基礎設施。例如,NVIDIA H100 GPU 開啟了利用 8 位元浮點 (FP8) 等新資料類型進行訓練的可能性。充分利用更大的叢集需要對額外的平行化技術和新的儲存解決方案進行投資,這提供了在數千個層級上高度優化檢查點以在數百毫秒內運行的機會。

Meta 也意識到可調試性是大規模訓練的主要挑戰之一。大規模識別出導致整個訓練停滯的出錯 GPU 非常困難。 Meta 正在建立諸如非同步調試或分散式集體飛行記錄器之類的工具,以公開分散式訓練的細節,並幫助以更快、更簡單的方式識別出現的問題。

以上是專為訓練Llama 3,Meta 4.9萬張H100集群細部公佈的詳細內容。更多資訊請關注PHP中文網其他相關文章!