數學問題解決能力一直被視為衡量語言模型智慧程度的重要指標。通常只有規模極大的模型或經過大量數學相關預訓練的模型才能有機會在數學問題上表現出色。 近日,由Swin-Transformer 團隊打造,來自西安交通大學、中國科學技術大學、清華大學和微軟亞洲研究院的學者共同完成的研究工作Xwin 顛覆了這個認知,揭示了通用預訓練下7B(即70 億參數)規模的語言模型(LLaMA-2-7B)在數學問題解決方面已經展現出較強的潛力,並可使用基於合成數據的監督微調方法促使模型愈發穩定地將數學能力激發出來。 這項研究發佈在 arXiv 上,題為《Common 7B Language Models Already Possess Strong Math Capabilities》。

- 論文連結:https://arxiv.org/pdf/2403.04706.pdf

- 程式碼連結:https://github.com/Xwin-LM/Xwin-LM

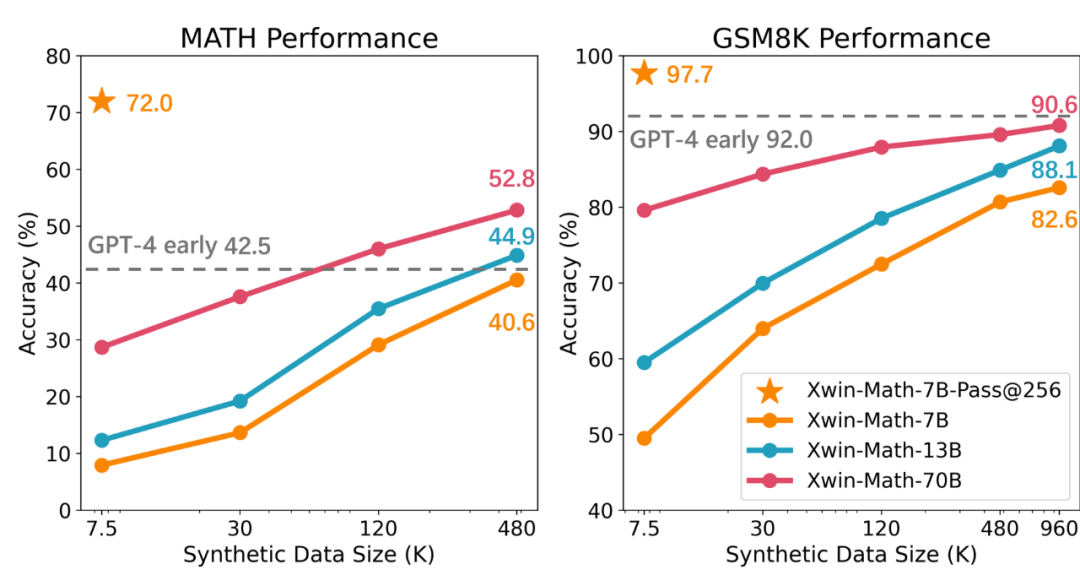

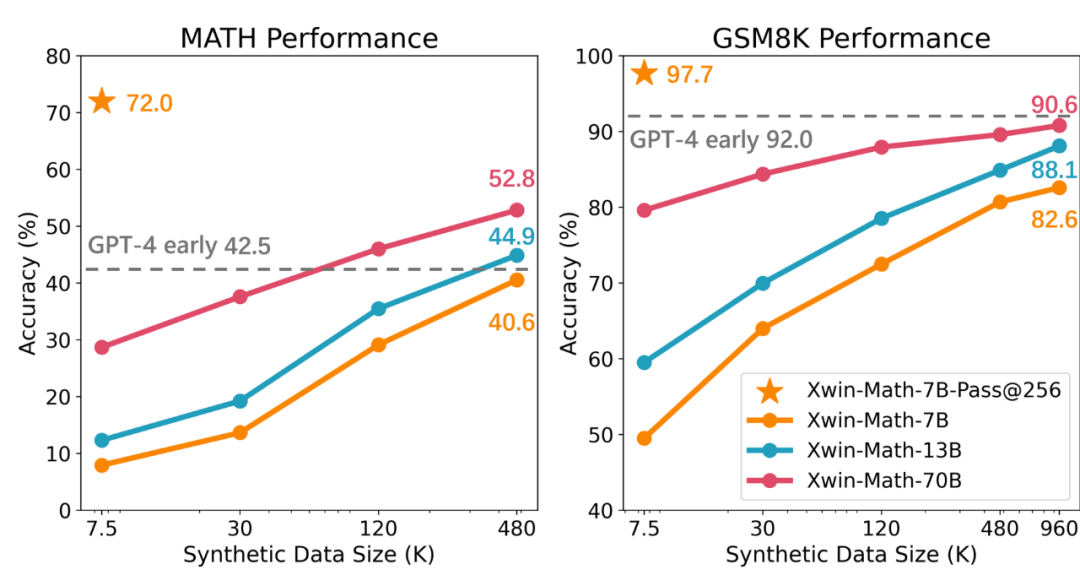

#研究團隊首先只使用7.5K 數據,對LLaMA- 2-7B 模型指令微調,進而評估模型在GSM8K 和MATH 的表現。實驗結果表明,當每個測試集中的問題從256 個產生的答案中選擇最佳答案時,測試準確率可分別高達97.7% 和72.0%,這一結果說明即使是通用預訓練下7B 量級的小模型,也具備產生優質答案的巨大潛力,這項發現挑戰了以往的觀點,即強大的數學推理潛力並非僅限於大規模和數學相關預訓練模型。

然而研究也指出,尽管已具备强大的数学推理潜力,但当前语言模型的主要问题是难以一致地激发其内在的数学能力。例如,在前面的实验中如果只考虑每个问题的一次生成的答案,那么在 GSM8K 和 MATH 基准测试上的准确率会分别降至 49.5% 和 7.9%。这体现出模型数学能力的不稳定性问题。为了解决这一问题,研究团队采用了扩大有监督微调(SFT)数据集的方法,并发现随着 SFT 数据的增多,模型生成正确答案的可靠性被显著提升。研究中还提到,通过使用合成数据,可以有效地扩大 SFT 数据集,而且这种方法几乎与真实数据一样有效。研究团队利用 GPT-4 Turbo API 生成了合成的数学问题与解题过程,并通过简单的验证提示词来确保问题的质量。通过这种方法,团队成功地将 SFT 数据集从 7.5K 扩展到约一百万样本,实现了近乎完美的缩放定律(Scaling Law)。最终获得的 Xwin-Math-7B 模型在 GSM8K 和 MATH 上分别达到了 82.6% 和 40.6% 的准确率,大幅超越此前的 SOTA 模型,甚至可超越一些 70B 量级模型,实现越级提升。而 Xwin-Math-70B 模型在 MATH 评测集上的结果可达 52.8%,显著超越了 GPT-4 的早期版本。这是基于 LLaMA 系列基础模型的研究第一次在 MATH 上超越 GPT-4。

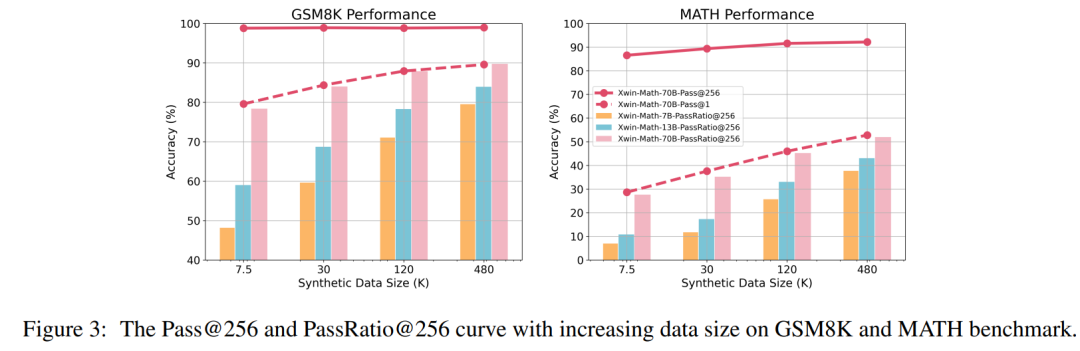

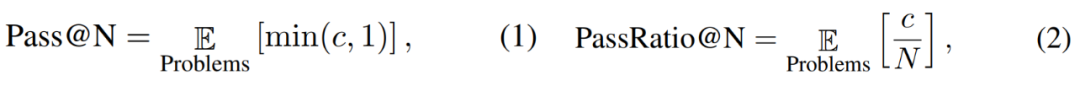

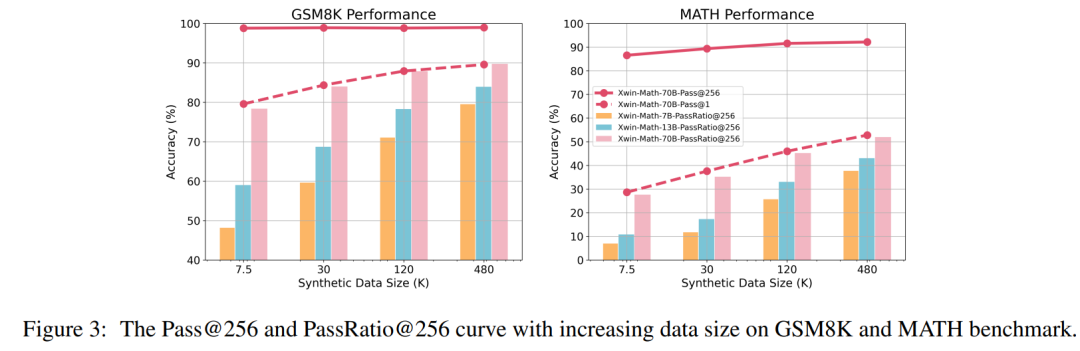

研究人员还定义了 Pass@N 和 PassRatio@N 评测指标,意图分别测评模型的 N 次输出中,是否能够输出正确答案(表示模型潜在的数学能力),以及正确答案的所占比例(表示模型数学能力的稳定性)。当 SFT 数据量较小时,模型的 Pass@256 已经很高,进一步扩大 SFT 数据规模后,模型的 Pass@256 提升极小,而 PassRatio@256 则获得显著增长。这表明基于合成数据的有监督微调是提升模型数学能力稳定性的有效方式。

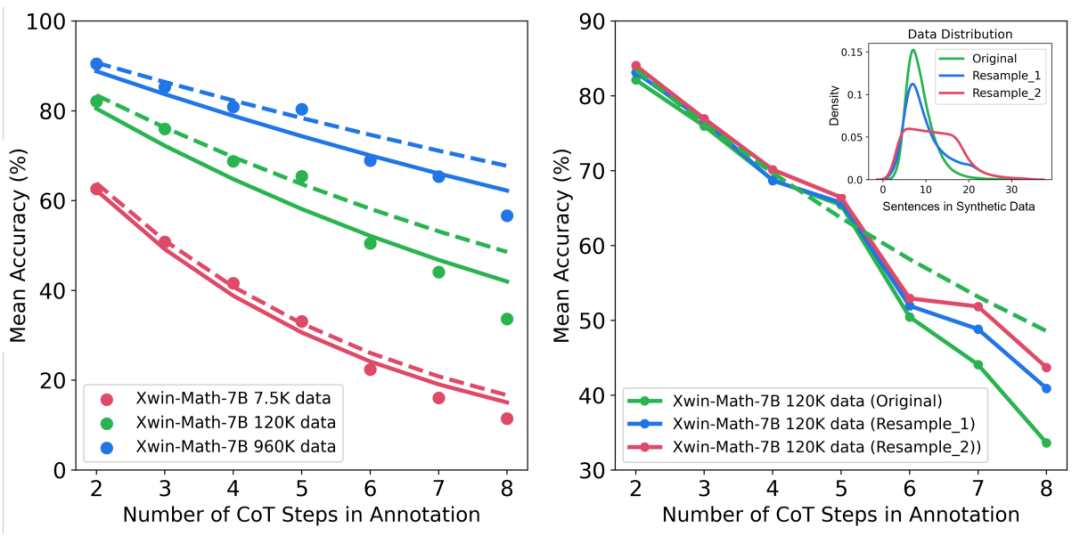

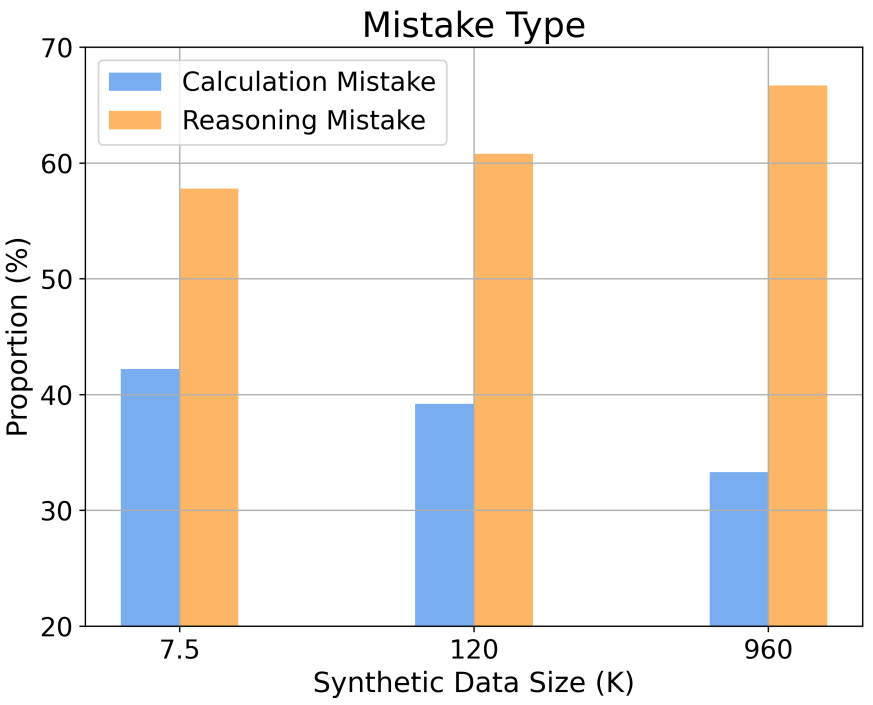

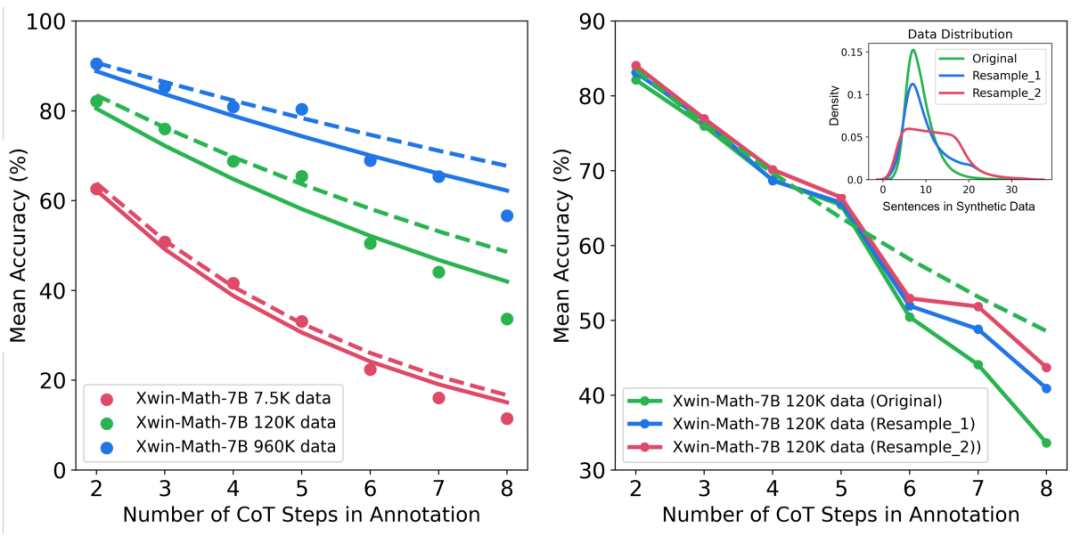

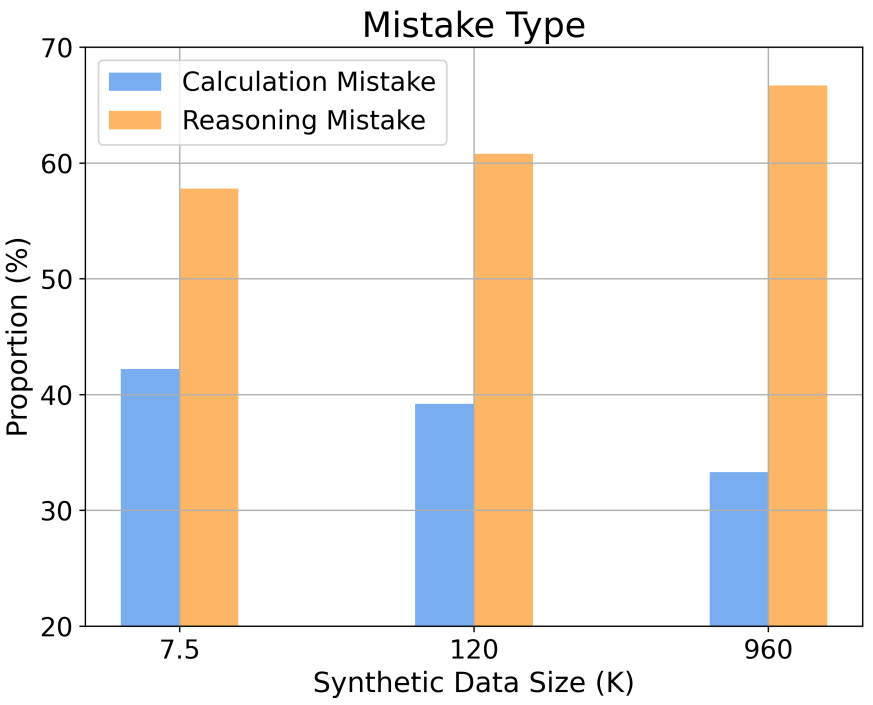

此外,研究还提供了对不同推理复杂性和错误类型下扩展行为的洞察。例如,随着 SFT 数据集规模的增加,模型在解决数学问题时的准确率遵循与推理步骤数量相关的幂律关系。通过增加训练样本中长推理步骤的比例,可以显著提高模型解决难题的准确率。同时,研究还发现,计算错误比推理错误更容易被缓解。

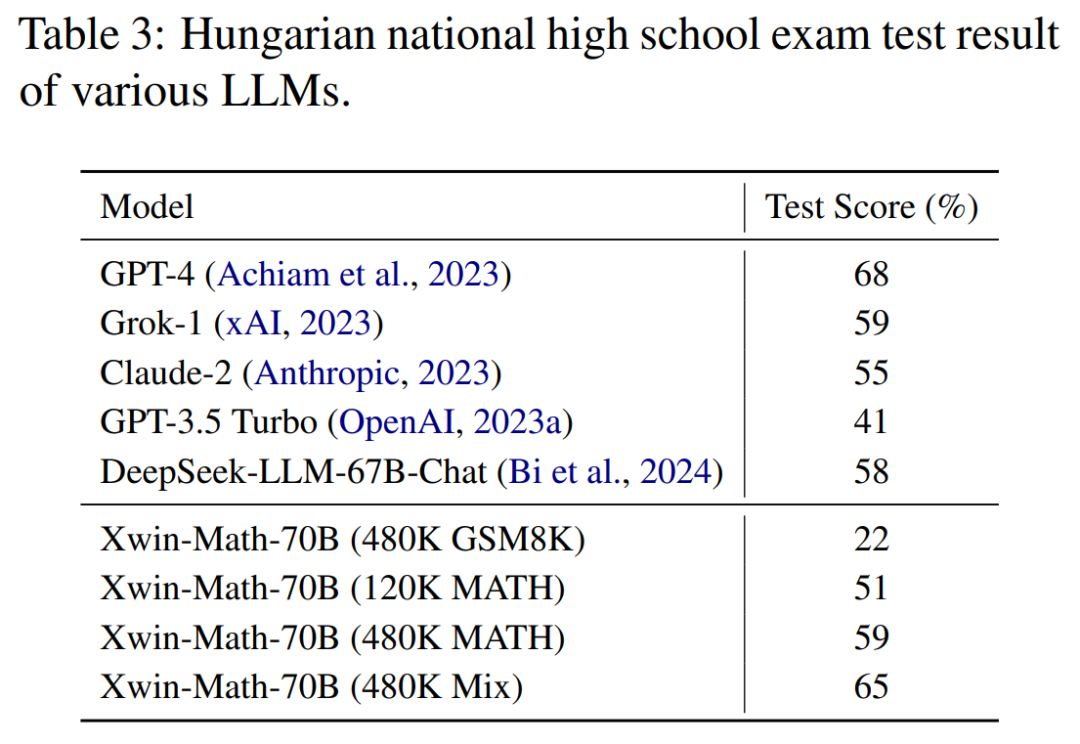

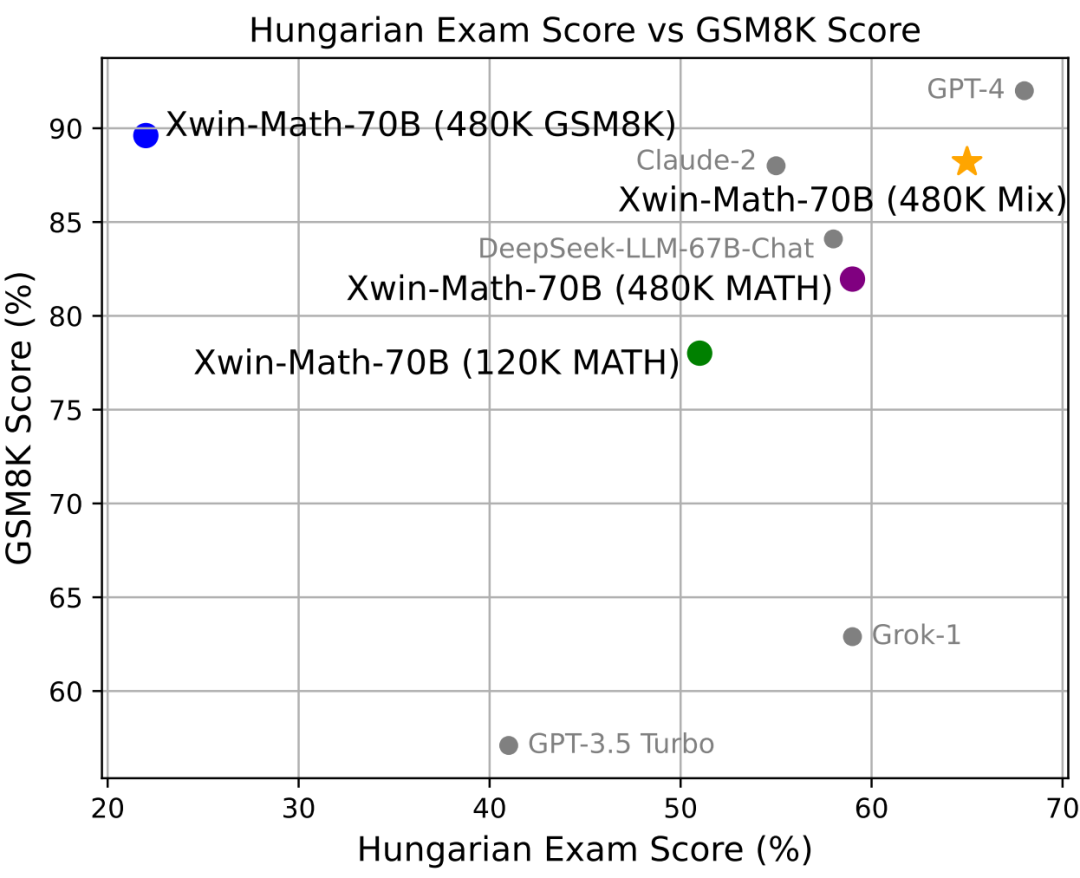

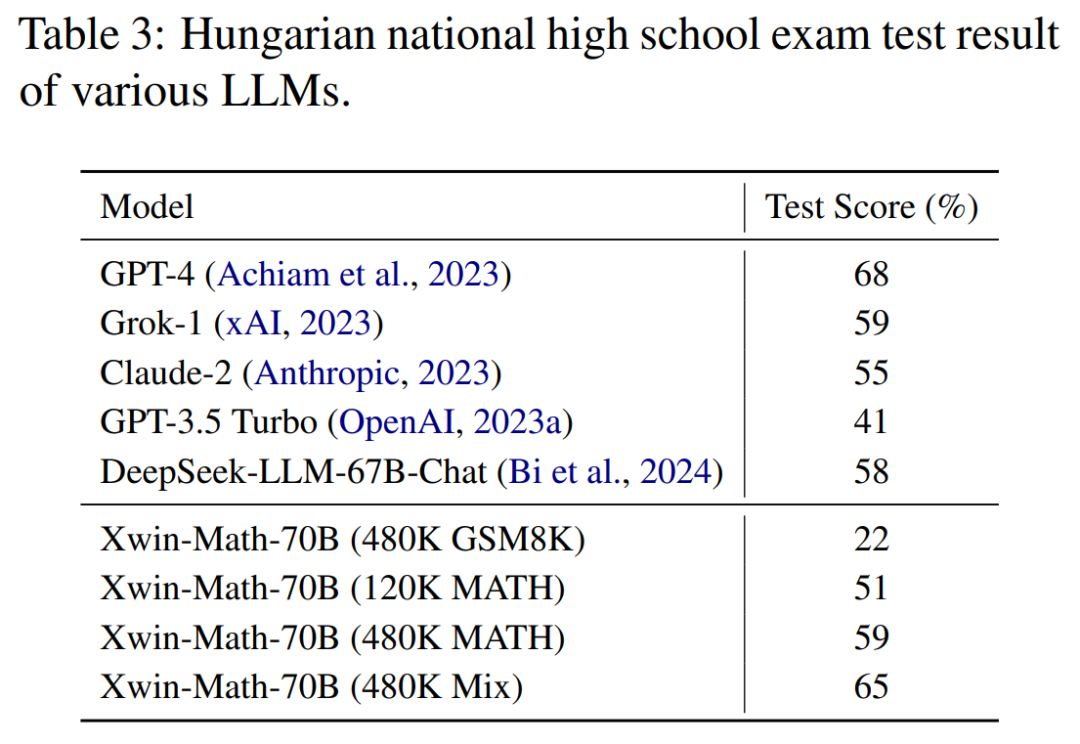

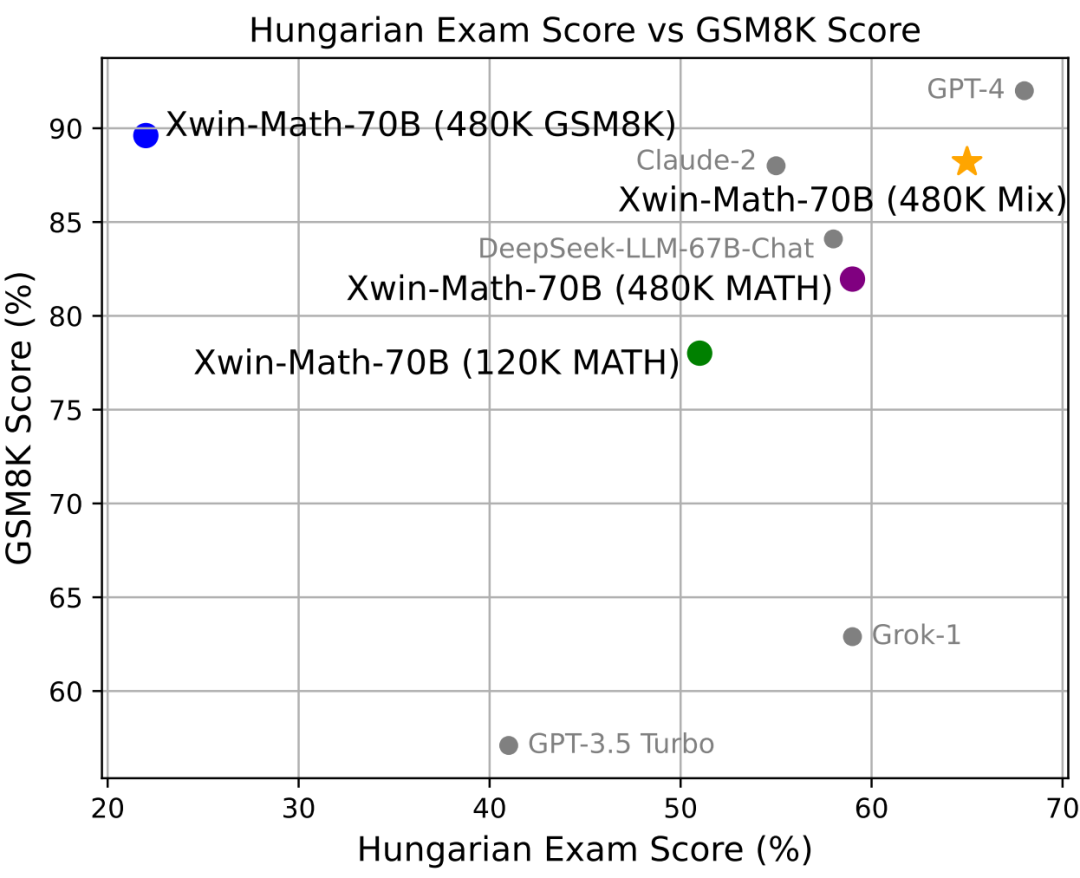

在表现模型数学推理泛化能力的匈牙利高中数学考试中,Xwin-Math 也拿到了 65% 的分数,仅次于 GPT-4。这表明研究中合成数据的方式并没有显著地过拟合到评测集中,展现出良好的泛化能力。

这项研究不仅展示了合成数据在扩展 SFT 数据方面的有效性,而且为大型语言模型在数学推理能力方面的研究提供了新的视角。研究团队表示,他们的工作为未来在这一领域的探索和进步奠定了基础,并期待能够推动人工智能在数学问题解决方面取得更大的突破。随着人工智能技术的不断进步,我们有理由期待 AI 在数学领域的表现将更加出色,为人类解决复杂数学问题提供更多帮助。文章还涉及数据合成方法的消融实验和其他评测指标的结果,详细内容请参阅全文。以上是LLaMA-2-7B數學能力上限已達97.7%? Xwin-Math利用合成資料解鎖潛力的詳細內容。更多資訊請關注PHP中文網其他相關文章!