在影片產生場景中,用 Transformer 做擴散模型的去噪骨幹已經被李飛飛等研究者證明行得通。這可算得上是 Transformer 在影片產生領域的重大成功。

近日,一項影片生成研究收穫了大量讚譽,甚至被一位 X 網友評價為「好萊塢的終結」。

很明顯,這些影片不僅幾乎看不到偽影,而且還非常連貫、細節滿滿,甚至似乎就算真的在電影大片中加上幾幀,也不會明顯違和。 這些影片的作者是來自史丹佛大學、Google、喬治亞理工學院的研究者提出的Window Attention Latent Transformer,即視窗注意力隱Transformer,簡稱 W.A.L.T。此方法成功地將 Transformer 架構整合到了隱視訊擴散模型中。史丹佛大學的李飛飛教授也是這篇論文的作者之一。

- 專案網站:https://walt-video-diffusion.github.io/

- 論文網址:https://walt-video-diffusion.github.io/assets/W.A.L.T.pdf

##

#在此之前,Transformer 架構已經在許多不同領域取得了巨大成功,但影像和視訊生成式建模領域卻是個例外,目前該領域的主導範式是擴散模型。

在影像、影片生成領域,擴散模型已成為主要範式。但是,在所有視訊擴散方法中,主導的骨幹網路是由一系列卷積和自註意力層構成的 U-Net 架構。人們之所以偏好 U-Net,是因為 Transformer 中全注意力機制的記憶體需求會隨輸入序列長度而二次方成長。在處理視訊這樣的高維度訊號時,這樣的成長模式會讓計算成本變得非常高。

而隱擴散模型(LDM)可在源自自動編碼器的更低維隱空間中運行,從而降低計算需求。在這種情況下,一大關鍵的設計選擇是隱空間的類型:空間壓縮與時空壓縮。

人們往往更喜歡空間壓縮,因為這樣就能使用預訓練的圖像自動編碼器和LDM,而它們使用了大量配對的圖像- 文字資料集進行訓練。但是,如果選擇空間壓縮,則會提升網路複雜度並會讓 Transformer 難以用作網路骨幹(由於記憶體限制),尤其是在產生高解析度視訊時。另一方面,雖然時空壓縮可以緩解這些問題,但它不適合使用配對的圖像 - 文字資料集,而這些資料集往往比影片 - 文字資料集更大更多樣化。

W.A.L.T 是一種用於隱視訊擴散模型(LVDM)的 Transformer 方法。 此方法由兩個階段所構成。

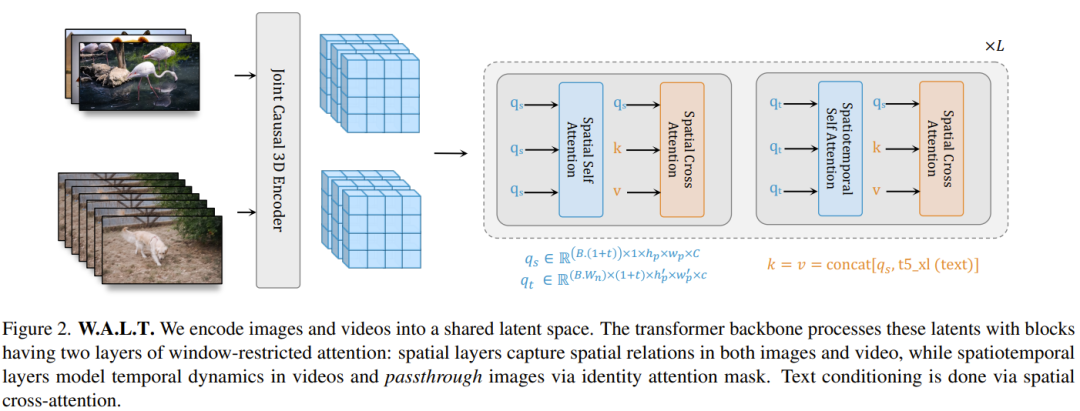

第一階段,用一個自動編碼器將視訊和影像對應到一個統一的低維隱空間。這樣一來,就可以在圖像和視訊資料集上聯合訓練單一生成模型,並顯著降低生成高解析度視訊的計算成本。

對於第二階段,團隊設計了一種用於隱視訊擴散模型的新Transformer 區塊,其由自註意力層構成,這些自註意力層在非重疊、視窗限制的空間和時空注意力之間交替。這項設計的好處主要有兩個:首先,它使用了局部視窗注意力,這能顯著降低計算需求。其次,它有助於聯合訓練,其中空間層可以獨立地處理影像和視訊幀,而時空層則用於建模視訊中的時間關係。

儘管概念上很簡單,但這項研究首次在公共基準上透過實驗證明Transformer 在隱視訊擴散中具有卓越的生成品質和參數效率。 最後,為了展示新方法的可擴展性和效率,該團隊還實驗了高難度的照片級圖像到影片生成任務。他們訓練了三個級聯在一起的模型。其中包括一個基礎隱視頻擴散模型和兩個視頻超分辨率擴散模型。最終能以每秒 8 幀的速度產生解析度為 512×896 的影片。在 UCF-101 基準上,此方法取得了目前最佳的零樣本 FVD 分數。

此外,這個模型還可以用來產生具有一致的 3D 攝影機運動的影片。

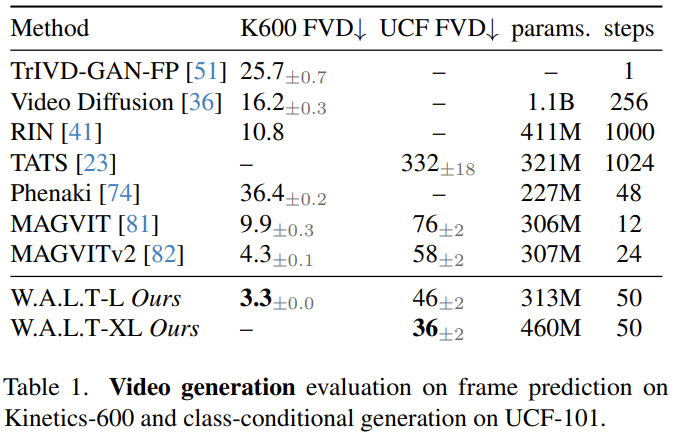

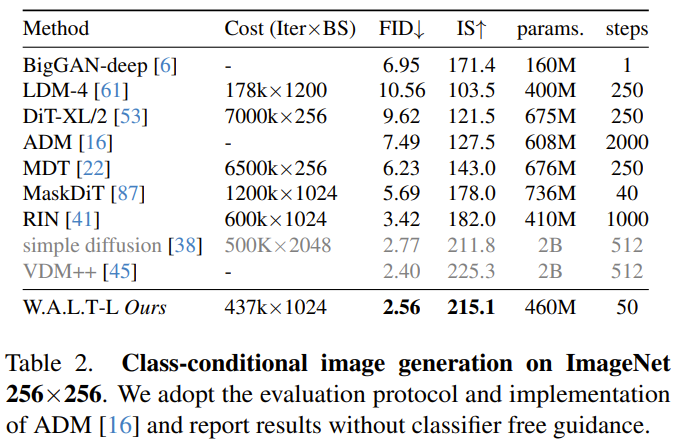

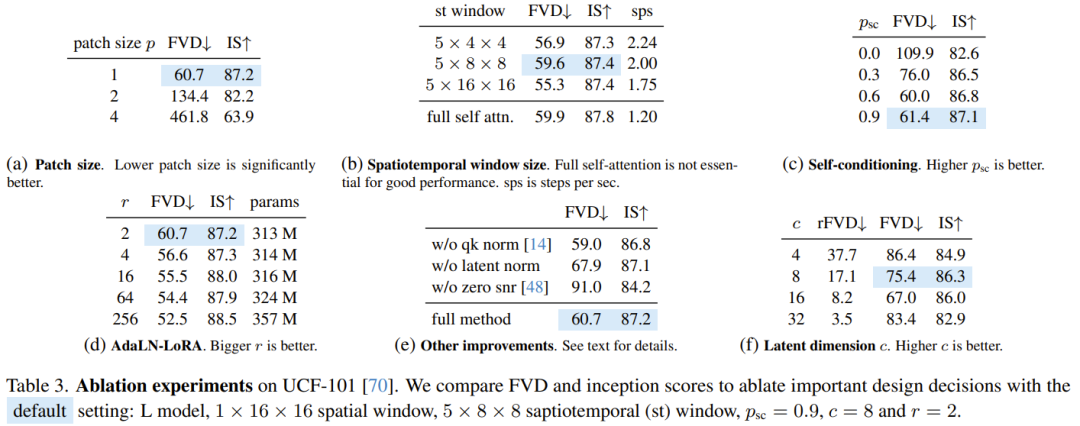

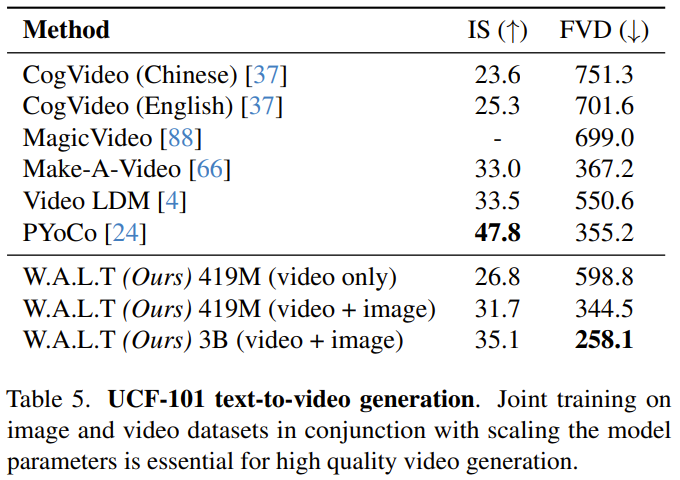

##在影片的生成式建模領域,一個關鍵的設計決策是隱空間表徵的選擇。理想情況下,我們希望得到一種共享和統一的壓縮視覺表徵,並且可同時用於影像和視訊的生成式建模。 具體來說,給定一個視訊序列 x,目標是學習一個低維度表徵 z,其以一定的時間和空間比例執行了時空壓縮。為了得到視訊和靜態影像的統一表徵,總是需要將影片的第一幀與其餘幀分開編碼。這樣一來,就可以將靜態影像當作只有一格的影片來處理。 基於這種思路,該團隊的實際設計使用了 MAGVIT-v2 token 化器的因果 3D CNN 編碼器 - 解碼器架構。 這一階段之後,模型的輸入就成了一批隱張量,它們表示單一影片或堆疊的分立影像(圖 2)。而這裡的隱表徵是實值的且無量化的。 #Patchify(圖塊化)。依照原始 ViT 的設計,團隊將每個隱含影格分別進行圖塊化,做法是將其轉換成不重疊圖塊的序列。他們也使用了可學習的位置嵌入,即空間和時間位置嵌入的和。位置嵌入會被加入到圖塊的線性投影。注意,對於影像而言,只需簡單地添加對應第一隱含影格的時間位置嵌入。 視窗注意力。完全由全域自註意力模組組成的 Transformer 模型的計算和記憶體成本很高,尤其是對於視訊任務。為了效率以及聯合處理圖像和視頻,該團隊是以窗口方式計算自註意力,這基於兩種類型的非重疊配置:空間(S)和時空(ST),參見圖 2。 空間視窗(SW)注意力關注的是一個隱含影格內的所有 token。 SW 建模的是影像和影片中的空間關係。時空窗口(STW)注意力的範圍是一個 3D 窗口,建模的是視訊隱含影格之間的時間關係。最後,除了絕對位置嵌入,他們還使用了相對位置嵌入。 據介紹,這個設計雖然簡單,但卻有很高的運算效率,並且能在影像和影片資料集上聯合訓練。不同於基於幀級自動編碼器的方法,新方法不會產生閃動的偽影,而這是分開編碼和解碼視訊幀方法的常見問題。 為了實現可控的視訊生成,除了以時間步驟t 為條件,擴散模型也傾向於使用額外的條件資訊c,例如類別標籤、自然語言、過去幀或低解析度視訊。在新提出的 Transformer 骨幹網路中,團隊整合了三種類型的條件機制,如下所述:交叉注意力。除了在視窗 Transformer 區塊中使用自註意力層,他們還為文字條件式生成添加了交叉注意力層。當只用影片訓練模型時,交叉注意力層使用相同視窗限制的注意力作為自註意力層,這意味著 S/ST 將具有 SW/STW 交叉注意力層(圖 2)。然而,對於聯合訓練,則只使用 SW 交叉注意力層。對於交叉注意力,該團隊的做法是將輸入訊號(查詢)和條件訊號 (key, value) 連接起來。 AdaLN-LoRA。在許多生成式和視覺合成模型中,自適應歸一化層都是重要組件。為了整合自適應歸一化層,簡單方法是為每一層 i 包含一個 MLP 層,以對條件參數的向量進行迴歸處理。這些附加 MLP 層的參數數量會隨層的數量而線性增長,並會隨模型維度的變化二次增長。受 LoRA 啟發,研究者提出了一種減少模型參數的簡單方案:AdaLN-LoRA。 以自我為條件(Self-conditioning)。除了以外部輸入為條件,迭代式產生演算法還能以自己在推理期間產生的樣本為條件。具體來說,Chen et al. 在論文《Analog bits: Generating discrete data using diffusion models with self-conditioning》中修改了擴散模型的訓練過程,使得模型有一定機率p_sc 產生一個樣本,然後再基於這個初始樣本,使用另一次前向通過來優化這個估計。另一定機率 1-p_sc 僅完成一次前向通過。團隊沿著通道維度將模型估計與輸入連接到一起,然後發現這種簡單技術與 v-prediction 結合起來效果很好。 #為了透過自回歸預測生成長視頻,該團隊在幀預測任務上也對模型進行了聯合訓練。其實現方式是在訓練過程中讓模型有一定機率 p_fp 以過去幀為條件。條件要麼是 1 個隱含影格(影像到影片產生),要麼是 2 個隱含影格(影片預測)。這種條件是透過沿著有雜訊隱含輸入的通道維度整合進模型中。推理過程中使用的是標準的無分類器引導,並以 c_fp 作為條件訊號。 #使用單一模型產生高解析度影片的計算成本非常高,基本上難以實現。而研究者則參考論文《Cascaded diffusion models for high fidelity image generation》使用一種級聯式方法將三個模型級聯起來,它們操作的分辨率越來越高。 其中基礎模型以 128×128 的分辨率生成視頻,然後再經過兩個超分辨率階段被上採樣兩次。首先使用一種深度到空間卷積運算在空間上對低解析度輸入(視訊或影像)進行上取樣。請注意,不同於訓練(提供了基本真值低解析度輸入),推理依賴的是先前階段產生的隱含表徵。 為了減少這種差異並能在超解析度階段更穩健地處理在低解析度階段產生的偽影,團隊也使用了雜訊條件式增強。 縱橫比微調。為了簡化訓練和利用具有不同縱橫比的更多資料來源,他們在基礎階段使用的是方形縱橫比。然後他們又在一個資料子集上對模型進行了微調,透過位置嵌入插值來產生縱橫比為 9:16 的影片。 #研究者在多種任務上評估了新提出的方法:以類別為條件的圖像和視訊生成、幀預測、基於文字的視訊生成。他們也透過消融研究探索了不同設計選擇的效果。 #影片產生:在UCF-101 和Kinetics-600 兩個資料集上,W.A.L.T 在FVD 指標上優於先前的所有方法,請參閱表1。 影像生成:表 2 比較了 W.A.L.T 與其它目前最佳方法產生 256×256 解析度影像的結果。新提出的模型的表現優於先前的方法,並且不需要專門的調度、卷積歸納偏差、改進的擴散損失和無分類器指導。雖然 VDM 的 FID 分數略高一些,但它的模型參數卻多很多(2B)。 #為了理解不同設計決策的貢獻,團隊也進行了消融研究。表 3 給出了在圖塊大小、視窗注意力、自我條件、AdaLN-LoRA 和自動編碼器方面的消融研究結果。 #該團隊在文字- 圖像和文字- 視頻對上聯合訓練了W.A.L.T 的文本到視頻生成能力。他們使用了一個來自公共互聯網和內部資源的資料集,其中包含約 970M 對文字 - 圖像和約 89M 對文字 - 影片。 基礎模型(3B)的解析度為17×128×128,兩個級聯的超解析度模型則分別為17×128×224 → 17× 256×448 (L, 1.3B, p = 2) 和17× 256×448→ 17×512×896 (L, 419M, p = 2)。他們也在基礎階段對縱橫比進行了微調,以便以 128×224 的分辨率生成影片。所有的文本到視頻生成結果都使用了無分類器引導方法。文字:A squirrel eating a burger.

##在影片的生成式建模領域,一個關鍵的設計決策是隱空間表徵的選擇。理想情況下,我們希望得到一種共享和統一的壓縮視覺表徵,並且可同時用於影像和視訊的生成式建模。 具體來說,給定一個視訊序列 x,目標是學習一個低維度表徵 z,其以一定的時間和空間比例執行了時空壓縮。為了得到視訊和靜態影像的統一表徵,總是需要將影片的第一幀與其餘幀分開編碼。這樣一來,就可以將靜態影像當作只有一格的影片來處理。 基於這種思路,該團隊的實際設計使用了 MAGVIT-v2 token 化器的因果 3D CNN 編碼器 - 解碼器架構。 這一階段之後,模型的輸入就成了一批隱張量,它們表示單一影片或堆疊的分立影像(圖 2)。而這裡的隱表徵是實值的且無量化的。 #Patchify(圖塊化)。依照原始 ViT 的設計,團隊將每個隱含影格分別進行圖塊化,做法是將其轉換成不重疊圖塊的序列。他們也使用了可學習的位置嵌入,即空間和時間位置嵌入的和。位置嵌入會被加入到圖塊的線性投影。注意,對於影像而言,只需簡單地添加對應第一隱含影格的時間位置嵌入。 視窗注意力。完全由全域自註意力模組組成的 Transformer 模型的計算和記憶體成本很高,尤其是對於視訊任務。為了效率以及聯合處理圖像和視頻,該團隊是以窗口方式計算自註意力,這基於兩種類型的非重疊配置:空間(S)和時空(ST),參見圖 2。 空間視窗(SW)注意力關注的是一個隱含影格內的所有 token。 SW 建模的是影像和影片中的空間關係。時空窗口(STW)注意力的範圍是一個 3D 窗口,建模的是視訊隱含影格之間的時間關係。最後,除了絕對位置嵌入,他們還使用了相對位置嵌入。 據介紹,這個設計雖然簡單,但卻有很高的運算效率,並且能在影像和影片資料集上聯合訓練。不同於基於幀級自動編碼器的方法,新方法不會產生閃動的偽影,而這是分開編碼和解碼視訊幀方法的常見問題。 為了實現可控的視訊生成,除了以時間步驟t 為條件,擴散模型也傾向於使用額外的條件資訊c,例如類別標籤、自然語言、過去幀或低解析度視訊。在新提出的 Transformer 骨幹網路中,團隊整合了三種類型的條件機制,如下所述:交叉注意力。除了在視窗 Transformer 區塊中使用自註意力層,他們還為文字條件式生成添加了交叉注意力層。當只用影片訓練模型時,交叉注意力層使用相同視窗限制的注意力作為自註意力層,這意味著 S/ST 將具有 SW/STW 交叉注意力層(圖 2)。然而,對於聯合訓練,則只使用 SW 交叉注意力層。對於交叉注意力,該團隊的做法是將輸入訊號(查詢)和條件訊號 (key, value) 連接起來。 AdaLN-LoRA。在許多生成式和視覺合成模型中,自適應歸一化層都是重要組件。為了整合自適應歸一化層,簡單方法是為每一層 i 包含一個 MLP 層,以對條件參數的向量進行迴歸處理。這些附加 MLP 層的參數數量會隨層的數量而線性增長,並會隨模型維度的變化二次增長。受 LoRA 啟發,研究者提出了一種減少模型參數的簡單方案:AdaLN-LoRA。 以自我為條件(Self-conditioning)。除了以外部輸入為條件,迭代式產生演算法還能以自己在推理期間產生的樣本為條件。具體來說,Chen et al. 在論文《Analog bits: Generating discrete data using diffusion models with self-conditioning》中修改了擴散模型的訓練過程,使得模型有一定機率p_sc 產生一個樣本,然後再基於這個初始樣本,使用另一次前向通過來優化這個估計。另一定機率 1-p_sc 僅完成一次前向通過。團隊沿著通道維度將模型估計與輸入連接到一起,然後發現這種簡單技術與 v-prediction 結合起來效果很好。 #為了透過自回歸預測生成長視頻,該團隊在幀預測任務上也對模型進行了聯合訓練。其實現方式是在訓練過程中讓模型有一定機率 p_fp 以過去幀為條件。條件要麼是 1 個隱含影格(影像到影片產生),要麼是 2 個隱含影格(影片預測)。這種條件是透過沿著有雜訊隱含輸入的通道維度整合進模型中。推理過程中使用的是標準的無分類器引導,並以 c_fp 作為條件訊號。 #使用單一模型產生高解析度影片的計算成本非常高,基本上難以實現。而研究者則參考論文《Cascaded diffusion models for high fidelity image generation》使用一種級聯式方法將三個模型級聯起來,它們操作的分辨率越來越高。 其中基礎模型以 128×128 的分辨率生成視頻,然後再經過兩個超分辨率階段被上採樣兩次。首先使用一種深度到空間卷積運算在空間上對低解析度輸入(視訊或影像)進行上取樣。請注意,不同於訓練(提供了基本真值低解析度輸入),推理依賴的是先前階段產生的隱含表徵。 為了減少這種差異並能在超解析度階段更穩健地處理在低解析度階段產生的偽影,團隊也使用了雜訊條件式增強。 縱橫比微調。為了簡化訓練和利用具有不同縱橫比的更多資料來源,他們在基礎階段使用的是方形縱橫比。然後他們又在一個資料子集上對模型進行了微調,透過位置嵌入插值來產生縱橫比為 9:16 的影片。 #研究者在多種任務上評估了新提出的方法:以類別為條件的圖像和視訊生成、幀預測、基於文字的視訊生成。他們也透過消融研究探索了不同設計選擇的效果。 #影片產生:在UCF-101 和Kinetics-600 兩個資料集上,W.A.L.T 在FVD 指標上優於先前的所有方法,請參閱表1。 影像生成:表 2 比較了 W.A.L.T 與其它目前最佳方法產生 256×256 解析度影像的結果。新提出的模型的表現優於先前的方法,並且不需要專門的調度、卷積歸納偏差、改進的擴散損失和無分類器指導。雖然 VDM 的 FID 分數略高一些,但它的模型參數卻多很多(2B)。 #為了理解不同設計決策的貢獻,團隊也進行了消融研究。表 3 給出了在圖塊大小、視窗注意力、自我條件、AdaLN-LoRA 和自動編碼器方面的消融研究結果。 #該團隊在文字- 圖像和文字- 視頻對上聯合訓練了W.A.L.T 的文本到視頻生成能力。他們使用了一個來自公共互聯網和內部資源的資料集,其中包含約 970M 對文字 - 圖像和約 89M 對文字 - 影片。 基礎模型(3B)的解析度為17×128×128,兩個級聯的超解析度模型則分別為17×128×224 → 17× 256×448 (L, 1.3B, p = 2) 和17× 256×448→ 17×512×896 (L, 419M, p = 2)。他們也在基礎階段對縱橫比進行了微調,以便以 128×224 的分辨率生成影片。所有的文本到視頻生成結果都使用了無分類器引導方法。文字:A squirrel eating a burger.

文字:A cat riding a ghost rider bike through the desert.

以科學方式評估以文字為主的影片產生仍是一大難題,部分原因是缺乏標準化的訓練資料集和基準。到目前為止,研究者的實驗和分析都集中在標準的學術基準,它們使用了相同的訓練數據,以確保比較是公平的對照。 儘管如此,為了與先前的文字到視訊生成研究比較,該團隊還是報告了在零樣本評估設定下在 UCF-101 資料集上的結果。 以上是將Transformer用於擴散模型,AI 生成影片達到照片級真實感的詳細內容。更多資訊請關注PHP中文網其他相關文章!