「不服跑個分」這句話,我相信關注手機圈的朋友一定不會感到陌生。例如,安兔兔、GeekBench等理論性能測試軟體因為能夠在一定程度上反映手機的性能,因此備受玩家的關注。同樣地,在PC處理器、顯示卡上也有對應的跑分軟體來衡量它們的效能

既然"萬物皆可跑分",目前最火爆的AI大模型也開始參與跑分比拼,尤其是在"百模大戰"開始後,幾乎每天都有突破,各家都自稱為"跑分第一"

國產AI大模型在表現評分方面幾乎從未落後,但在使用者體驗方面卻始終無法超越GPT-4。這就引發了一個問題,即在大促銷售節點,各手機廠商總能夠宣稱自家產品“銷量第一”,透過不斷增加定語,將市場細分再細分,讓每個人都有機會成為第一,但在AI大模型領域,情況卻不同。畢竟,它們的評估標準基本上是統一的,其中包括MMLU(用於衡量多任務語言理解能力)、Big-Bench(用於量化和外推LLMs的能力),以及AGIEval(用於評估應對人類級任務的能力)

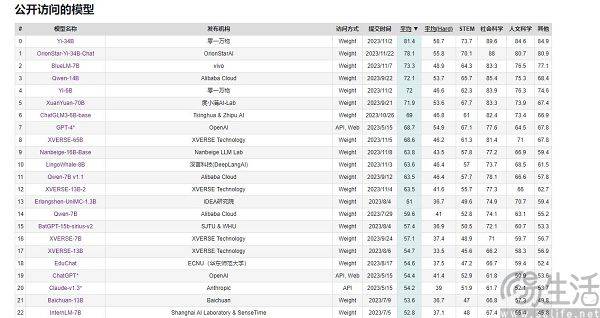

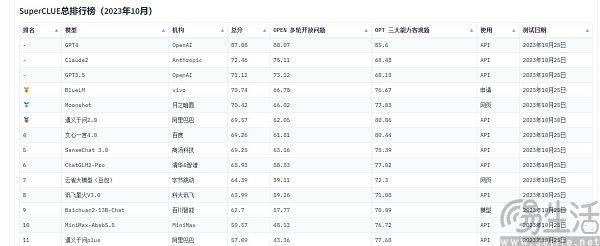

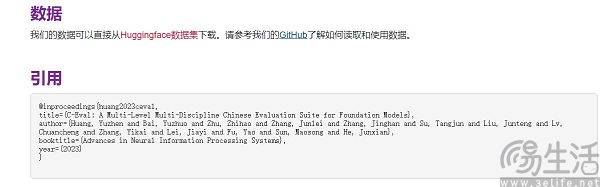

目前在國內常被引用的大型模式評測榜單有SuperCLUE、CMMLU和C-Eval。其中,CMMLU和C-Eval是由清華大學、上海交通大學和愛丁堡大學合作建構的綜合考試評測集。而CMMLU則是由MBZUAI、上海交通大學和微軟亞洲研究院共同推出。至於SuperCLUE,則是由各大專院校的人工智慧專業人士共同撰寫的

以C-Eval為例,在9月初的榜單上,雲天勵飛大模型 " 雲天書 " 排在第一、360排第八,GPT-4卻只能排在第十名。既然標準是可量化的,為什麼會出現反直覺的結果呢?大模型跑分榜單之所以會呈現出「群魔亂舞」的景象,其實是目前評價AI大模型表現的方法有局限性,它們是用「做題」的方式來衡量大模型的能力。

眾所周知,智慧型手機的SoC、電腦的CPU和顯示卡為了保護自身壽命,在高溫情況下會自動降頻,而低溫則能提升晶片效能。因此,有些人會將手機放入冰箱中,或為電腦配備更強大的散熱系統來進行效能測試,通常能得到比正常狀態下更高的成績。此外,各大手機廠商也會進行“專屬優化”,針對各類跑分軟體,這已經成為他們的標準操作了

同樣道理,人工智慧大模型的評分以做題為核心,自然會有一個題庫。沒錯,國內一些大模型不斷上榜的原因就在於這一點。由於各種原因,目前各大模型榜單的題庫對廠商幾乎是單向透明的,也就是出現了所謂的「基準洩漏」。例如,C-Eval榜單在剛上線時就有13948道題目,並且由於題庫有限,出現了讓某些不知名大模型通過刷題的方式“通關”的情況

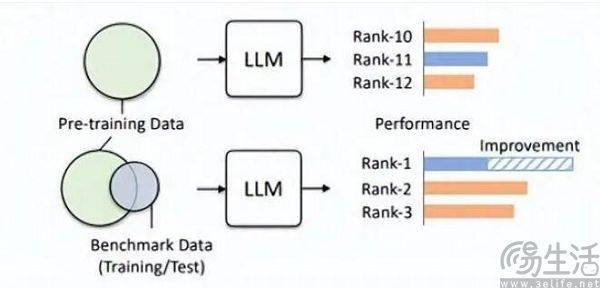

大家可以想像一下,在考試之前,如果偶然看到了考捲和標準答案,然後突擊背題,考試成績將會大幅提高。因此,將大模型榜單預設的題庫加入訓練集,這樣一來大模型就成為了擬合基準資料的模型。而且,目前的LLM本身就以出色的記憶力而著稱,背誦標準答案簡直就是小菜一碟

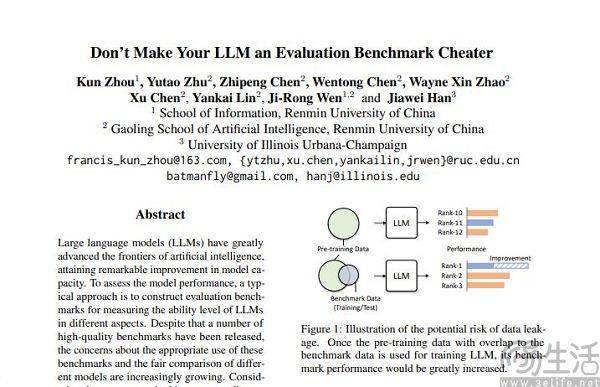

透過這個方式,小尺寸模型在跑分中也能擁有比大尺寸模型更好的結果,部分大模型所取得的高分就是在這樣的「微調」下實現。人大高瓴團隊在論文《Don't Make Your LLM an Evaluation Benchmark Cheater》中,就直白地指明了此類現象,而且這種投機取巧的做法對於大模型的性能反而是有害的。

高瓴團隊的研究人員發現,基準洩漏會導致大模型跑出誇張的成績,例如1.3B的模型可以在某些任務上超越10倍體量的模型,但副作用就是這些專門為「應試「設計的大模型,在其他正常測試任務上的表現會受到不利影響。畢竟想想也能知道,AI大模型本來應該是“做題家”、卻變成了“背題家”,為了獲得某榜單的高分,去使用該榜單特定的知識和輸出樣式,肯定就會誤導大模型。

訓練集、驗證集、測試集的不交叉顯然只是理想狀態,畢竟現實很骨感,資料外洩問題從根源幾乎不可避免。隨著相關技術的不斷進步,當下大模型的基石Transformer結構的記憶和接收能力不斷提升,今年夏季微軟研究院General AI的策略就已經實現了讓模型接收1億Tokens、而不會產生無法接受的遺忘。換而言之,未來AI大模型很有可能具有讀取整個互聯網的能力。

即使拋開技術進步,單純以當下的技術水平,數據污染其實也難以規避,因為優質數據總歸是稀缺、且產能有限的。 AI研究團隊Epoch在今年年初發表的論文就表明,AI不出5年就會把人類所有的高質量語料用光,而且這一結果是其將人類語言數據增長率,即全體人類未來5年內出版的書籍、撰稿的論文、寫的程式碼都考慮在內,預測的結果。

如果一個資料集適合用於評估的話,那麼它在預訓練方面肯定也能夠發揮更好的作用。例如,OpenAI的GPT-4就使用了權威的推理評估資料集GSM8K。因此,目前在大型模型評估領域存在一個尷尬的問題,大型模型對數據的需求似乎沒有止境,這導致評估機構必須比人工智慧大型模型製造商更快、更遠地前進。然而,現如今評估機構似乎根本沒有能力做到這一點

至於說為什麼某些廠商會在大模型跑分上格外上心,紛紛去操作刷榜呢?其實這行為背後的邏輯,就跟App開發者為自家App的用戶量注水一模一樣。畢竟App的用戶規模是衡量其價值的關鍵要素,而在當下這個AI大模型的起步階段,評測榜單的成績幾乎就是唯一一個相對客觀的評判標尺,畢竟在大眾的認知裡跑分高就等於性能強。

當刷榜可能帶來強烈的宣傳效應,甚至可能會為融資打下基礎的情況下,商業利益的加入就必然會驅使AI大模型廠商爭先恐後去刷榜了。

以上是一言不合就跑分,國內AI大模型為何沉迷於'刷榜”的詳細內容。更多資訊請關注PHP中文網其他相關文章!