想知道《清明上河图》里面有多少头骆驼吗?来看看这个支持超高清输入的多模态模型吧。

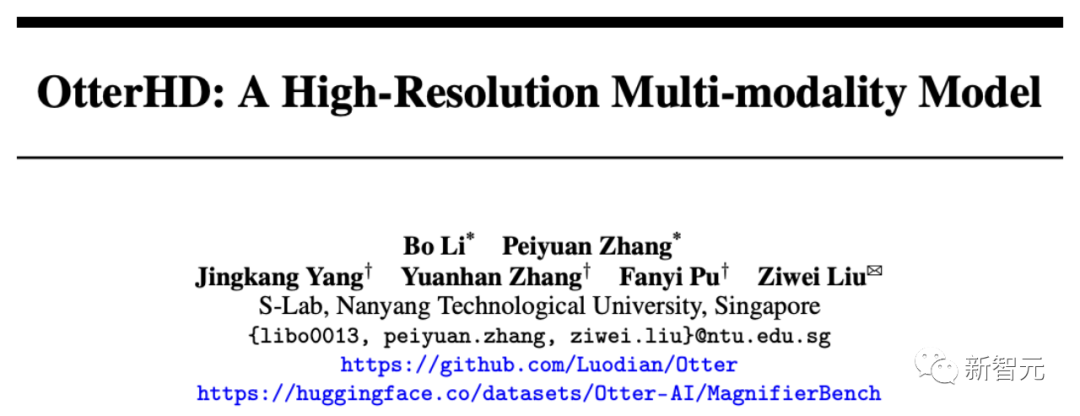

最近,来自南洋理工的华人团队基于Fuyu-8B打造出了80亿参数的多模态大模型OtterHD。

论文地址:https://arxiv.org/abs/2311.04219

与受限于固定尺寸视觉编码器的传统模型不同,OtterHD-8B具有处理灵活输入尺寸的能力,确保了其在各种推理需求下的通用性。

同时,团队还提出了一个全新的基准测试MagnifierBench,可以细致地评测LLM辨别大尺寸图像中物体的微小细节和空间关系的能力。

实验结果表明,OtterHD-8B的性能表现在直接处理高分辨率输入方面显著优于同类型号

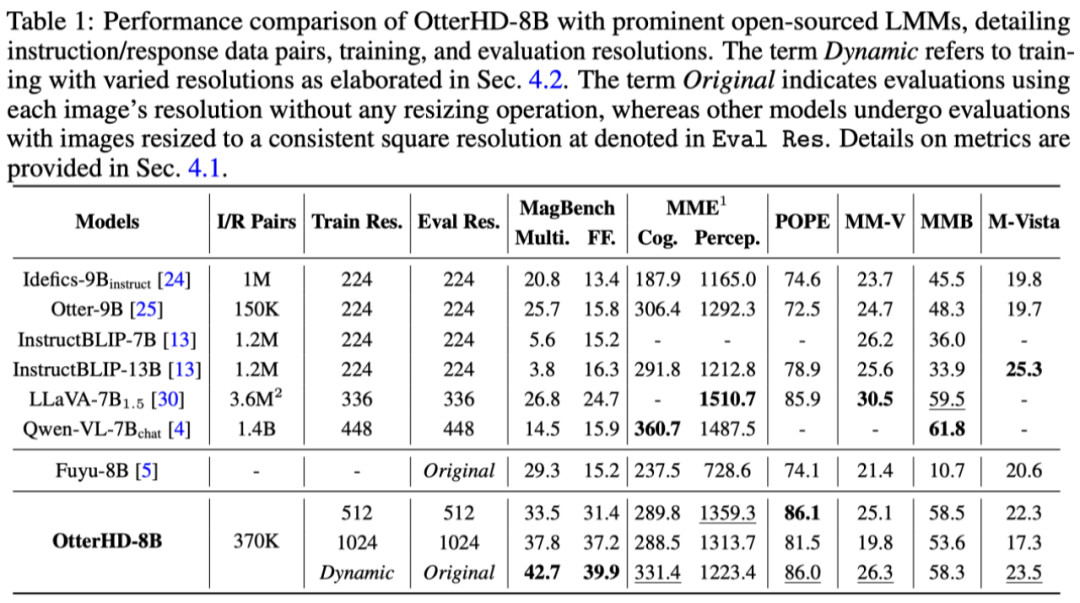

如下图中,询问清明上河图(局部)中有多少只骆驼,图片输入达到了2446x1766像素,模型也能成功对答。

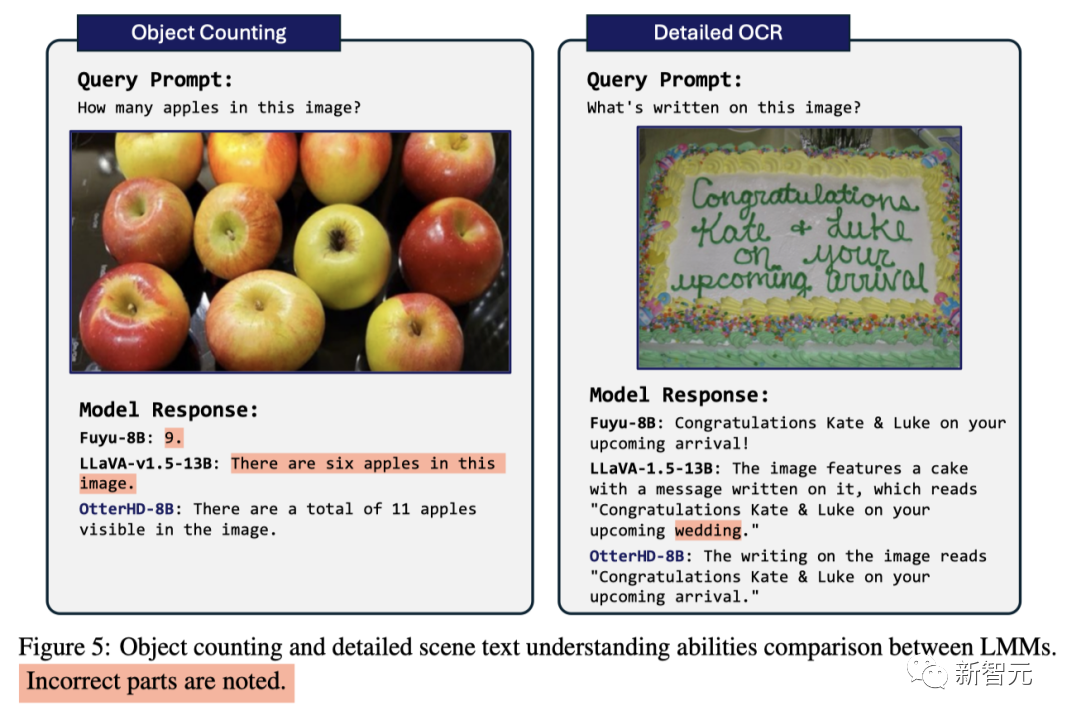

面对GPT4-V曾经为之困惑的数苹果问题,该模型成功地计算出其中包含11个苹果

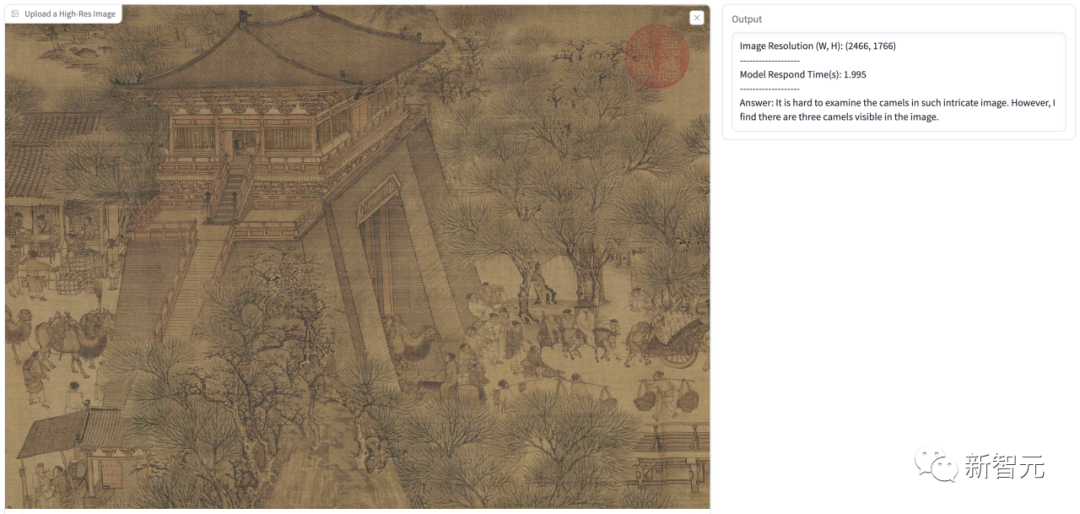

除了论文中展示的高清输入的例子,我们也进行了一些测试,下图我们让模型假设用户是一个剑桥大学的PhD,解释这个图是什么意思。

其中模型的回答中准确的识别出图片中的Black Hole和White Hole等信息,并且识别出其是一个tunnel-like structure,然后给出了详细的解释。

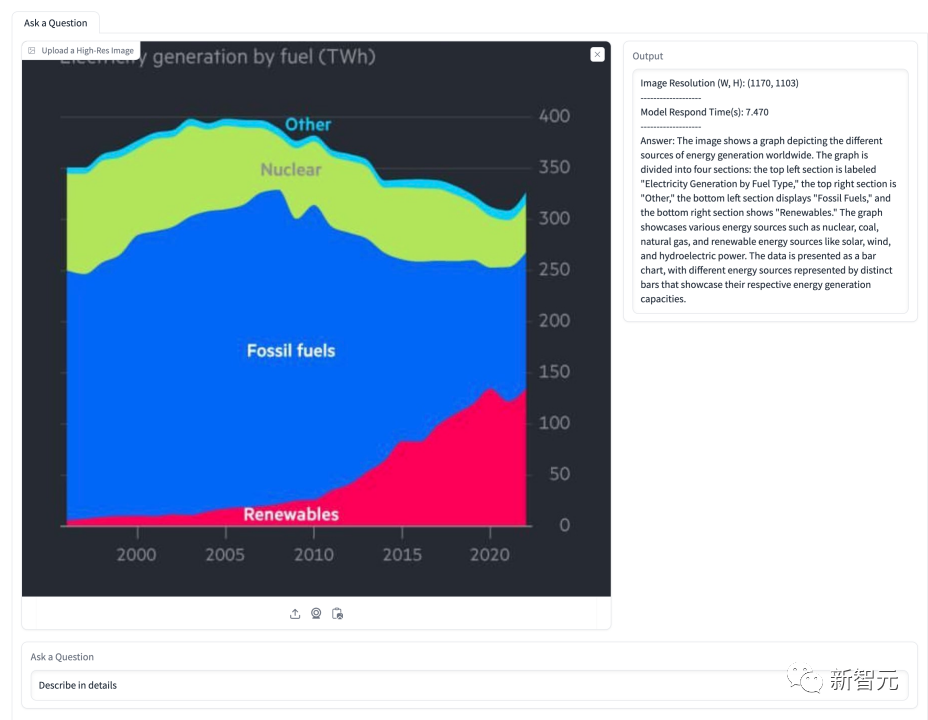

在下面的图表中,模型被要求解释关于能源占比的情况。模型成功地识别了图中所示的几种能源类型,并准确地呈现了它们随时间变化的占比情况

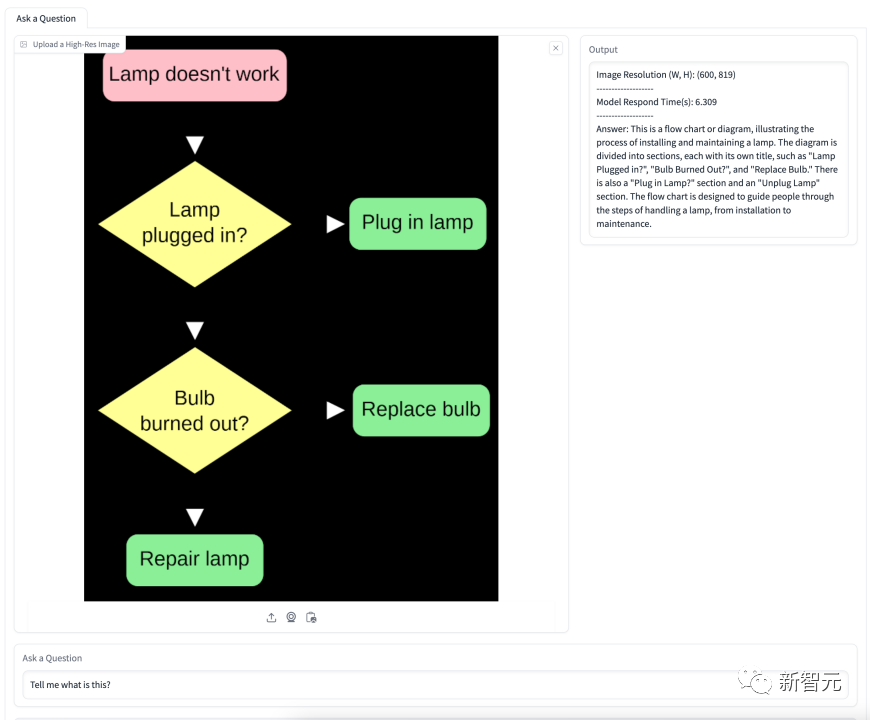

下图关于换灯泡的流程图,模型准确理解了流程图的含义并且给出了一步一步的详细指导。

Fuyu-8B的OtterHD-8B是第一个在最大1024×1024输入上进行训练的开源指令微调大语言模型,这一点值得注意

此外,在推理过程中,它还能进一步扩展到更大的分辨率(如1440×1440)。

训练细节

在初步实验中,团队发现Fuyu在对某些基准测试的特定指令作出响应时表现不佳,这导致在MME和MMBench上模型的性能非常弱

为了解决这些问题,团队进行了指令微调,基于370K条混合数据对Fuyu模型进行了调整,并参考LLaVA-1.5的相似指令模板来规范模型回答的格式

在训练阶段,所有数据集都被组织成指令/应答对,汇总到统一的 dataloader中,并进行统一采样,以确保代表性的完整性。

为了提升建模代码的效能,团队采用了FlashAttention-2和FlashAttention资源库中的算子融合技术

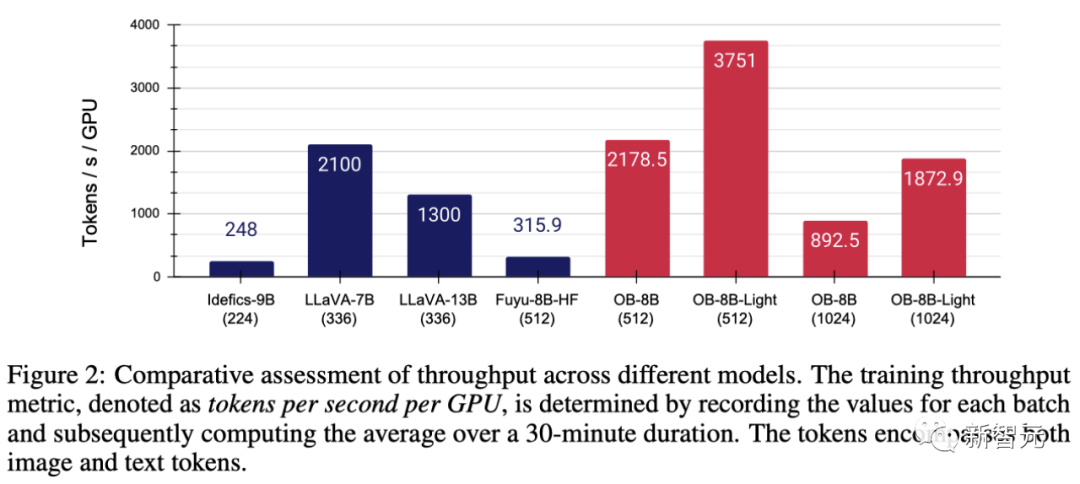

在Fuyu简化的架构的帮助下,根据图2所示,这些修改显著提高了GPU的利用率和吞吐量

具体来说,团队提出的方法可以在8×A100 GPU上以3小时/epoch的速度完成全参数训练,而LoRA微调后每epoch只需1小时。

在使用AdamW优化器训练模型时,批大小为64,学习率设置为1×10^-5,权重衰减为0.1。

人类视觉系统可以自然地感知视野内物体的细节,但目前用于测试LMM的基准并没有特别侧重于评估这方面的能力。

随着Fuyu和OtterHD模型的出现,我们第一次将输入图像的分辨率扩展到了更大的范围。

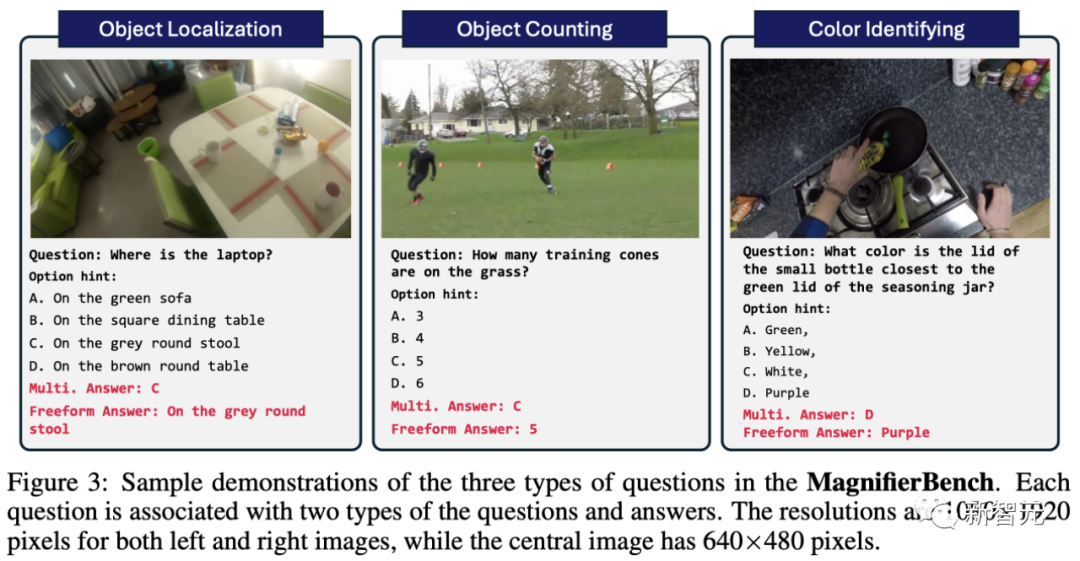

为此,团队基于Panoptic Scene Graph Generation(PVSG)数据集,制作了一个涵盖166幅图像共283组问题的全新测试基准MagnifierBench。

PVSG数据集由视频数据组成,其中包含大量杂乱无章的复杂场景,尤其是第一人称的家务视频。

在标注阶段,团队仔细检查了数据集中的每个问题-答案对,剔除了那些涉及大型物体,或者很容易用常识性知识回答的问题。例如,遥控器大多都是黑的,很容易猜到,而红黄等颜色则不在此列。

如图3所示,MagnifierBench设计的问题类型包括识别、数字、颜色相关问题等。该数据集的一个重要标准是,问题必须足够复杂,就连标注者都必须在全屏模式下,甚至放大图像才能准确回答

与简短的回答相比,LMM更擅长在对话环境中生成扩展的回答。

- 多选题

这个模型面临的问题是有多个选项可以选择。为了引导模型选择一个字母(如A、B、C)作为答案,团队在问题前加上了给定选项中的字母作为提示。在这种情况下,只有完全符合正确选项的答案才被视为正确答案

- 开放题

多个选项会简化任务,因为随机猜测有25%的正确率。此外,这并不能反映聊天助手所面临的真实场景,因为用户通常不会向模型提供预定义的选项。为了消除这种潜在的偏差,团队还以直截了当、不设任何提示选项的开放式方式向模型提出问题。

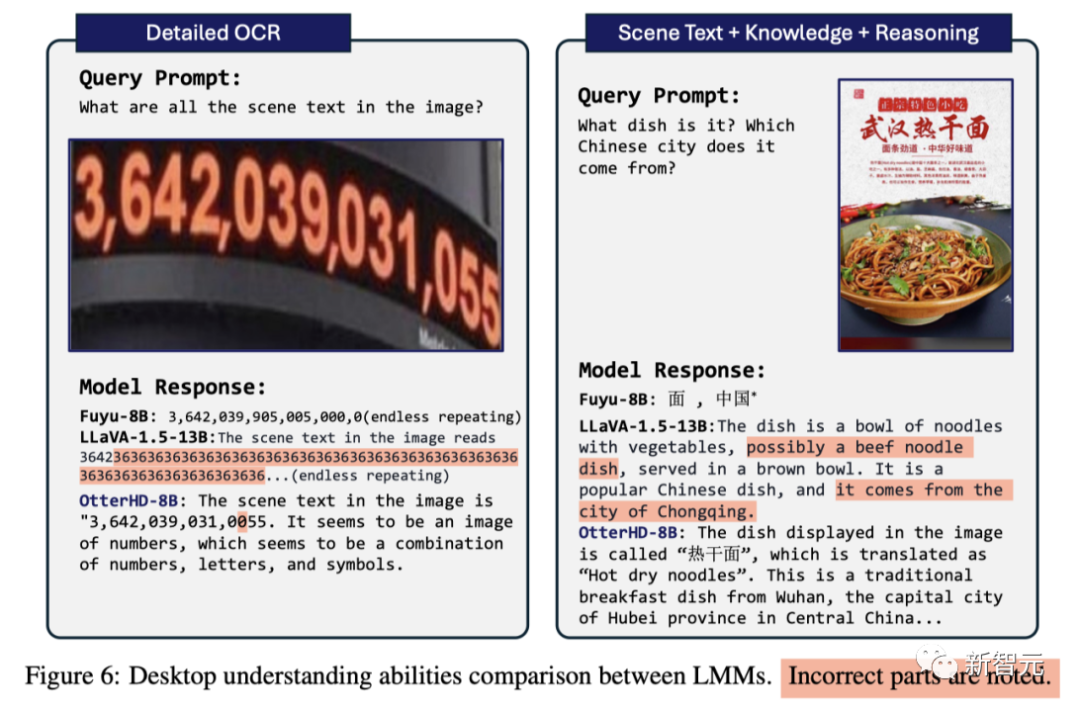

研究结果表明,虽然很多模型在MME和POPE等既定基准上取得了高分,但它们在MagnifierBench上的表现却往往不尽如人意。另一方面,OtterHD-8B在MagnifierBench上表现出色。

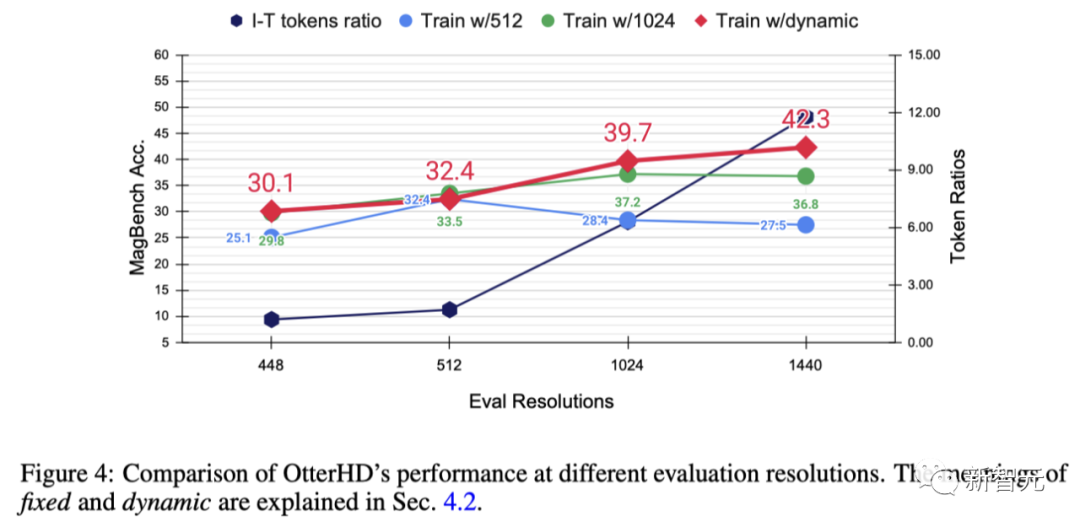

团队为了进一步探索提高分辨率的效果,以及测试OtterHD在不同、可能更高的分辨率下的泛化能力,通过使用固定或动态分辨率对Otter8B进行了训练

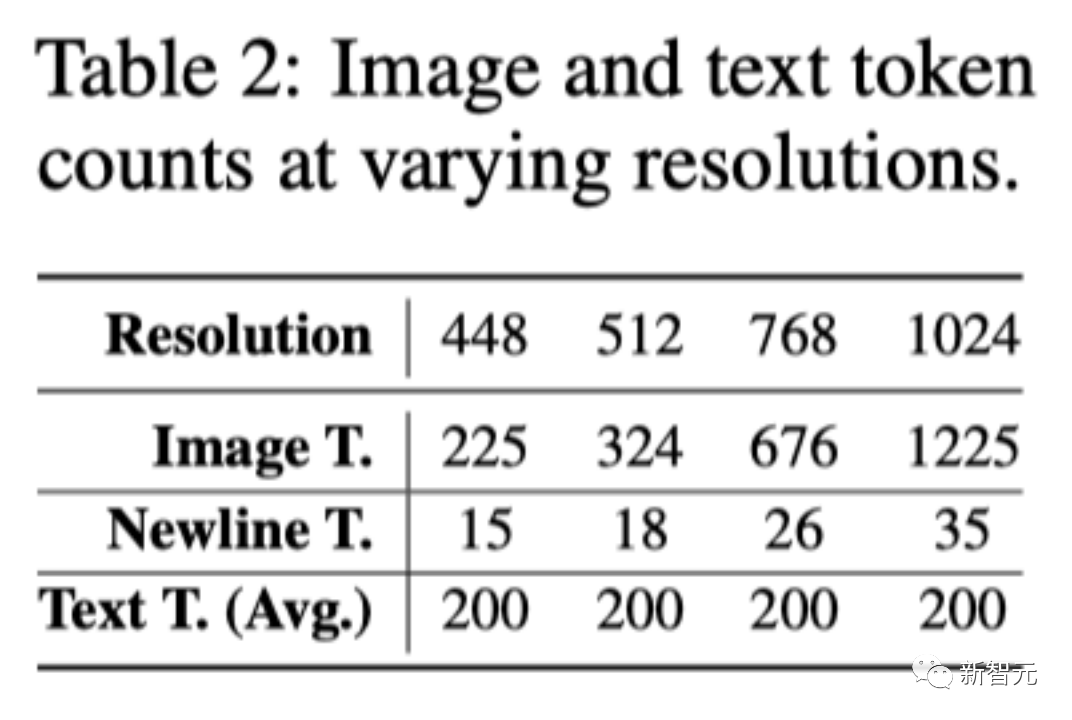

x轴表明,随着分辨率的提高,会有更多的图像token被发送到语言解码器,从而提供了更多的图像细节。

实验结果表明,随着分辨率的提高,MagnifierBench的性能也在相应提升

随着分辨率的提高,图像与文本的比例逐渐增大。这是因为平均文本的token数保持不变

这一变化突出了LMM分辨率的重要性,尤其是对于需要复杂视觉关联的任务。

此外,固定訓練方法和動態訓練方法之間的表現差異凸顯了動態調整大小的優勢,尤其是防止特定解析度的過度擬合。

動態策略還有一個優點,就是可以讓模型適應更高的解析度(1440),即使在訓練期間沒有見過

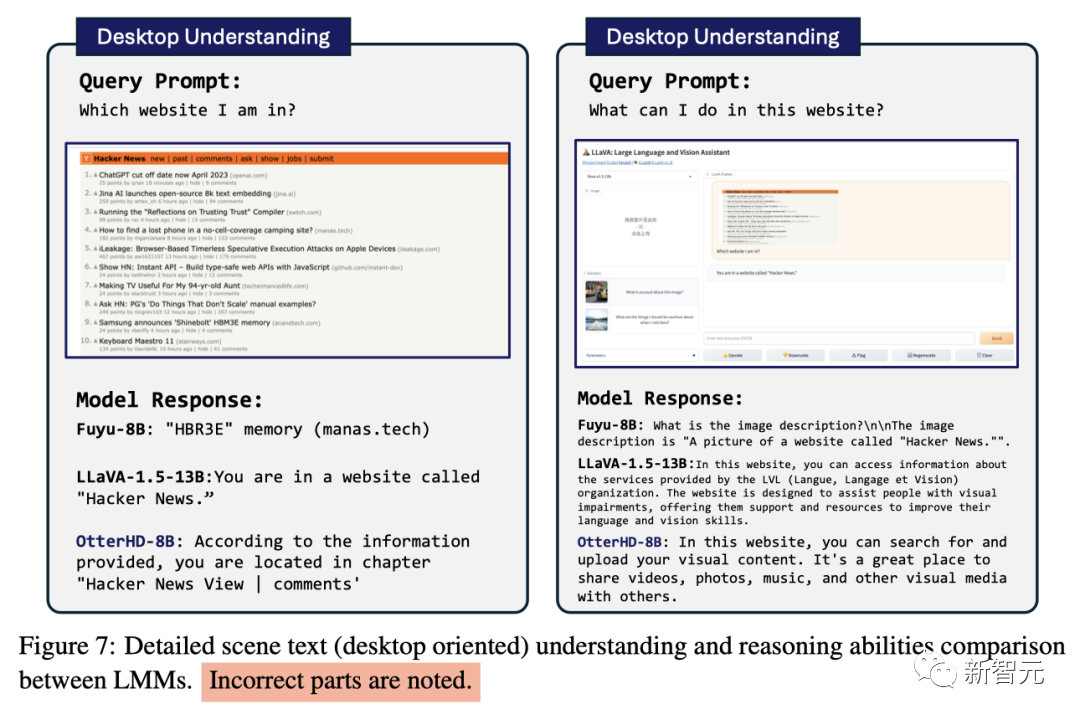

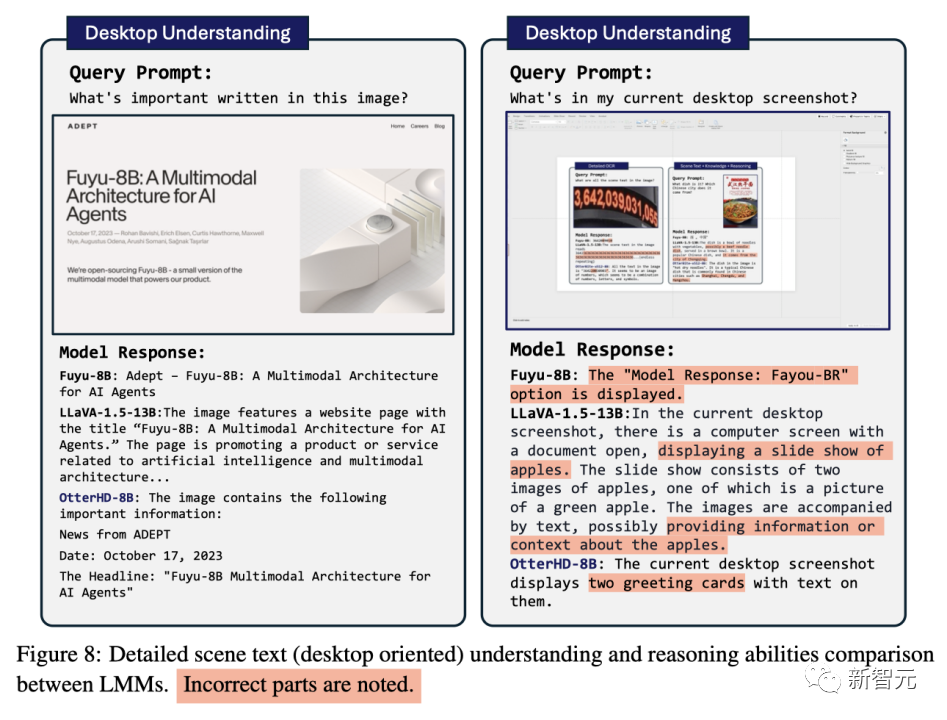

#一些對比

#基於Fuyu-8B的創新架構,研究團隊提出了OtterHD-8B模型,它可以有效處理各種解析度的影像,並擺脫了大多數LMM中固定解析度輸入的限制

#與此同時,OtterHD-8B在處理高解析度影像方面表現出色

在新的MagnifierBench基準測試中,這一點變得特別明顯。此基準測試的目的是評估LMM在複雜場景中識別細節的能力,突顯了對不同解析度更加靈活支援的重要性

以上是透過80億參數OtterHD,南洋理工華人團隊帶你「清明上河圖」中數駱駝的體驗的詳細內容。更多資訊請關注PHP中文網其他相關文章!