多模態大模型最全綜述來了!

由微軟7位華人研究員撰寫,足足119頁——

它從目前已經完善的和還處於最前沿的兩類多模態大模型研究方向出發,全面總結了五個具體研究主題:

並且專注於一個現象:

多模態基礎模型已經從專用走向通用。

Ps. 這也是為什麼論文開頭作者就直接畫了一個哆啦A夢的圖像。

誰適合閱讀這份綜述(報告)?

用微軟的原話來說:

只要你有興趣學習多模態基礎模型的基礎知識和最新進展,無論你是專業研究員還是在校學生,這個內容都非常適合你

一起來看看~

這五個具體主題中的前兩個是目前已經成熟的領域,而後三個則屬於前沿領域

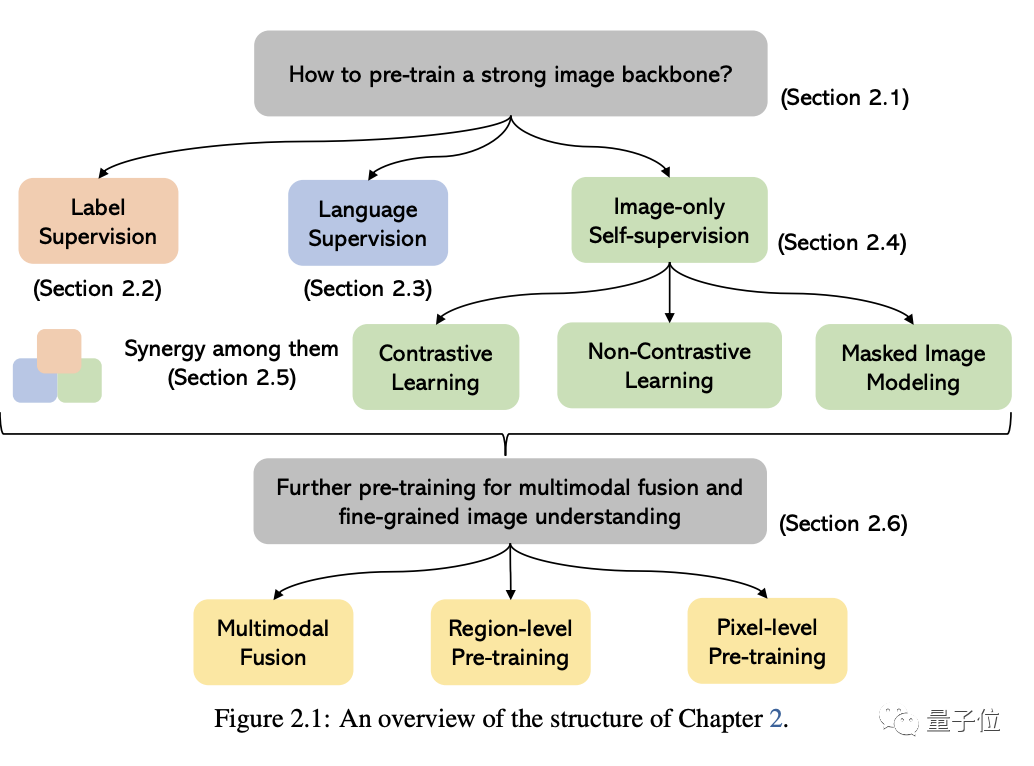

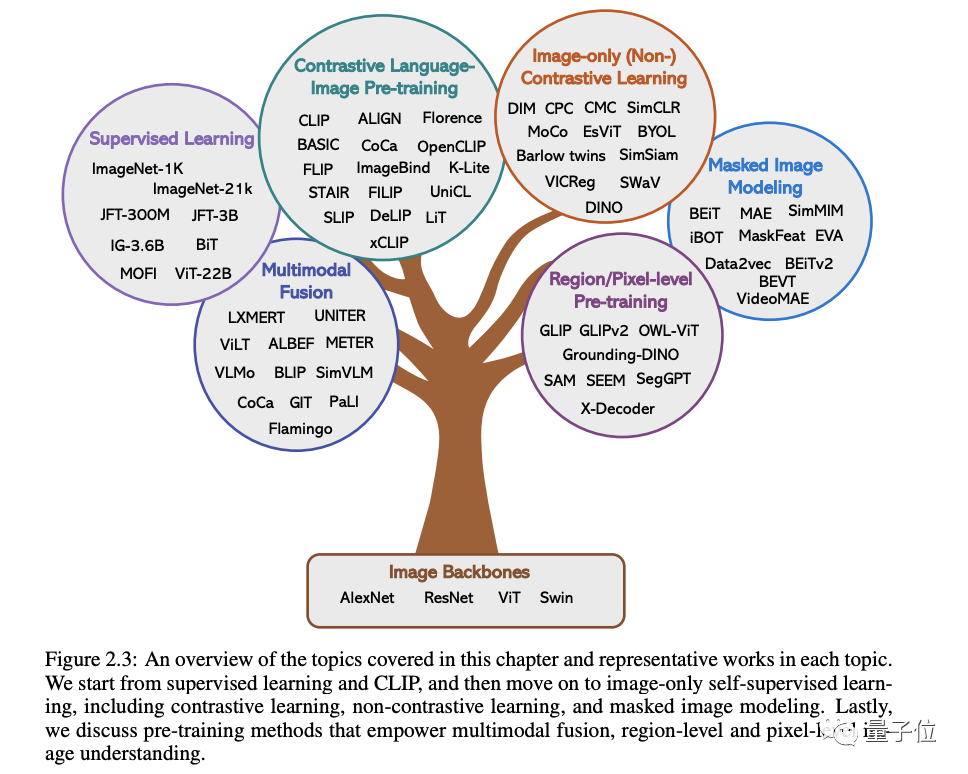

這部分的核心問題是如何預訓練一個強大的圖像理解backbone。

如下圖所示,根據用於訓練模型的監督訊號的不同,我們可以將方法分為三類:

標籤監督、語言監督(以CLIP為代表)和只有影像的自監督。

其中最後一個表示監督訊號是從影像本身挖掘出來的,流行的方法包括對比學習、非對比學習和masked image建模。

除了這些方法之外,文章還進一步討論了多模態融合、區域級和像素級影像理解等類別的預訓練方法

#也列出了以上這些方法各自的代表作品。

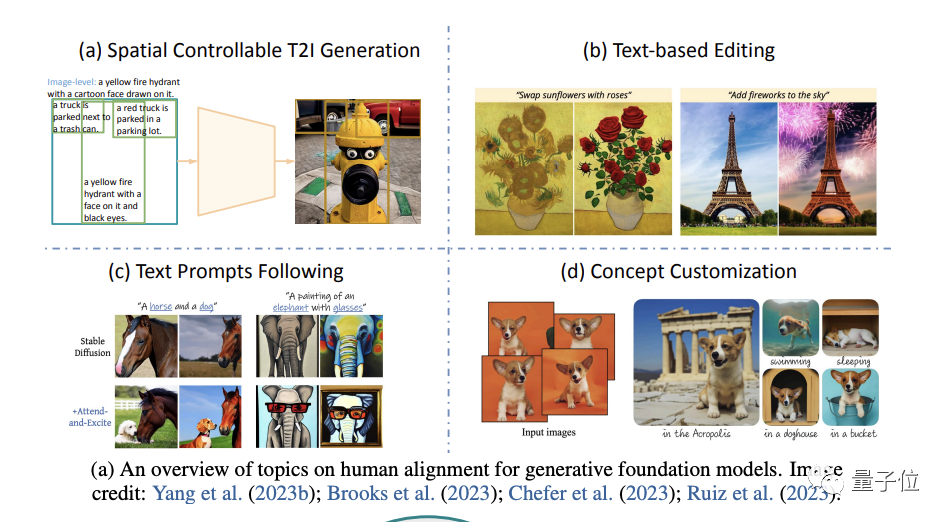

這個主題是AIGC的核心,不限於影像生成,還包括影片、3D點雲圖等等。

而且它的用處不止於藝術、設計等領域——還非常有助於合成訓練數據,直接幫助我們實現多模態內容理解和生成的閉環。

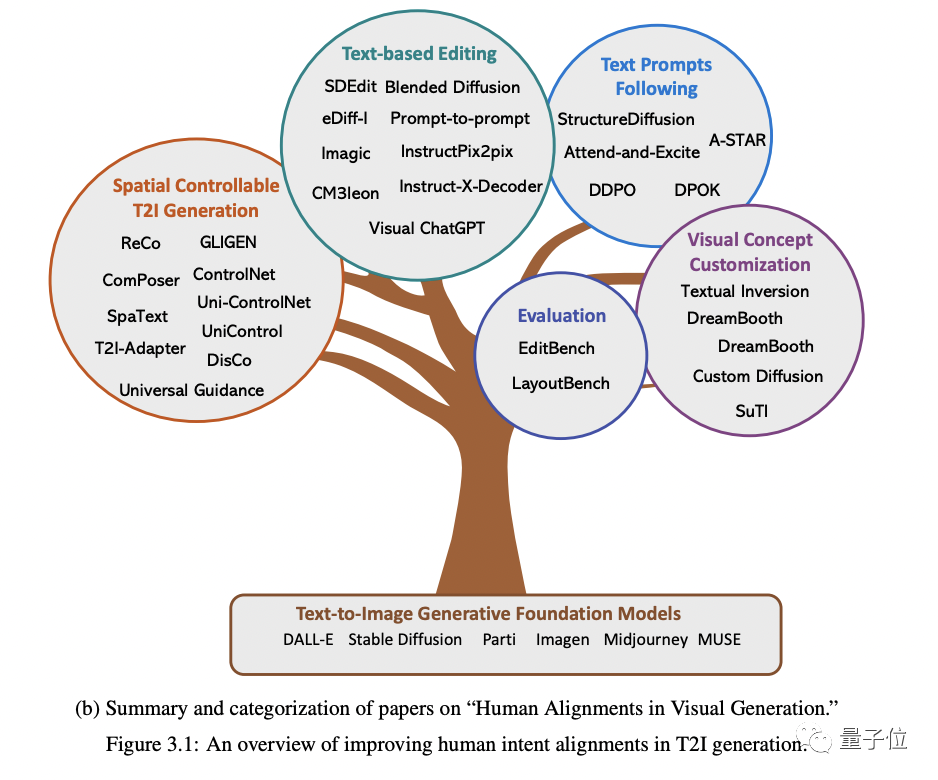

在這部分,作者重點討論了產生與人類意圖嚴格一致的效果的重要性和方法(重點是圖像生成)。

具體則從空間可控生成、基於文本再編輯、更好地遵循文本提示和生成概念定制(concept customization)四個方面展開。

在本節的結尾,作者也分享了他們對目前研究趨勢和即將展開的研究方向的觀點

為了更好地遵循人類的意圖並使上述四個方向都能夠更加靈活和可替代,我們需要開發一個通用的文生成模型

列舉了四個方向的各自代表作如下:

這部分內容探討了建構統一視覺模型所面臨的挑戰:

需要進行改寫的內容是:首先,輸入類型不同;

需要進行改寫的內容是:其次,不同的任務需要採用不同的細粒度,並且輸出也要求採用不同的格式;

#資料也面臨挑戰,除了建模之外

例如不同類型的標籤註釋成本差異很大,收集成本比文字資料高得多,這導致視覺資料的規模通常比文字語料庫小得多。

不過,儘管挑戰多多,作者指出:

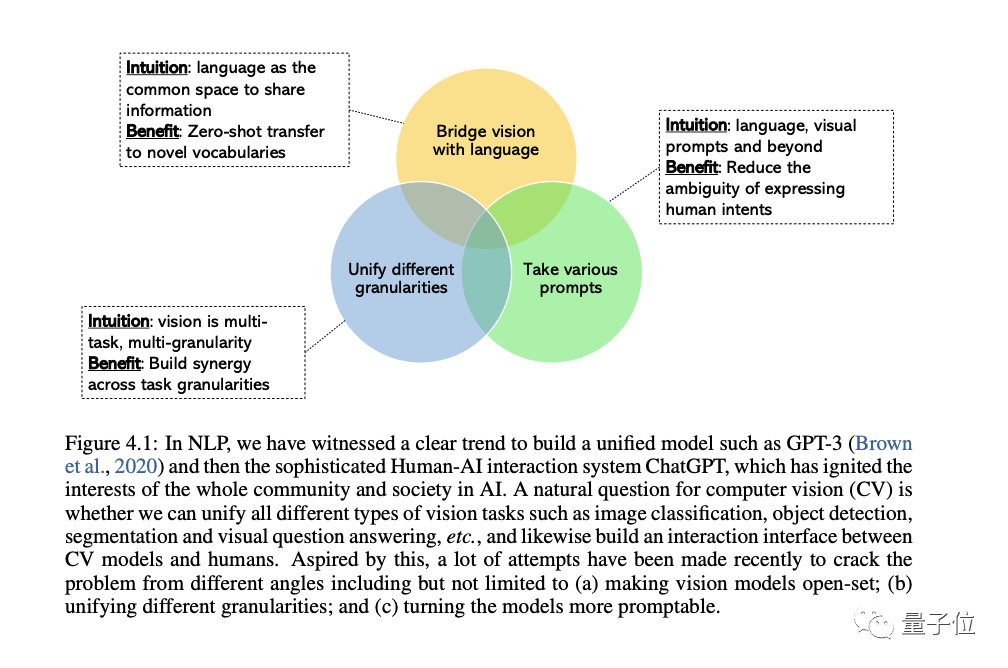

CV領域對於開發通用、統一的視覺系統的興趣是越來越高漲,還衍生出來三類趨勢:

一是從閉集(closed-set)到開集(open-set),它可以更好地將文字和視覺匹配起來。

從特定任務到通用能力的轉變最重要的原因是為每個新任務開發一個新模型的成本太高

三是從靜態模型到可提示模型,LLM可以採用不同的語言和上下文提示作為輸入,並在不進行微調的情況下產生使用者想要的輸出。我們要打造的通用視覺模型應該具有相同的情境學習能力。

本節全面探討多模態大模型。

先是深入研究背景和代表實例,並討論OpenAI的多模態研究進展,確定該領域現有的研究空白。

接下來作者詳細檢視了大語言模型中指令微調的重要性。

再接著,作者探討了多模態大模型中的指令微調工作,包括原理、意義和應用。

最後,我們還將涉及一些多模態模型領域中的高階主題,以便更深入地了解,其中包括:

更多超越視覺和語言的模態、多模態的上下文學習、參數高效訓練以及Benchmark等內容。

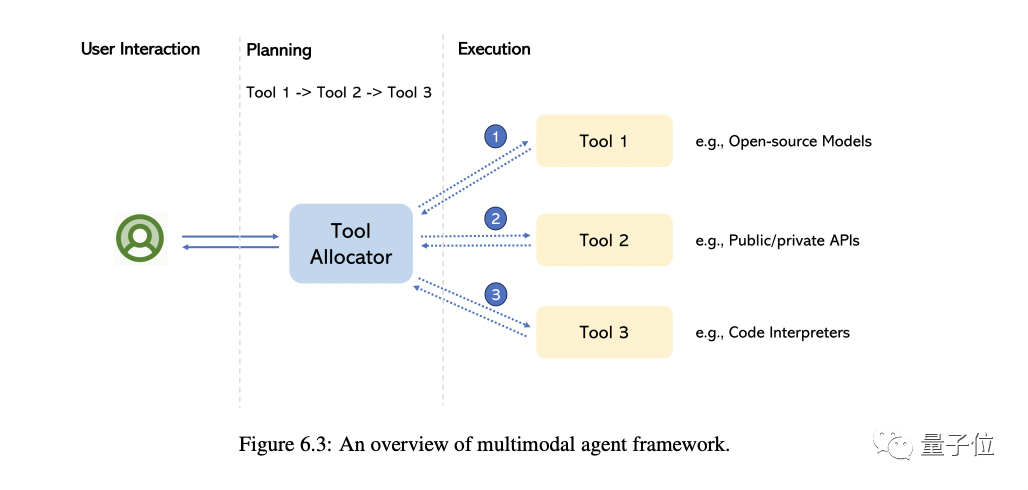

所謂多模態agent,就是一種將不同的多模態專家與LLM連結起來解決複雜多模態理解問題的辦法。

這部分,作者主要先帶大家回顧了這種模式的轉變,總結方法與傳統方法的根本差異。

以MM-REACT為例,我們將詳細介紹這種方法的具體運作方式

我們進一步總結瞭如何建構多模態代理的全面方法,以及它在多模態理解方面的新興能力。同時,我們也介紹瞭如何輕鬆地擴展這種能力,包括最新、最強大的LLM和潛在的數百萬種工具

當然,最後也是一些高階主題討論,包括如何改進/評估多多模態agent,由它建成的各種應用程式等。

這份報告共有7位作者

發起人和整體負責人為Chunyuan Li 。

他是微軟雷德蒙首席研究員,博士畢業於杜克大學,最近研究興趣為CV和NLP中的大規模預訓練。

他負責了開頭介紹和結尾總結以及「利用LLM訓練的多模態大模型」這章的撰寫。 重寫後的內容:他負責撰寫了文章的開頭介紹和結尾總結,以及關於「利用LLM訓練的多模態大模型」這一章的部分

核心作者共有4位:

目前已進入Apple AI/ML工作,負責大規模視覺和多模態基礎模型研究。先前是Microsoft Azure AI的首席研究員,北大本碩畢業,杜克大學博士畢業。

他是微軟的高級研究員,畢業於羅徹斯特大學並獲得了ACM SIGMM傑出博士獎等榮譽。他本科就讀於中國科學技術大學

#微軟雷德蒙研究院深度學習小組首席研究員。佐治亞理工學院博士畢業。

#Microsoft Cloud & AI電腦視覺組研究員,普渡大學碩士畢業。

他們分別負責了剩下四個主題章節的撰寫。

綜述網址:https://arxiv.org/abs/2309.10020

#以上是多模態大模型最全綜述來了! 7位微軟研究員大力合作,5大主題,成文119頁的詳細內容。更多資訊請關注PHP中文網其他相關文章!