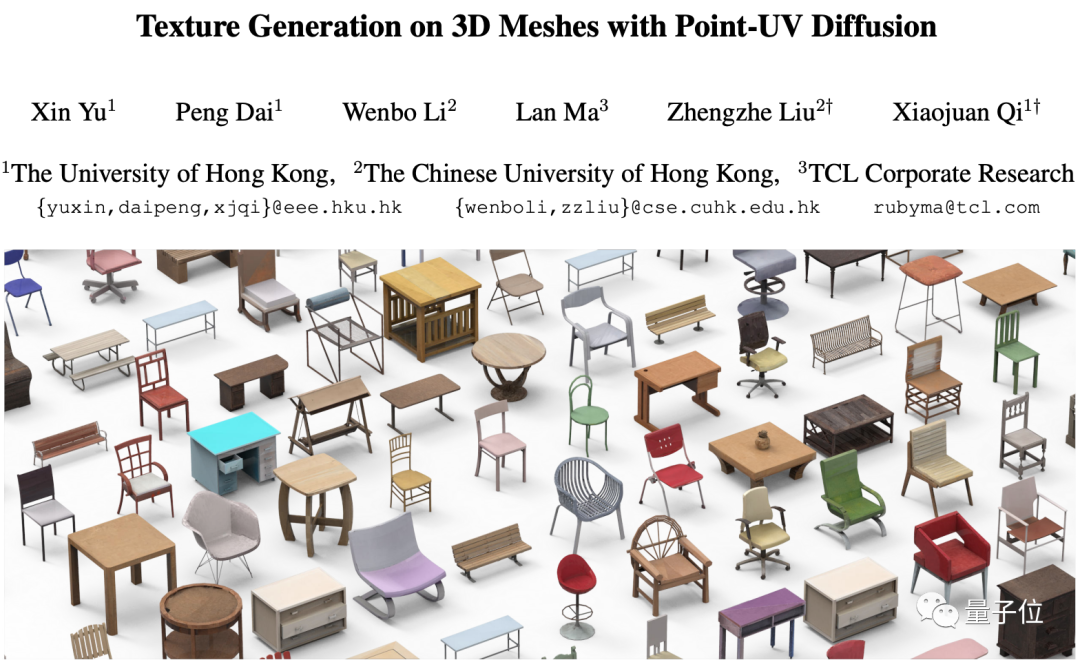

用上擴散模型,3D物件生成紋理一句話就能搞定!

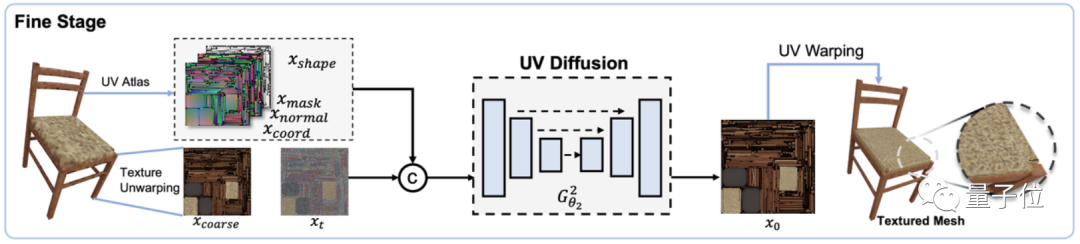

當你輸入「一張帶有棕色和黑色幾何圖案的椅子」時,擴散模型會立即為它添加古老的紋理,給人一種具有年代感的感覺

AI能夠立即以想像力為桌面添加木質的細節紋理,甚至只需要一張看不出桌面長相的截圖

要知道,為3D物件加上紋理,可不只是「變變顏色」這麼簡單。

設計材質時,需要考慮到粗糙度、反射、透明度、漩渦、泛光等多個參數。為了設計出好的效果,不僅需要了解材質、燈光、渲染等方面的知識,還需要進行反覆的渲染測試和修改。如果材質發生變化,可能需要重新開始設計

需要進行重寫的內容是:遊戲場景中紋理遺失的效果

然而,先前使用人工智慧設計的紋理在外觀上並不理想,因此設計紋理一直是一項耗時費力的工作,也造成了較高的成本

港大、港中文和TCL的研究人員最近開發了一種全新的人工智慧設計3D物件紋理的方法。這種方法不僅能夠完美保留物體原有的形狀,還能夠設計出更真實、完美貼合物體表面的紋理

#目前這項研究已經被ICCV 2023收錄為口頭報告論文

我們需要重新寫的內容是:這個問題的解決方法是什麼?讓我們一起來看看

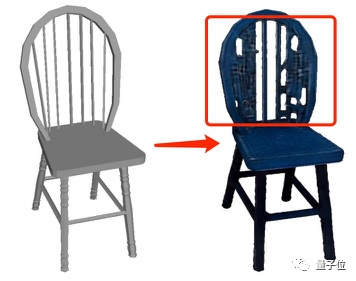

在之前使用人工智慧設計3D紋理時,主要存在兩類問題

生成的紋理不真實,細節有限的一類

生成過程中會對3D物件本身的幾何做特殊處理,使得生成的紋理無法和原始物件完美貼合,會「冒出」奇怪的形狀

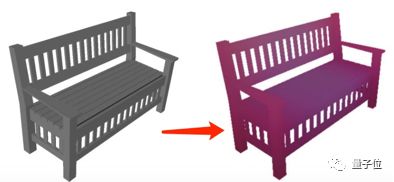

因此,為了能確保3D物體結構穩定、同時生成細節逼真的紋理,這項研究設計了一個名叫Point-UV diffusion的框架。

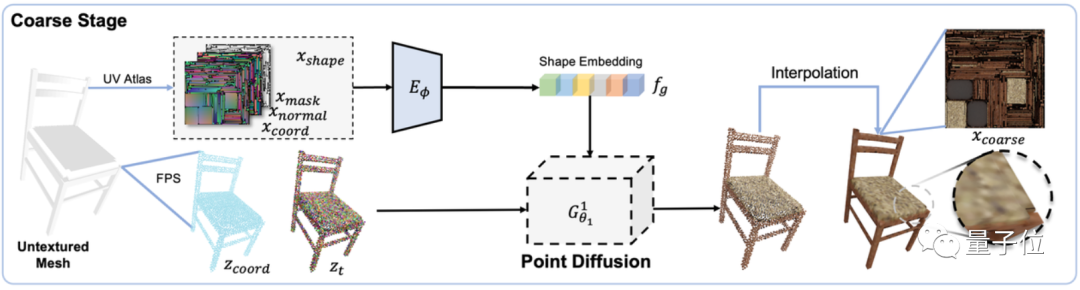

這個框架包含「粗設計」和「精加工」兩個模組,都基於擴散模型打造,不過二者用到的擴散模型有所不同。

首先在「粗設計」模組中,訓練一個以形狀特徵(包括表面法線、座標和遮罩)為輸入條件的3D擴散模型,用來預測物體形狀中每個點的顏色,從而產生一個粗糙紋理圖像效果:

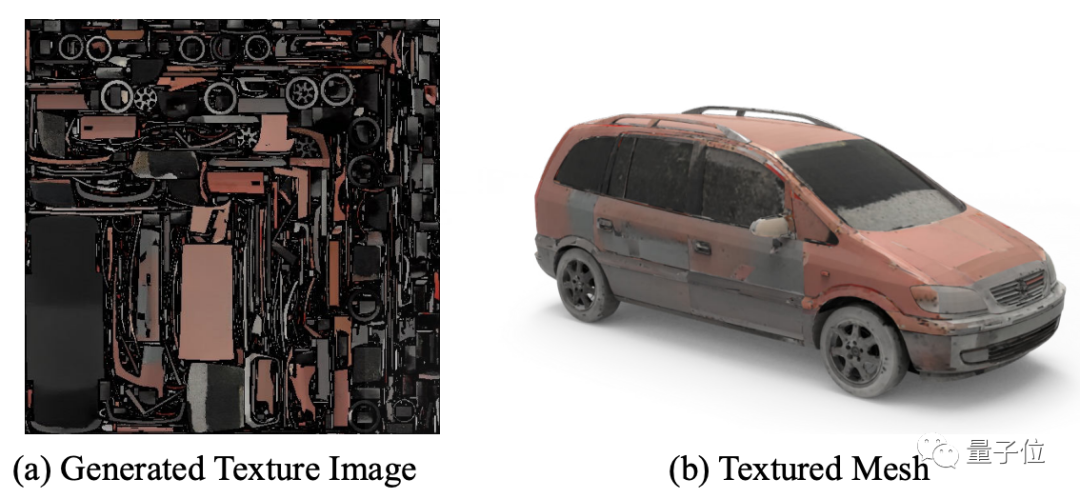

在「精加工」模組中,也設計了一個2D擴散模型,用於進一步利用先前生成的粗糙紋理圖像和物體形狀作為輸入條件,以產生更精細的紋理

採取這種設計結構的原因是先前的高解析度點雲生成方法計算成本通常過高

透過這種兩階段產生的方法,不僅可以節省計算成本,使得兩個擴散模型能夠各自發揮作用,而且與之前的方法相比,不僅保留了原始3D物體的結構,生成的紋理也更加精細

至於透過輸入文字或圖片控制生成效果,則是CLIP的「功勞」。

為了不改變原始意思,需要將內容改寫成中文。需要改寫的內容是:針對輸入,作者會先使用預先訓練的CLIP模型提取文字或圖像的嵌入向量,然後將其輸入到一個MLP模型中,最終將條件整合到“粗設計”和“精加工”兩個階段的網路中

透過文字和影像控制產生的紋理,可以實現最終輸出結果

#因此,這個模型的實現效果到底如何呢?

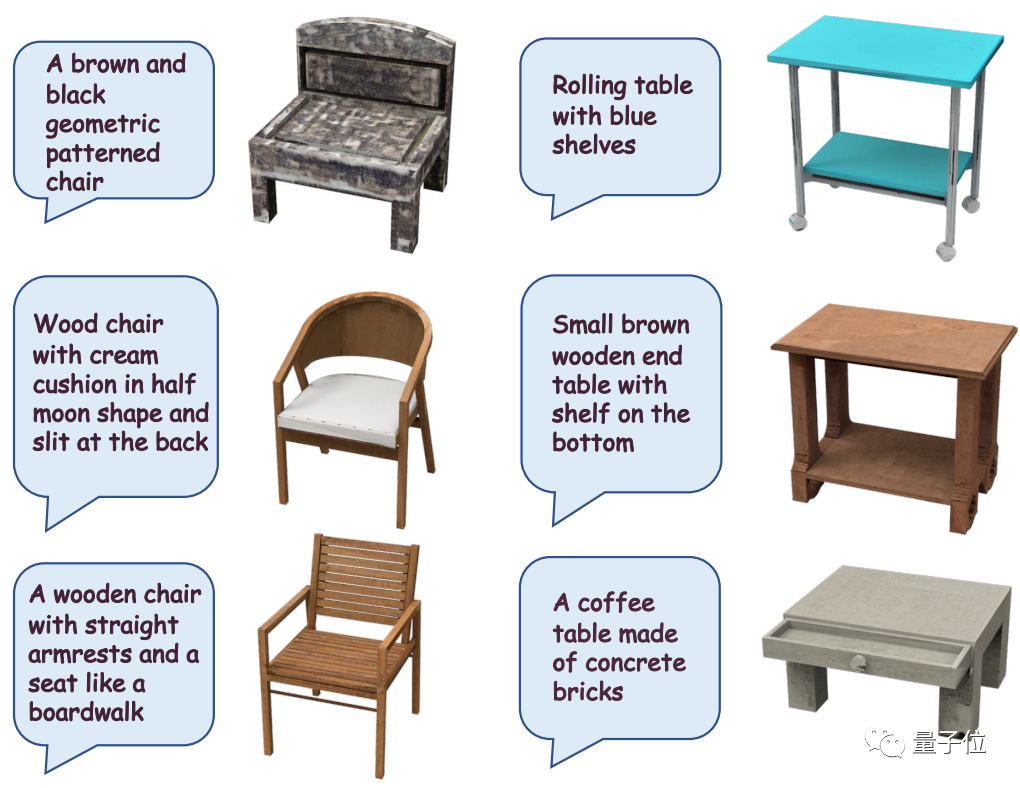

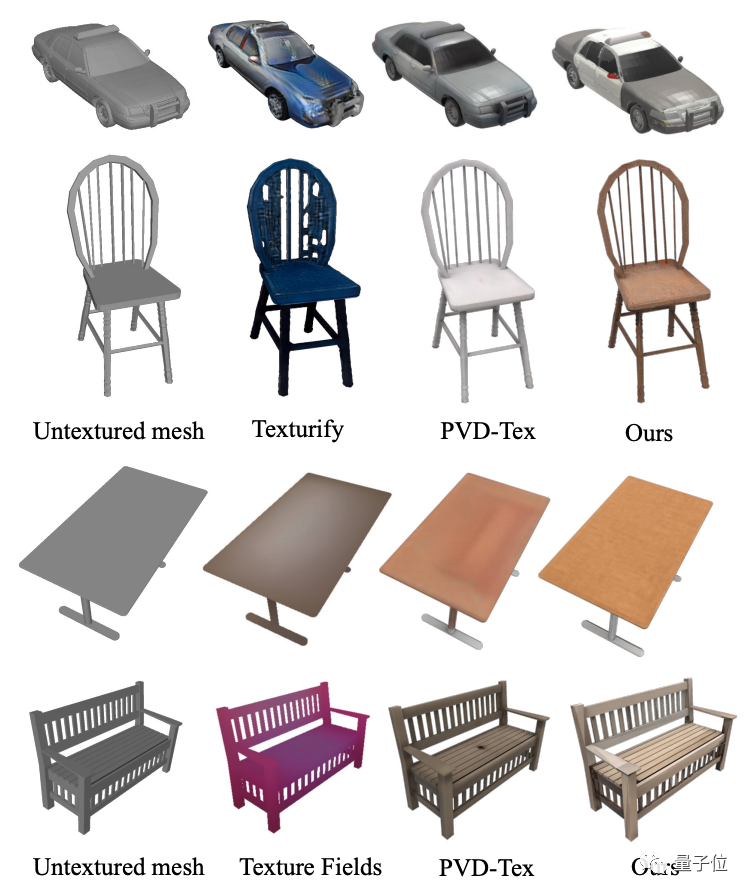

讓我們先來看看Point-UV擴散的生成效果

從效果圖中可以看出,除了桌椅,Point -UV擴散同樣可以產生汽車等物體的紋理,種類更加豐富

不僅能根據文字生成紋理:

透過觀察圖表,可以發現與Texture Fields、Texturify、PVD-Tex等其他紋理生成模型相比,Point-UV擴散在結構和精細度方面展現出更好的效果

作者也提到,同樣硬體配置下,相較於Text2Mesh需要10分鐘的計算,Point-UV diffusion只需要30秒。

######然而,作者也指出了Point-UV擴散目前存在的一些限制。例如,當UV貼圖中存在過多的「碎片化」部分時,它仍然無法實現無縫紋理效果。此外,由於依賴3D資料進行訓練,而目前3D資料的精細化品質和數量還無法達到2D資料的水平,因此產生的效果暫時無法達到2D影像產生的精細效果########## #####對於對這項研究有興趣的朋友們,你們可以點擊下方的連結來閱讀論文~##########論文網址:######https://cvmi- lab.github.io/Point-UV-Diffusion/paper/point_uv_diffusion.pdf############專案地址(還在施工中):#######https://github. com/CVMI-Lab/Point-UV-Diffusion#######以上是30秒內輕鬆完成3D模型紋理貼圖,簡單又有效率!的詳細內容。更多資訊請關注PHP中文網其他相關文章!