OpenAI似乎找到了解決生成式人工智慧「一本正經胡說八道」的辦法。

5月31日,OpenAI在其官網宣布,已經訓練了一個模型,能夠有助於消除生成式AI常見的「幻覺」和其他常見問題。

OpenAI表示,可以訓練獎勵模型來檢測幻覺,獎勵模型又分為結果監督(根據最終結果提供回饋)或過程監督(為思考鏈中的每個步驟提供回饋)模型。

也就是說,過程監督獎勵推理的每個正確步驟,而結果監督只是簡單地獎勵正確的答案。

OpenAI表示,相較之下,過程監督有一個重要的優勢——它直接訓練模型以產生由人類認可的思維鏈:

過程監督與結果監督相比有幾個一致性優勢。每個步驟都得到精確監督,因此它獎勵遵循一致思維鏈模型的行為。

過程監督也更有可能產生可解釋的推理,因為它鼓勵模型遵循人類批准的過程

結果監督可能會獎勵一個不一致的過程,而且通常更難審查。

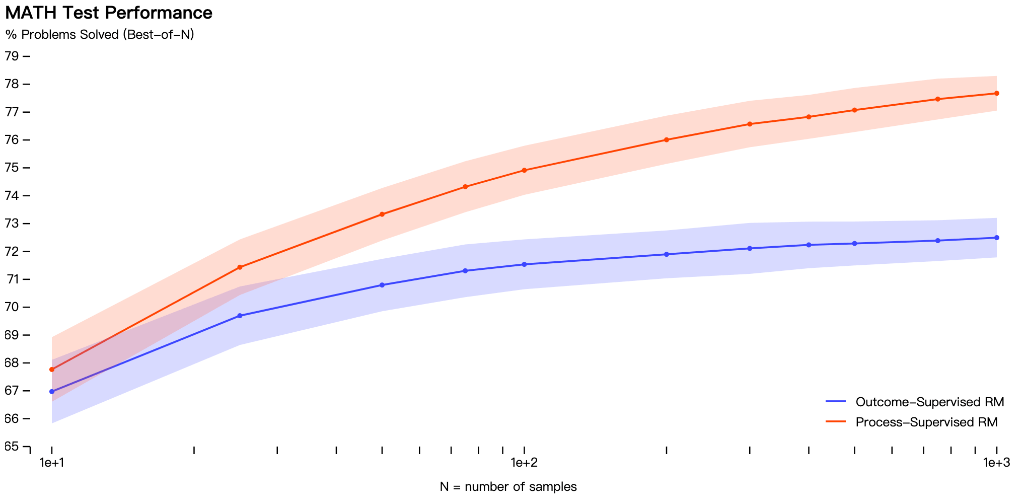

OpenAI在數學資料集上測試了這兩種模型,發現過程監督方法導致了「顯著更好的性能」。

但需要注意的是,到目前為止,過程監督方法僅在數學領域進行了測試,並且需要更多的工作來觀察它如何更普遍地執行。

此外,OpenAI並沒有說明這項研究需要多長時間才能應用在ChatGPT,它仍然處於研究階段。

雖然最初的結果是好的,但OpenAI確實提到,更安全的方法會產生降低的效能,稱為對齊稅(alignment tax)。

目前的結果顯示,在處理數學問題時,過程監督不會產生對齊稅,但在一般的資訊上的情況尚不知曉。

生成式AI的「幻覺」

生成式AI問世以來,圍繞其編造假訊息、「產生幻覺」的指控從未消失,這也是目前生成式AI模型最大的問題之一。

今年2月,Google為應對微軟資助下ChatGPT,倉促推出了聊天機器人Bard,結果卻被發現在演示中出現了常識性錯誤,導致谷歌股價大跌。

導致AI出現幻覺的原因有很多種,輸入資料欺騙AI程式進行錯誤分類是其中一種。

例如,開發人員使用資料(如圖像、文字或其他類型)來訓練人工智慧系統,如果資料被改變或扭曲,應用程式將以不同的方式解釋輸入並產生不正確的結果。

幻覺可能會出現在像ChatGPT這樣的基於語言的大型模型中,這是由於不正確的轉換器解碼,導致語言模型可能會產生一個沒有不合邏輯或模糊的故事或敘述。

以上是解決AI落地的最大障礙,OpenAI找到方法了?的詳細內容。更多資訊請關注PHP中文網其他相關文章!