毫無疑問,AIGC正在為人類社會帶來一場深刻的變革。

而剝離其令人眼花撩亂的華麗外表,運行的核心離不開海量的數據支持。

ChatGPT的「入侵」已經引起了各行各業對內容抄襲的擔憂,以及網路資料安全意識的提高。

雖然AI技術是中立的,但並不能成為規避責任與義務的理由。

最近,英國情報機構——英國政府通訊總部(GCHQ)警告稱,ChatGPT和其他人工智慧聊天機器人將是一個新的安全威脅。

儘管ChatGPT的概念出現沒有多久,但對網路安全和資料安全帶來威脅的問題已經成為業界關注的焦點。

對於目前還處於發展初期的ChatGPT,如此擔憂是否杞人憂天?

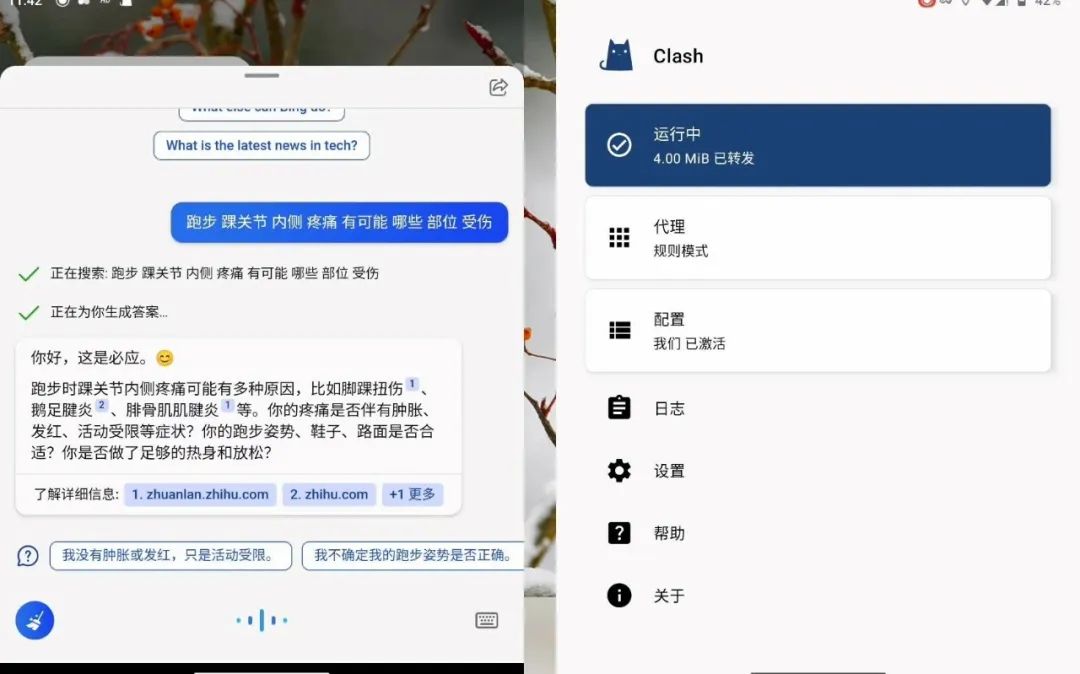

去年年底,新創公司OpenAI推出ChatGPT,之後,其投資商微軟於今年推出了基於ChatGPT技術開發的聊天機器人“必應聊天(Bing Chat)」。

由於這類軟體能夠提供酷似人類的對話,目前這項服務已風靡全球。

GCHQ的網路安全部門指出,提供AI聊天機器人的公司可以看到用戶輸入的查詢內容,就ChatGPT而言,其開發商OpenAI就能夠看到這些。

ChatGPT透過大量文字語料庫進行訓練,其深度學習能力很大程度上依賴背後的資料。

出於對資訊外洩的擔憂,目前已有多家公司和機構發布「ChatGPT禁令」。

倫敦金融城律師事務所Mishcon de Reya禁止其律師將客戶資料輸入ChatGPT,因為擔心在法律上享有隱私特權的資料可能會被洩露。

國際顧問公司埃森哲警告其全球70萬名員工,出於類似的原因,不要使用ChatGPT,因為擔心客戶的機密資料最終會落入他人之手。

英國電腦晶片公司Arm的母公司日本軟銀集團同樣警告其員工,不要向人工智慧聊天機器人輸入公司人員的身份資訊或機密資料。

今年2月,摩根大通成為第一家在工作場所限制使用ChatGPT的華爾街投入行動。

花旗集團和高盛集團緊跟在後,前者禁止員工在整個公司範圍內存取ChatGPT,後者則限制員工在交易大廳使用該產品。

而在更早些時候,亞馬遜和微軟為防備員工在使用ChatGPT的過程中洩密,禁止他們向其分享敏感數據,因為這些資訊可能會被用作進一步迭代的訓練資料。

事實上,這些人工智慧聊天機器人背後是大型語言模型(LLM),用戶的這些查詢內容將會被儲存起來,並且會在未來某個時候被用於開發LLM服務或模型。

這意味著,LLM提供者能夠讀取到相關查詢,並可能以某種方式將它們合併到未來的版本中。

儘管LLM運營商應該採取措施保護數據,但不能完全排除未經授權存取的可能性。因此,企業需要確保他們有嚴格的政策,提供技術性支持,來監控LLM的使用,以最大限度地降低資料暴露的風險。

另外,儘管ChatGPT本身尚不具備直接攻擊網路安全和資料安全的能力,但是由於它具有自然語言生成和理解的能力,可以被用於偽造虛假資訊、攻擊社交工程等方面。

此外,攻擊者還可以使用自然語言來讓ChatGPT產生對應的攻擊程式碼、惡意軟體程式碼、垃圾郵件等。

因此,AI可以讓那些原本沒有能力發動攻擊的人基於AI生成攻擊,並且大幅提高攻擊成功率。

在自動化、AI、「攻擊即服務」等技術和模式加持下,網路安全攻擊呈現暴漲趨勢。

在ChatGPT火熱之前,已經發生了多次駭客使用AI技術進行的網路攻擊。

事實上,人工智慧被用戶調教「帶偏節奏」的案例並不鮮見,6年前,微軟推出智慧聊天機器人Tay,上線時,Tay表現得彬彬有禮,但不到24小時,其就被不良用戶“帶壞”,出言不遜、髒話不斷,言語甚至涉及種族主義、色情、納粹,充滿歧視、仇恨和偏見,只好被下線結束了短暫的生命。

另一方面,距離使用者更近的風險是,使用者在使用ChatGPT等AI工具時,可能會不經意地將私密資料輸入到雲端模型,這些資料可能會成為訓練數據,也可能成為提供給他人答案的一部分,從而導致資料外洩和合規風險。

ChatGPT作為大語言模型,其核心邏輯事實上是海量資料的收集、加工、處理和運算結果的輸出。

總的來說,這幾個環節可能會在技術要素、組織管理、數位內容三個方面伴生相關風險。

雖然ChatGPT表示,儲存訓練和運行模型所需的資料會嚴格遵守隱私和安全政策,但未來可能出現網路攻擊和資料爬取等現象,仍有不可忽視的資料安全隱患。

特別是涉及國家核心資料、地方和產業重要資料以及個人隱私資料的抓取、處理以及合成使用等過程,需平衡資料安全保護與流動共享。

除了資料與隱私外洩隱患外,AI技術還存在著資料偏見、虛假資訊、模型的難解釋性等問題,可能會導致誤解和不信任。

風口已至,AIGC浪潮奔湧而來,在前景向好的大背景下,關口前移,建立資料安全防護牆也至關重要。

尤其是當AI技術逐漸完善,它既能成為生產力進步的強大抓手,又易淪為黑產犯罪的工具。

奇安信威脅情報中心監測數據顯示,2022年1月份-10月份,超過950億條的中國境內機構數據在海外被非法交易,其中有570多億條是個人資訊。

因此,如何確保資料儲存、運算、流通過程中的安全問題,是數位經濟發展的大前提。

從整體來看,應該堅持頂層設計與產業發展並進,在《網路安全法》的基礎上,要細化風險與責任分析體系,確立安全問責機制。

同時,監理機關可進行常態化監查工作,安全領域企業協同發力,建構全流程資料安全保障體系。

對於資料合規和資料安全的問題,特別是在《資料安全法》推出後,資料隱私越來越重要。

如果在應用AI技術的過程中無法保證資料安全和合規,可能會對企業造成很大風險。

特別是中小企業對資料隱私安全的知識比較匱乏,不知道如何保護資料不會受到安全威脅。

資料安全合規並不是某個部門的事情,而是整個企業最為重要的事情。

企業要對員工進行培訓,讓他們意識到每個使用數據的人,都有義務保護數據,包括IT人員、AI部門、數據工程師、開發人員、使用報表的人等,人和技術要結合在一起。

面對前述潛藏風險,監管方和相關企業如何從制度和技術層面加強AIGC領域的資料安全保護?

相較於直接針對用戶終端採取限制使用等監管措施,明確要求AI技術研發企業遵循科技倫理原則會更具成效,因為這些企業能夠在技術層面限定用戶的使用範圍。

在製度層面,需要結合AIGC底層技術所需資料的特性和作用,建立健全資料分類分級保護制度。

例如,可依據資料主體、資料處理程度、資料權利屬性等面向對訓練資料集中的資料進行分類管理,根據資料對資料權利主體的價值,以及資料一旦遭到竄改、破壞等對資料主體的危害程度進行分級。

在資料分類分級的基礎上,建立與資料類型和安全性等級相符的資料保護標準與共享機制。

目光投向企業,還需加快推動「隱私運算」技術在AIGC領域的應用。

這類技術能夠讓多個資料擁有者在不暴露資料本身的前提下,透過共享SDK或開放SDK權限的方式,在進行資料的共享、互通、計算、建模,在確保AIGC能夠正常提供服務的同時,保證資料不會外洩給其他參與者。

此外,全流程合規管理的重要性癒加凸顯。

企業首先應關注其所運用的資料資源是否符合法律法規要求,其次要確保演算法和模型運作的全流程合規,企業的創新研發也應最大限度地滿足社會公眾的倫理期待。

同時,企業應制定內部管理規範,設立相關的監督部門,對AI技術應用場景的各個環節進行資料監督,確保資料來源合法、處理合法、輸出合法,從而保障自身的合規性。

AI應用程式的關鍵在於部署方式與成本間的考量,但必須注意的是,如果沒有做好安全合規、隱私保護,對企業來說或將蘊含“更大風險點」。

AI是把雙面刃,用得好讓企業如虎添翼;用不好疏忽了安全、隱私和合規,會給企業帶來更大損失。

因此,在AI應用前,需要建構更穩固的“資料底座”,正所謂,行穩方能致遠。

以上是ChatGPT應用爆火,安全的大數據底座何處尋?的詳細內容。更多資訊請關注PHP中文網其他相關文章!