你是否擔心人工智慧發展太快,可能會產生負面後果?你希望有一部國家法律來規範它嗎?如今,沒有新的法律來限制人工智慧的使用,通常自我監管成為採用人工智慧的公司的最佳選擇——至少目前是這樣。

儘管「人工智慧」取代「大數據」成為科技界最受歡迎流行詞彙已經很多年了,但2022年11月下旬ChatGPT的推出開啟了一場人工智慧淘金熱,這讓包括我們在內的許多人工智慧觀察者感到驚訝。在短短幾個月內,大量強大的生成人工智慧模型吸引了世界的注意力,這要歸功於它們模仿人類語言和理解的非凡能力。

在ChatGPT的出現的推動下,主流文化中生成模型的非凡崛起引發了許多關於這一切走向的問題。人工智慧能夠產生令人信服的詩歌和異想天開的藝術,這一令人驚訝的現象正在讓位給對人工智慧負面後果的擔憂,從消費者傷害和失業,一直到虛假監禁,甚至毀滅人類。

這讓一些人非常擔心。上個月,一個人工智慧研究人員聯盟尋求暫停開發比GPT-4更大的新生成模型六個月(延展閱讀:公開信敦促暫停人工智慧研究),GPT-4是OpenAI上個月推出的大規模語言模型(LLM)。

圖靈獎得主Yoshua Bengio和OpenAI聯合創始人Elon Musk等人簽署的一封公開信表示:「先進的人工智慧可能代表著地球生命史的深刻變化,應該以相應的謹慎和資源進行規劃和管理。」「不幸的是,這種程度的規劃和管理並沒有實現。」

##毫不奇怪,對人工智慧監管的呼聲正在上升。民調顯示,美國人認為人工智慧不可信,希望對其進行監管,尤其是在自動駕駛汽車和獲得政府福利等有影響力的事情上。

然而,儘管有幾項針對人工智慧的新地方法律——例如紐約市的一項法律,該法律側重於在招聘中使用人工智慧,執法工作被推遲到本月——國會沒有專門針對接近終點線的人工智慧的新聯邦法規(儘管人工智慧已涉足金融服務和醫療保健等高度監管行業的法律範疇)。

在人工智慧的刺激下,一家公司該做什麼?公司想要分享人工智慧的好處並不令人意外。畢竟,成為「數據驅動」的衝動被視為數位時代生存的必要條件。然而,公司也希望避免使用人工智慧不當可能導致的負面後果,無論是真實的還是感知的。

人工智慧是狂野的「西方世界」。人工智慧律師事務所BNH.AI的創辦人Andrew Burt曾說過,「沒有人知道如何管理風險。每個人都有不同的做法。」

話雖如此,公司可以使用幾個框架來幫助管理人工智慧的風險。 Burt建議使用人工智慧風險管理框架(RMF: Risk Management Framework),該框架來自美國國家標準研究所(NIST),並於今年稍早定稿。

RMF幫助公司思考他們的人工智慧是如何運作的,以及可能產生的潛在負面後果。它使用「地圖、測量、管理和治理」的方法來理解並最終降低在各種服務產品中使用人工智慧的風險。

另一個人工智慧風險管理架構來自O'Neil風險諮詢與演算法審計(ORCAA)執行長Cathy O'Neil。 ORCAA提出了一個名為「可解釋的公平」的框架。

可解釋的公平性為組織提供了一種方法,不僅可以測試他們的演算法是否存在偏見,還可以研究當檢測到結果差異時會發生什麼。例如,如果一家銀行正在確定是否有資格獲得學生貸款,那麼哪些因素可以合法地用於批准或拒絕貸款或收取更高或更低的利息?

顯然,銀行必須使用數據來回答這些問題。但是,他們可以使用哪些數據,也就是說,哪些因素反映了貸款申請人?哪些因素在法律上應該被允許使用,哪些因素不該被使用? O'Neil說,回答這些問題既不容易也不簡單。

O'Neil在上個月舉行的Nvidia GPU技術會議(GTC)上的一次討論中表示:「這就是這個框架的全部意義,即這些合法因素必須合法化。」

數據分析和人工智慧軟體供應商Dataiku人工智慧的負責人Triveni Gandhi表示,即使沒有新的人工智慧法律,公司也應該開始自問如何公平、合乎道德地實施人工智慧,以遵守現有法律。

「人們必須開始思考,好吧,我們如何看待現有的法律,並將其應用於目前存在的人工智慧用例?」「有一些規定,但也有很多人在思考我們想要建構人工智慧的道德和價值導向方式。這些其實是公司開始問自己的問題,即使沒有總體規定。」

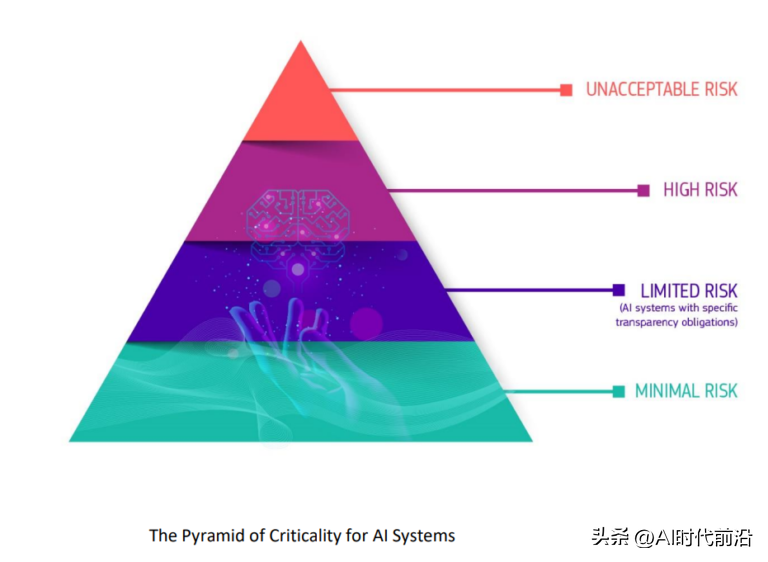

################# #######歐盟將人工智慧的潛在危害歸類為「臨界金字塔」###############歐盟已經在推動自己的法規,即《人工智慧法案》 ,該法案可能在今年稍後生效。 ############《人工智慧法案》將為影響歐盟居民的人工智慧的使用創建一個共同的監管和法律框架,包括人工智慧的開發方式、公司可以將其用於什麼目的,以及不遵守要求的法律後果。該法律可能會要求公司在某些用例中採用人工智慧之前獲得批准,並禁止某些被認為風險太大的其他人工智慧用途。 ######

以上是現在自我調節是人工智慧的控制標準的詳細內容。更多資訊請關注PHP中文網其他相關文章!