在文字轉圖像上捲了大半年之後,Meta、Google等科技巨頭又將目光投向了一個新的戰場:文字轉影片。

上週,Meta 公佈了一個能夠產生高品質短影片的工具——Make-A-Video,利用這款工具產生的影片非常具有想像。

當然,Google也不甘示弱。剛剛,該公司 CEO Sundar Pichai 親自安麗了他們在這一領域的最新成果:兩款文本轉視頻工具——Imagen Video 與 Phenaki。前者主打影片品質,後者主要挑戰影片長度,可以說各有千秋。

下面這個洗碗的泰迪熊就是用Imagen Video 產生的,可以看到,畫面的解析度和連貫性都有一定的保障。

生成建模在最近的文字到圖像AI 系統中取得了重大進展,例如DALL-E 2、Imagen、Parti、CogView 和Latent Diffusion。特別地,擴散模型在密度估計、文字轉語音、圖像到圖像、文字轉圖像和 3D 合成等多種生成式建模任務中取得了巨大成功。

Google想要做的是從文字產生影片。以往的影片產生工作集中在具有自迴歸模型的受限資料集、具有自迴歸先驗的潛變數模型以及近來的非自迴歸潛變量方法。擴散模型也已經展示出了出色的中等解析度視訊生成能力。

在此基礎上,Google推出了 Imagen Video,它是一個基於級聯視訊擴散模型的文字條件視訊生成系統。給予文字提示,Imagen Video 就可以透過一個由 frozen T5 文字編碼器、基礎視訊生成模型、級聯時空視訊超解析度模型組成的系統來產生高清視訊。

論文網址:https://imagen.research.google/video/paper.pdf

在論文中,Google詳細描述如何將該系統擴展為一個高清文本轉視頻模型,包括某些分辨率下選擇全卷積時空超分辨率模型以及選擇擴散模型的v 參數化等設計決策。谷歌也將以往基於擴散的影像生成研究成果成功地遷移到了視訊生成設定。

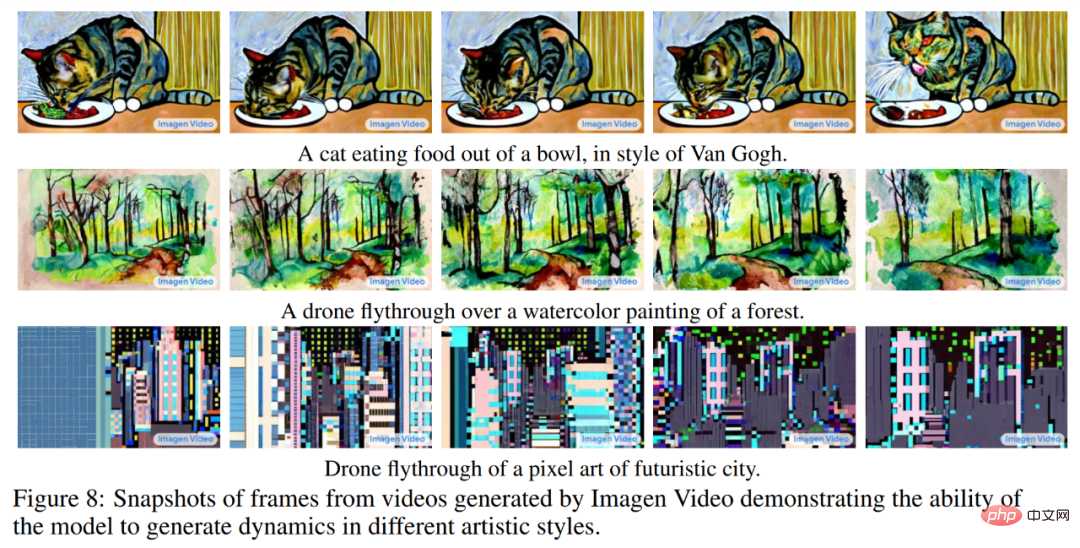

Google發現,Imagen Video 能夠將以往工作產生的 24fps 64 幀 128×128 影片提升至 128 幀 1280×768 高畫質影片。此外,Imagen Video 還具有高度的可控性和世界知識,能夠生成多樣化藝術風格的影片和文字動畫,還具備了 3D 物件理解能力。

讓我們再來欣賞一些Imagen Video 生成的視頻,例如開車的熊貓:

遨遊太空的木船:

更多生成影片請參閱:https://imagen.research.google/video/

方法與實驗

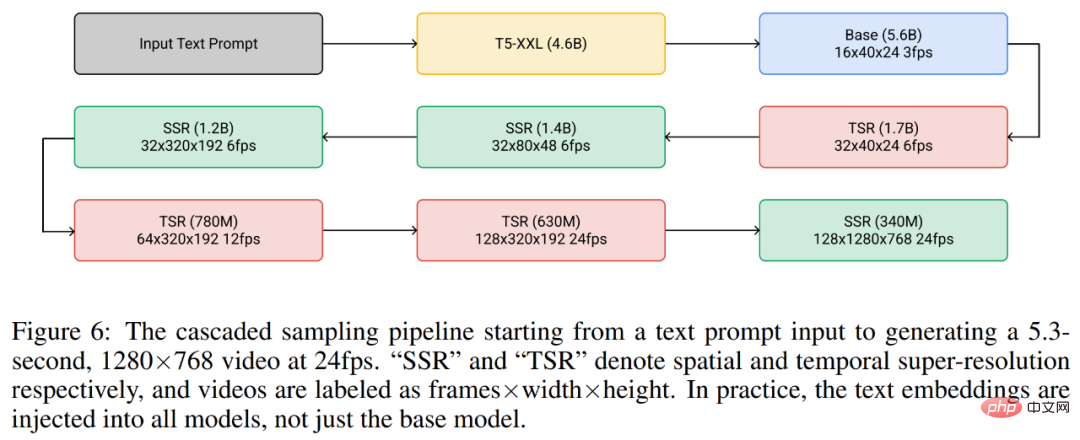

#整體而言,Google的視訊生成框架是七個子視訊擴散模型的級聯,它們相應地執行文字條件視訊生成、空間超解析度和時間超解析度。借助整個級聯,Imagen Video 能夠以每秒 24 幀的速度生成 128 幀 1280×768 的高清視訊(約 1.26 億像素)。

同時,在漸進式蒸餾的幫助下,Imagen Video 的每個子模型中僅使用八個擴散步驟就能產生高品質視訊。這將影片生成時間加快了大約 18 倍。

下圖6 展示了Imagen Video 的整個級聯pipeline,包括1 個frozen 文字編碼器、1 個基礎視訊擴散模型以及3 個空間超解析度(SSR)和3 個時間超解析度(TSR)模型。這七個視訊擴散模型共有 116 億參數。

在生成過程中,SSR 模型提高了所有輸入幀的空間分辨率,同時 TSR 模型透過在輸入幀之間填充中間幀來提高時間分辨率。所有模型同時產生一個完整的幀塊,這樣 SSR 模型就不會遭受明顯的偽影。

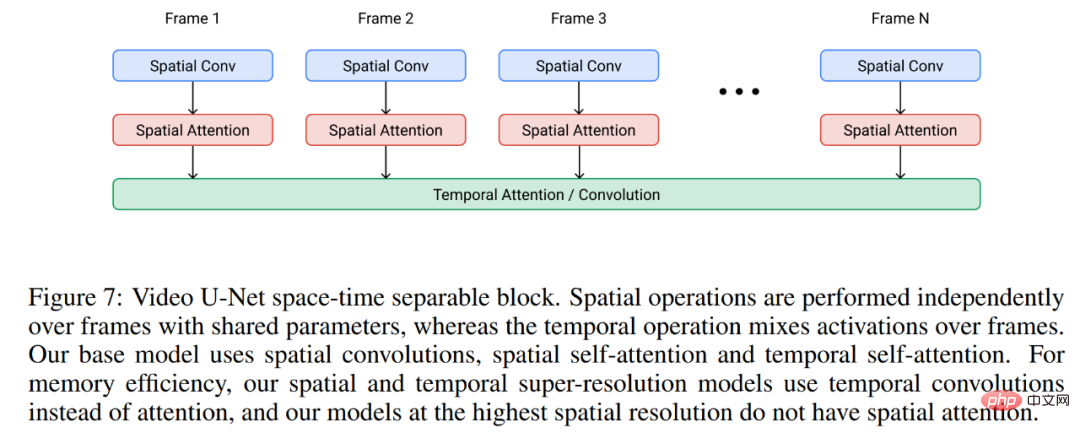

Imagen Video 建構在影片 U-Net 架構之上,如下圖 7 所示。

在實驗中,Imagen Video 在公開可用的LAION-400M 圖像文字資料集、1400 萬個視訊文字對和6000 萬個圖像文本對上進行訓練。結果如上文所述,Imagen Video 不僅能夠生成高清視頻,還具備一些純粹從資料中學習的非結構化生成模型所沒有的獨特功能。

下圖 8 展示了 Imagen Video 能夠生成具有從圖像訊息中學得的藝術風格的視頻,例如梵高繪畫風格或水彩畫風格的視頻。

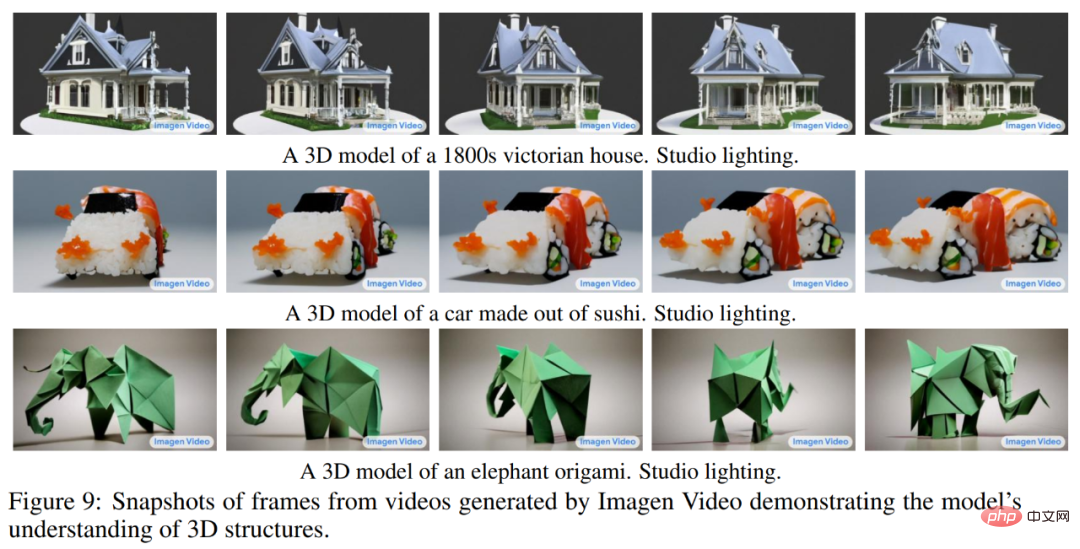

下圖9 展示了Imagen Video 對3D 結構的理解能力,它能夠產生旋轉物件的視頻,同時物體的大致結構也能保留。

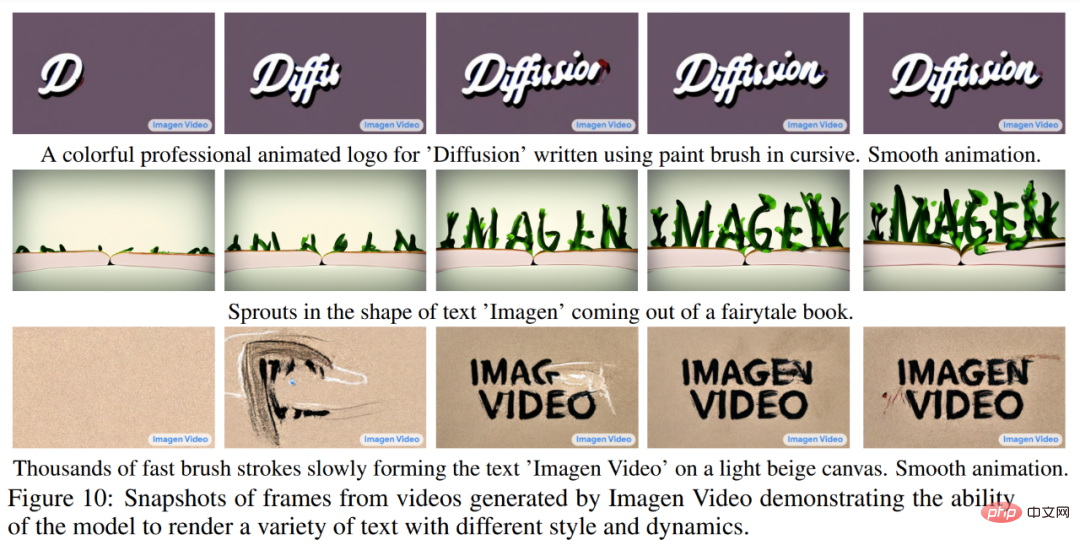

下圖 10 展示了 Imagen Video 能夠可靠地生成各種動畫樣式的文本,其中一些使用傳統工具很難來製作。

更多實驗細節請參考原文。

我們知道,雖然從本質上講,影片就是一系列圖像,但生成一個連貫的長影片並沒有那麼容易,因為在這項任務中,可用的高品質資料非常少,而且任務本身的運算需求又很大。

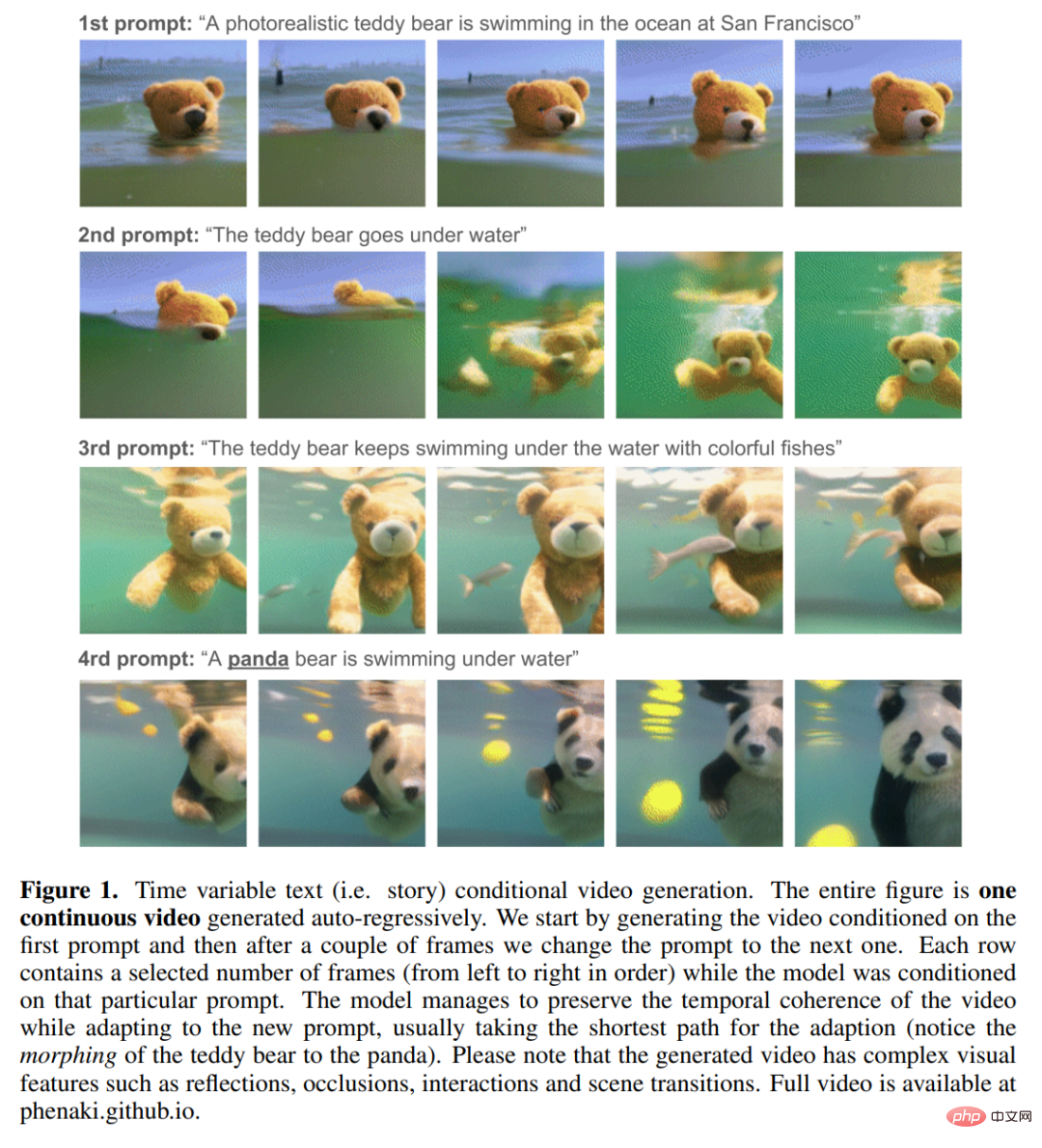

更麻煩的是,像之前那種用於圖像生成的簡短文字 prompt 通常不足以提供對影片的完整描述,影片需要的是一系列 prompt 或故事。理想情況下,一個視頻生成模型必須能夠生成任意長度的視頻,並且要能根據某個時刻 t 的 prompt 變化調節生成的視頻幀。只有具備這樣的能力,模型生成的作品才能稱之為“視頻”,而不是“移動的圖像”,並開啟在藝術、設計和內容創作方面的現實創意應用之路。

Google等機構的研究人員表示,「據我們所知,基於故事的條件影片生成之前從未被探索過,這是第一篇朝著該目標邁進的早期論文。”

#專案連結:https://phenaki.github.io/#interactive

#由於沒有基於故事的資料集可以拿來學習,研究人員沒有辦法簡單地依靠傳統深度學習方法(簡單地從資料中學習)來完成這些任務。因此,他們專門設計了一個模型來完成這項任務。

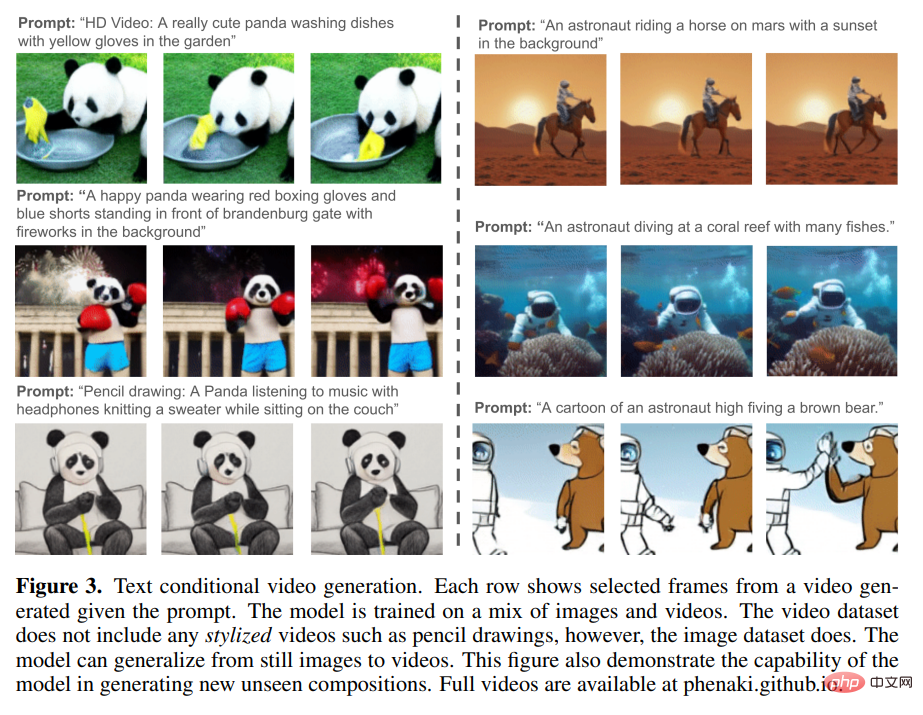

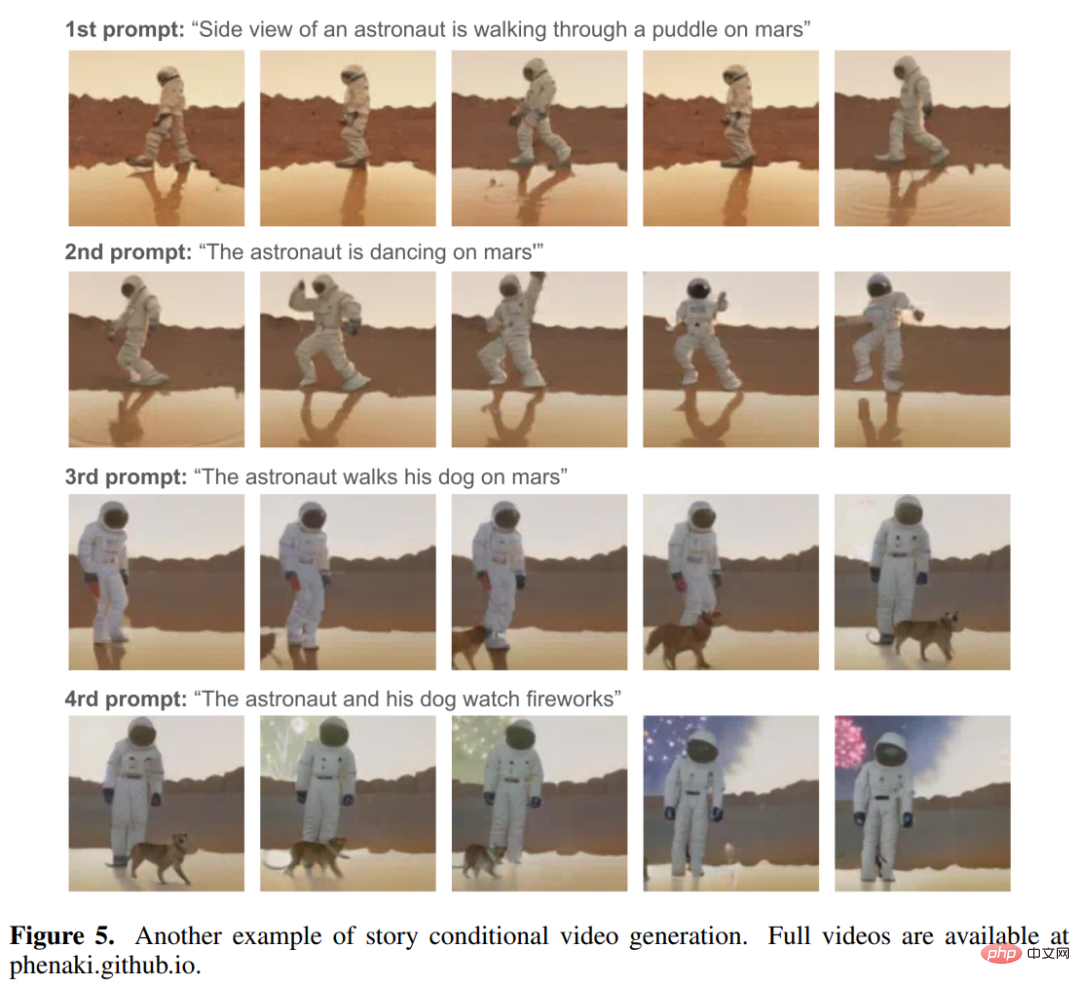

這個新的文字轉視訊模型名為 Phenaki,它使用了「文字轉影片」和「文字轉影像」資料聯合訓練。該模型具有以下能力:

#從以下動圖中我們可以看到Phenaki 產生影片的連貫性和多樣性:

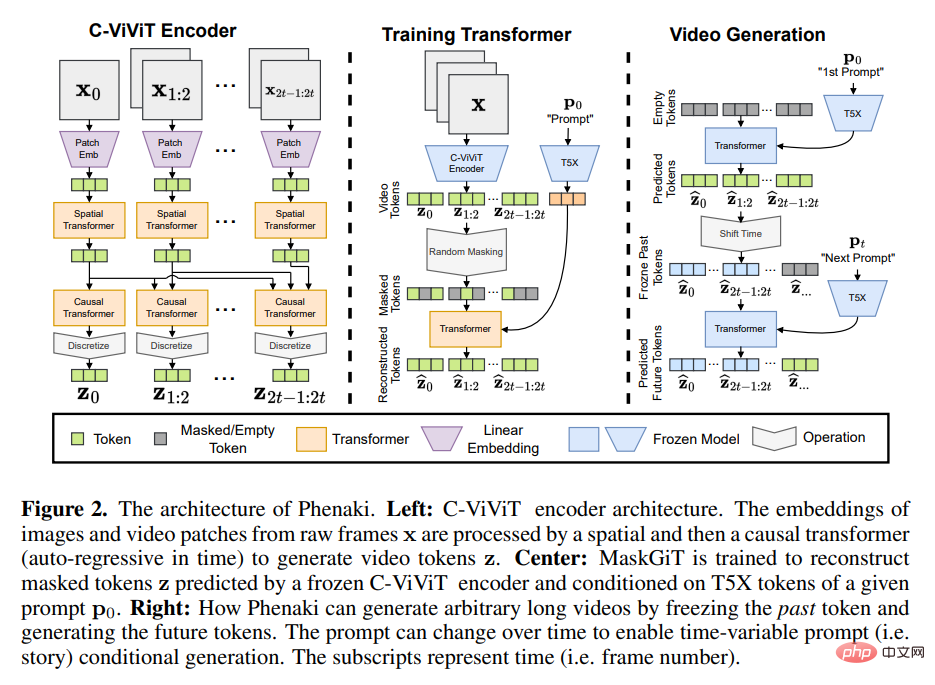

###要實現這些功能,研究人員無法依賴現有的視頻編碼器,因為這些編碼器要么只能解碼固定大小的視頻,要么獨立編碼幀。為了解決這個問題,他們引入了一個新的編碼器 - 解碼器架構——C-ViViT。 ############C-ViViT 可以:################利用影片中的時間冗餘來提高每個畫面模型的重構質量,同時將視訊token 的數量壓縮40% 或更多;############在給定因果結構的情況下,允許編碼和解碼可變長度視訊。 ##################PHENAKI 模型架構################受先前自回歸文字轉圖像、文字轉影片研究的啟發,Phenaki 的設計主要包含兩大部分(見下圖2):一個將視訊壓縮為離散嵌入(即token)的編碼器- 解碼器模型和一個將文字嵌入轉換為視訊token 的transformer 模型。 #####################取得影片的壓縮表示法是從文字產生影片的主要挑戰之一。先前的工作要么使用 per-frame 圖像編碼器,如 VQ-GAN,要么使用固定長度視訊編碼器,如 V ideoVQVAE。前者允許生成任意長度的視頻,但在實際使用中,視頻必須要短,因為編碼器不能及時壓縮視頻,並且 token 在連續幀中是高度冗餘的。後者在 token 數量上更加高效,但它不允許生成任意長度的影片。 ######

在 Phenaki 中,研究者的目標是產生可變長度的視頻,同時盡可能壓縮視頻 token 的數量,這樣就可以在當前的計算資源限制下使用 Transformer 模型。為此,他們引入了 C-ViViT,這是 ViViT 的一種因果變體,為視頻生成進行了額外的架構更改,它可以在時間和空間維度上壓縮視頻,同時保持時間上的自回歸。此功能允許產生任意長度的自回歸影片。

為了得到文字嵌入,Phenaki 也用到了一個預先訓練的語言模型-T5X。

具體細節請參考原文。

以上是圖片生成捲膩了,Google全面轉向文字→視訊生成,兩大利器同時挑戰解析度和長度的詳細內容。更多資訊請關注PHP中文網其他相關文章!