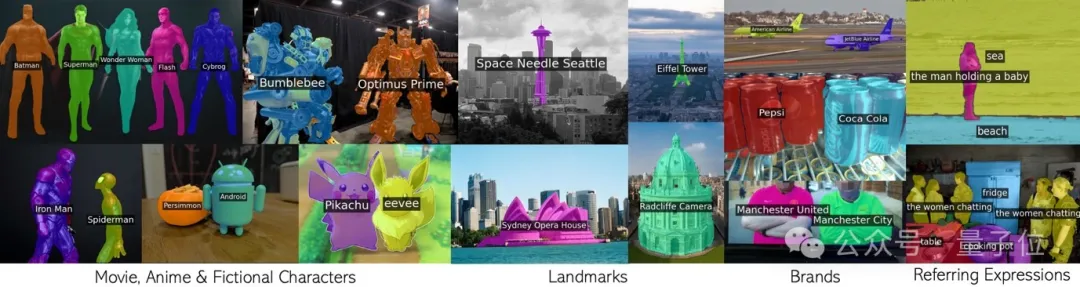

循環呼叫CLIP,無需額外訓練就有效分割無數概念。

包括電影動漫人物,地標,品牌,和普通類別在內的任意短語。

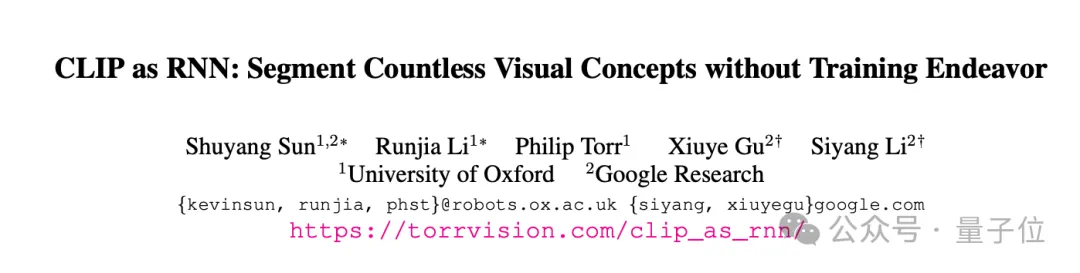

牛津大學與Google研究院聯合團隊的這項新成果,已被CVPR 2024接收,並開源了程式碼。

團隊提出名為CLIP as RNN(簡稱CaR)的新技術,解決了開放詞彙量圖像分割領域中的幾個關鍵問題:

要理解CaR的原理,需要先回顧一下循環神經網路RNN。

RNN引入了隱藏狀態(hidden state)的概念,就像是一個“記憶體”,儲存了過去時間步的資訊。而每個時間步共享同一組權重,可以很好地建模序列資料。

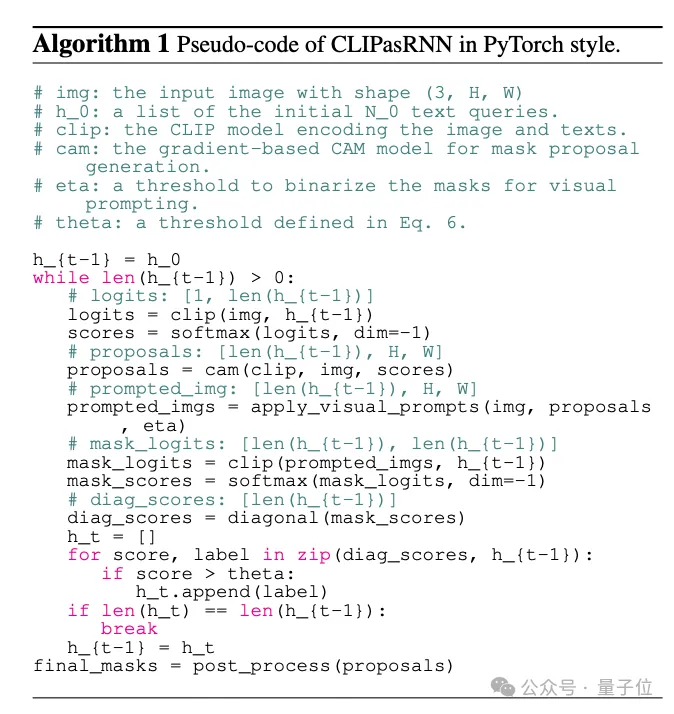

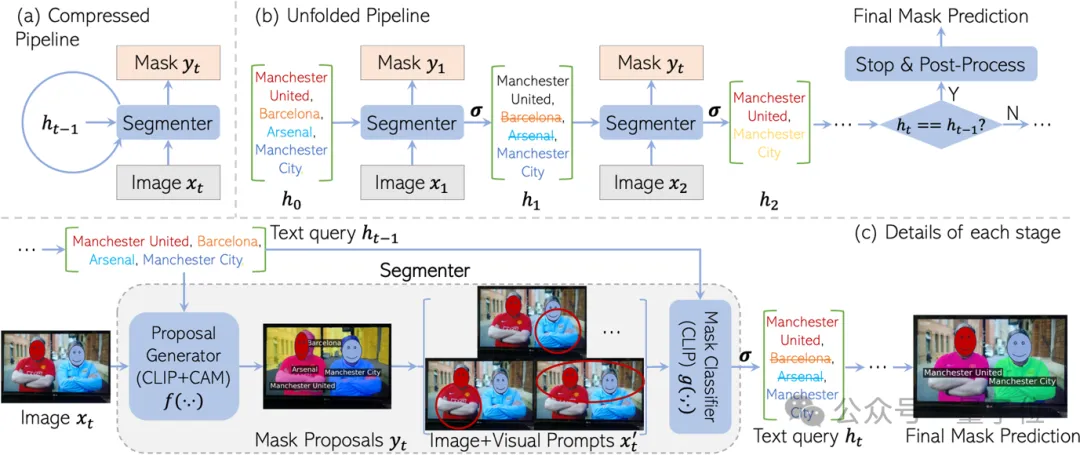

受RNN啟發,CaR也設計成循環的框架,由兩部分組成:

就這樣反覆迭代下去,文字查詢會越來越精準,mask的品質也會越來越高。

最後當查詢集合不再變化,就可以輸出最終的分割結果了。

之所以要設計這個遞歸框架,是為了最大限度地保留CLIP預訓練的」知識」。

CLIP預訓練中見過的概念可是海量,涵蓋了從名人、地標到動漫角色等方方面面。如果在分割資料集上微調,詞彙量勢必會大幅縮水。

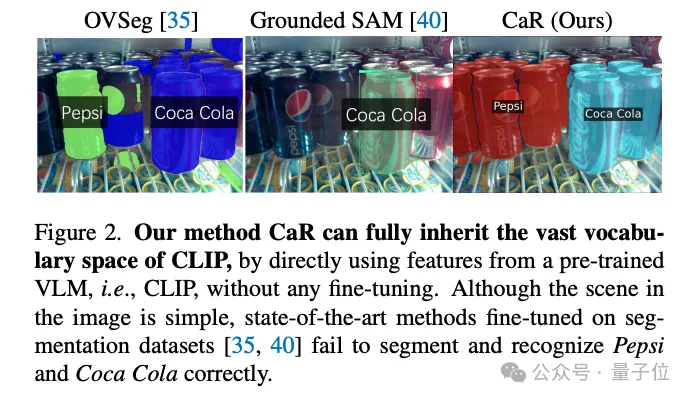

例如「分割一切」SAM模型就只能認出一瓶可口可樂,百事可樂是一瓶也不認了。

但直接拿CLIP做分割,效果又不盡人意。

這是因為CLIP的預訓練目標本來就不是為密集預測設計的。尤其是當圖像中不存在某些文字查詢時,CLIP很容易產生一些錯誤的mask。

CaR巧妙地透過RNN式的迭代來解決這個問題。透過反覆評估、篩選查詢,同時完善mask,最終實現了高品質的開放詞彙分割。

最後再來跟隨團隊的解讀,了解CaR框架的細節。

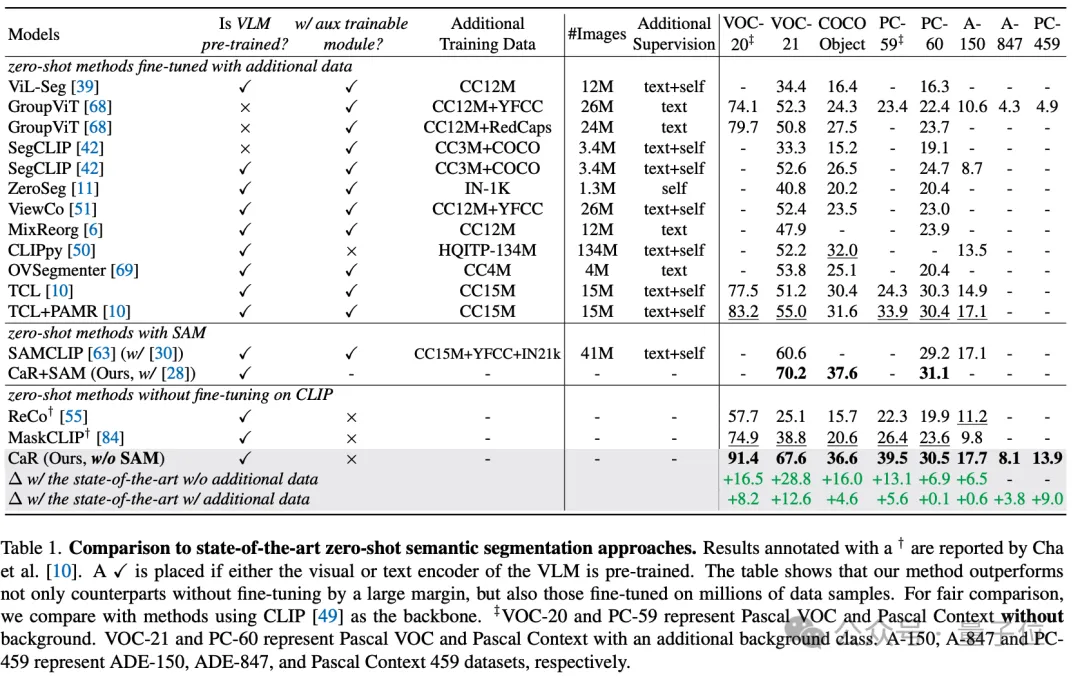

通过这些技术手段,CaR技术在多个标准数据集上实现了显著的性能提升,超越了传统的零样本学习方法,并在与进行了大量数据微调的模型相比时也展现出了竞争力。如下表所示,尽管完全无需额外训练及微调,CaR在零样本语义分割的8个不同指标上表现出比之前在额外数据上进行微调过的方法更强的性能。

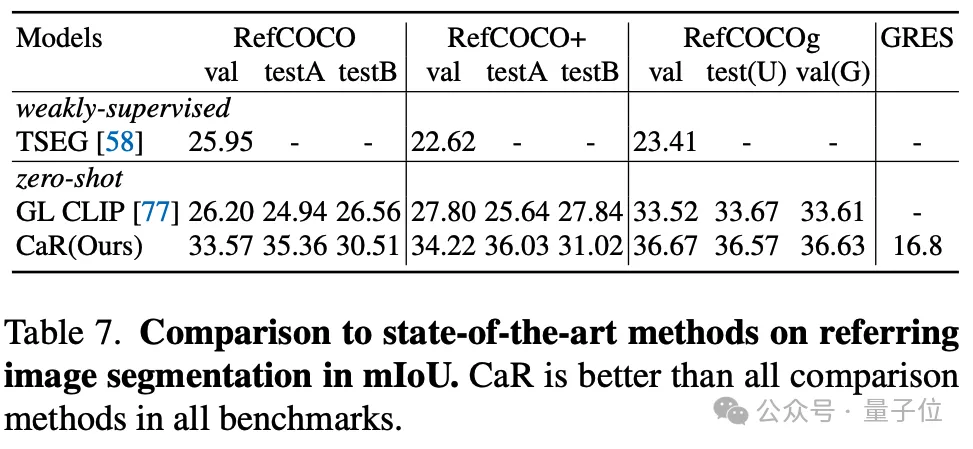

作者还测试了CaR在零样本Refering segmentation的效果,CaR也表现出了相较之前零样本的方法表现出更强的性能。

综上所述,CaR(CLIP as RNN)是一种创新的循环神经网络框架,能够在无需额外训练数据的情况下,有效地进行零样本语义和指代图像分割任务。它通过保留预训练视觉-语言模型的广泛词汇空间,并利用迭代过程不断优化文本查询与掩膜提议的对齐度,显著提升了分割质量。

CaR的优势在于其无需微调、处理复杂文本查询的能力和对视频领域的扩展性,为开放词汇量图像分割领域带来了突破性进展。

论文链接:https://arxiv.org/abs/2312.07661。

项目主页:https://torrvision.com/clip_as_rnn/。

以上是CLIP當RNN用入選CVPR:無需訓練即可分割無數概念|牛津大學&Google研究院的詳細內容。更多資訊請關注PHP中文網其他相關文章!