Jumlah kandungan berkaitan 10000

Latih model YOLOv7 dan bangunkan pengesanan kebakaran AI

Pengenalan Artikel:1. Sediakan set data Set data menggunakan imej sumber terbuka, dengan jumlah imej kebakaran 6k, ditandai dengan asap dan api. Projek Fire and Smoke menggunakan YOLO untuk latihan Saya telah menukar data ke dalam format YOLO dan membahagikannya kepada set latihan dan set pengesahan. Lihat direktori set data. 2. Untuk latihan, sila rujuk dokumentasi laman web rasmi YOLOv7 untuk proses latihan. Ubah suai fail data/coco.yaml dan konfigurasikan laluan dan kategori data latihan. Muat turun model pra-latihan yolov7.pt, dan kemudian anda boleh memulakan latihan 3. Selepas latihan pemantauan kebakaran selesai, cari fail model-best.pt yang dijana dalam direktori run di bawah direktori yolov7. saya berlatih

2023-05-11

komen 0

982

CMU bergabung tenaga dengan Adobe: Model GAN menyambut era pra-latihan, hanya memerlukan 1% sampel latihan

Pengenalan Artikel:Selepas memasuki era pra-latihan, prestasi model pengecaman visual telah berkembang pesat, tetapi model penjanaan imej, seperti rangkaian musuh generatif (GAN), nampaknya telah ketinggalan. Biasanya latihan GAN dilakukan dari awal tanpa pengawasan, yang memakan masa dan memerlukan tenaga kerja "ilmu" yang dipelajari melalui data besar dalam pra-latihan berskala besar tidak digunakan. Selain itu, penjanaan imej itu sendiri perlu dapat menangkap dan mensimulasikan data statistik yang kompleks dalam fenomena visual dunia sebenar Jika tidak, imej yang dihasilkan tidak akan mematuhi undang-undang dunia fizikal dan akan dikenal pasti secara langsung sebagai "palsu" pada sesuatu. sepintas lalu. Model pra-latihan memberikan pengetahuan, dan model GAN menyediakan keupayaan penjanaan Gabungan kedua-duanya boleh menjadi perkara yang indah! Persoalannya, model pra-latihan manakah dan cara menggabungkannya boleh meningkatkan keupayaan penjanaan model GAN

2023-05-11

komen 0

1456

Penjelasan terperinci tentang model pra-latihan pembelajaran mendalam dalam Python

Pengenalan Artikel:Dengan perkembangan kecerdasan buatan dan pembelajaran mendalam, model pra-latihan telah menjadi teknologi popular dalam pemprosesan bahasa semula jadi (NLP), penglihatan komputer (CV), pengecaman pertuturan dan bidang lain. Sebagai salah satu bahasa pengaturcaraan yang paling popular pada masa ini, Python secara semula jadi memainkan peranan penting dalam penerapan model pra-latihan. Artikel ini akan menumpukan pada model pra-latihan pembelajaran mendalam dalam Python, termasuk definisi, jenis, aplikasi dan cara menggunakan model pra-latihan. Apakah model pralatihan? Kesukaran utama model pembelajaran mendalam adalah untuk menganalisis sejumlah besar model yang berkualiti tinggi

2023-06-11

komen 0

1996

Bagaimanakah rangka kerja Java mempercepatkan latihan model kecerdasan buatan?

Pengenalan Artikel:Rangka kerja Java boleh mempercepatkan latihan model kecerdasan buatan dengan: menggunakan TensorFlowServing untuk menggunakan model pra-latihan untuk inferens pantas menggunakan H2OAI DriverlessAI untuk mengautomasikan proses latihan dan menggunakan pengkomputeran teragih untuk memendekkan masa latihan menggunakan SparkMLlib untuk melaksanakan latihan teragih dan berskala besar; data pada pemprosesan Set seni bina Apache Spark.

2024-06-04

komen 0

894

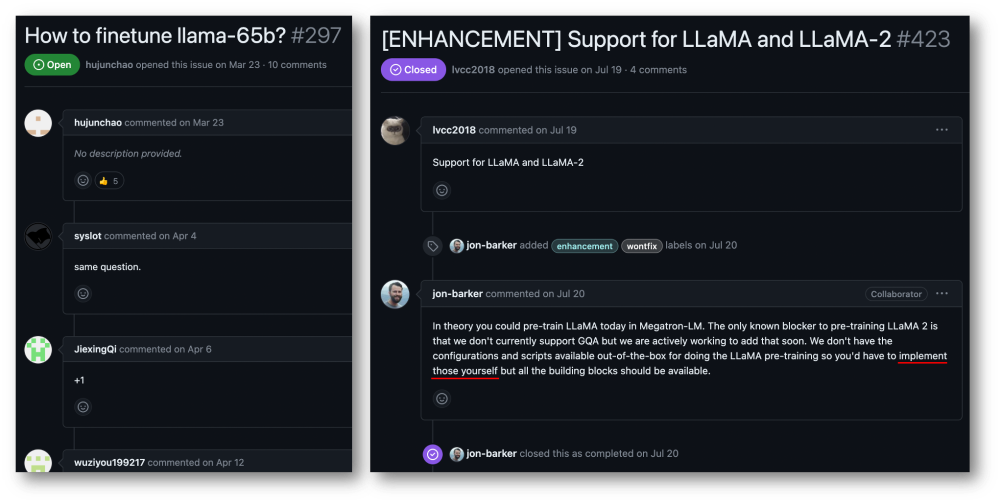

32-kad 176% pecutan latihan, rangka kerja latihan model besar sumber terbuka Megatron-LLaMA ada di sini

Pengenalan Artikel:Kumpulan Taotian dan Teknologi Aicheng secara rasmi mengeluarkan rangka kerja latihan model besar sumber terbuka - Megatron-LLaMA pada 12 September. Matlamat rangka kerja ini adalah untuk memudahkan pembangun teknologi meningkatkan prestasi latihan model bahasa besar, mengurangkan kos latihan dan mengekalkan keserasian dengan komuniti LLaMA. Keputusan ujian menunjukkan bahawa pada latihan 32-kad, Megatron-LLaMA boleh mencapai pecutan 176% berbanding dengan versi kod yang diperoleh secara langsung pada HuggingFace pada latihan berskala besar, Megatron-LLaMA berkembang hampir secara linear dan tidak stabil kepada rangkaian tahap toleransi yang tinggi. Pada masa ini, Megatron-LLaMA telah dilancarkan dalam komuniti sumber terbuka di alamat sumber terbuka: https:

2023-09-14

komen 0

627

Kesan kekurangan data terhadap latihan model

Pengenalan Artikel:Kesan kekurangan data pada latihan model memerlukan contoh kod khusus Dalam bidang pembelajaran mesin dan kecerdasan buatan, data ialah salah satu elemen teras untuk model latihan. Walau bagaimanapun, masalah yang sering kita hadapi dalam realiti adalah kekurangan data. Kekurangan data merujuk kepada jumlah data latihan yang tidak mencukupi atau kekurangan data beranotasi Dalam kes ini, ia akan memberi kesan tertentu pada latihan model. Masalah kekurangan data terutamanya dicerminkan dalam aspek-aspek berikut: Overfitting: Apabila jumlah data latihan tidak mencukupi, model terdedah kepada overfitting. Overfitting merujuk kepada model yang terlalu menyesuaikan diri dengan data latihan.

2023-10-08

komen 0

1394

Perpustakaan sambungan latihan teragih sumber terbuka Ant AToch mencapai kadar penggunaan berkesan sebanyak 60% kuasa pengkomputeran latihan model besar

Pengenalan Artikel:Ant Group baru-baru ini mengumumkan pelancaran perpustakaan sambungan pecutan latihan teragih model besar yang dipanggil ATorch, alat sumber terbuka. Matlamat ATorch adalah untuk membantu meningkatkan kecerdasan pembelajaran mendalam melalui pengoptimuman dinamik sumber automatik dan peningkatan kestabilan latihan yang diedarkan. Difahamkan bahawa dalam latihan model besar, ATorch boleh meningkatkan kadar penggunaan kuasa pengkomputeran latihan tahap kilokalori ratusan bilion model kepada 60%, yang bersamaan dengan menambah enjin berkuasa pada kereta sport. Ini akan menjadi alat penting untuk penyelidik dan pembangun pembelajaran mendalam untuk membantu mereka melatih dan mengoptimumkan model besar dengan lebih cekap. Rajah: ATorch komited untuk menjadikan latihan model besar lebih cekap dan boleh dihasilkan semula Dengan letupan model besar generatif, skala set data dan parameter untuk latihan model telah meningkat secara eksponen.

2024-01-14

komen 0

1416

Bagaimana untuk melaksanakan algoritma yang diedarkan dan latihan model dalam perkhidmatan mikro PHP

Pengenalan Artikel:Cara melaksanakan algoritma teragih dan latihan model dalam perkhidmatan mikro PHP Pengenalan: Dengan perkembangan pesat pengkomputeran awan dan teknologi data besar, permintaan untuk pemprosesan data dan latihan model semakin meningkat. Algoritma dan latihan model yang diedarkan adalah kunci untuk mencapai kecekapan, kelajuan dan kebolehskalaan. Artikel ini akan memperkenalkan cara melaksanakan algoritma teragih dan latihan model dalam perkhidmatan mikro PHP dan menyediakan beberapa contoh kod khusus. 1. Apakah yang dimaksudkan dengan latihan algoritma dan model yang diedarkan ialah teknologi yang menggunakan pelbagai mesin atau sumber pelayan untuk melaksanakan pemprosesan data dan latihan model secara serentak.

2023-09-25

komen 0

1442

Menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin

Pengenalan Artikel:Menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin Dengan perkembangan pesat pembelajaran mesin, ramai pembangun telah mula memberi perhatian kepada cara menggunakan JavaScript untuk melaksanakan latihan model pembelajaran mesin di bahagian hadapan. Artikel ini akan memperkenalkan cara menggunakan fungsi JavaScript untuk melaksanakan latihan model pembelajaran mesin dan memberikan contoh kod khusus. Sebelum kita memulakan, kita perlu memahami beberapa konsep penting. Set Data: Latihan model pembelajaran mesin memerlukan set set data berlabel sebagai input. Set data terdiri daripada

2023-11-03

komen 0

1184

Memindahkan aplikasi pembelajaran dan teknologi biasa dalam latihan model bahasa besar

Pengenalan Artikel:Model bahasa besar merujuk kepada model pemprosesan bahasa semula jadi dengan lebih daripada 100 juta parameter. Oleh kerana saiz dan kerumitannya yang besar, latihan model sedemikian memerlukan sumber dan data pengkomputeran yang ketara. Oleh itu, pembelajaran pemindahan telah menjadi kaedah penting untuk melatih model bahasa besar Dengan menggunakan model dan data sedia ada, proses latihan dapat dipercepatkan dan prestasi dapat ditingkatkan. Memindahkan pembelajaran boleh memindahkan parameter dan pengetahuan model yang dilatih pada tugas lain kepada tugas sasaran, dengan itu mengurangkan keperluan data dan masa latihan. Pendekatan ini digunakan secara meluas dalam kedua-dua penyelidikan dan industri, meletakkan asas untuk membina model bahasa yang lebih berkuasa. Memindahkan pembelajaran ialah kaedah yang menggunakan model yang sudah terlatih untuk melaraskan parameternya atau beberapa komponen semasa menyelesaikan tugasan lain. Dalam bidang pemprosesan bahasa semula jadi, pembelajaran pemindahan boleh

2024-01-22

komen 0

926

Maksud Saiz Kelompok dan kesannya terhadap latihan (berkaitan dengan model pembelajaran mesin)

Pengenalan Artikel:BatchSize merujuk kepada jumlah data yang digunakan oleh model pembelajaran mesin setiap kali semasa proses latihan. Ia membahagikan sejumlah besar data kepada kumpulan kecil data untuk latihan model dan pengemaskinian parameter. Kaedah pemprosesan kelompok ini membantu meningkatkan kecekapan latihan dan penggunaan memori. Data latihan biasanya dibahagikan kepada kelompok untuk latihan, dan setiap kelompok mengandungi berbilang sampel. Saiz kelompok (saiz kelompok) merujuk kepada bilangan sampel yang terkandung dalam setiap kelompok. Apabila melatih model, saiz kelompok mempunyai kesan penting ke atas proses latihan. 1. Kelajuan latihan Saiz kelompok (saiz kelompok) memberi kesan kepada kelajuan latihan model. Saiz kelompok yang lebih besar boleh memproses data latihan dengan lebih cepat kerana dalam setiap zaman, saiz kelompok yang lebih besar boleh memproses lebih banyak data secara serentak.

2024-01-23

komen 0

2223

Cara menggunakan Python untuk melatih model pada imej

Pengenalan Artikel:Gambaran keseluruhan cara menggunakan Python untuk melatih model pada imej: Dalam bidang penglihatan komputer, menggunakan model pembelajaran mendalam untuk mengklasifikasikan imej, pengesanan sasaran dan tugas lain telah menjadi kaedah biasa. Sebagai bahasa pengaturcaraan yang digunakan secara meluas, Python menyediakan banyak perpustakaan dan alatan, menjadikannya agak mudah untuk melatih model pada imej. Artikel ini akan memperkenalkan cara menggunakan Python dan perpustakaan berkaitannya untuk melatih model pada imej, dan menyediakan contoh kod yang sepadan. Penyediaan persekitaran: Sebelum memulakan, anda perlu memastikan bahawa anda telah memasang

2023-08-26

komen 0

1635

Panduan latihan model ChatGPT Python: langkah untuk menyesuaikan chatbot

Pengenalan Artikel:Panduan latihan model ChatGPTPython: Gambaran keseluruhan langkah untuk menyesuaikan robot sembang: Dalam beberapa tahun kebelakangan ini, dengan peningkatan pembangunan teknologi NLP (pemprosesan bahasa semula jadi), robot sembang telah menarik lebih banyak perhatian. ChatGPT OpenAI ialah model bahasa pra-latihan yang berkuasa yang boleh digunakan untuk membina chatbot berbilang domain. Artikel ini akan memperkenalkan langkah-langkah untuk menggunakan Python untuk melatih model ChatGPT, termasuk penyediaan data, latihan model dan penjanaan sampel dialog. Langkah 1: Penyediaan, pengumpulan dan pembersihan data

2023-10-24

komen 0

1317

Adakah latihan model besar lebih sukar daripada mencapai langit? Perpustakaan model 'Li Bai' yang telah terlatih, mudah digunakan dan sangat cekap ada di sini!

Pengenalan Artikel:Pustaka model LiBai merangkumi kelebihan semua perpustakaan Transformer arus perdana seperti Hugging Face, Megatron-LM, DeepSpeed dan FairSeq, menjadikan latihan model besar boleh diakses oleh orang biasa. Terdapat begitu banyak model besar, beritahu saya bagaimana untuk mempercepatkannya? Sejak kelahiran BERT pada 2018, model dengan ratusan juta parameter seperti GPT-3 dan ViT terus muncul. rasa kebas. Pada masa yang sama, model besar menimbulkan cabaran besar kepada sumber pengkomputeran dan ingatan. Kos latihan meningkat dengan mendadak, seperti menggunakan NVIDIA A yang sangat maju

2023-04-09

komen 0

1366

Prinsip dan aplikasi pensampelan penolakan dalam latihan model besar

Pengenalan Artikel:Persampelan penolakan ialah teknik biasa dalam latihan model bahasa besar. Ia mengambil sampel berdasarkan fungsi ketumpatan kebarangkalian taburan sasaran untuk menghasilkan sampel yang sesuai dengan taburan sasaran. Tujuan pensampelan penolakan adalah untuk meningkatkan kepelbagaian data latihan, dengan itu meningkatkan keupayaan generalisasi model. Kaedah ini amat penting dalam latihan model bahasa kerana ia dapat membantu model mempelajari ungkapan bahasa yang lebih kaya dan tepat. Dengan menolak pensampelan, model boleh menghasilkan teks daripada perspektif dan gaya yang berbeza, menjadikannya lebih mudah disesuaikan dan kreatif. Dengan cara ini, model boleh meramalkan perkataan atau frasa seterusnya dengan lebih tepat apabila memproses pelbagai jenis teks, dengan itu meningkatkan kualiti penjanaan keseluruhan. Penggunaan pensampelan penolakan juga dapat mengurangkan latihan pensampelan penolakan adalah asas

2024-01-22

komen 0

1263