Tajuk asal: Terangi Malam: Rangka Kerja Resapan Pelbagai Keadaan untuk Peningkatan Cahaya Rendah Tidak Berpasangan dalam Pemanduan Autonomi

Pautan kertas: https://arxiv.org/pdf/2404.04804.pdf

Afiliasi Pengarang: Cleveland State University Universiti Texas di Austin A*STAR Universiti New York, Universiti California, Los Angeles

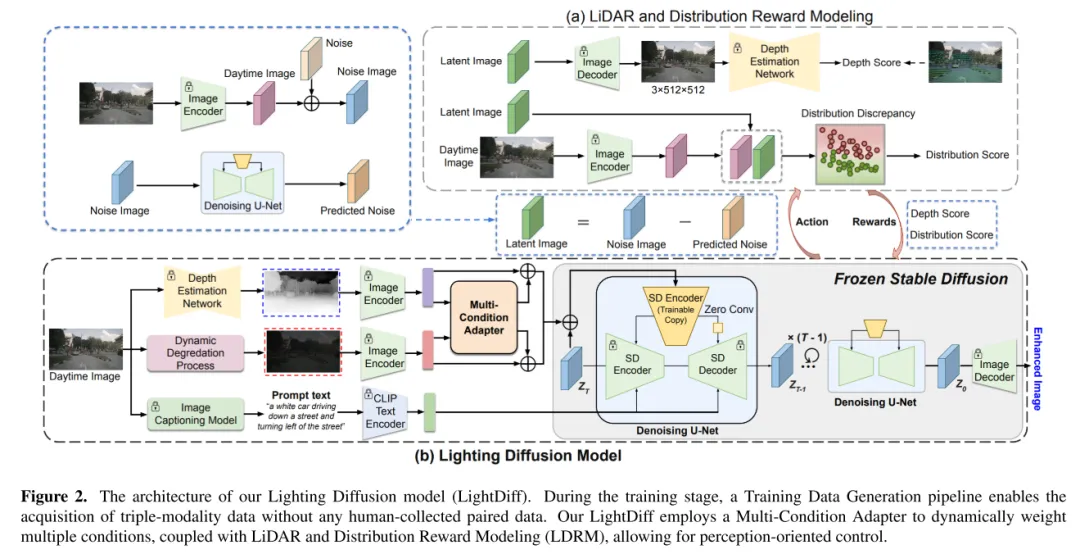

LightDiff ialah teknologi yang meningkatkan kecekapan dan skalabiliti sistem persepsi pusat visual pemanduan autonomi. Sistem LiDAR telah mendapat perhatian yang besar baru-baru ini. Walau bagaimanapun, sistem ini sering mengalami kesukaran dalam keadaan cahaya malap, yang berpotensi menjejaskan prestasi dan keselamatannya. Untuk menyelesaikan masalah ini, artikel ini memperkenalkan LightDiff, rangka kerja automatik yang direka untuk meningkatkan kualiti imej cahaya malap dalam aplikasi pemanduan autonomi. Khususnya, kertas kerja ini menggunakan model penyebaran terkawal berbilang keadaan. LightDiff menghapuskan keperluan untuk data berpasangan yang dikumpul secara manual dan sebaliknya mengeksploitasi proses degradasi data dinamik. Ia menggabungkan penyesuai berbilang keadaan baharu yang mampu menyesuaikan berat input daripada modaliti yang berbeza, termasuk peta kedalaman, imej RGB dan kapsyen teks, untuk mengekalkan konsistensi kandungan secara serentak dalam keadaan cahaya malap dan cahaya malap. Tambahan pula, untuk memadankan imej yang ditambah dengan pengetahuan model pengesanan, LightDiff menggunakan skor khusus perceptron sebagai ganjaran untuk membimbing proses latihan resapan melalui pembelajaran pengukuhan. Eksperimen meluas pada set data nuScenes menunjukkan bahawa LightDiff boleh meningkatkan prestasi berbilang pengesan 3D tercanggih dalam keadaan waktu malam sambil mencapai skor kualiti visual yang tinggi, menyerlahkan potensinya untuk memastikan keselamatan pemanduan autonomi.

Kertas kerja ini mencadangkan model Lighting Diffusion (LightDiff) untuk meningkatkan imej kamera cahaya malap dalam pemanduan autonomi, mengurangkan keperluan untuk pengumpulan data waktu malam yang meluas dan mengekalkan keupayaan prestasi siang hari.

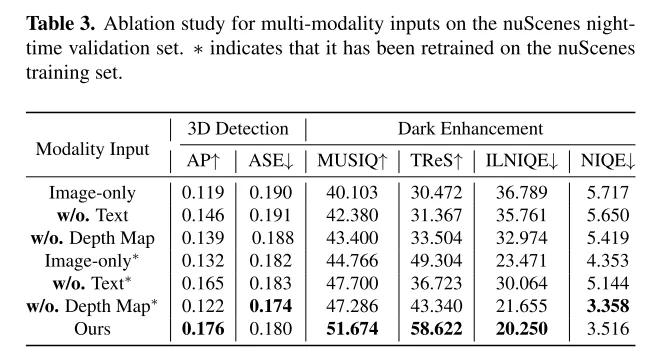

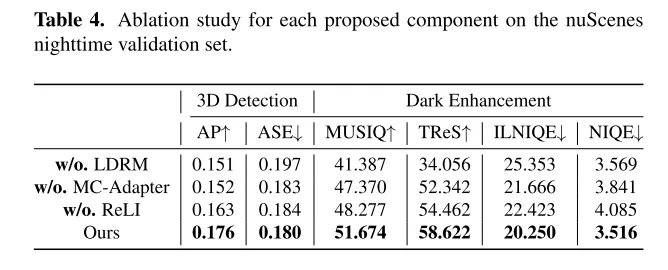

Makalah ini menyepadukan berbilang mod input termasuk peta kedalaman dan kapsyen imej, dan mencadangkan penyesuai berbilang keadaan untuk memastikan integriti semantik dalam penukaran imej sambil mengekalkan kualiti visual yang tinggi. Kertas kerja ini menggunakan proses praktikal untuk menjana pasangan imej siang dan malam daripada data siang hari untuk mencapai latihan model yang cekap.

Kertas kerja ini memperkenalkan mekanisme penalaan halus menggunakan pembelajaran pengukuhan, digabungkan dengan pengetahuan domain tersuai persepsi (lidar yang boleh dipercayai dan ketekalan pengedaran statistik) untuk memastikan proses resapan mempunyai kekuatan yang kondusif kepada persepsi visual manusia, dan memanfaatkan prestasi Model persepsi pemodelan persepsi. Kaedah ini mempunyai kelebihan yang ketara dalam persepsi visual manusia dan juga mempunyai kelebihan model persepsi.

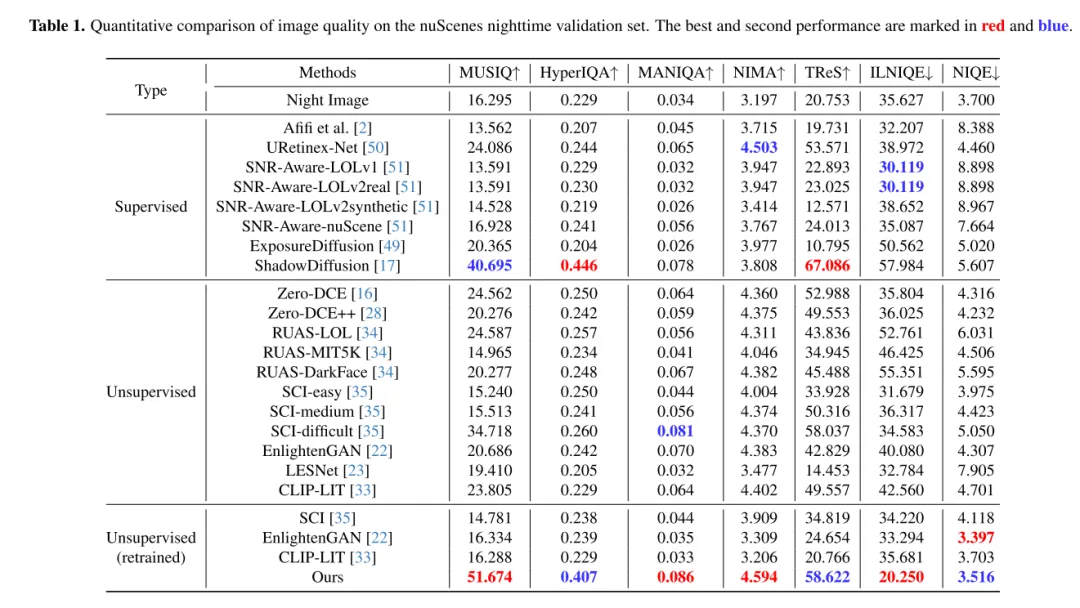

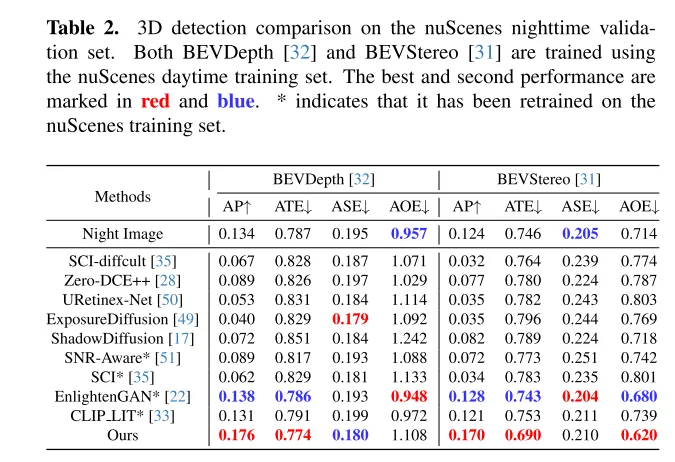

Percubaan meluas pada set data nuScenes menunjukkan bahawa LightDiff meningkatkan prestasi pengesanan kenderaan 3D dengan ketara pada waktu malam dan mengatasi prestasi model generatif lain pada berbilang metrik sudut tontonan.

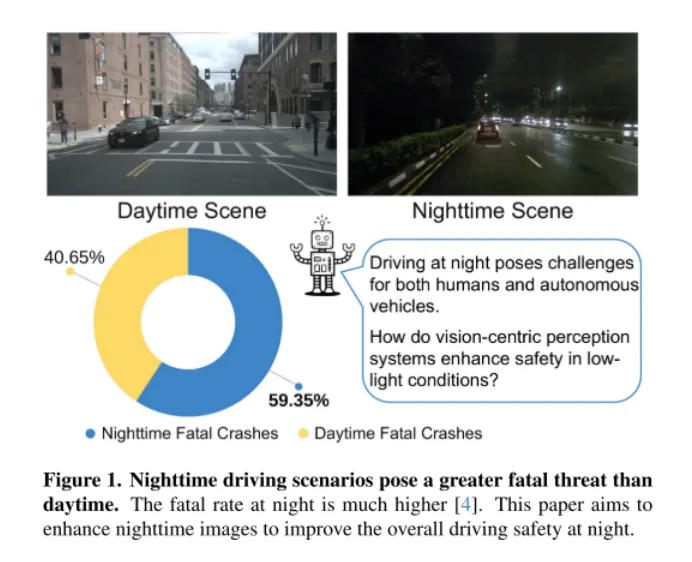

Rajah 1. Senario pemanduan pada waktu malam lebih membawa maut berbanding pada waktu siang. Kadar kematian adalah lebih tinggi pada waktu malam [4]. Artikel ini bertujuan untuk meningkatkan imej waktu malam untuk meningkatkan keselamatan keseluruhan pemanduan waktu malam.

Seperti yang ditunjukkan dalam Rajah 1, pemanduan malam adalah mencabar bagi manusia, terutamanya untuk kereta pandu sendiri. Cabaran ini diserlahkan oleh insiden malapetaka pada 18 Mac 2018, apabila sebuah kereta pandu sendiri dari Uber Advanced Technologies Group melanggar dan membunuh seorang pejalan kaki di Arizona [37]. Insiden itu, yang disebabkan oleh kegagalan kenderaan mengesan pejalan kaki dalam keadaan cahaya malap dengan tepat, telah membawa isu keselamatan untuk kenderaan autonomi ke hadapan, terutamanya dalam persekitaran yang mencabar. Memandangkan sistem pemanduan autonomi bertumpu penglihatan semakin bergantung pada penderia kamera, menangani kebimbangan keselamatan dalam keadaan cahaya malap menjadi semakin kritikal untuk memastikan keselamatan keseluruhan kenderaan ini.

Penyelesaian intuitif adalah untuk mengumpul sejumlah besar data pemanduan malam. Walau bagaimanapun, kaedah ini bukan sahaja memerlukan tenaga kerja dan kos yang tinggi, tetapi juga boleh menjejaskan prestasi model siang hari disebabkan oleh perbezaan taburan imej antara waktu malam dan siang hari. Untuk menangani cabaran ini, kertas kerja ini mencadangkan model Lighting Diffusion (LightDiff), pendekatan baru yang menghapuskan keperluan untuk pengumpulan data manual dan mengekalkan prestasi model siang hari.

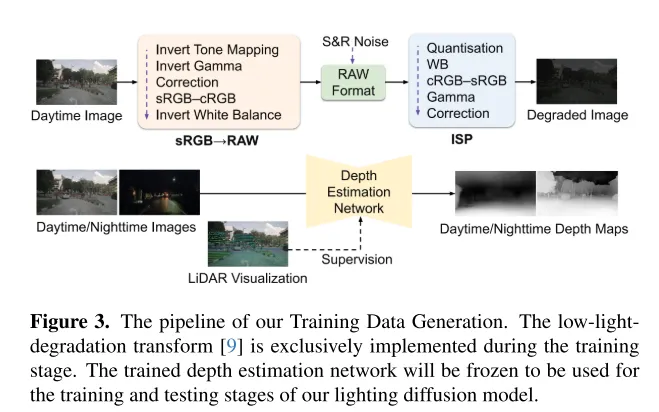

LightDiff bertujuan untuk meningkatkan imej kamera cahaya rendah dan meningkatkan prestasi model persepsi. Dengan menggunakan proses pengecilan cahaya malap dinamik, LightDiff menjana pasangan imej siang-malam sintetik untuk latihan daripada data siang hari sedia ada. Seterusnya, kertas kerja ini mengguna pakai teknologi Stable Diffusion [44] kerana keupayaannya untuk menghasilkan kesan visual berkualiti tinggi yang secara berkesan mengubah pemandangan waktu malam kepada setara siang hari. Walau bagaimanapun, mengekalkan konsistensi semantik adalah penting dalam pemanduan autonomi, yang merupakan cabaran yang dihadapi oleh model Stable Diffusion yang asal. Untuk mengatasinya, LightDiff menggabungkan berbilang modaliti input, seperti anggaran peta kedalaman dan kapsyen imej kamera, dengan penyesuai berbilang keadaan. Penyesuai ini secara bijak menentukan berat setiap modaliti input, memastikan integriti semantik imej yang ditukar sambil mengekalkan kualiti visual yang tinggi. Untuk membimbing proses resapan bukan sahaja ke arah menjadi lebih cerah untuk penglihatan manusia, tetapi juga untuk model persepsi, kertas kerja ini selanjutnya menggunakan pembelajaran pengukuhan untuk memperhalusi LightDiff kertas ini, menambah pengetahuan domain yang disesuaikan untuk persepsi ke dalam gelung. Makalah ini menjalankan eksperimen yang meluas pada set data pemanduan autonomi nuScenes [7] dan menunjukkan bahawa LightDiff kami boleh meningkatkan ketepatan purata (AP) pengesanan kenderaan 3D waktu malam dengan ketara untuk dua model terkini, BEVDepth [32] dan BEVStereo [31] meningkat sebanyak 4.2% dan 4.6%.

Rajah 2. Seni bina model Resapan Pencahayaan (LightDiff) dalam artikel ini. Semasa fasa latihan, proses penjanaan data latihan membolehkan pemerolehan data trimodal tanpa sebarang pengumpulan manual data berpasangan. LightDiff kami menggunakan penyesuai berbilang keadaan untuk menimbang berbilang keadaan secara dinamik, digabungkan dengan pemodelan ganjaran lidar dan teragih (LDRM), membenarkan kawalan berorientasikan persepsi.

Rajah 3. Proses penjanaan data latihan artikel ini. Transformasi degradasi cahaya rendah [9] hanya dilaksanakan semasa fasa latihan. Rangkaian anggaran kedalaman terlatih akan dibekukan dan digunakan untuk fasa latihan dan ujian model Resapan Pencahayaan dalam artikel ini.

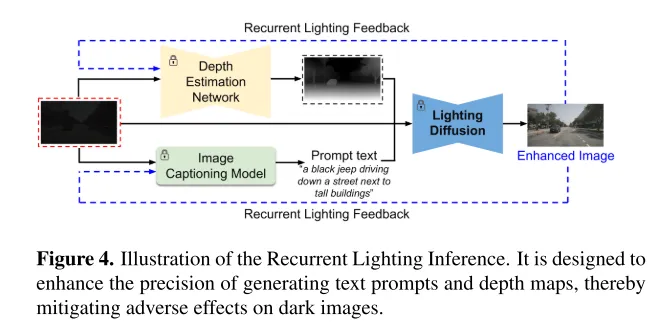

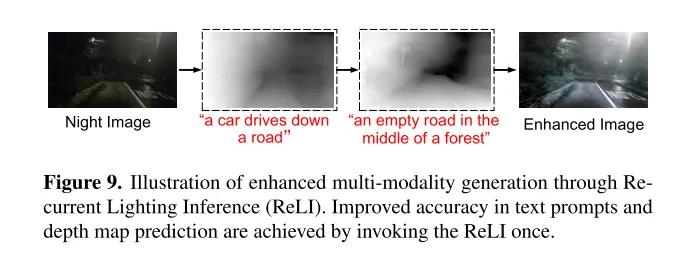

Rajah 4. Gambarajah skematik Inferens Pencahayaan Berulang. Ia direka bentuk untuk meningkatkan ketepatan menjana pembayang teks dan peta kedalaman, dengan itu mengurangkan kesan buruk imej gelap.

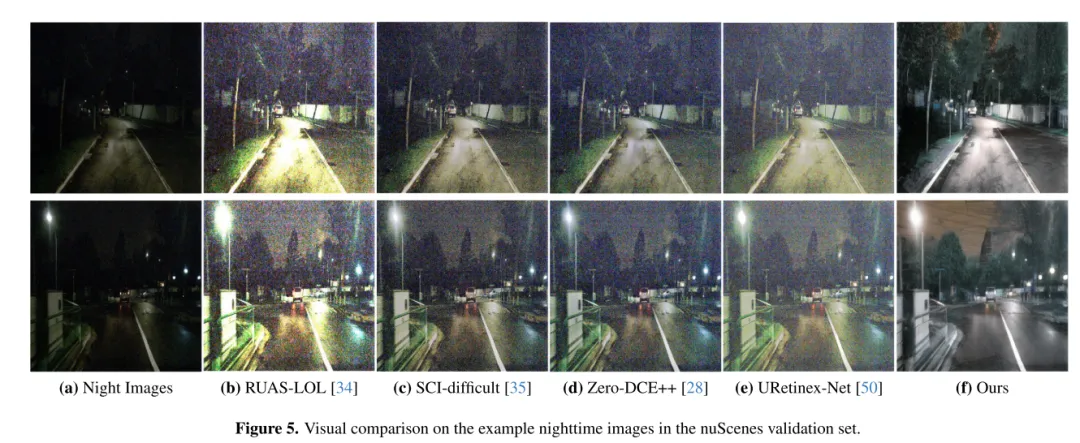

Rajah 5. Perbandingan visual pada sampel imej waktu malam dalam set pengesahan nuScenes.

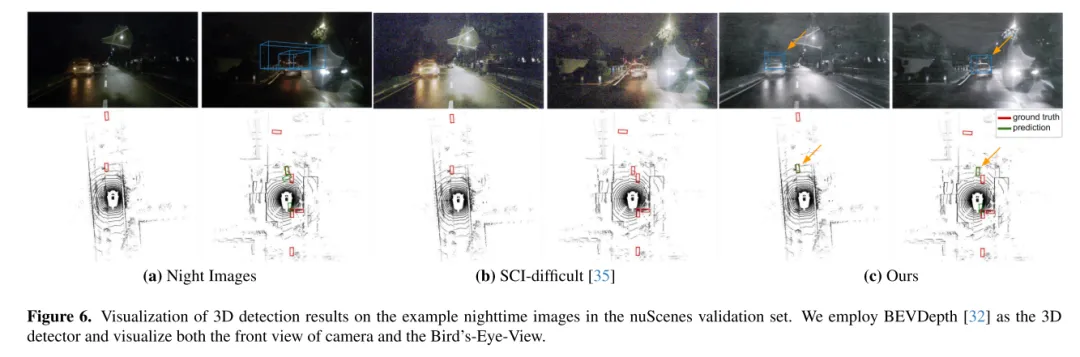

Rajah 6. Visualisasi hasil pengesanan 3D pada sampel imej waktu malam dalam set pengesahan nuScenes. Kertas ini menggunakan BEVDepth [32] sebagai pengesan tiga dimensi dan menggambarkan pandangan hadapan dan Bird’s-Eye-View kamera.

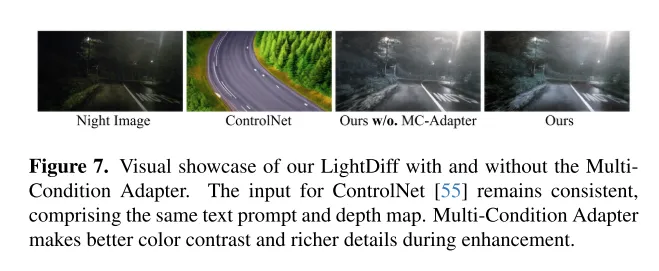

Rajah 7. Menunjukkan kesan visual LightDiff artikel ini dengan atau tanpa Penyesuai MultiCondition. Input kepada ControlNet [55] kekal konsisten, termasuk isyarat teks dan peta kedalaman yang sama. Penyesuai berbilang keadaan membolehkan kontras warna yang lebih baik dan butiran yang lebih kaya semasa peningkatan.

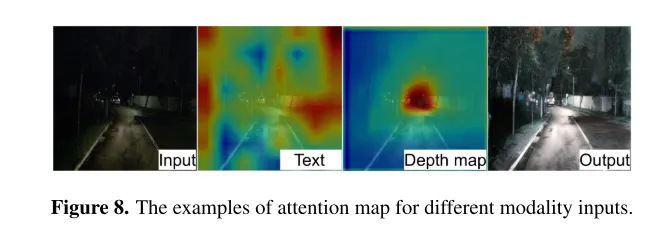

Rajah 8. Contoh peta perhatian untuk input modal yang berbeza.

Rajah 9. Gambar rajah skema penjanaan pelbagai mod yang dipertingkatkan melalui Inferens Pencahayaan Berulang (ReLI). Dengan memanggil ReLI sekali, ketepatan pembayang teks dan ramalan peta kedalaman dipertingkatkan.

Artikel ini memperkenalkan LightDiff, rangka kerja khusus domain yang direka untuk aplikasi pemanduan autonomi, bertujuan untuk meningkatkan kualiti imej dalam persekitaran cahaya malap dan mengurangkan cabaran penglihatan yang dihadapi sistem. Dengan memanfaatkan proses degradasi data dinamik, penyesuai berbilang keadaan untuk modaliti input yang berbeza, dan pemodelan ganjaran berpandukan skor secara persepsi khusus menggunakan pembelajaran pengukuhan, LightDiff meningkatkan kualiti imej waktu malam dan prestasi 3D dengan ketara pada set data nuScenes prestasi pengesanan kenderaan. Inovasi ini bukan sahaja menghapuskan keperluan untuk sejumlah besar data waktu malam, tetapi juga memastikan integriti semantik dalam transformasi imej, menunjukkan potensinya untuk meningkatkan keselamatan dan kebolehpercayaan dalam senario pemanduan autonomi. Dengan ketiadaan imej siang-malam berpasangan realistik, agak sukar untuk mensintesis imej pemanduan malap dengan lampu kereta, yang mengehadkan penyelidikan dalam bidang ini. Penyelidikan masa depan boleh menumpukan pada pengumpulan atau penjanaan data latihan berkualiti tinggi yang lebih baik.

@ARTICLE{2024arXiv240404804L,

author = {{Li}, Jinlong and {Li}, Baolu and {Tu}, Zhengzhong and {Liu}, Xinyu and {GuoJue} Xu}, Felix dan {Xu}, Runsheng dan {Yu}, Hongkai},

title = "{Terangi Malam: Rangka Kerja Resapan Pelbagai Keadaan untuk Peningkatan Cahaya Rendah Tidak Berpasangan dalam Pemanduan Autonomi}",

jurnal = {arXiv e-cetakan},

kata kunci = {Sains Komputer - Visi Komputer dan Pengecaman Corak},

tahun = 2024,

bulan = apr,

eid = {arXiv:2404.04804},

halaman = {arXiv:2404},

doi {10.48550/arXiv.2404.04804},

archivePrefix = {arXiv},

eprint = {2404.04804},

primaryClass = {cs.CV},

adsurl =2sbharui.sb/2bharui. 4804L },

adsnote = {Disediakan oleh Sistem Data Astrofizik SAO/NASA}

}

Atas ialah kandungan terperinci CVPR\'24 |. LightDiff: Model resapan dalam pemandangan cahaya malap, menerangi malam secara langsung!. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!

Pengenalan kepada rangka kerja yang digunakan oleh vscode

Pengenalan kepada rangka kerja yang digunakan oleh vscode

kaedah konfigurasi nagios

kaedah konfigurasi nagios

apakah maksud antara muka usb

apakah maksud antara muka usb

Bagaimana untuk menyimpan gambar di ruang komen Douyin ke telefon bimbit

Bagaimana untuk menyimpan gambar di ruang komen Douyin ke telefon bimbit

Foto Windows tidak boleh dipaparkan

Foto Windows tidak boleh dipaparkan

Perbezaan antara Fahrenheit dan Celsius

Perbezaan antara Fahrenheit dan Celsius

Bagaimana untuk memasang pycharm

Bagaimana untuk memasang pycharm

Apakah protokol yang termasuk dalam protokol ssl?

Apakah protokol yang termasuk dalam protokol ssl?