Penterjemah |. Memandangkan Party A memegang maklumat pelanggan yang sangat sensitif, atas sebab keselamatan kami tidak boleh menyampaikannya kepada

OpenAI atau model proprietari lain. Oleh itu, kami memuat turun dan menjalankan model AI sumber terbuka dalam mesin maya AWS, memastikannya berada di bawah kawalan kami sepenuhnya. Pada masa yang sama, aplikasi

Rails boleh membuat

API panggilan ke AI dalam persekitaran yang selamat. Sudah tentu, jika isu keselamatan tidak perlu dipertimbangkan, kami lebih suka untuk bekerjasama secara langsung dengan OpenAI. Di bawah, saya akan berkongsi dengan anda cara memuat turun model AI sumber terbuka secara tempatan, biarkan ia berjalan, dan cara menjalankan skrip Ruby terhadapnya.

Mengapa menyesuaikan?

Motivasi untuk projek ini adalah mudah: keselamatan data. Apabila mengendalikan maklumat pelanggan yang sensitif, pendekatan yang paling boleh dipercayai biasanya melakukannya dalam syarikat. Oleh itu, kami memerlukan model AI tersuai untuk memainkan peranan dalam menyediakan tahap kawalan keselamatan dan perlindungan privasi yang lebih tinggi. Model sumber terbuka

6 bulan telah ada produk baru di pasaran seperti:

dan Lamadsb. Sebilangan besar model AI sumber terbuka. Walaupun mereka tidak sekuat GPT-4, prestasi kebanyakan mereka telah melebihi GPT-3.5, dan mereka akan menjadi lebih dan lebih berkuasa seiring dengan berlalunya masa. Sudah tentu, model yang anda pilih bergantung sepenuhnya pada keupayaan pemprosesan anda dan perkara yang perlu anda capai. Memandangkan kami akan menjalankan model AI secara tempatan, kami memilih Mistral iaitu lebih kurang 4GB. Ia mengatasi prestasi GPT-3.5

pada kebanyakan metrik. Walaupun Mixtral berprestasi lebih baik daripada Mistral, ia adalah model besar yang memerlukan sekurang-kurangnya 48GB memori untuk dijalankan. ParameterApabila bercakap tentang model bahasa besar (LLM), kita cenderung untuk memikirkan tentang menyebut saiz parameternya. Di sini, model

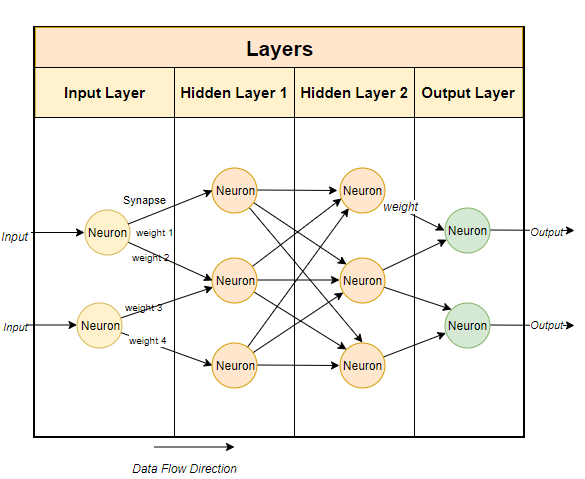

Mixtral mempunyai 700 bilion parameter, dan GP-T, dan lebih kurang GP-T 1750 bilion parameter). Lazimnya, model bahasa besar menggunakan teknik berasaskan rangkaian saraf. Rangkaian saraf terdiri daripada neuron, dan setiap neuron disambungkan kepada semua neuron lain dalam lapisan seterusnya.

Seperti yang ditunjukkan dalam gambar di atas, setiap sambungan mempunyai berat, biasanya dinyatakan sebagai peratusan. Setiap neuron juga mempunyai bias, yang membetulkan data semasa ia melalui nod.Tujuan rangkaian saraf adalah untuk "mempelajari" algoritma lanjutan, algoritma padanan corak. Dengan dilatih mengenai jumlah teks yang banyak, ia akan mempelajari secara beransur-ansur keupayaan untuk meramal corak teks dan bertindak balas dengan bermakna kepada isyarat yang kami berikan. Ringkasnya, parameter ialah bilangan berat dan berat sebelah dalam model. Ia memberi kita gambaran tentang berapa banyak neuron yang terdapat dalam rangkaian saraf. Contohnya, untuk model parameter

7 bilion, terdapat kira-kira  100

100

Jalankan model secara setempat

Untuk menjalankan model sumber terbuka secara setempat, anda mesti memuat turun aplikasi yang berkaitan terlebih dahulu. Walaupun terdapat banyak pilihan di pasaran, yang saya dapati paling mudah dan paling mudah untuk dijalankan pada Intel Mac ialah Ollama.

Ollama pada masa ini hanya berjalan pada Mac dan Linux pada masa hadapan, ia akan dijalankan pada masa hadapan Sudah tentu, anda boleh menggunakan WSL

(Windows Subsystem for Linux) pada Windows untuk menjalankan Linux shell.

Ollama bukan sahaja membenarkan anda memuat turun dan menjalankan pelbagai model sumber terbuka, tetapi juga membuka model pada port tempatan, membolehkan anda membuat API panggilan melalui Rubykod. Ini memudahkan Ruby pembangun menulis Ruby aplikasi yang boleh disepadukan dengan model tempatan. . sistem. Anda hanya perlu memuat turun Ollama melalui pautan

//m.sbmmt.com/link/04c7f37f2420f0532d7f0e062ff2d5b5

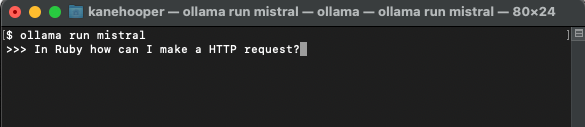

ollama run mistral

Pertama, anda boleh mencipta Modelfile (fail model) dan menambah teks berikut di dalamnya:

FROM mistral# Set the temperature set the randomness or creativity of the responsePARAMETER temperature 0.3# Set the system messageSYSTEM ”””You are an excerpt Ruby developer. You will be asked questions about the Ruby Programminglanguage. You will provide an explanation along with code examples.”””

Mesej sistem AI yang muncul di atas adalah asas untuk respons khusus bagi model. Seterusnya, anda boleh menjalankan arahan berikut pada terminal untuk mencipta model baharu: ollama create <model-name> -f './Modelfile</model-name>

ollama create ruby -f './Modelfile'

Pada masa yang sama, anda boleh menggunakan arahan berikut untuk menyenaraikan dan memaparkan model sedia ada anda: ollama list

Ollama run ruby

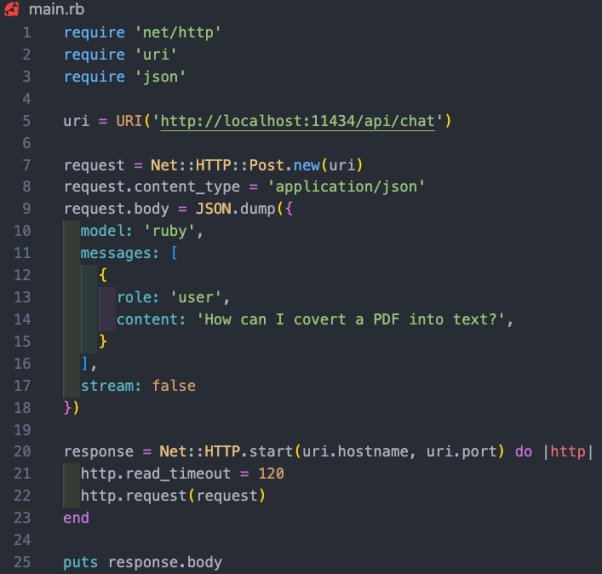

sementara Ollama tidak mempunyai gem yang berdedikasi lagi, ruby pemaju boleh menggunakan kaedah http http http http http http http untuk berinteraksi dengan model. Ollama berjalan di latar belakang boleh membuka model melalui port 11434

, jadi anda boleh mengaksesnya melalui "//m.sbmmt.com/link/dcd3f83c96576c0fd437286a1ff6f1f0". Selain itu, dokumentasi untuk OllamaAPI juga menyediakan titik akhir yang berbeza untuk arahan asas seperti perbualan sembang dan mencipta benaman. Dalam kes projek ini, kami mahu menggunakan titik akhir

/api/chat

Ruby asas untuk berinteraksi dengan model:

Pengenalan penterjemah

Julian Chen, editor komuniti 51CTO, mempunyai lebih sepuluh tahun pengalaman pelaksanaan projek IT, pandai mengawal sumber komunikasi dalaman dan luaran serta risiko dan pengetahuan dan pengalaman keselamatan maklumat. .

Atas ialah kandungan terperinci Untuk melindungi privasi pelanggan, jalankan model AI sumber terbuka secara tempatan menggunakan Ruby. Untuk maklumat lanjut, sila ikut artikel berkaitan lain di laman web China PHP!